公司windows电脑搭建spark开发环境遇到的问题

报错如下:

The root scratch dir: /tmp/hive on HDFS should be writable. Current permissions are: ---------

Caused by: java.lang.RuntimeException: The root scratch dir: /tmp/hive on HDFS should be writable. Current permissions are: rw-rw-rw- at org.apache.hadoop.hive.ql.session.SessionState.createRootHDFSDir(SessionState.java:612) at org.apache.hadoop.hive.ql.session.SessionState.createSessionDirs(SessionState.java:554) at org.apache.hadoop.hive.ql.session.SessionState.start(SessionState.java:508) ... 33 more

看报错日志是权限问题,于是执行加权限操作,命令如下:

%HADOOP_HOME%\bin\winutils.exe chmod 777 d:\tmp\hive

执行完后查看权限

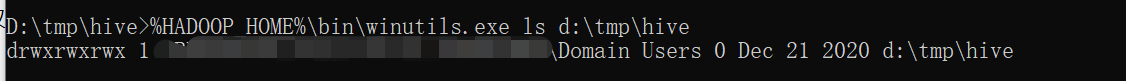

%HADOOP_HOME%\bin\winutils.exe ls d:\tmp\hive

发现又出现如下多个?的异常,具体如下:

FindFileOwnerAndPermission error (1789): ????????????????

执行idea上的spark测试代码,发现还是报权限问题的错误,这说明权限根本没给到,最后发现我的系统无法连接到电脑的域控制器,因此必须连接到VPN然后执行上诉赋权限的命令,此时再查看权限,结果如下图

再次再idea上执行spark的测试代码,正常运行

分类:

软件安装,以及报错等

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 25岁的心里话

· 闲置电脑爆改个人服务器(超详细) #公网映射 #Vmware虚拟网络编辑器

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· 零经验选手,Compose 一天开发一款小游戏!

· 一起来玩mcp_server_sqlite,让AI帮你做增删改查!!