ElasticSearch 安装 ik 分词器

ES 中的查询分析分为两步:

- 分词器将输入的文本转为一个一个的词条流

- 过滤:比如停用词过滤器会从词条中去除不相干的词条(的,嗯,啊,呢);另外还有同义词过滤器、小写过滤器等。

ES 中内置了多种分词器可以供使用。但是这些分词器中并不适用于中文。

ES 使用较多的中文分词器是 elasticsearch-analysis-ik

ik 分词器介绍

安装 ik 分词器

按照 readme 上的步骤进行即可

- 从 release 页面下载对应的版本

- 在 es 目录中的 plugins 目录下,新建目录 ik

- 将 第一步中下载的内容放到 ik 目录中

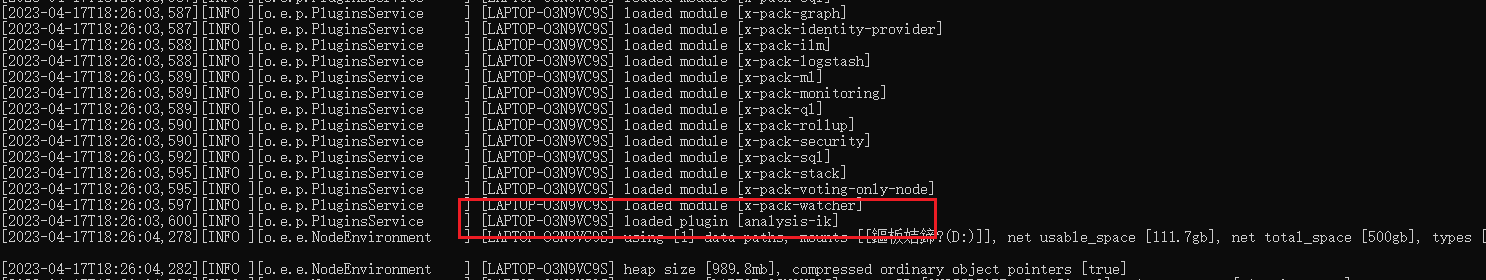

- 重启 es 发现启动的时候 加载了 分词器模块,即为安装成功。

IK提供了两个分词算法 :

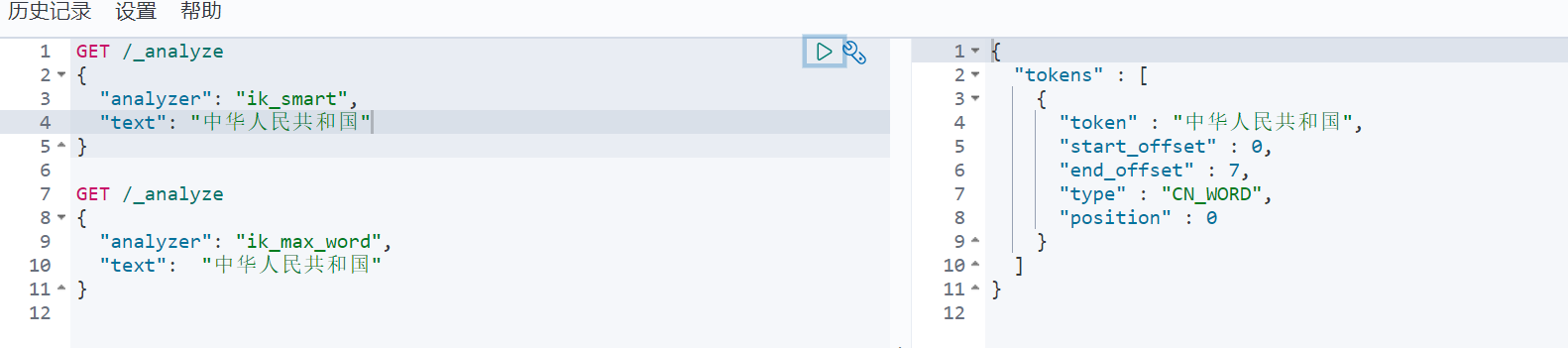

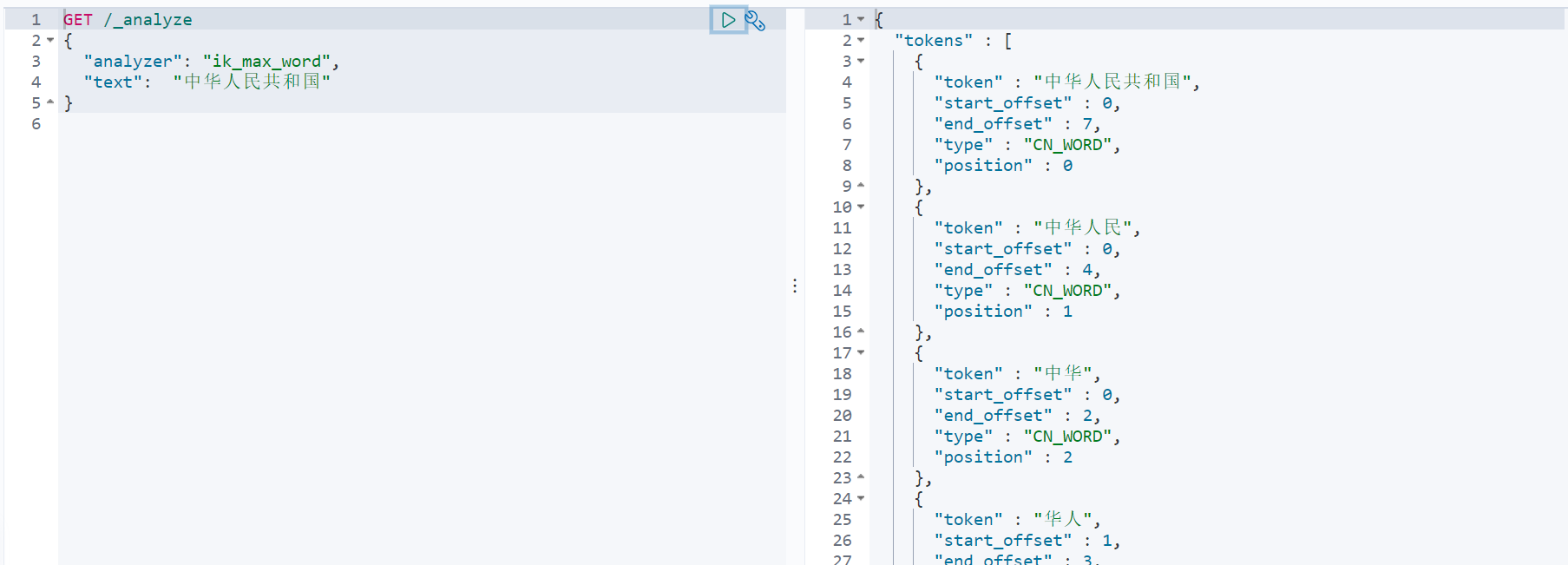

ik_smart最少切分,ik_max_word最细粒度划分

效果演示:

最少切分

最细粒度切分

自定义扩展词库:

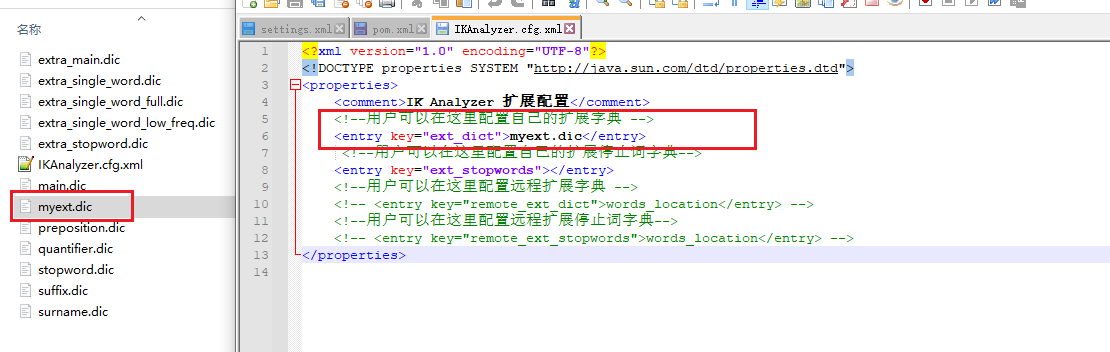

可以在 elasticsearch/plugins/ik/config 下新增一个 .dic 文件,在其中自定义我们的词库,如果有多个词,则需要换行写入。

然后在 IKAnalyzer.cfg.xml 指定扩展词典