Going Deep: Graph Convolutional Ladder-Shape Networks-AAAI2020

Going Deep: Graph Convolutional Ladder-Shape Networks-AAAI2020

深入研究:图卷积梯形网络-AAAI2020

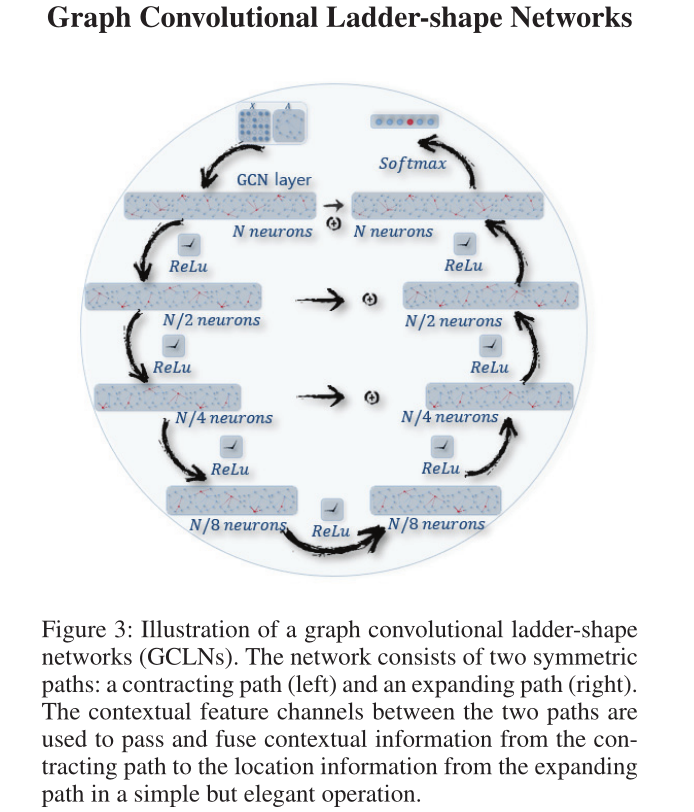

(提出了图卷积梯形网络(GCLNs),该网络采用对称梯形结构来解决超平滑问题。该网络由收缩路径、扩展路径和上下文特征通道组成,通过将相应的上下文信息从收缩端融合到更深层次,对不可区分特征进行表征和增强)

一、引言

1、图嵌入工作

(1) 只考虑拓扑结构

- 概率模型(probabilistic models)

- 矩阵分解模型(matrix factorization-based works)

(2)同时考虑结构和节点属性的图嵌入的方法

- 基于内容增强(content enhanced network embedding methods)

- 内容增强方法将文本特征与表示架构相关联,例如,TADW (Yang et al. 2015)在矩阵分解框架下将特征信息整合到网络表示中,TriDNR (Pan et al. 2016)训练神经网络体系结构,从属性图中捕获结构接近度和属性接近度。

- 基于邻居聚合(消息传递)(neighborhood aggregation (or message passing) algorithms))。

- 邻域聚合算法(Dai等人,2018;李、韩、吴2018;Klicpera, Bojchevski,和Günnemann 2018),表示为光谱图卷积网络(光谱GCNs) (Kipf和Welling 2016b),引入Laplacian平滑操作,在其邻域上传播节点的属性。

- 在上述方法中,基于频谱的算法因其对半监督任务的显著改进而受到越来越多的关注。基于频谱的算法借用了图信号处理领域中滤波器的思想来进行图卷积运算,也可以解释为从图信号中去除噪声。

- 一种光谱GCN和另一种的主要区别在于滤波器的设计。频谱cnn (Bruna et al. 2013)用一组可学习参数来制定滤波器来实现基于频谱的卷积运算。

- ChebNet (Defferrard, Bresson, and Vandergheynst 2016)认为滤波器是特征值对角矩阵的Chebyshev多项式,其中Chebyshev多项式是用递归公式定义的。

- GCNs谱(Kipf和Welling 2016b)可以解释为ChebNet的一阶近似,它假设拉普拉斯多项式的阶数限制为1,而特征值的最大值限制为2。

- 最近,g-U-Nets (Gao和Ji 2019)试图通过提出的gPooling和gUnpool操作来生成所选节点的位置信息,因此经典的计算机视觉方法可以应用到图形中,增加了架构的深度。然而,这种方法严重依赖于图形预处理,很难训练出良好的性能。

2、问题引入

(1)问题

- 在具有许多图卷积层的深度神经网络体系结构中,邻域聚合过程的质量不可避免地下降(Klicpera, Bojchevski,和Günnemann 2018)。

(2)原因

- 产生这一问题的主要原因是这些聚合(或传播)方案中的拉普拉斯平滑对节点特征进行了过度平滑,使得来自不同簇的节点难以区分(Xu et al. 2018)。

- 可见,添加多个GCN层相当于重复进行拉普拉斯平滑操作,图中相邻连通节点的特征将收敛到相同的值。

- 对于光谱GCN,特征会按节点度的平方根比例收敛(Li, Han, and Wu 2018),这就是本文所解决的过平滑问题。

3、方案

- 本文提出了一种基于上下文特征信道的图卷积网络,该网络对称地构建在一条收缩和一条扩展路径上,极大地扩展了谱图卷积网络的深度。

二、问题定义

三、预备知识

1、GCN

2、U-net

- U-Net (Ronneberger, Fischer, and Brox 2015)是一种优雅的u形全卷积网络结构,用于生物医学图像分割。该架构由两部分组成:下行采样路径和上行采样路径。

- 下采样路径由四个块组成,每个块有两个卷积层和一个最大池化(stride=2)层。沿着下采样路径的每一步,特征通道的数量增加一倍。收缩路径从输入图像中捕获上下文特征用于分割,并将这些特征传递到具有跳过连接的上采样路径。

- 上采样路径也由四个相似的去卷积块组成,使模型能够同时从下采样路径获得准确的定位信息和足够的上下文信息。

- U-Net充分利用了上采样路径的精确定位和下采样路径的上下文信息。在生物医学图像分割训练过程中,将两个信息源通过特征通道进行相应的连接。

3、可微图池(Differentiable Graph Pooling)

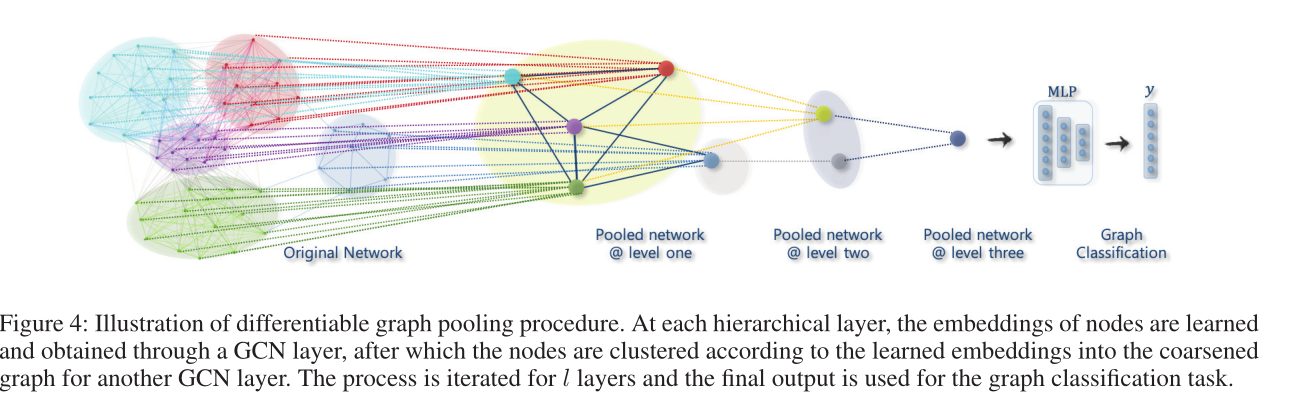

- The differentiable graph pooling module solves the aforementioned challenges by learning a differentiable soft assignment at each layer of a GNN model, assigning nodes to a set of clusters according to the learned representations.

Thus, the pooling operation of each GNN layer coarsens the

given graph iteratively and generates a hierarchical repre-

sentation of every input graph on completion of the entire

training procedure. - 可微图池模块通过学习GNN模型每一层的可微软分配,根据学习到的表示将节点分配给一组集群,从而解决了上述挑战。因此,每个GNN层的池化操作对给定的图进行迭代粗化,并在整个训练过程完成后生成每个输入图的层次表示.

四、图卷积梯形网络

1、架构

本文提出的GCLN是一个对称的体系结构,它由一个收缩路径和一个扩展路径构成。三个上下文特征通道允许从收缩路径捕获上文特征与通过扩展路径学习到的本地化信息相融合。每一层都用谱图卷积构建,该框架共包含8个GCN层。

两个路径之间的上下文特性通道用于在简单而优雅的操作中传递和融合从收缩路径到扩展路径的位置信息的上下文信息。

2、图卷积操作

3、GCLN抽取路径

- 收缩路径是一个四层图卷积嵌入体系结构,其中每一层的大小是前一层的一半。每个GCN层进行图卷积,然后RELU激活和dropout。

- 如果将GCLN解释为端到端的编码器-解码器体系结构,将与每个节点相关的拓扑特征和特征编码为多个层次的特征表示,则可以将收缩路径视为编码器部分。通过收缩路径获取图的上下文信息,并在每一层保存,相应通过上下文特征通道传递到扩展路径。

4、GCLN扩展路径 - 扩展路径反映了收缩路径的体系结构,并将层的安排颠倒过来。每一层的神经元数量都是前一层的两倍。执行一个元素级的求和操作来接收和融合从收缩路径跳过来的上下文路径。

![]()

- 上下文特征通道允许网络更深入,并将收缩侧的上下文特征与扩展侧的上卷积特征融合在一起。这个总和使表示能够更好地局部化,并通过多次卷积获得。

- 对节点重复进行对称归一化拉普拉斯平滑操作所产生的不可区分的特征进行直接表征和增强,使其与收缩路径中的上下文特征合并。从而克服了基于邻域聚合算法的过平滑问题。

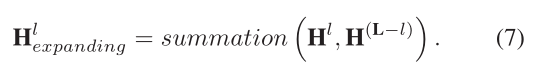

5、差分池的扩展

- The differentiable graph pooling formulates a general recipe for hierarchically pooling nodes across a set of graphs by generating a cluster assignment matrix S over the nodes leveraging the output of each GCN layer. The cluster matrix S on layer l is computed as follows:

- 可微图池通过利用每个GCN层的输出的节点上生成一个集群分配矩阵S,从而为跨一组图层次池化节点形成一个通用方案:

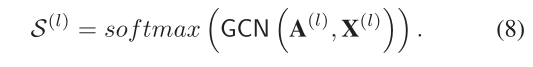

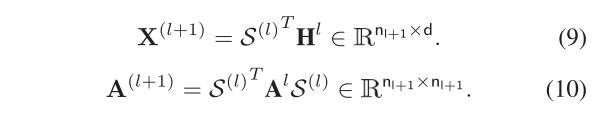

![]()

- 利用聚类分配矩阵S,可微池化层对给定图进行粗化,应用下列公式生成一个新的邻接矩阵\(a^{(l+1)}\)和一个新的矩阵\(X^{(l+1)}\):

![]()

![]()

图4:可微图池过程的说明。在每个层次层中,通过一个GCN层学习并获得节点的嵌入,然后根据学习到的嵌入信息将节点聚类到另一个GCN层的粗化图中。该过程在l层中迭代,最终的输出用于图分类任务。

- 可微图池通过利用每个GCN层的输出的节点上生成一个集群分配矩阵S,从而为跨一组图层次池化节点形成一个通用方案:

浙公网安备 33010602011771号

浙公网安备 33010602011771号