第6章 通过CrawlSpider对招聘网站进行整站爬取

通过前几章的2个项目的学习,其实本章的拉钩网项目还是挺容易理解的。

本章主要的还是对CrawlSpider源码的解析,其实我对源码还不是很懂,只是会基本的一些功能而已。

不分小节记录了,直接上知识点,可能比较乱。

1.建立数据表sql语句参考

1 CREATE TABLE `lagou_job` ( 2 `job_id` int(11) NOT NULL DEFAULT '0' COMMENT '职位页面的id', 3 `title` varchar(255) NOT NULL COMMENT '职位名称', 4 `url` varchar(255) NOT NULL COMMENT '职位链接', 5 `salary` varchar(255) DEFAULT NULL COMMENT '工资', 6 `job_city` varchar(255) DEFAULT NULL COMMENT '城市', 7 `work_years` varchar(255) DEFAULT NULL COMMENT '工作经验', 8 `degree_need` varchar(255) DEFAULT NULL COMMENT '学历', 9 `job_type` varchar(255) DEFAULT NULL COMMENT '工作性质', 10 `publish_time` varchar(255) DEFAULT NULL COMMENT '发布时间', 11 `job_advantage` varchar(255) DEFAULT '' COMMENT '职位诱惑', 12 `job_desc` longtext COMMENT '职位描述', 13 `job_addr` varchar(255) DEFAULT NULL COMMENT '工作详细地点', 14 `company_url` varchar(255) DEFAULT NULL COMMENT '公司链接', 15 `company_name` varchar(255) DEFAULT NULL COMMENT '公司名称', 16 PRIMARY KEY (`job_id`) 17 ) ENGINE=MyISAM DEFAULT CHARSET=utf8;

2.继承CrawlSpider

scrapy genspider -t crawl lagou www.lagou.com

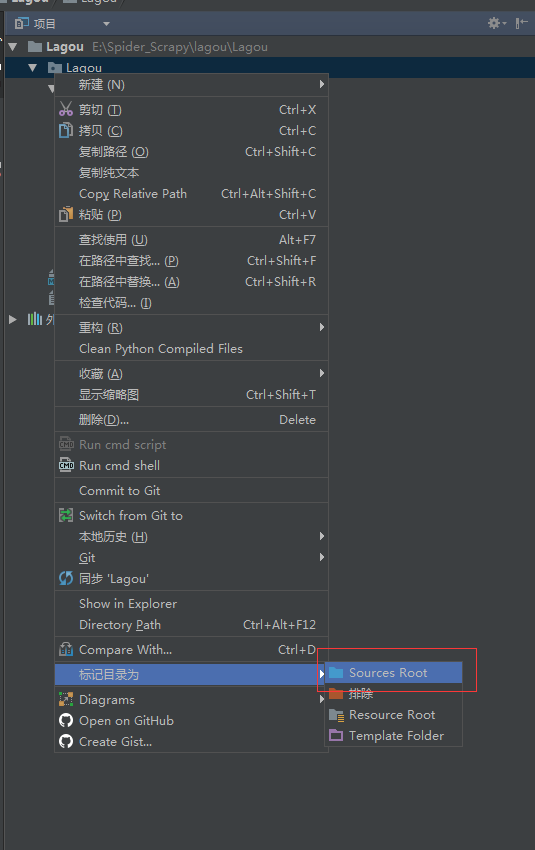

3.根目录问题

有时候from ... import ...出错的时候,可以看看根目录是不是对的

4.CrawlSpider使用说明

参考scrapy文档: http://scrapy-chs.readthedocs.io/zh_CN/latest/topics/spiders.html#crawlspider

作者:今孝

出处:http://www.cnblogs.com/jinxiao-pu/p/6757603.html

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接。

欢迎博友指出错误,我将改进,共同提高技术。