Hadoop(28)hdfs小文件解决方案总结

hdfs小文件解决方案总结

小文件的问题弊端

HDFS上每个文件都要在NameNode上建立一个索引,这个索引的大小约为150byte,这样当小文件比较多的时候,就会产生很多的索引文件,一方面会大量占用NameNode的内存空间,另一方面就是索引文件过大使得索引速度变慢。

小文件的解决方案

小文件的优化无非以下几种方式:

(1)在数据采集的时候,就将小文件或小批数据合成大文件再上传HDFS。

(2)在业务处理之前,在HDFS上使用MapReduce程序对小文件进行合并。

(3)在MapReduce处理时,可采用CombineTextInputFormat提高效率。

-

Hadoop archive小文件打包成一个文件

-

Sequence File二进制的key/value组成的文件,用来将大批小文件合并成一个大文件

-

CombineFileInputFormat一个输入类,可以将多个文件合并成一个分片

-

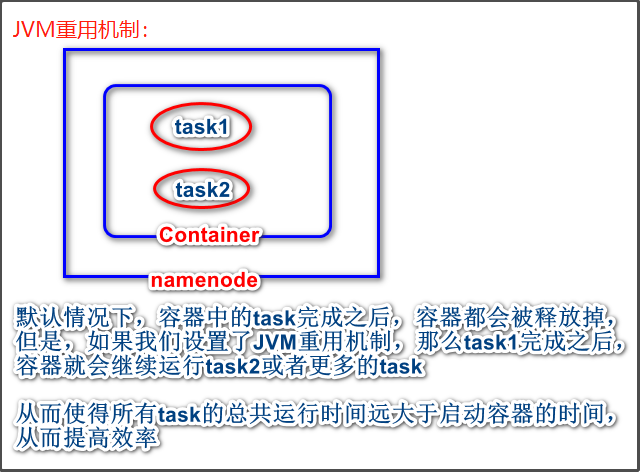

开启

JVM重用对于大量小文件的

Job,可以开启JVM重用,大约会减少15%的运行时间。原理:一个

map运行在一个JVM上(可看成容器的JVM?),该map在JVM上运行完毕后,JVM继续运行其它map。将参数

mapreduce.job.jvm.numtasks的值设为10-20之间即可。JVM重用机制示意图如下: