Hive(2) hive安装部署

Hive安装部署

安装前准备

- 安装好对应版本的

hadoop集群(三节点),并启动hadoop的HDFS以及YARN服务 Node03安装了MySQL服务,并启动MySQL的服务

安装注意事项

注意hive就是一个构建数据仓库的工具,只需要在一台服务器上安装就可以了,不需要在多台服务器上安装。 此处以安装到node03为例;

使用hadoop普通用户操作

安装步骤

准备安装包

-

通过浏览器下载

hive的安装包 -

上传安装包到

node03服务器中的/kkb/soft路径下

解压安装包

-

解压安装包到指定的规划目录

/kkb/install[hadoop@node03 ~]$ cd /kkb/soft/ [hadoop@node03 soft]$ tar -xzvf hive-1.1.0-cdh5.14.2.tar.gz -C /kkb/install/

修改配置文件

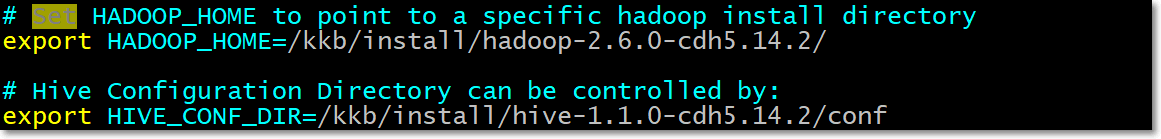

修改配置文件hive-env.sh

- 进入到

Hive的安装目录下的conf文件夹中

[hadoop@node03 soft]$ cd /kkb/install/hive-1.1.0-cdh5.14.2/conf/

- 重命名

hive-env.sh.template

[hadoop@node03 conf]$ mv hive-env.sh.template hive-env.sh

- 修改

hive-env.sh

[hadoop@node03 conf]$ vim hive-env.sh

- 如下,修改此文件中

HADOOP_HOME、HIVE_CONF_DIR的值(根据自己机器的实际情况配置)

#配置HADOOP_HOME路径

HADOOP_HOME=/kkb/install/hadoop-2.6.0-cdh5.14.2/

#配置HIVE_CONF_DIR路径

export HIVE_CONF_DIR=/kkb/install/hive-1.1.0-cdh5.14.2/conf

修改配置文件hive-site.xml

conf目录下默认没有此文件,vim创建即可

[hadoop@node03 conf]$ vim hive-site.xml

- 文件内容如下

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!--指定元数据存储在mysql的哪个数据库里-->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://node03:3306/hive?createDatabaseIfNotExist=true&characterEncoding=latin1&useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

<property>

<name>hive.cli.print.header</name>

<value>true</value>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>node03</value>

</property>

</configuration>

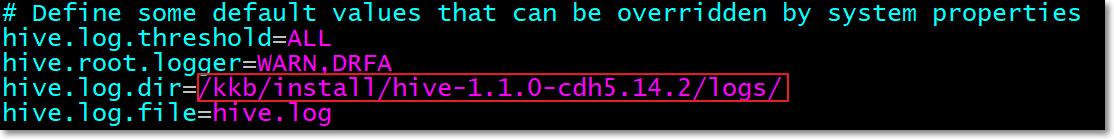

修改日志配置文件hive-log4j.properties

创建hive日志存储目录

[hadoop@node03 conf]$ mkdir -p /kkb/install/hive-1.1.0-cdh5.14.2/logs/

重命名生成文件hive-log4j.properties

[hadoop@node03 conf]$ pwd

/kkb/install/hive-1.1.0-cdh5.14.2/conf

[hadoop@node03 conf]$ mv hive-log4j.properties.template hive-log4j.properties

[hadoop@node03 conf]$ vim hive-log4j.properties # 修改文件

修改此文件的hive.log.dir属性的值

#更改以下内容,设置我们的hive的日志文件存放的路径,便于排查问题

hive.log.dir=/kkb/install/hive-1.1.0-cdh5.14.2/logs/

拷贝mysql驱动包

-

上传

mysql驱动包,如mysql-connector-java-5.1.38.jar到/kkb/soft目录中 -

由于运行

hive时,需要向mysql数据库中读写元数据,所以需要将mysql的驱动包上传到hive的lib目录下

[hadoop@node03 ~]$ cd /kkb/soft/

[hadoop@node03 soft]$ cp mysql-connector-java-5.1.38.jar /kkb/install/hive-1.1.0-cdh5.14.2/lib/

配置Hive环境变量

- 切换到

root用户下

[hadoop@node03 soft]$ su root

Password:

- 打开

/etc/profile文件

[root@node03 soft]# vim /etc/profile

- 末尾添加如下内容

export HIVE_HOME=/kkb/install/hive-1.1.0-cdh5.14.2

export PATH=$PATH:$HIVE_HOME/bin

- 切换回hadoop用户,并source

[root@node03 soft]# su - hadoop

[hadoop@node03 soft]$ source /etc/profile

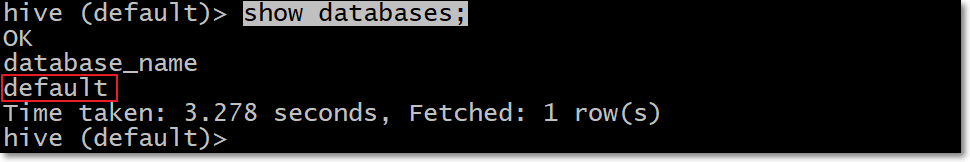

验证安装

- hadoop集群已启动

- mysql服务已启动

- 在

node03上任意目录启动hive cli命令行客户端

[hadoop@node03 ~]$ hive

- 查看有哪些数据库

show databases;

- 说明

hive安装成功 - 退出

cli

quit;