Kylin-2.6.2集群部署

1. 集群节点规划与说明

rzx1 all

rzx2 query

rzx3 query

说明:

Kylin节点角色有三种:

all: 包含query和job

query: 查询节点

job: 工作节点

2. Kylin依赖的其他大数据组件非常多,下列列表是安装kylin需要的组件

JDK 1.8<必须项>

HADOOP<必须项,hdfs作为数据存储基础,这里版本是hadoop-2.7.7>

ZOOKEERER<必须项,集群协调,这里版本zookeeper-3.4.13>

HBASE<必须项,可以理解为数据中间件,这里版本hbase-2.0.4>

HIVE<必须项,kylin OLAP基础数仓或可以理解为OLAP数据源,这里版本hive-2.3.4>

KAFKA<可选项,这里不安装>

3. 在已下载解压好的目录下

<下载地址: https://archive.apache.org/dist/kylin/>

在rzx1节点下:

vim conf/kylin.properties:

kylin.server.mode=all

kylin.server.cluster-servers=rzx1:7070,rzx2:7070,rzx3:7070

kylin.coprocessor.local.jar=/home/bigdata/software/kylin-2.6.2/lib/kylin-coprocessor-2.6.2.jar

说明:开发测试环境目前只安装简易版,该配置文件配置参数非常多,实际生产环境需要根据实际情况来配置

4. 在rzx1节点下将上面配置好的kylin目录scp到rzx2,rzx3节点上

在kylin当前目录的上一层目录上:

scp -r kylin-2.6.2 root@rzx2:/home/bigdata/software/

scp -r kylin-2.6.2 root@rzx2:/home/bigdata/software/

将rzx2,rzx3节点kylin目录下conf/kylin.properties的

kylin.server.mode改为query

kylin.server.mode=query

5. 配置kylin环境变量

前提配置好kylin依赖的组件的环境变量

export KYLIN_HOME=/home/bigdata/software/kylin-2.6.2

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$HIVE_HOME/bin:$ZK_HOME/bin:$KAFKA_HOME/bin:$HBASE_HOME/bin:$HCAT_HOME/bin:$KYLIN_HOME/bin:$PATH

这里为了方便kylin依赖的完整组件的环境变量,贴出我的全部环境变量配置:

export JAVA_HOME=/home/bigdata/software/jdk1.8.0_201

export HADOOP_HOME=/home/bigdata/software/hadoop-2.7.7

export HADOOP_MAPRED_HOME=${HADOOP_HOME}

export HADOOP_COMMON_HOME=${HADOOP_HOME}

export HADOOP_HDFS_HOME=${HADOOP_HOME}

export YARN_HOME=${HADOOP_HOME}

export HIVE_HOME=/home/bigdata/software/hive-2.3.4

export HIVE_CONF_DIR=/home/bigdata/software/hive-2.3.4/conf

export HCAT_HOME=$HIVE_HOME/hcatalog

export ZK_HOME=/home/bigdata/software/zookeeper-3.4.13

export KAFKA_HOME=/home/bigdata/software/kafka_2.11-2.0.0

export HBASE_HOME=/home/bigdata/software/hbase-2.0.4

export KYLIN_HOME=/home/bigdata/software/kylin-2.6.2

export HADOOP_COMMON_LIB_NATIVE_DIR=${HADOOP_HOME}/lib/natvie

export HADOOP_OPTS="-Djava.library.path=${HADOOP_HOME}/lib:${HADOOP_HOME}/lib/native"

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$HIVE_HOME/bin:$ZK_HOME/bin:$KAFKA_HOME/bin:$HBASE_HOME/bin:$HCAT_HOME/bin:$KYLIN_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

6. 上面配置完成无误后,启动kylin依赖检测

前提:检测前要确保hadoop,zookeeper,hbase,hive正常启动

检测依次执行以下命令:

# 执行下面的检查命令会在 hdfs 上创建 kylin 目录

./check-env.sh

# 检查数据源 hive 和数据存储 hbase

./find-hive-dependency.sh

./find-hbase-dependency.sh

说明:如果环境变量配置不正确,依赖组件不能正常启动,检测是不会通过的,只能一项项去排查了

7. 在每个节点上都启动kylin集群

kylin.sh start

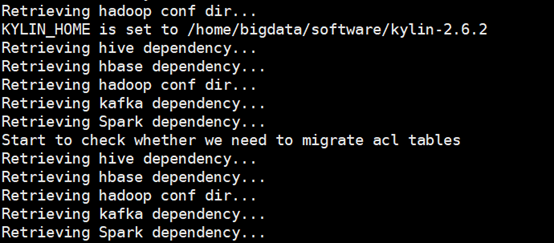

说明:执行启动命令后kylin会去自动检测它需要的相关组件的相关依赖,如下图提示

这里需要主要,如果你没有安装spark,kylin就回检测它依赖的执行引擎的相关依赖不存在,所以会提示用本身提供的脚本去下载,如果你的大数据计算引擎不是spark按照提示下载即可,如果是只需要正确配置就可以了,在kylin的bin目录下提供了下载spark的脚本

bin/download-spark.sh

这里事先下载好了所以不会提示

8. 验证

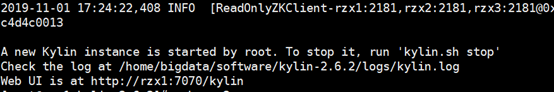

在第7部启动结束末尾提示

证明启动无误,注意三个节点都需要得到该提示才会证明完全成功,不然就会出现query和job能力缺少导致功能不能使用

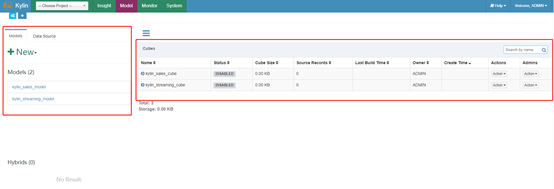

进一步根据提示通过图形化界面确认

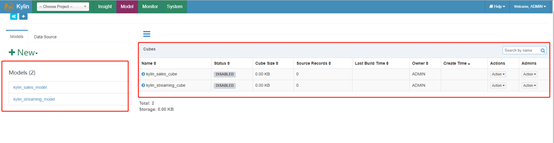

注意:表红框的地方在正确无误启动后不会立即有,因为这是数据及模型,所有启动成功后Models,Datasour,Cubes都是空的

9. 加入数据及模型

Kylin很贴心,知道你第一次不会,所以提供了一个实例化kylin三个核心Models,Datasour,Cubes的脚本,该脚本在kylin目录下bin目录下

bin/sample.sh

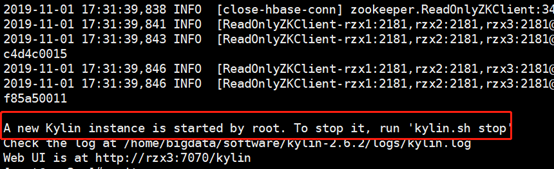

正确启动后再执行bin/sample.sh,这个过程需要一些时间,当看到下面信息,证明正确创建了一个kylin instance

根据提示,需要重启kylin实例才能生效,所以重启kylin

注意:kylin提供的命令不支持

kylin.sh restart

所以只能先

kylin.sh stop

再

kylin.sh start

注意是每个节点

进行如上操作后再查看可视化界面:

至此kylin部署配置,启动,添加样例实例全部成功

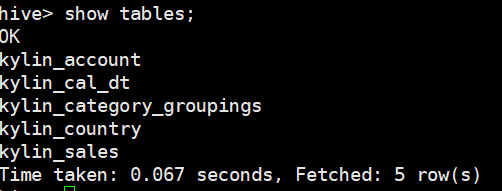

10. 还可以验证hive上是否有kylin相关数据实例的表

说明: 这里只是简易的开发测试集群搭建配置,实际数据量过大的生产环境配置可能相对复杂些