Spark2.1.0——运行环境准备

学习一个工具的最好途径,就是使用它。这就好比《极品飞车》玩得好的同学,未必真的会开车,要学习车的驾驶技能,就必须用手触摸方向盘、用脚感受刹车与油门的力道。在IT领域,在深入了解一个系统的原理、实现细节之前,应当先准备好它的运行环境或者源码阅读环境。如果能在实际环境下安装和运行Spark,显然能够提升读者对于Spark的一些感受,对系统能有个大体的印象,有经验的工程师甚至能够猜出一些Spark在实现过程中采用的设计模式、编程模型。

考虑到大部分公司在开发和生产环境都采用Linux操作系统,所以笔者选用了64位的Linux。在正式安装Spark之前,先要找台好机器。为什么?因为笔者在安装、编译、调试的过程中发现Spark非常耗费内存,如果机器配置太低,恐怕会跑不起来。Spark的开发语言是Scala,而Scala需要运行在JVM之上,因而搭建Spark的运行环境应该包括JDK和Scala。

本文只介绍最基本的与Spark相关的准备工作,至于Spark在实际生产环境下的配置,则需要结合具体的应用场景进行准备。

安装JDK

自Spark2.0.0版本开始,Spark已经准备放弃对Java 7的支持,所以我们需要选择Java 8。我们还需要使用命令getconf LONG_BIT查看linux机器是32位还是64位,然后下载相应版本的JDK并安装。

下载地址:

http://www.oracle.com/technetwork/java/javase/downloads/index.html。

配置环境:

1 2 | cd ~vim .bash_profile |

添加如下配置:

1 2 3 | exportJAVA_HOME=/opt/javaexportPATH=$PATH:$JAVA_HOME/binexportCLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar |

输入以下命令使环境变量快速生效:

1 | source .bash_profile |

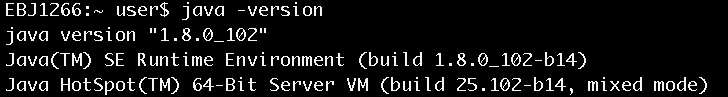

安装完毕后,使用java –version命令查看,确认安装正常,如图1所示。

图1 查看java安装是否正常

安装Scala

由于从Spark 2.0.0开始,Spark默认使用Scala 2.11来编译、打包,不再是以前的Scala 2.10,所以我们需要下载Scala 2.11。

下载地址:

http://www.scala-lang.org/download/

选择Scala 2.11的版本进行下载,下载方法如下:

1 | wget https://downloads.lightbend.com/scala/2.11.8/scala-2.11.8.tgz |

移动到选好的安装目录,例如:

1 | mv scala-2.11.8.tgz~/install/ |

进入安装目录,执行以下命令:

1 2 | chmod 755scala-2.11.8.tgztar -xzvfscala-2.11.8.tgz |

配置环境:

1 2 | cd ~vim .bash_profile |

添加如下配置:

1 2 | export SCALA_HOME=$HOME/install/scala-2.11.8export PATH=$SCALA_HOME/bin:$PATH |

输入以下命令使环境变量快速生效:

1 | source .bash_profile |

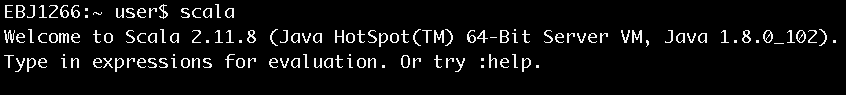

安装完毕后键入scala,进入scala命令行以确认安装正常,如图2所示。

图2 进入Scala命令行

安装Spark

Spark进入2.0时代之后,目前一共有两个大的版本:一个是2.0.0,一个是2.1.0。本书选择2.1.0。

下载地址:

http://spark.apache.org/downloads.html

下载方法如下:

1 | wget http://d3kbcqa49mib13.cloudfront.net/spark-2.1.0-bin-hadoop2.6.tgz |

移动到选好的安装目录,如:

1 | mv spark-2.1.0-bin-hadoop2.6.tgz~/install/ |

进入安装目录,执行以下命令:

1 2 | chmod 755 spark-2.1.0-bin-hadoop2.6.tgztar -xzvf spark-2.1.0-bin-hadoop2.6.tgz |

配置环境:

1 2 | cd ~vim .bash_profile |

添加如下配置:

1 2 | export SPARK_HOME=$HOME/install/spark-2.1.0-bin-hadoop2.6export PATH=$SPARK_HOME/bin:$PATH |

输入以下命令使环境变量快速生效:

1 | source .bash_profile |

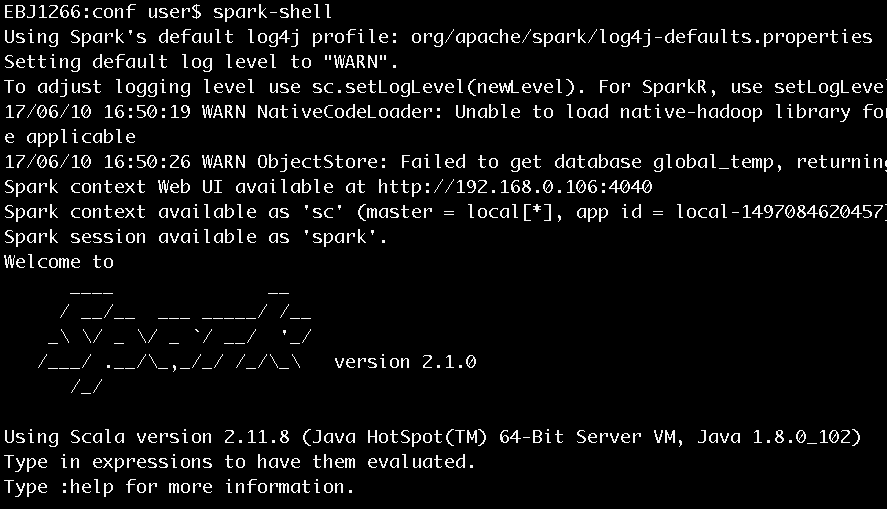

安装完毕后键入spark-shell,进入scala命令行以确认安装正常,如图3所示。

图3 执行spark-shell进入Scala命令行

有了对spark运行环境的准备,下面就可以来看看《Spark2.1.0之初体验》

想要对Spark源码进行阅读的同学,可以看看《Spark2.1.0之代码结构及载入Ecplise方法》

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· Ollama——大语言模型本地部署的极速利器

· DeepSeek如何颠覆传统软件测试?测试工程师会被淘汰吗?