2.3 PySpark安装(Hadoop3.0)

2.3 PySpark安装(Hadoop3.0)

【实验目的】

1.学习PySpark的安装配置

2.了解PySpark的运行原理

【实验原理】

PySpark简介:官方对PySpark的释义为:“PySpark is the Python API for Spark”。 也就是说pyspark为Spark提供的Python编程接口。

Spark使用py4j来实现python与java的互操作,从而实现使用python编写Spark程序。Spark也同样提供了pyspark,一个Spark的python shell,可以以交互式的方式使用Python编写Spark程序。 如:

from pyspark import SparkContext sc = SparkContext("local","Job Name", pyFiles=['MyFile.py', 'lib.zip', 'app.egg']) words =sc.textFile("/usr/share/dict/words") words.filter(lambda w:w.startswith("spar")).take(5) |

PySpark文档主页界面:

https://spark.apache.org/docs/latest/api/python/index.html

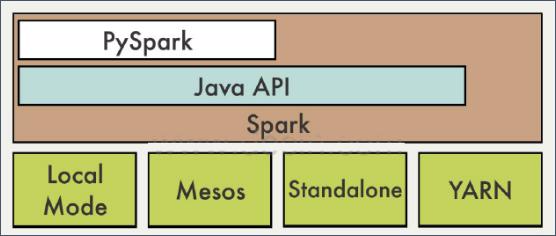

PySpark是构建在Java API之上的,如下图:

【实验环境】

Anolis8.8

Java 1.8.0

Hadoop-3.0.0

Pycharm

Eclipse-JEE 2022.03

spark 3.5.0

【实验内容】

在Linux环境下,安装PySpark,并在PyChram中配置Pyspark的Spark开发环境。

【实验步骤】

切换到 vmuser 用户,完成本次实验(密码:vm123456)

su vmuser

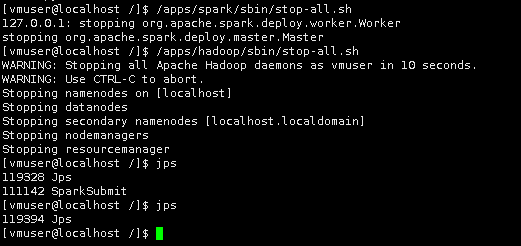

关闭spark

/apps/spark/sbin/stop-all.sh

关闭hadoop

/apps/hadoop/sbin/stop-all.sh

jps

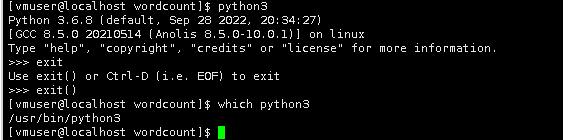

检查python3是否已安装

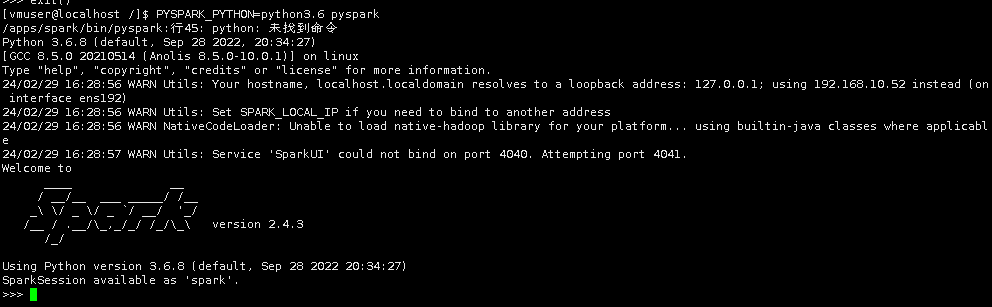

使用下面命令打开pyspark shell

PYSPARK_PYTHON=python3.6 pyspark

在python shell中导入pyspark模块

另开启一个终端,使用vim命令打开~/.bashrc文件(密码:vm123456)

su vmuser

sudo vim ~/.bashrc

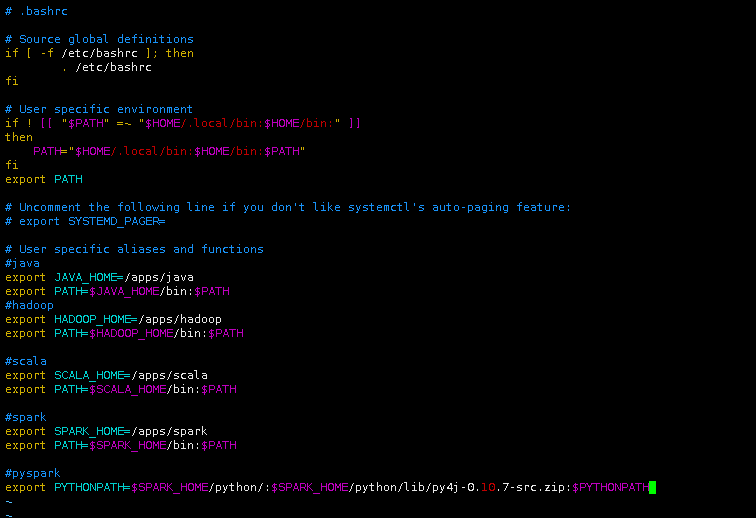

将下面代码添加到~/.bashrc文件

#pyspark export PYTHONPATH=$SPARK_HOME/python/:$SPARK_HOME/python/lib/py4j-0.10.7-src.zip:$PYTHONPATH |

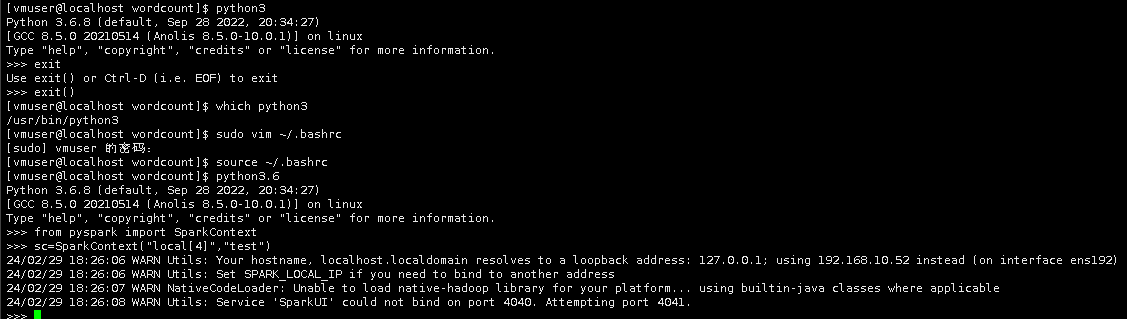

声明环境变量,使其生效

source ~/.bashrc

18.在任意目录下启动Python解释器

python3.6

并在解释器里输入下面命令。

from pyspark import SparkContext

sc=SparkContext("local[4]","test")

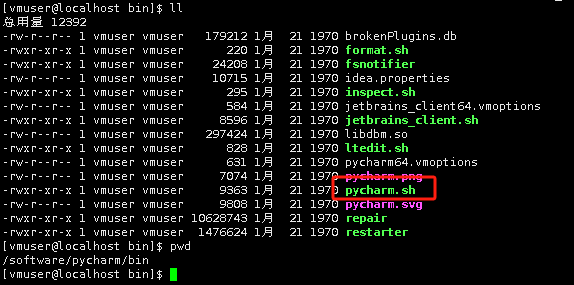

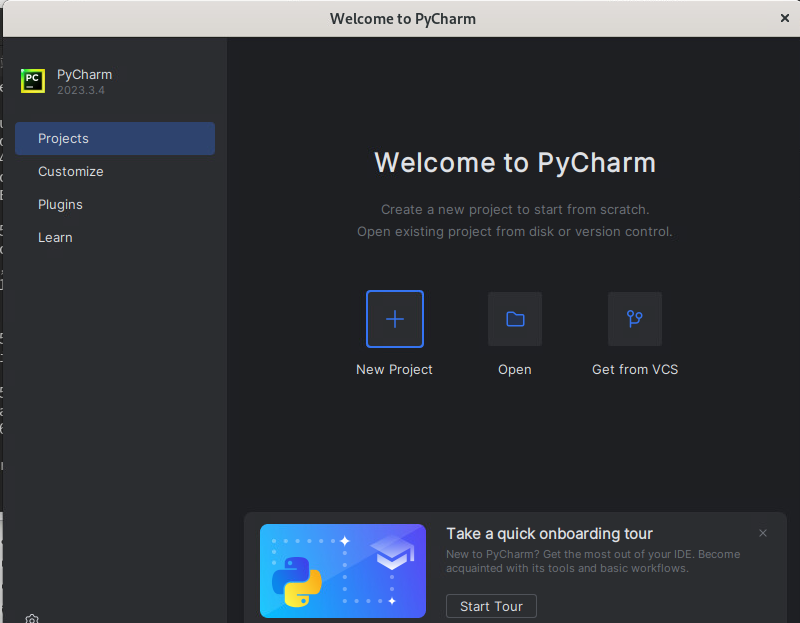

下载pycharm-community-2023.3.4.tar.gz文件

sudo chown -R vmuser:vmuser pycharm-community-2023.3.4.tar.gz

tar -zxvf pycharm-community-2023.3.4.tar.gz

mv pycharm-community-2023.3.4 pycharm

在PyChram中配置Pyspark的Spark开发环境

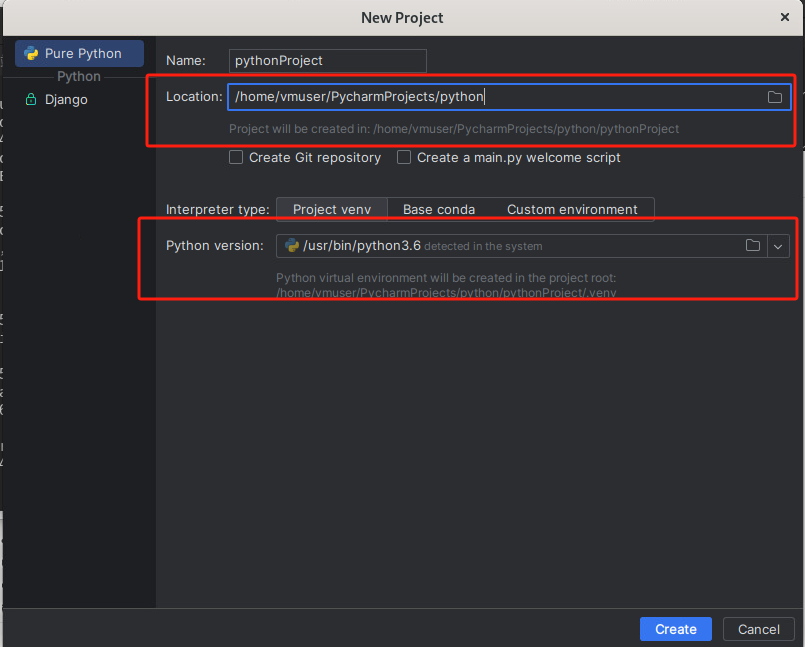

打开PyCharm,点击【新建项目】。注意要选择python解释器为3.6

点击【新建项目】,Location为【/home/vmuser/PycharmProjects/Python】,点击【创建】完成创建。

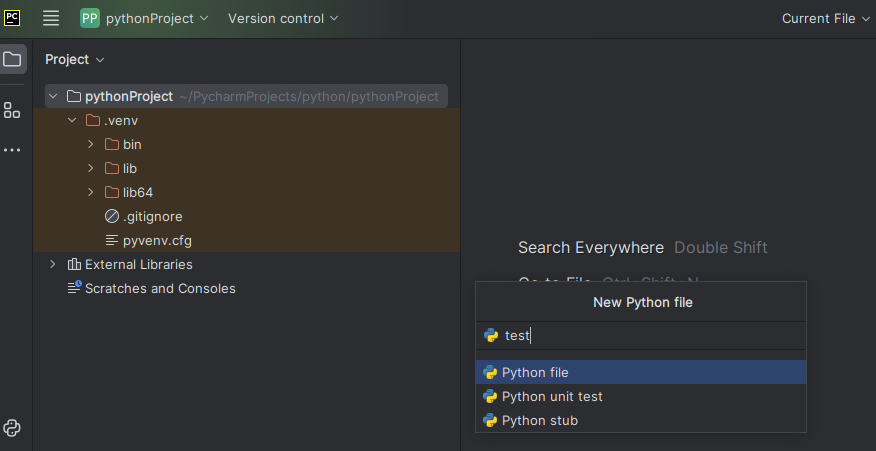

在Python项目下,点击项目名--->【New】--->【Python File】命名为【test】

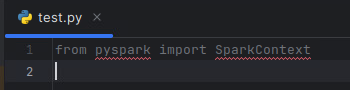

在test.py文件内输入

from pyspark import SparkContext

一开始导入会出现红线

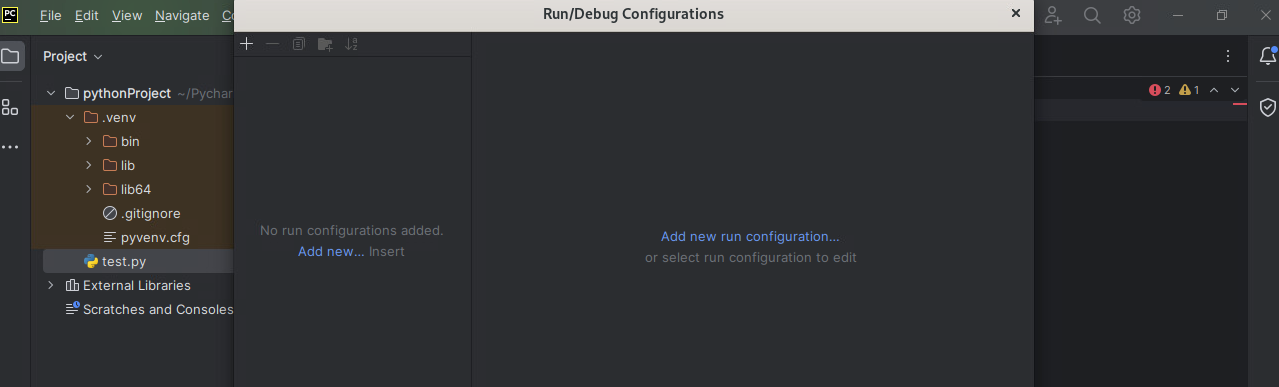

点击左上角红框--->【Run】--->【Edit Configurations】

进入设置界面。点击左上角的加号按钮(“+”),选择Python。

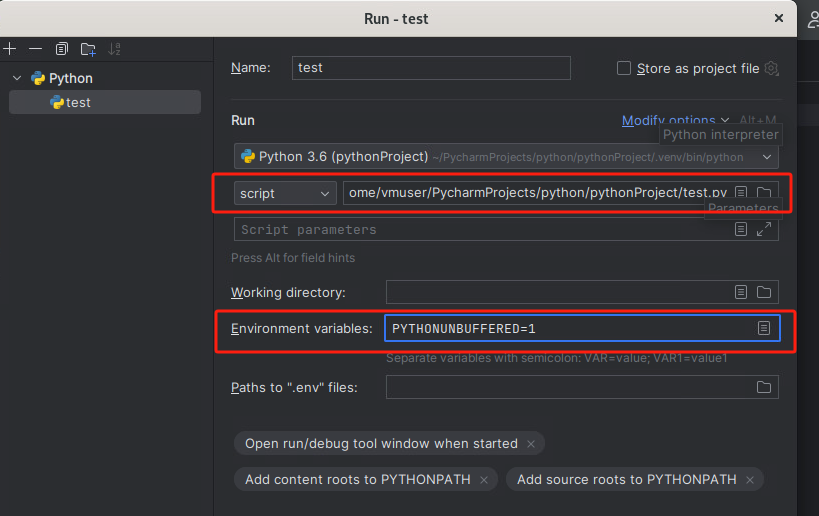

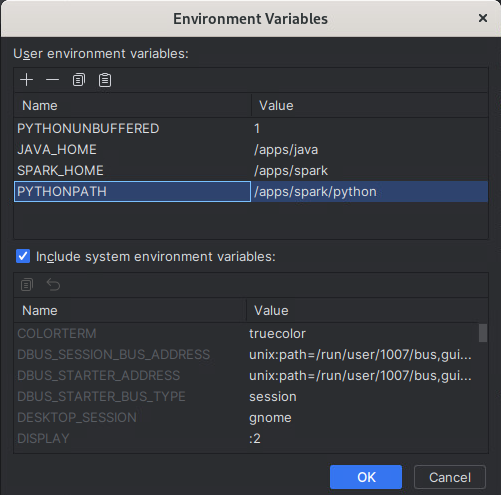

23.点击加号按钮(“+”),设置三个环境变量。

设置为如下所示,点击【OK】--->【OK】

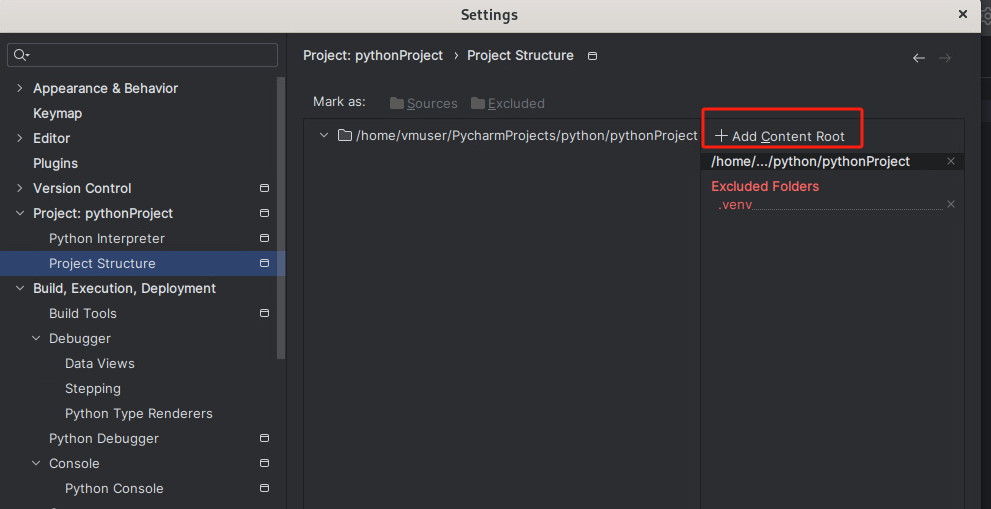

依次点击红框--->【File】-- -> 【Setting...】

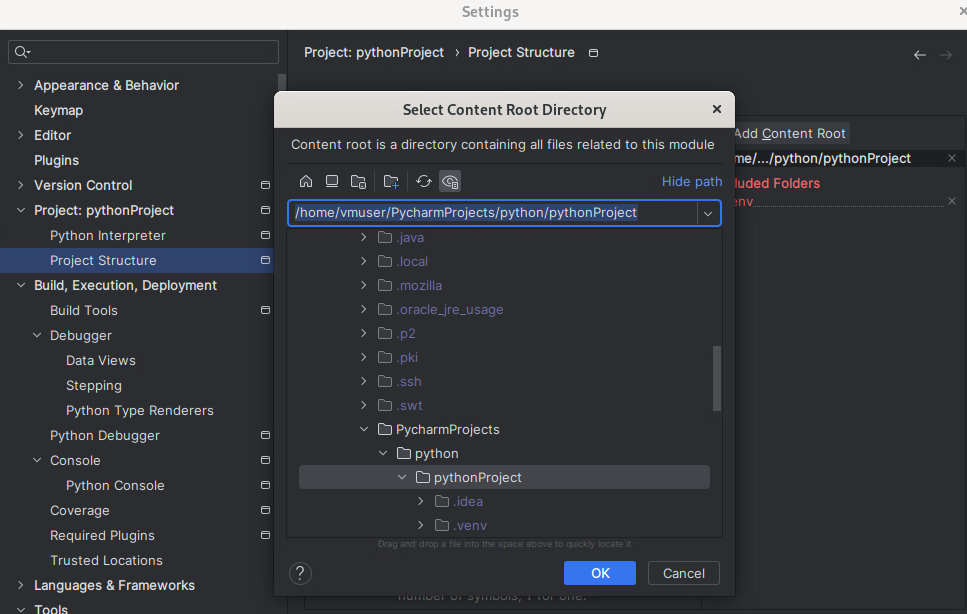

进入配置界面,依次选择【Project:Python】---> 【Project Structrue】,点击右边的“【+ Add Content Root】

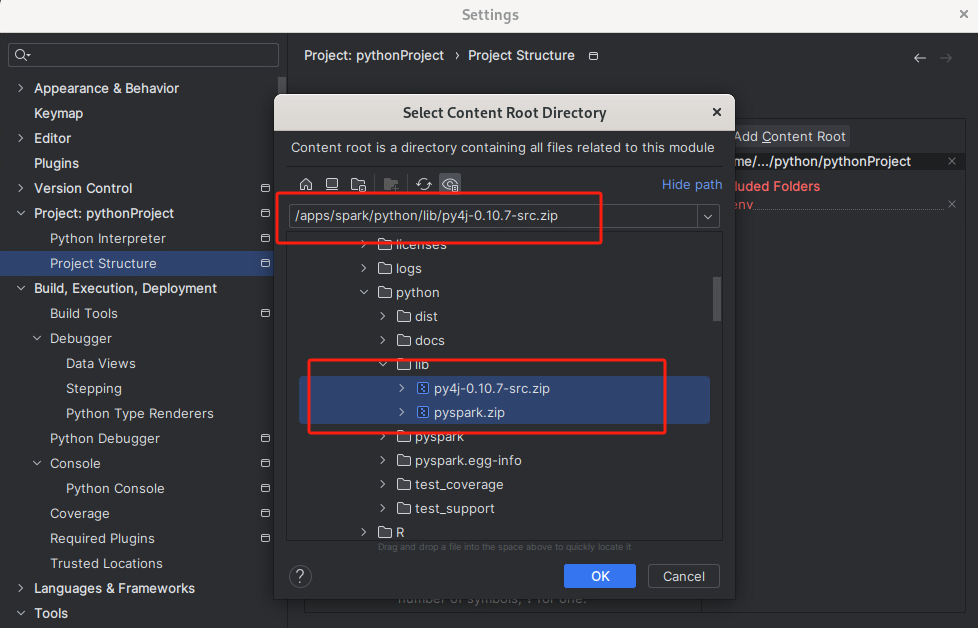

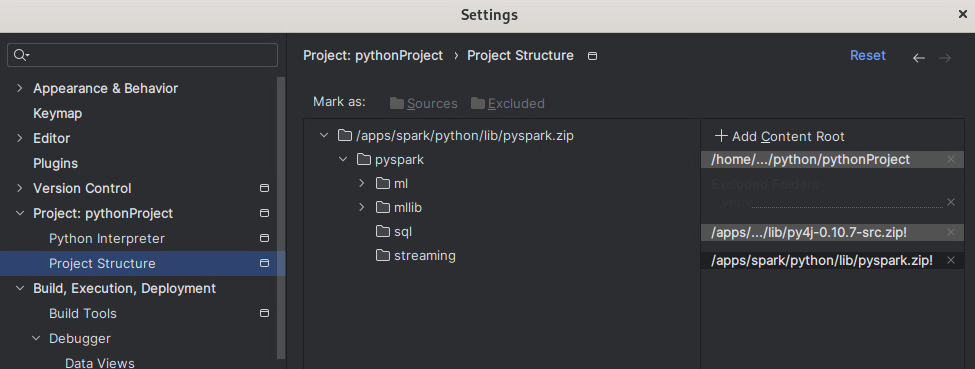

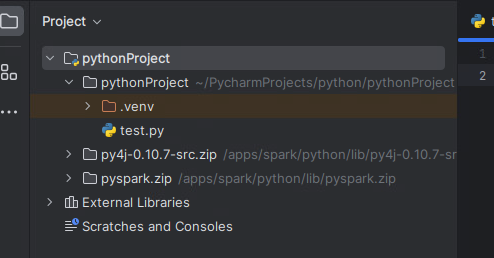

将/apps/spark/python/lib目录下的py4j-0.10.7-src.zip和pyspark.zip选中添加进来,点击【OK】--->【OK】

添加完成后,可以看到在test.py文件中导入from pyspark import SparkContext时,红线消失,运行正常。

保存test.py,并关闭PyCharm。

至此,实验结束!

浙公网安备 33010602011771号

浙公网安备 33010602011771号