Bert whole mask为什么效果比mask字效果更好?

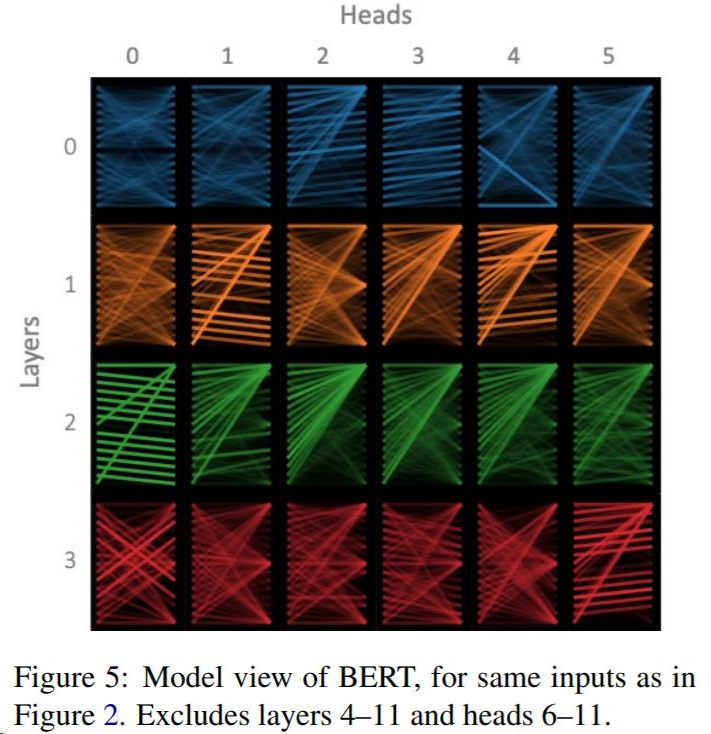

论文What Does BERT Look At? An Analysis of BERT’s Attention 指出bert的多头注意力,不同的头可以学到不同的信息,有的学到词法、有的学到语法、语义。

论文地址:https://arxiv.org/pdf/1908.11365.pdf

举例如:现在好饿呀,我们去吃饭,好不好? MASK字的方式: 现在好饿呀,我们去吃[MASK],好不好?

MASK词的方式: 现在好饿呀,我们去[MASK] [MASK],好不好? 可以发现MASK字的话模型很容易根据“吃”推断出MASK位置是“饭”的概率很高。

而MASK词的方式明显将任务的难度扩大,需要学习更多的上下文比如上文中“饿”的信息,来推断出两个MASK位置可能是“吃饭”的可能性比较大。

所以说MASK词的方式使得模型预训练时被迫更加关注上下文信息,学到更多的语义,从而下游任务能够表现更好。

三年程序员,专注语音文本分析、大数据挖掘、预训练模型及知识图谱相关技术的探索

浙公网安备 33010602011771号

浙公网安备 33010602011771号