[Bayes] Latent Gaussian Process Models

比较难理解,通过做题来入门。

目的:简单的了解下相关概念。

基础

热身

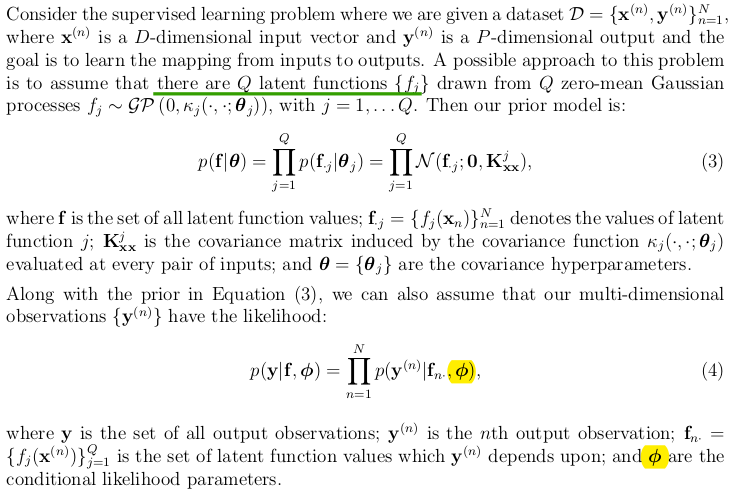

目的:找x到y的映射关系。

假设:Q latent functions {fi}

fj 作为先验,跟x没什么直接关系,x只是作为承载超参数的载体。共有Q个,也就是有Q套超参数。

对于公式(4),x --> f --> (noise) --> y,大概就是这么个关系。

因为noise,当然y是iid。

由公式(3)可见,f也是iid。

一般而言,Q等于多分类的类别数量,P = 1即可(无需one-hot)。

开始

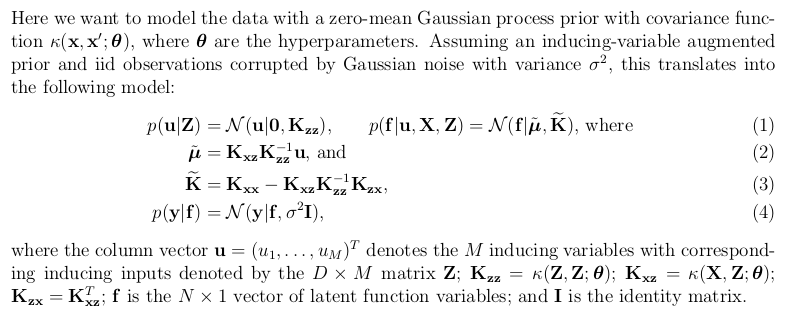

没看错,这么多符号,需要缕一缕,看不懂的概念可以参考以下链接。

Ref: Generic Inference in Latent Gaussian Process Models

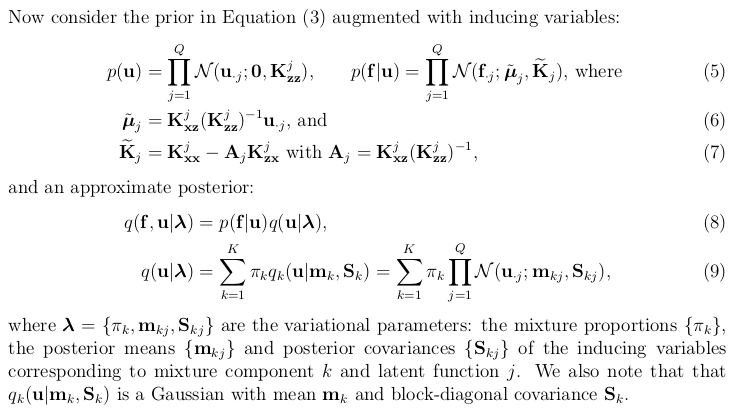

(5) (6) (7) 其实跟(3)一回事:

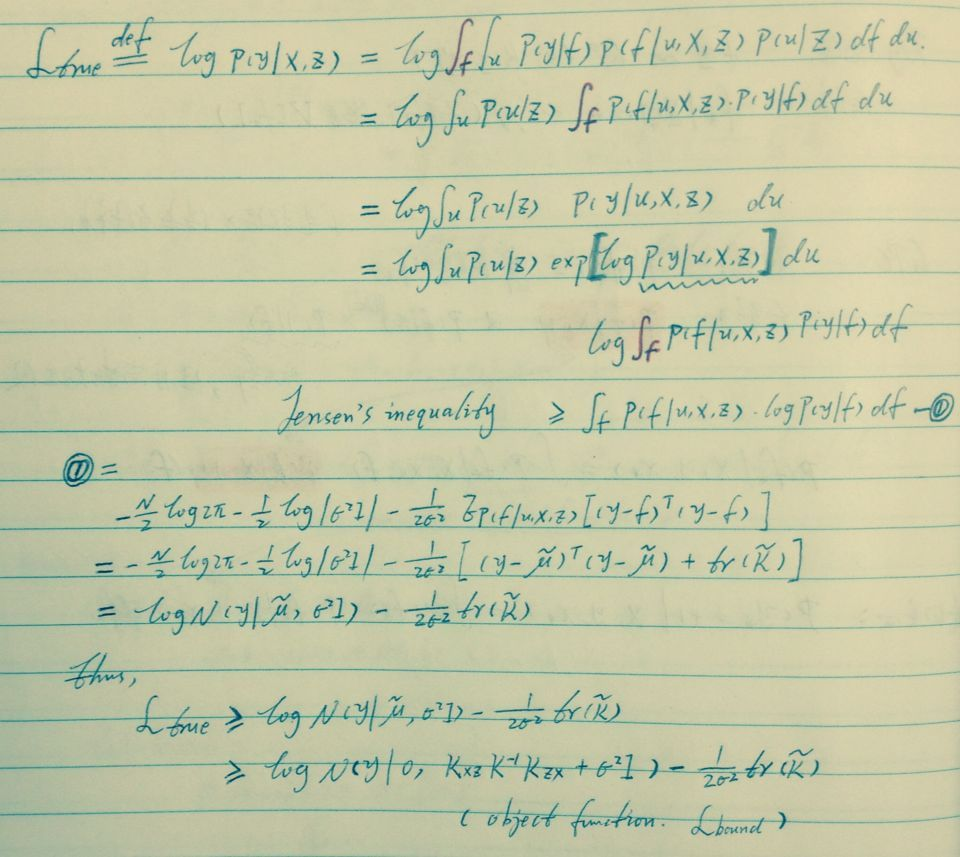

既然多出了变量u,就分解出来看看:

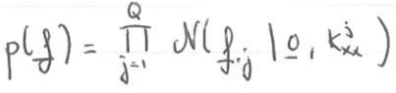

带入已知条件,最后得:

高斯与高斯的联姻,结果还是高斯,就是在说这个。

这里主要是熟悉两个bound,对比下效果,以下是背景。

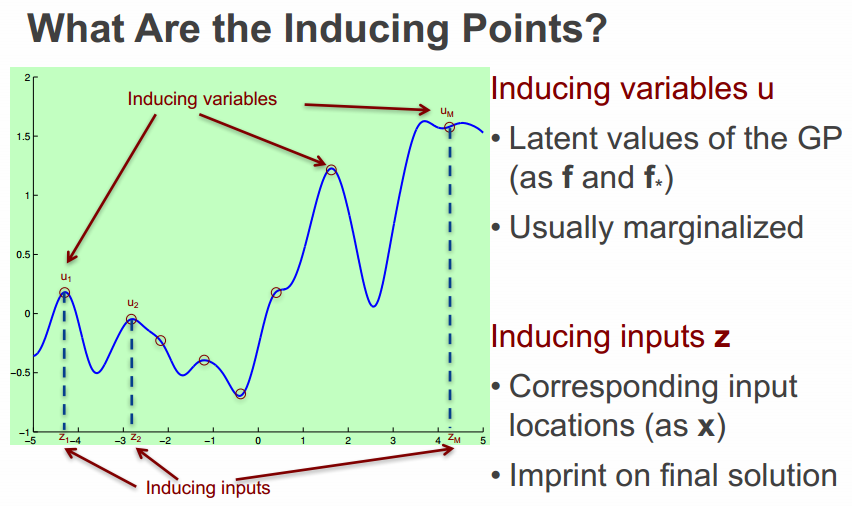

Inducing variables:ui

简单的理解为重要的某些点即可。

两个bound如下,可见后者计算复杂度更低。

浙公网安备 33010602011771号

浙公网安备 33010602011771号