kafka文件存储机制

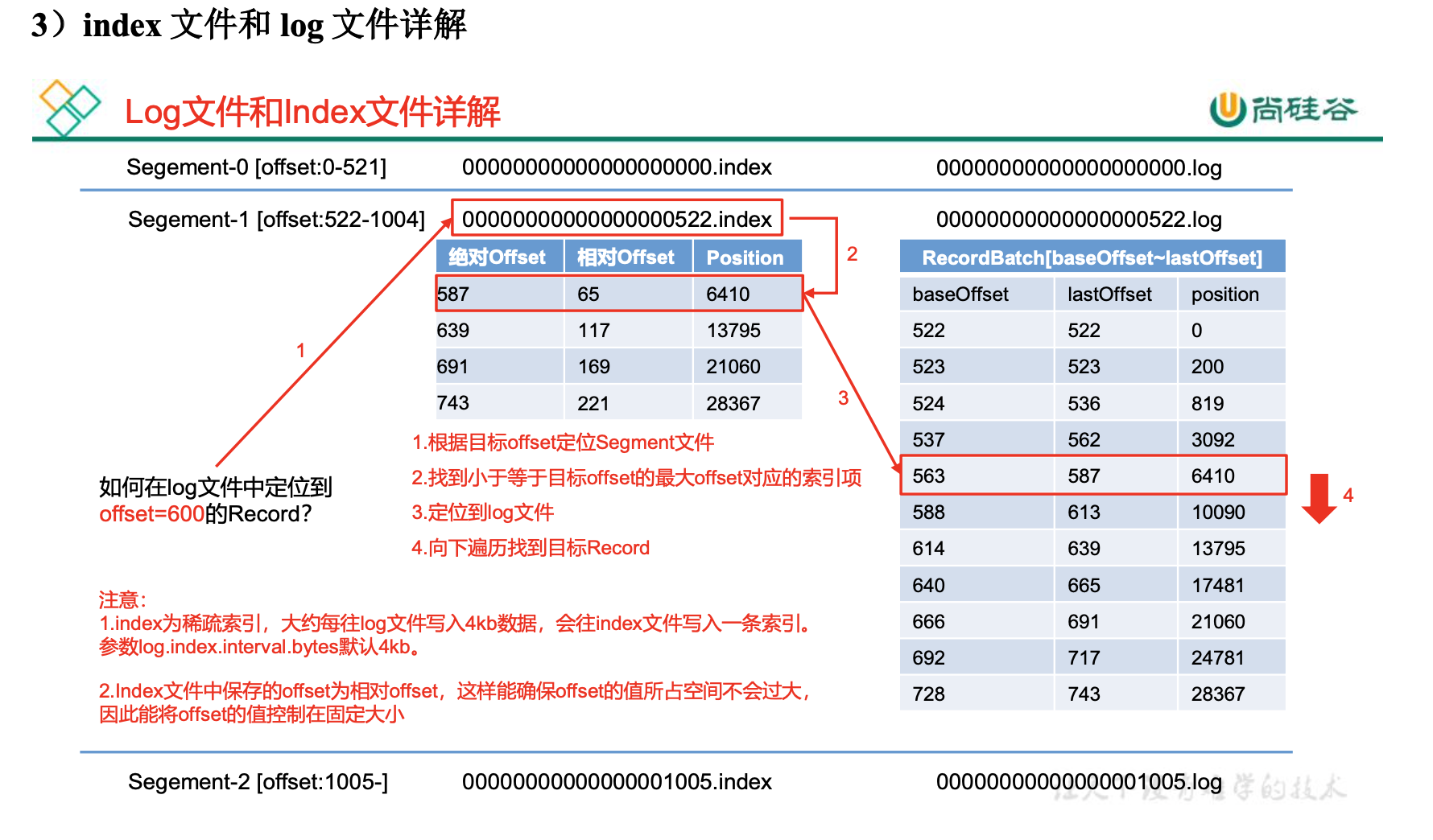

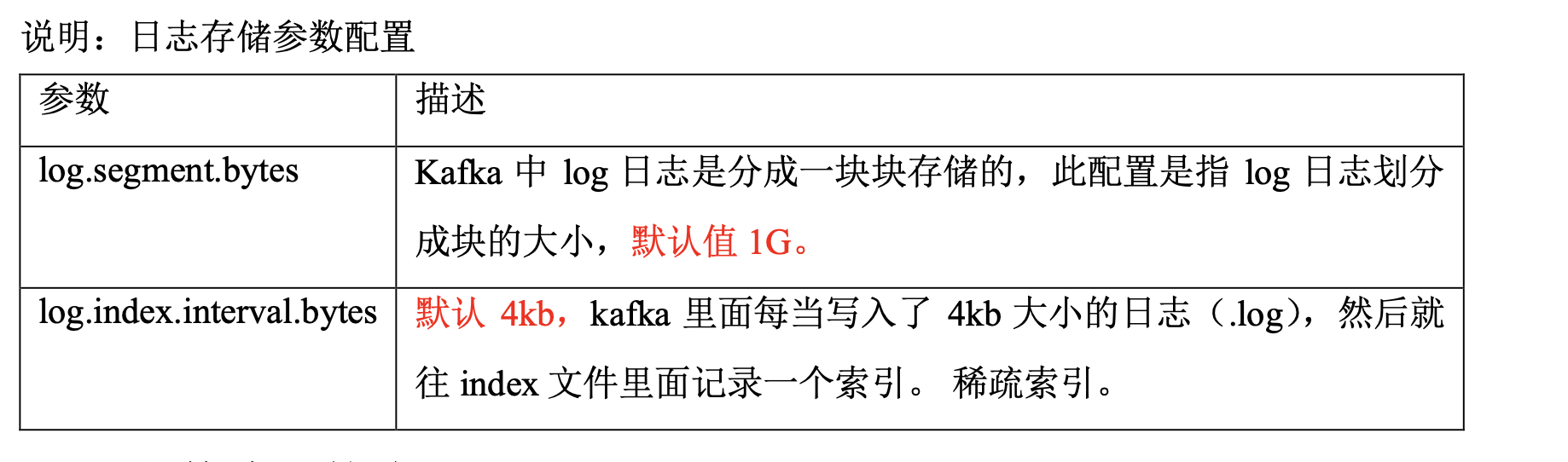

1.index为稀疏索引,大约每往log文件写入4kb数据,会往index文件写入一条索引。注意: 参数log.index.interval.bytes默认4kb。

2.Index文件中保存的offset为相对offset,这样能确保offset的值所占空间不会过大, 因此能将offset的值控制在固定大小

文件清理策略

Kafka 中默认的日志保存时间为 7 天,可以通过调整如下参数修改保存时间。

- log.retention.hours,最低优先级小时,默认7天。

- log.retention.minutes,分钟。

- log.retention.ms,最高优先级毫秒。

- log.retention.check.interval.ms,负责设置检查周期,默认5分钟。 那么日志一旦超过了设置的时间,怎么处理呢?

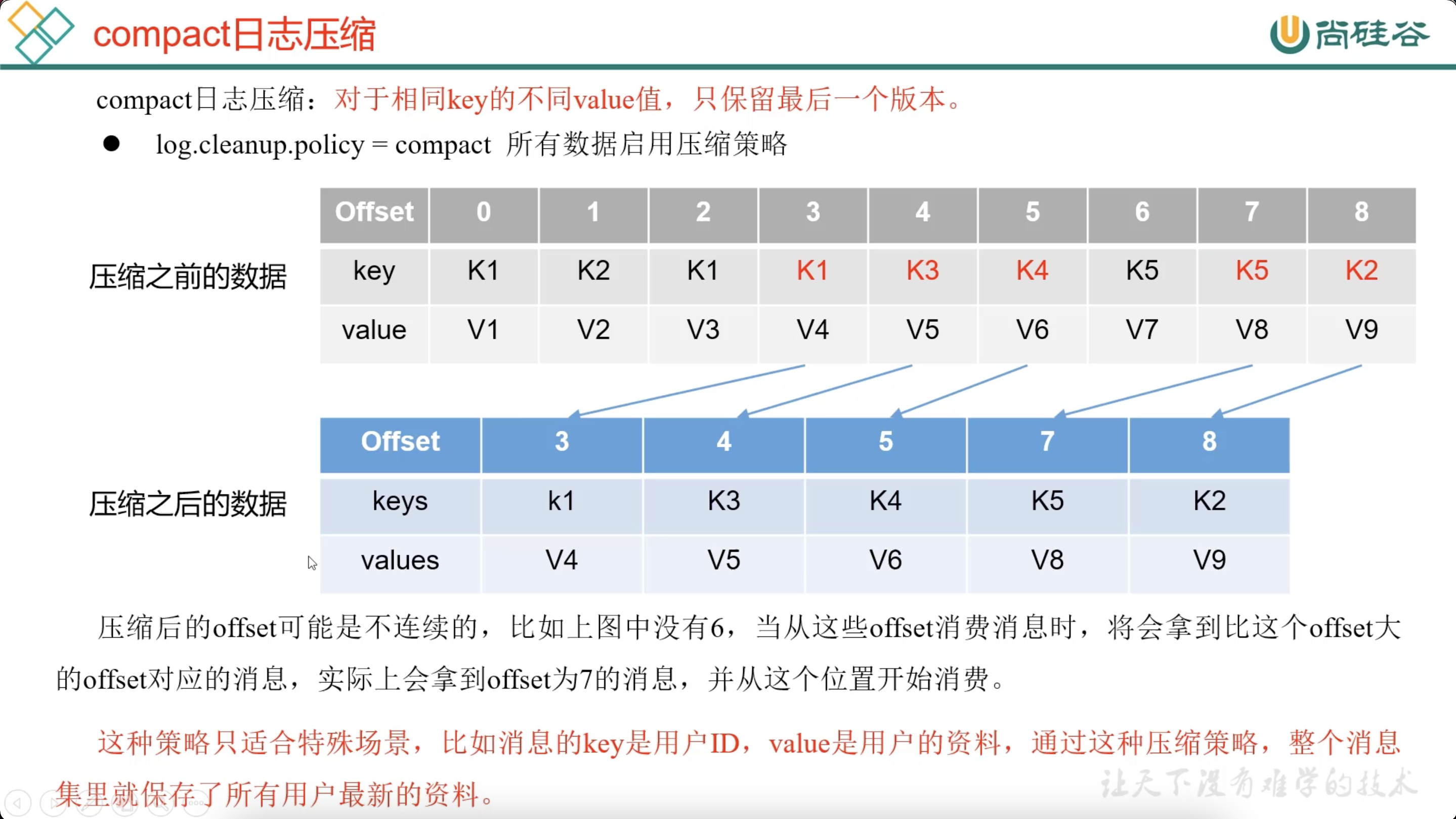

Kafka 中提供的日志清理策略有 delete 和 compact 两种。

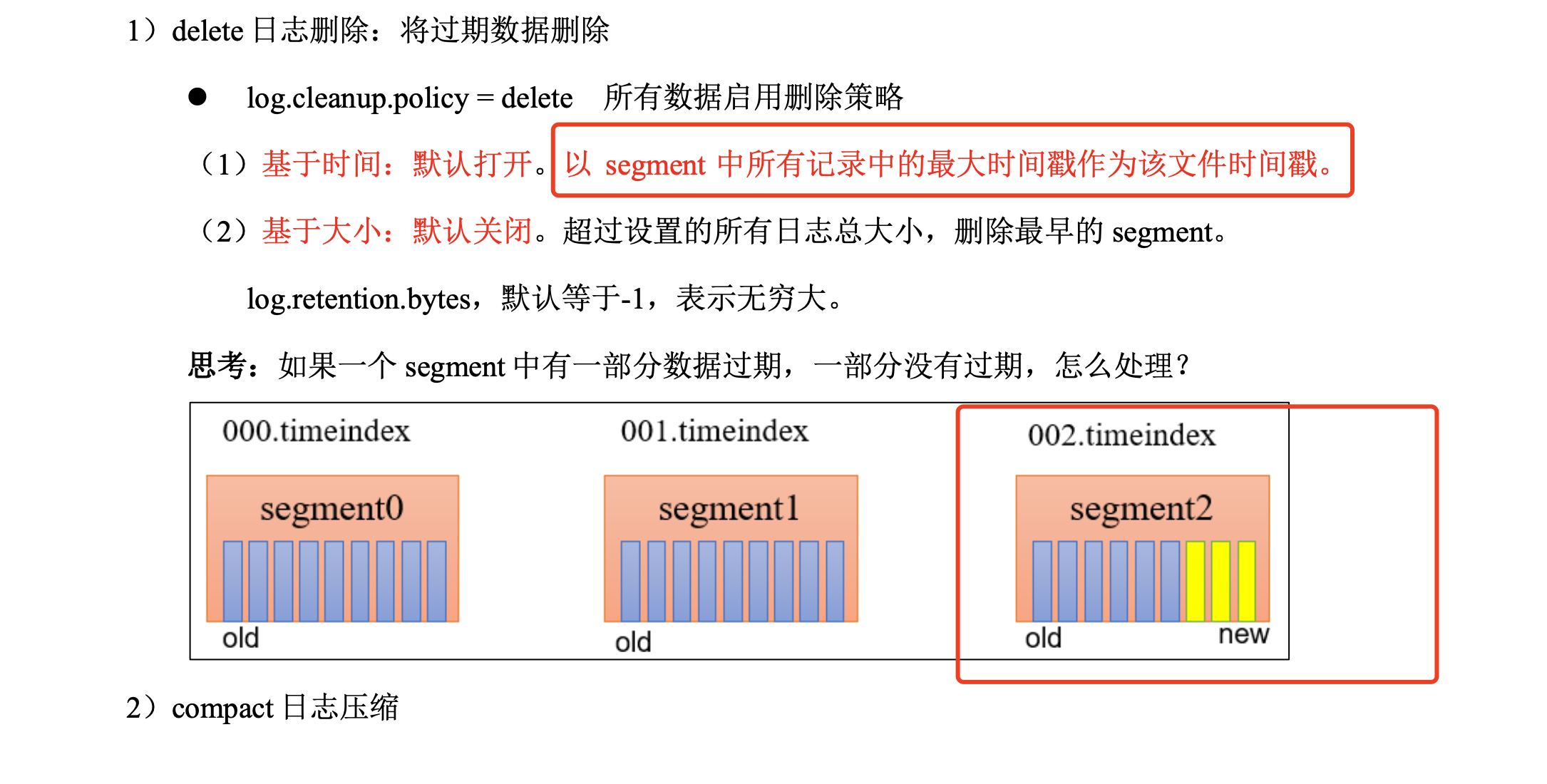

1)delete 日志删除:将过期数据删除

log.cleanup.policy = delete 所有数据启用删除策略

(1)基于时间:默认打开。以 segment 中所有记录中的最大时间戳作为该文件时间戳。 (2)基于大小:默认关闭。超过设置的所有日志总大小,删除最早的 segment。

log.retention.bytes,默认等于-1,表示无穷大。

这种策略只适合特殊场景,比如消息的key是用户ID,value是用户的资料,通过这种压缩策略,整个消息 集里就保存了所有用户最新的资料。

郭慕荣博客园

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?

2021-03-16 Minor GC ,Full GC 触发条件是什么?

2021-03-16 InnoDB中B+树总结

2021-03-16 查看JVM使用的默认的垃圾收集器