Dubbo之Cluster负载均衡

参考文献

负载均衡

-

当服务提供方是集群时,为了避免大量请求一直集中在一个或者几个服务提供方机器上,需要做负载均衡策略。Dubbo提供了多种均衡策略,默认为random,即每次随机调用一台服务提供者的服务

-

Dubbo 提供了4种负载均衡实现

- 基于权重随机算法的 RandomLoadBalance:按照概率设置权重,比较均匀,并且可以动态调节提供者的权重

- 基于最少活跃调用数算法的 LeastActiveLoadBalance:如果每个提供者的活跃数相同,则随机选择一个。在每个服务提供者里维护着一个活跃数计数器,用来记录当前同时处理请求的个数,也就是并发处理任务的个数。这个值越小,说明当前服务提供者处理的速度越快或者当前机器的负载比较低,所以路由选择时就选择该活跃度最底的机器。如果一个服务提供者处理速度很慢,由于堆积,那么同时处理的请求就比较多,也就是说活跃调用数目较大(活跃度较高),这时,处理速度慢的提供者将收到更少的请求。

- 基于一致性hash的 ConsistentHashLoadBalance:一致性Hash,可以保证相同参数的请求总是发到同一提供者,当某一台提供者机器宕机时,原本发往该提供者的请求,将基于虚拟节点平摊给其他提供者,这样就不会引起剧烈变动。

- 基于加权轮询算法的 RoundRobinLoadBalance:轮循,按公约后的权重设置轮循比率。会存在执行比较慢的服务提供者堆积请求的情况,比如一个机器执行得非常慢,但是机器没有宕机(如果宕机了,那么当前机器会从ZooKeeper的服务列表中删除),当很多新的请求到达该机器后,由于之前的请求还没处理完,会导致新的请求被堆积,久而久之,消费者调用这台机器上的所有请求都会被阻塞。

-

负载均衡配置

<dubbo:service interface="..." loadbalance="roundrobin" /> <dubbo:reference interface="..." loadbalance="roundrobin" /> <dubbo:service interface="..."> <dubbo:method name="..." loadbalance="roundrobin"/> </dubbo:service> <dubbo:reference interface="..."> <dubbo:method name="..." loadbalance="roundrobin"/> </dubbo:reference> -

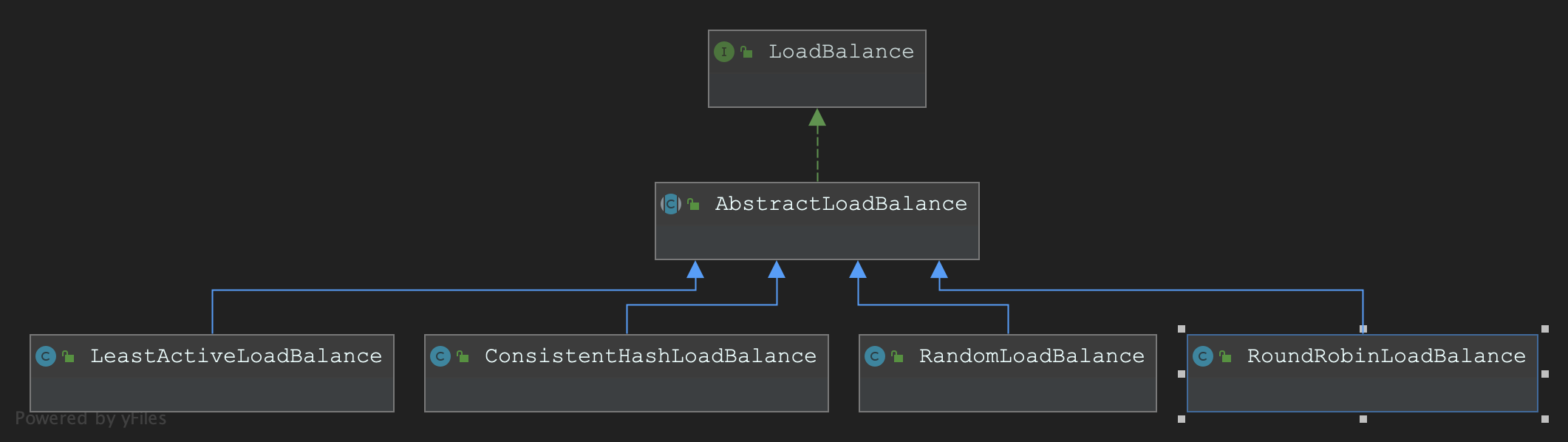

在 Dubbo 中,所有负载均衡实现类均继承自 AbstractLoadBalance,该类实现了 LoadBalance 接口,并封装了一些公共的逻辑

AbstractLoadBalance

-

AbstractLoadBalance是公共的抽象基类,核心方法AbstractLoadBalance#getWeight,获取权重方法- 获取

weight=xxx配置值,默认是100 - 获取服务提供者启动时间戳,计算服务提供者运行时长

- 获取服务预热时间,默认10 * 60 * 1000,即10分钟。

- 如果服务运行时间小于预热时间,则重新计算服务权重,即降权。预热的目的是避免服务在启动之初就处于高负载状态,是一种优化,让服务启动后"低功率"运行一段时间

protected int getWeight(Invoker<?> invoker, Invocation invocation) { // 从 url 中获取权重 weight(权重) 配置值,默认是100 int weight = invoker.getUrl().getMethodParameter(invocation.getMethodName(), Constants.WEIGHT_KEY, Constants.DEFAULT_WEIGHT); if (weight > 0) { // 获取服务提供者启动时间戳 long timestamp = invoker.getUrl().getParameter(Constants.REMOTE_TIMESTAMP_KEY, 0L); if (timestamp > 0L) { //计算服务提供者运行时长 int uptime = (int) (System.currentTimeMillis() - timestamp); // 获取服务预热时间,默认10 * 60 * 1000,即10分钟 int warmup = invoker.getUrl().getParameter(Constants.WARMUP_KEY, Constants.DEFAULT_WARMUP); //如果服务运行时间小于预热时间,则重新计算服务权重,即降权 //预热的目的是避免服务在启动之初就处于高负载状态,是一种优化,让服务启动后"低功率"运行一段时间 if (uptime > 0 && uptime < warmup) { weight = calculateWarmupWeight(uptime, warmup, weight); } } } return weight; } static int calculateWarmupWeight(int uptime, int warmup, int weight) { // 计算权重,下面代码等价于(uptime / warmup) * weight。 // 随着服务运行时间 uptime 增大,权重计算值 ww 会慢慢接近配置值 weight int ww = (int) ((float) uptime / ((float) warmup / (float) weight)); return ww < 1 ? 1 : (ww > weight ? weight : ww); } - 获取

RandomLoadBalance

-

RandomLoadBalance是加权随机算法的具体实现。假设有一组服务器

server={(A,5),(B,3),(C,2)},前面是服务器,后面是服务器对应的权重。把权重的值放在一维坐标轴上。则[0, 5)区间属于服务器 A,[5, 8)区间属于服务器 B,[8, 10)区间属于服务器 C -

通过随机数生成器生成一个范围在 [0, 10) 之间的随机数,然后计算这个随机数会落到哪个区间上。数字3会落到服务器 A 对应的区间上,此时返回服务器 A 即可。权重越大的机器,在坐标轴上对应的区间范围就越大,因此随机数生成器生成的数字就会有更大的概率落到此区间内

-

当调用次数比较少时,Random 产生的随机数可能会比较集中,此时多数请求会落到同一台服务器上。这个缺点并不是很严重,多数情况下可以忽略。

-

RandomLoadBalance 是一个简单,高效的负载均衡实现,因此 Dubbo 选择它作为缺省实现。

-

RandomLoadBalance#doSelect核心源码@Override protected <T> Invoker<T> doSelect(List<Invoker<T>> invokers, URL url, Invocation invocation) { //服务提供者的数量 int length = invokers.size(); // Number of invokers int totalWeight = 0; // The sum of weights //每一个invoker是否有相同的权重 boolean sameWeight = true; // Every invoker has the same weight? //第一是计算总权重 totalWeight, //第二是检测每个服务提供者的权重是否相同 for (int i = 0; i < length; i++) { int weight = getWeight(invokers.get(i), invocation); //累加权重 totalWeight += weight; // Sum //检测当前服务提供者的权重与上一个服务提供者的权重是否相同,不相同则设置sameWeight = false //此处直接新建一个previousWeight来保存上一个岂不是更好??避免重复计算 if (sameWeight && i > 0 && weight != getWeight(invokers.get(i - 1), invocation)) { sameWeight = false; } } //获取随机数,并计算随机数落在哪个区间上 if (totalWeight > 0 && !sameWeight) { // If (not every invoker has the same weight & at least one invoker's weight>0), select randomly based on totalWeight. // 随机获取一个 [0, totalWeight) 区间内的数字 int offset = random.nextInt(totalWeight); // Return a invoker based on the random value. // 循环让 offset 数减去服务提供者权重值,当 offset 小于0时,返回相应的 Invoker。 // 举例说明一下,我们有 servers = [A, B, C],weights = [5, 3, 2],offset = 7。 // 第一次循环,offset - 5 = 2 > 0,即 offset > 5, // 表明其不会落在服务器 A 对应的区间上。 // 第二次循环,offset - 3 = -1 < 0,即 5 < offset < 8, // 表明其会落在服务器 B 对应的区间上 for (int i = 0; i < length; i++) { // 让随机值 offset 减去权重值 offset -= getWeight(invokers.get(i), invocation); if (offset < 0) { return invokers.get(i); } } } // If all invokers have the same weight value or totalWeight=0, return evenly. // 如果所有服务提供者权重值相同,此时直接随机返回一个即可 return invokers.get(random.nextInt(length)); }

RoundRobinLoadBalance

- 轮询是指将请求轮流分配给每台服务器。举个例子,我们有三台服务器 A、B、C。我们将第一个请求分配给服务器 A,第二个请求分配给服务器 B,第三个请求分配给服务器 C,第四个请求再次分配给服务器 A。这个过程就叫做轮询。轮询是一种无状态负载均衡算法,实现简单,适用于每台服务器性能相近的场景下

- 但现实情况下,我们并不能保证每台服务器性能均相近。如果我们将等量的请求分配给性能较差的服务器,这显然是不合理的。因此,这个时候我们需要对轮询过程进行加权,以调控每台服务器的负载。经过加权后,每台服务器能够得到的请求数比例,接近或等于他们的权重比。比如服务器 A、B、C 权重比为 5:2:1。那么在8次请求中,服务器 A 将收到其中的5次请求,服务器 B 会收到其中的2次请求,服务器 C 则收到其中的1次请求。

LeastActiveLoadBalance

-

加权最小活跃负载均衡LeastActiveLoadBalance。活跃调用数越小,表明该服务提供者效率越高,单位时间内可处理更多的请求。此时应优先将请求分配给该服务提供者

-

每个服务提供者对应一个活跃数 active。初始情况下,所有服务提供者活跃数均为0。每收到一个请求,活跃数加1,完成请求后则将活跃数减1。在服务运行一段时间后,性能好的服务提供者处理请求的速度更快,因此活跃数下降的也越快,此时这样的服务提供者能够优先获取到新的服务请求、这就是最小活跃数负载均衡算法的基本思想。除了最小活跃数,LeastActiveLoadBalance 在实现上还引入了权重值

-

实现逻辑

- 遍历 invokers 列表,寻找活跃数最小的 Invoker

- 如果有多个 Invoker 具有相同的最小活跃数,此时记录下这些 Invoker 在 invokers 集合中的下标,并累加它们的权重,比较它们的权重值是否相等

- 如果只有一个 Invoker 具有最小的活跃数,此时直接返回该 Invoker 即可

- 如果有多个 Invoker 具有最小活跃数,且它们的权重不相等,此时处理方式和 RandomLoadBalance 一致

- 如果有多个 Invoker 具有最小活跃数,但它们的权重相等,此时随机返回一个即可

-

实现代码

@Override protected <T> Invoker<T> doSelect(List<Invoker<T>> invokers, URL url, Invocation invocation) { int length = invokers.size(); // Number of invokers //最小活跃数 int leastActive = -1; // The least active value of all invokers //具有相同"最小活跃数"的服务者提供者(以下用 Invoker 代称)数量 int leastCount = 0; // The number of invokers having the same least active value (leastActive) //leastIndexs 用于记录具有相同"最小活跃数"的 Invoker 在 invokers 列表中的下标信息 int[] leastIndexs = new int[length]; // The index of invokers having the same least active value (leastActive) //记录调用次数等于最小调用次数的服务提供者的权重和 int totalWeight = 0; // The sum of with warmup weights // 第一个最小活跃数的 Invoker 权重值,用于与其他具有相同最小活跃数的 Invoker 的权重进行对比, // 以检测是否“所有具有相同最小活跃数的 Invoker 的权重”均相等 int firstWeight = 0; // Initial value, used for comparision //所有的调用次数等于最小调用次数的服务提供者的权重是否一样 boolean sameWeight = true; // Every invoker has the same weight value? // 遍历 invokers 列表,过滤出所有的调用次数等于最小调用次数的服务提供者 for (int i = 0; i < length; i++) { Invoker<T> invoker = invokers.get(i); // 获取 Invoker 对应的活跃数 int active = RpcStatus.getStatus(invoker.getUrl(), invocation.getMethodName()).getActive(); // Active number int afterWarmup = getWeight(invoker, invocation); // Weight // 发现更小的活跃数,重新开始 if (leastActive == -1 || active < leastActive) { // Restart, when find a invoker having smaller least active value. // 使用当前活跃数 active 更新最小活跃数 leastActive leastActive = active; // Record the current least active value // 更新 leastCount 为 1 leastCount = 1; // Reset leastCount, count again based on current leastCount // 记录当前下标值到 leastIndexs 中 leastIndexs[0] = i; // Reset totalWeight = afterWarmup; // Reset firstWeight = afterWarmup; // Record the weight the first invoker sameWeight = true; // Reset, every invoker has the same weight value? } else if (active == leastActive) { // If current invoker's active value equals with leaseActive, then accumulating. // 当前 Invoker 的活跃数 active 与最小活跃数 leastActive 相同 leastIndexs[leastCount++] = i; // Record index number of this invoker // 累加权重 totalWeight += afterWarmup; // Add this invoker's weight to totalWeight. // If every invoker has the same weight? // 检测当前 Invoker 的权重与 firstWeight 是否相等, // 不相等则将 sameWeight 置为 false if (sameWeight && i > 0 && afterWarmup != firstWeight) { sameWeight = false; } } } // assert(leastCount > 0) // 当只有一个 Invoker 具有最小活跃数,此时直接返回该 Invoker 即可 if (leastCount == 1) { // If we got exactly one invoker having the least active value, return this invoker directly. return invokers.get(leastIndexs[0]); } // 有多个 Invoker 具有相同的最小活跃数,但它们之间的权重不同 if (!sameWeight && totalWeight > 0) { // 随机生成一个 [0, totalWeight) 之间的数字 // If (not every invoker has the same weight & at least one invoker's weight>0), select randomly based on totalWeight. int offsetWeight = random.nextInt(totalWeight) + 1; // Return a invoker based on the random value. // 循环让随机数减去具有最小活跃数的 Invoker 的权重值, // 当 offset 小于等于0时,返回相应的 Invoker for (int i = 0; i < leastCount; i++) { int leastIndex = leastIndexs[i]; // 获取权重值,并让随机数减去权重值 - ⭐️ offsetWeight -= getWeight(invokers.get(leastIndex), invocation); if (offsetWeight <= 0) return invokers.get(leastIndex); } } // If all invokers have the same weight value or totalWeight=0, return evenly. // 如果权重相同或权重为0时,随机返回一个 Invoker return invokers.get(leastIndexs[random.nextInt(leastCount)]); }

ConsistentHashLoadBalance

-

默认只对第一个参数hash,可以通过配置修改

<dubbo:parameter key="hash.arguments" value="0.1" /> -

默认使用160份虚拟节点,可以通过配置修改

<dubbo:parameter key="hash.nodes" value="320"> -

实现

ConsistentHashLoadBalance#doSelect@Override protected <T> Invoker<T> doSelect(List<Invoker<T>> invokers, URL url, Invocation invocation) { String methodName = RpcUtils.getMethodName(invocation); String key = invokers.get(0).getUrl().getServiceKey() + "." + methodName; // 获取 invokers 原始的 hashcode int identityHashCode = System.identityHashCode(invokers); ConsistentHashSelector<T> selector = (ConsistentHashSelector<T>) selectors.get(key); // 如果 invokers 是一个新的 List 对象,意味着服务提供者数量发生了变化,可能新增也可能减少了。 // 此时 selector.identityHashCode != identityHashCode 条件成立 if (selector == null || selector.identityHashCode != identityHashCode) { selectors.put(key, new ConsistentHashSelector<T>(invokers, methodName, identityHashCode)); selector = (ConsistentHashSelector<T>) selectors.get(key); } return selector.select(invocation); } -

ConsistentHashSelector

private static final class ConsistentHashSelector<T> { // 使用 TreeMap 存储 Invoker 虚拟节点 private final TreeMap<Long, Invoker<T>> virtualInvokers; private final int replicaNumber; private final int identityHashCode; private final int[] argumentIndex; ConsistentHashSelector(List<Invoker<T>> invokers, String methodName, int identityHashCode) { this.virtualInvokers = new TreeMap<Long, Invoker<T>>(); this.identityHashCode = identityHashCode; URL url = invokers.get(0).getUrl(); // 获取虚拟节点数,默认为160 this.replicaNumber = url.getMethodParameter(methodName, "hash.nodes", 160); // 获取参与 hash 计算的参数下标值,默认对第一个参数进行 hash 运算 String[] index = Constants.COMMA_SPLIT_PATTERN.split(url.getMethodParameter(methodName, "hash.arguments", "0")); argumentIndex = new int[index.length]; for (int i = 0; i < index.length; i++) { argumentIndex[i] = Integer.parseInt(index[i]); } for (Invoker<T> invoker : invokers) { String address = invoker.getUrl().getAddress(); for (int i = 0; i < replicaNumber / 4; i++) { // 对 address + i 进行 md5 运算,得到一个长度为16的字节数组 byte[] digest = md5(address + i); // 对 digest 部分字节进行4次 hash 运算,得到四个不同的 long 型正整数 for (int h = 0; h < 4; h++) { // h = 0 时,取 digest 中下标为 0 ~ 3 的4个字节进行位运算 // h = 1 时,取 digest 中下标为 4 ~ 7 的4个字节进行位运算 // h = 2, h = 3 时过程同上 long m = hash(digest, h); // 将 hash 到 invoker 的映射关系存储到 virtualInvokers 中, // virtualInvokers 需要提供高效的查询操作,因此选用 TreeMap 作为存储结构 virtualInvokers.put(m, invoker); } } } } public Invoker<T> select(Invocation invocation) { // 将参数转为 key String key = toKey(invocation.getArguments()); // 对参数 key 进行 md5 运算 byte[] digest = md5(key); // 取 digest 数组的前四个字节进行 hash 运算,再将 hash 值传给 selectForKey 方法, // 寻找合适的 Invoker return selectForKey(hash(digest, 0)); } private String toKey(Object[] args) { StringBuilder buf = new StringBuilder(); for (int i : argumentIndex) { if (i >= 0 && i < args.length) { buf.append(args[i]); } } return buf.toString(); } private Invoker<T> selectForKey(long hash) { // 到 TreeMap 中查找第一个节点值大于或等于当前 hash 的 Invoker Map.Entry<Long, Invoker<T>> entry = virtualInvokers.tailMap(hash, true).firstEntry(); // 如果 hash 大于 Invoker 在圆环上最大的位置,此时 entry = null, // 需要将 TreeMap 的头节点赋值给 entry if (entry == null) { entry = virtualInvokers.firstEntry(); } // 返回 Invoker return entry.getValue(); } ...省略... }

自定义负载均衡

-

实现

LoadBalance接口public class MyLoadBalance implements LoadBalance { @Override public <T> Invoker<T> select(List<Invoker<T>> invokers, URL url, Invocation invocation) throws RpcException { return invokers.get(0); } } -

创建

/src/main/resources/META-INF/dubbo/com.alibaba.dubbo.rpc.cluster.LoadBalance文件myLoadBalance=com.alibaba.dubbo.spi.MyLoadBalance -

配置

<dubbo:reference id="demoService" check="false" interface="com.alibaba.dubbo.demo.DemoService"loadbalance="myLoadBalance"/>