053.Kubernetes集群管理-Helm部署及使用

一 Helm概述

1.1 Helm介绍

Helm 是 Kubernetes 的软件包管理工具。包管理器类似 Ubuntu 中使用的apt、Centos中使用的yum 或者Python中的 pip 一样,能快速查找、下载和安装软件包。通常每个包称为一个Chart,一个Chart是一个目录(一般情况下会将目录进行打包压缩,形成name-version.tgz格式的单一文件,方便传输和存储)。

Helm 由客户端组件 helm 和服务端组件 Tiller 组成, 能够将一组K8S资源打包统一管理, 是查找、共享和使用为Kubernetes构建的软件的最佳方式。

1.2 Helm优势

在 Kubernetes中部署一个可以使用的应用,需要涉及到很多的 Kubernetes 资源的共同协作。如安装一个 WordPress 博客,用到了一些 Kubernetes 的一些资源对象。包括 Deployment 用于部署应用、Service 提供服务发现、Secret 配置 WordPress 的用户名和密码,可能还需要 pv 和 pvc 来提供持久化服务。并且 WordPress 数据是存储在mariadb里面的,所以需要 mariadb 启动就绪后才能启动 WordPress。这些 k8s 资源过于分散,不方便进行管理。

基于如上场景,在 k8s 中部署一个应用,通常面临以下几个问题:

- 如何统一管理、配置和更新这些分散的 k8s 的应用资源文件;

- 如何分发和复用一套应用模板;

- 如何将应用的一系列资源当做一个软件包管理。

对于应用发布者而言,可以通过 Helm 打包应用、管理应用依赖关系、管理应用版本并发布应用到软件仓库。

对于使用者而言,使用 Helm 后不用需要编写复杂的应用部署文件,可以以简单的方式在 Kubernetes 上查找、安装、升级、回滚、卸载应用程序。

1.3 Helm 相关组件及概念

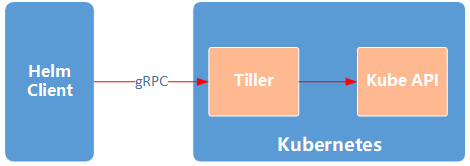

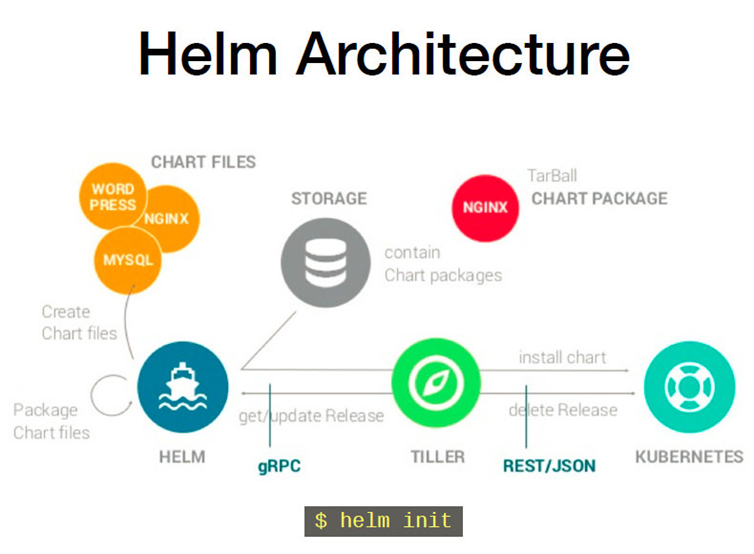

Helm 包含两个组件,分别是 helm 客户端 和 Tiller 服务器:

- helm:是一个命令行工具,主要用于 Kubernetes 应用程序 Chart 的创建、打包、发布以及创建和管理本地和远程的 Chart 仓库。

- Tiller:是 Helm 的服务端,部署在 Kubernetes 集群中。Tiller 负责接收 Helm 的请求,并根据 Chart 生成 Kubernetes 的部署文件( 称为 Release ),然后提交给 Kubernetes 创建应用。(v3版本已移除)

- chart:Helm 的打包格式叫做 chart,所谓 chart 就是一系列文件, 它描述了一组相关的 k8s 集群资源,即包含了一组定义 Kubernetes 资源相关的 YAML 文件。

- release:使用 helm install 命令在 Kubernetes 集群中部署的 Chart 称为 Release。

- Repoistory:Helm chart 的仓库,Repository 本质上是一个 Web 服务器,该服务器保存了一系列的 Chart 软件包以供用户下载,并且提供了一个该 Repository 的 Chart 包的清单文件以供查询。Helm 可以同时管理多个不同的 Repository。

注意:Helm 中提到的 Release 与通常概念中的版本有所不同,Helm 的 Release 可以理解为 Helm 使用 Chart 包部署的一个应用实例。

二 Helm原理机制

2.1 Helm原理

如下图所示描述了Helm 的主要组件 Helm(客户端)、Tiller(服务器)、Repository(Chart 软件仓库)、Chart(软件包)之间的关系以及它们之间如何通信。

Helm架构:

2.2 Helm主要过程

创建release过程:

- helm 客户端从指定的目录或本地tar文件或远程repo仓库解析出chart的结构信息;

- helm 客户端指定的 chart 结构和 values 信息通过 gRPC 传递给 Tiller;

- Tiller 服务端根据 chart 和 values 生成一个 release;

- Tiller 将install release请求直接传递给 kube-apiserver。

删除release:

- helm 客户端从指定的目录或本地tar文件或远程repo仓库解析出chart的结构信息;

- helm 客户端指定的 chart 结构和 values 信息通过 gRPC 传递给 Tiller;

- Tiller 服务端根据 chart 和 values 生成一个 release;

- Tiller 将delete release请求直接传递给 kube-apiserver。

更新release

- helm 客户端将需要更新的 chart 的 release 名称、chart 结构和 value 信息传给 Tiller;

- Tiller 将收到的信息生成新的 release,并同时更新这个 release 的 history;

- Tiller 将新的 release 传递给 kube-apiserver 进行更新。

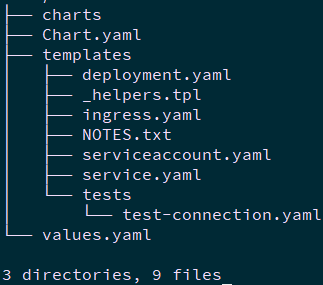

2.3 chart基本结构

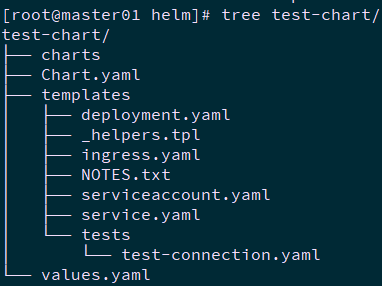

Helm的打包格式叫做chart,所谓chart就是一系列文件, 它描述了一组相关的 k8s 集群资源。Chart中的文件安装特定的目录结构组织, 最简单的chart 目录如下所示:

目录释义:

- charts:该目录存放依赖的chart;

- Chart.yaml:包含Chart的基本信息,包括chart版本,名称等;

- templates:该目录下存放应用,即一系列 k8s 资源的 yaml 模板;

- _helpers.tpl:此文件中定义一些可重用的模板片断,此文件中的定义在任何资源定义模板中可用;

- NOTES.txt:介绍chart 部署后的帮助信息,如何使用chart等;

- values.yaml:包含了必要的值定义(默认值), 用于存储 templates 目录中模板文件中用到变量的值。

参考链接:https://www.jianshu.com/p/4bd853a8068b。

附:helm v3说明:

Helm 2 是 C/S 架构,主要分为客户端 helm 和服务端 Tiller; 与v2版本不同,v3移除了Tiller,只有 helm。

Tiller 主要用于在 Kubernetes 集群中管理各种应用发布的版本,在 Helm 3 中移除了 Tiller, 版本相关的数据直接存储在了 Kubernetes 中。

1:移除Tiller,针对v3版本移除Tiller的说明,可参考:https://blog.csdn.net/zzh_gaoxingjiuhao/article/details/104182596。

2:移除Tiller的优势可参考:https://www.sohu.com/a/364182362_609513。

Helm v3新特性参考:https://www.jianshu.com/p/dfb8e2a42db0、https://github.com/helm/helm/releases/tag/v3.0.0-alpha.1。

三 Helm部署安装

3.1 前置准备

Helm 将使用 kubectl 在已配置的集群上部署 Kubernetes 资源,因此需要如下前置准备:

- 正在运行的 Kubernetes 集群;

- 本地 Docker 客户端;

- 预配置的 kubectl 客户端和 Kubernetes 集群正确交互。

3.2 安装Helm

- 二进制安装

1 [root@master01 ~]# wget https://get.helm.sh/helm-v3.1.2-linux-amd64.tar.gz 2 [root@master01 ~]# tar -zxvf helm-v3.1.2-linux-amd64.tar.gz 3 [root@master01 ~]# cp linux-amd64/helm /usr/local/bin/

- 脚本安装

1 [root@master01 ~]# curl -fsSL -o get_helm.sh https://raw.githubusercontent.com/helm/helm/master/scripts/get-helm-3 2 [root@master01 ~]# chmod 700 get_helm.sh 3 [root@master01 ~]# ./get_helm.sh

提示:更多安装方式参考官方手册:https://helm.sh/docs/intro/install/。

1 [root@master01 ~]# helm version #查看安装版本 2 [root@master01 ~]# echo 'source <(helm completion bash)' >> .bashrc #helm自动补全

四 Helm操作

4.1 查找chart

helm search:可以用于搜索两种不同类型的源。

helm search hub:搜索 Helm Hub,该源包含来自许多不同仓库的Helm chart。

helm search repo:搜索已添加到本地头helm客户端(带有helm repo add)的仓库,该搜索是通过本地数据完成的,不需要连接公网。

1 [root@master01 helm]# helm search hub #可搜索全部可用chart 2 [root@master01 helm]# helm search hub wordpress

4.2 添加repo

1 [root@master01 helm]# helm repo list #查看repo 2 [root@master01 helm]# helm repo add brigade https://brigadecore.github.io/charts 3 [root@master01 helm]# helm repo add stable https://kubernetes-charts.storage.googleapis.com/ #添加官方repo 4 [root@master01 helm]# helm repo add bitnami https://charts.bitnami.com/bitnami 5 6 [root@master01 helm]# helm search repo brigade 7 [root@master01 helm]# helm search repo stable #搜索repo中的chart 8 [root@master01 helm]# helm repo update #更新repo的chart 9 [root@master01 helm]# helm repo remove stable #移除repo

4.3 安装软件包

1 [root@master01 helm]# helm search repo mariadb #查找确认存在 2 [root@master01 helm]# helm show chart bitnami/mariadb #可提前查看相关信息 3 [root@master01 helm]# helm install xhy_mariadb bitnami/mariadb #以repo中chart安装 4 [root@master01 helm]# helm install xhy_mariadb2 bitnami.mariadb.tgz #以压缩包中chart安装 5 [root@master01 helm]# helm install xhy_mariadb3 mariadb/ #以解压后的目录安装 6 [root@master01 helm]# helm install xhy_mariadb4 https://hub.helm.sh/charts/bitnami/mariadb.tgz #以远程路径安装 7 [root@master01 helm]# helm ls #查看已安装的release

提示:在 Helm 3 中,必须主动指定release名称,或者增加 --generate-name 的参数使Helm自动生成。

在安装期间,helm客户端将显示有关创建了哪些资源,发布状态是什么以及是否可以或应该执行其他配置步骤的有用信息。

注意:由于许多chart需要较大的镜像,需要一定时间才能正确部署至集群,Helm不会等到所有资源都在运行后才退出。

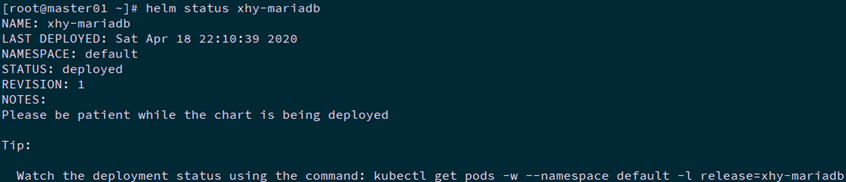

4.4 状态查看

1 [root@master01 ~]# helm status xhy-mariadb

4.5 升级回滚

当发布新版本的chart时,或者需要更改发布的配置时,可以使用该helm upgrade命令。

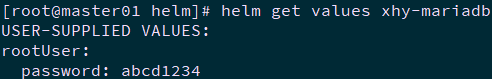

1 [root@master01 helm]# vi mariadb.yml #以新配置重发布 2 rootUser: 3 password: abcd1234 4 [root@master01 helm]# helm upgrade -f mariadb.yml xhy-mariadb bitnami/mariadb #升级 5 [root@master01 helm]# helm get values xhy-mariadb #查看新配置

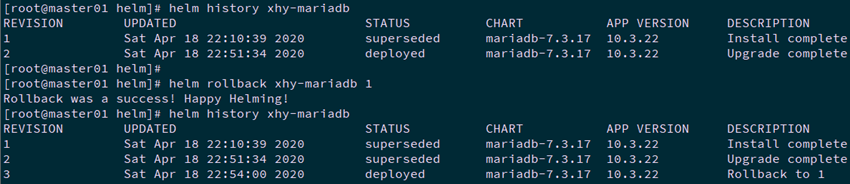

1 [root@master01 helm]# helm history xhy-mariadb #查看安装历史 2 [root@master01 helm]# helm rollback xhy-mariadb 1 #回滚

提示:升级将采用现有发行版,并根据所提供的信息对其进行升级。由于Kubernetes chart可能很大且很复杂,因此Helm尝试执行侵入性最小的升级。它将仅更新自上一发行版以来已更改的内容。

4.6 卸载release

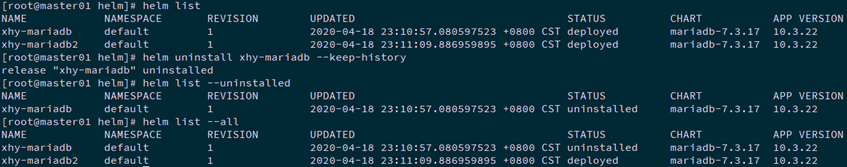

1 [root@master01 helm]# helm uninstall xhy-mariadb #卸载release 2 [root@master01 helm]# helm list

提示:在Helm 3中,删除release也会删除发布记录。如果希望保留删除发布记录,可使用helm uninstall --keep-history。使用helm list --uninstalled将仅显示带有--keep-history标志卸载的发行版。

提示:helm list --all标志可查询Helm保留的所有发布记录,包括失败或已删除项目的记录(如果--keep-history已指定)。

4.7 其他常见选项

--timeout:等待Kubernetes命令完成的秒数,默认5m0s。

--wait:等待,直到所有Pod都处于就绪状态、PVC处于绑定、deployment的Pods最少可用数处于ready状态,并且Services具有IP地址(如果安装的为Ingress LoadBalancer),然后才将发布标记为成功。它将一直等待至--timeout设置的值。如果达到超时,该release将标记为FAILED。

注意:在作为滚动更新策略一部分的Deployment replicas设置为1,maxUnavailable且未设置为0的情况下,--wait只要满足最小Pod就绪状态,它将返回就绪状态。

--no-hooks:跳过命令行的运行钩子。

--dry-run:模拟安装。

-n, --namespace:指定需要部署的命名空间。

提示:hele完整命令选项可执行helm <command> --help查看。

五 Helm自定义安装

5.1 查看chart默认value

如上4.3所示方法进行安装将仅使用此chart的默认配置选项。通常,需要自定义图表以使用首选配置。

1 [root@master01 ~]# helm show values bitnami/mariadb #查看此chart可自定义配置项 2 …… 3 rootUser: 4 ## MariaDB admin password 5 ## ref: https://github.com/bitnami/bitnami-docker-mariadb#setting-the-root-password-on-first-run 6 ## 7 password: "" 8 ……

5.2 传递配置方式

有两种在安装过程中传递配置数据的方式:

--values(或-f):指定带有替代参数及值的YAML文件。可以多次指定,最后一个文件优先级最高。

--set:在命令行上指定替代。

提示:如果同时使用--set和-f,则将-f优先级更高。

5.3 配置文件定义配置项

1 [root@master01 helm]# vi mariadb.yml #创建自定义配置 2 rootUser: 3 password: abcd1234 4

提示:如上设置数据库密码,而不使用默认的随机密码。

5.4 命令行定义配置项

1 [root@master01 helm]# helm install --set rootUser.password=abcd1234 xhy_mariadb bitnami/mariadb

提示:更多命令与yaml对应如下:

六 创建chart

6.1 创建chart命令

1 [root@master01 helm]# helm create test-chart

提示:create会创建一个标准的chart目录结构,可以编辑相应配置从而创建自己的chart。更多的chart开发指南参考:https://helm.sh/docs/topics/charts/。

有关chart的字段及编写可参考:https://www.kubernetes.org.cn/3884.html。

1 [root@master01 helm]# helm lint test-chart/ #验证创建后是否正常 2 [root@master01 helm]# helm package test-chart #将创建的进行打包 3 [root@master01 helm]# helm install test-chart/ ./test-chart/-0.1.0.tgz #安装 4

七 Monocular

7.1 Monocular介绍

Monocular是一个开源软件,基于web UI图形界面管理kubernetes上以Helm Charts形式创建的服务

7.2 Monocular安装

1 [root@master01 ~]# helm repo add monocular https://helm.github.io/monocular #添加repo 2 [root@master01 ~]# kubectl create ns helm 3 [root@master01 ~]# cat > custom-repos.yaml <<EOF 4 sync: 5 repos: 6 - name: stable 7 url: https://kubernetes-charts.storage.googleapis.com 8 schedule: "0 * * * *" 9 successfulJobsHistoryLimit: 1 10 - name: incubator 11 url: https://kubernetes-charts-incubator.storage.googleapis.com 12 schedule: "*/5 * * * *" 13 - name: monocular 14 url: https://helm.github.io/monocular 15 ui: 16 replicaCount: 2 17 service: 18 name: monocular-ui 19 type: NodePort 20 externalPort: 80 21 internalPort: 8080 22 annotations: {} 23 # foo.io/bar: "true" 24 ingress: 25 hosts: 26 - monocular.odocker.com 27 EOF #添加自定义配置:配置默认添加的repo及ingress host 28 [root@master01 ~]# helm install mymonocular monocular/monocular -f custom-repos.yaml -n helm 29

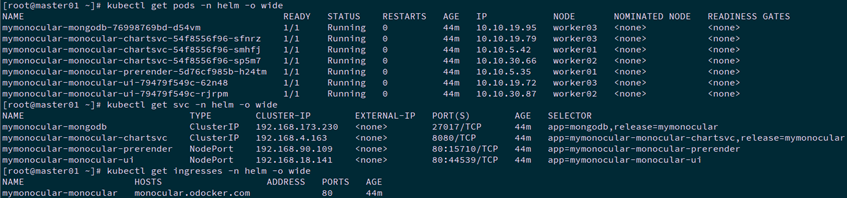

7.3 确认安装

1 [root@master01 ~]# kubectl get pods -n helm -o wide 2 [root@master01 ~]# kubectl get svc -n helm -o wide 3 [root@master01 ~]# kubectl get ingresses -n helm -o wide 4

参考:https://github.com/helm/monocular

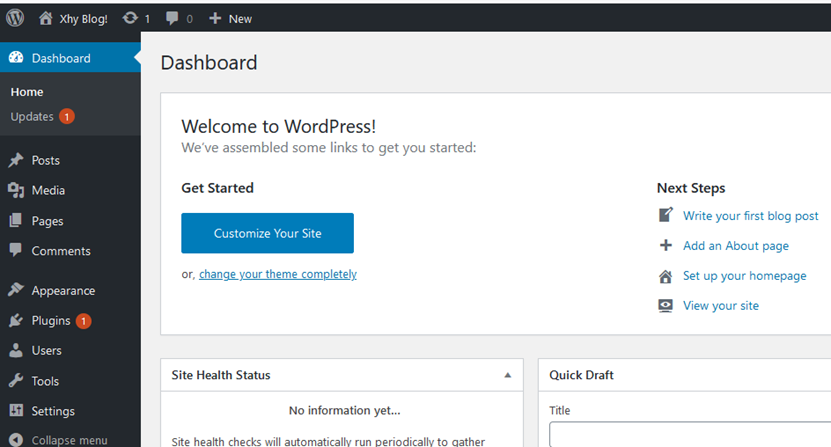

八 helm部署WordPress

8.1 查看chart包

1 [root@master01 ~]# helm repo add bitnami https://charts.bitnami.com/bitnami 2 [root@master01 ~]# helm search repo wordpress 3 NAME CHART VERSION APP VERSION DESCRIPTION 4 bitnami/wordpress 9.2.4 5.4.1 Web publishing platform for building blogs and ... 5

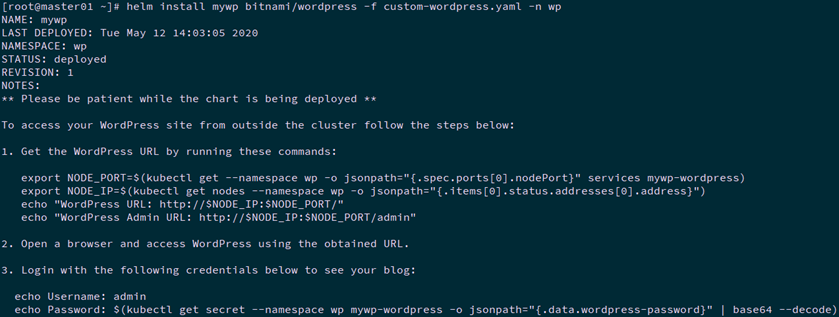

8.2 安装WordPress

1 [root@master01 ~]# kubectl create ns wp 2 [root@master01 ~]# vi custom-wordpress.yaml 3 wordpressUsername: admin 4 wordpressPassword: admin12345 5 wordpressBlogName: Xhy Blog! 6 persistence: 7 enabled: true 8 storageClass: "ghsc" 9 accessMode: ReadWriteOnce 10 size: 5Gi 11 12 13 mariadb: 14 db: 15 name: wpdb 16 user: wpuser 17 password: wppass12345 18 rootUser: wpadmin 19 password: wpadminpass12345 20 21 22 master: 23 persistence: 24 enabled: true 25 storageClass: "ghsc" 26 accessModes: 27 - ReadWriteOnce 28 size: 5Gi 29 30 31 service: 32 type: NodePort 33 nodePorts: 34 http: "30005" 35 https: "30006" 36

提示:

默认参考配置参考:https://github.com/bitnami/charts/blob/master/bitnami/wordpress/values.yaml

更多参数设置参考:https://github.com/bitnami/charts/tree/master/bitnami/wordpress

1 [root@master01 ~]# helm install mywp bitnami/wordpress -f custom-wordpress.yaml -n wp

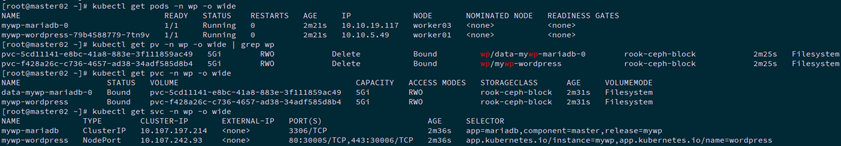

8.3 确认安装

1 [root@master02 ~]# kubectl get pods -n wp -o wide 2 [root@master02 ~]# kubectl get pv -n wp -o wide | grep wp 3 [root@master02 ~]# kubectl get pvc -n wp -o wide 4 [root@master02 ~]# kubectl get svc -n wp -o wide

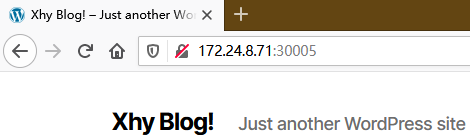

8.4 访问测试

1 [root@master01 ~]# kubectl get --namespace wp -o jsonpath="{.spec.ports[0].nodePort}" services mywp-wordpress #查看端口 2 30005 3 [root@master01 ~]# kubectl get nodes --namespace wp -o jsonpath="{.items[0].status.addresses[0].address}" #查看node ip 4 172.24.8.71

浏览器访问:http://172.24.8.71:30005或者https://172.24.8.71:30006/

浏览器访问:http://172.24.8.71:30005/admin,进入管理界面。

参考文档:

https://www.hi-linux.com/posts/21466.html

https://helm.sh/docs/intro/using_helm/

作者:木二

出处:http://www.cnblogs.com/itzgr/

关于作者:云计算、虚拟化,Linux,多多交流!

本文版权归作者所有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接!如有其他问题,可邮件(xhy@itzgr.com)咨询。

浙公网安备 33010602011771号

浙公网安备 33010602011771号