014.Kubernetes二进制所有节点部署kube-proxy

一 部署 kube-proxy

kube-proxy 运行在所有节点上,它监听 apiserver 中 service 和 endpoint 的变化情况,创建路由规则以提供服务 IP 和负载均衡功能。

1.1 安装kube-proxy

提示:master01 节点已下载相应二进制,可直接分发至worker节点。

1.2 分发kube-proxy

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 4 do 5 echo ">>> ${all_ip}" 6 scp kubernetes/server/bin/kube-proxy root@${all_ip}:/opt/k8s/bin/ 7 ssh root@${all_ip} "chmod +x /opt/k8s/bin/*" 8 done

提示:本步骤操作仅需要在master01节点操作。

1.3 创建kube-scheduler证书和私钥

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# cat > kube-proxy-csr.json <<EOF 4 { 5 "CN": "system:kube-proxy", 6 "key": { 7 "algo": "rsa", 8 "size": 2048 9 }, 10 "names": [ 11 { 12 "C": "CN", 13 "ST": "Shanghai", 14 "L": "Shanghai", 15 "O": "k8s", 16 "OU": "System" 17 } 18 ] 19 } 20 EOF #创建kube-scheduler的CA证书请求文件

提示:本步骤操作仅需要在master01节点操作。

解释:

- CN:指定该证书的 User 为 system:kube-proxy;

- 预定义的 RoleBinding system:node-proxier 将User system:kube-proxy 与 Role system:node-proxier 绑定,该 Role 授予了调用 kube-apiserver Proxy 相关 API 的权限;

- 该证书只会被 kube-proxy 当做 client 证书使用,所以 hosts 字段为空。

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# cfssl gencert -ca=/opt/k8s/work/ca.pem \ 3 -ca-key=/opt/k8s/work/ca-key.pem -config=/opt/k8s/work/ca-config.json \ 4 -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy #生成密钥和证书

提示:本步骤操作仅需要在master01节点操作。

1.4 创建和分发kubeconfig

kube-proxy 使用 kubeconfig 文件访问 apiserver,该文件提供了 apiserver 地址、嵌入的 CA 证书和 kube-proxy 证书:

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# kubectl config set-cluster kubernetes \ 4 --certificate-authority=/opt/k8s/work/ca.pem \ 5 --embed-certs=true \ 6 --server=${KUBE_APISERVER} \ 7 --kubeconfig=kube-proxy.kubeconfig 8 9 [root@master01 work]# kubectl config set-credentials kube-proxy \ 10 --client-certificate=kube-proxy.pem \ 11 --client-key=kube-proxy-key.pem \ 12 --embed-certs=true \ 13 --kubeconfig=kube-proxy.kubeconfig 14 15 [root@master01 work]# kubectl config set-context default \ 16 --cluster=kubernetes \ 17 --user=kube-proxy \ 18 --kubeconfig=kube-proxy.kubeconfig 19 20 [root@master01 work]# kubectl config use-context default --kubeconfig=kube-proxy.kubeconfig 21 22 [root@master01 ~]# cd /opt/k8s/work 23 [root@master01 work]# source /root/environment.sh 24 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 25 do 26 echo ">>> ${all_ip}" 27 scp kube-proxy.kubeconfig root@${all_ip}:/etc/kubernetes/ 28 done

提示:本步骤操作仅需要在master01节点操作。

1.5 创建kube-proxy 配置文件

从 v1.10 开始,kube-proxy 部分参数可以配置文件中配置。可以使用 --write-config-to 选项生成该配置文件。

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# cat > kube-proxy-config.yaml.template <<EOF 4 kind: KubeProxyConfiguration 5 apiVersion: kubeproxy.config.k8s.io/v1alpha1 6 clientConnection: 7 burst: 200 8 kubeconfig: "/etc/kubernetes/kube-proxy.kubeconfig" 9 qps: 100 10 bindAddress: ##ALL_IP## 11 healthzBindAddress: ##ALL_IP##:10256 12 metricsBindAddress: ##ALL_IP##:10249 13 enableProfiling: true 14 clusterCIDR: ${CLUSTER_CIDR} 15 hostnameOverride: ##ALL_NAME## 16 mode: "ipvs" 17 portRange: "" 18 kubeProxyIPTablesConfiguration: 19 masqueradeAll: false 20 kubeProxyIPVSConfiguration: 21 scheduler: rr 22 excludeCIDRs: [] 23 EOF

提示:本步骤操作仅需要在master01节点操作。

解释:

- bindAddress: 监听地址;

- clientConnection.kubeconfig: 连接 apiserver 的 kubeconfig 文件;

- clusterCIDR: kube-proxy 根据 --cluster-cidr 判断集群内部和外部流量,指定 --cluster-cidr 或 --masquerade-all 选项后 kube-proxy 才会对访问 Service IP 的请求做 SNAT;

- hostnameOverride: 参数值必须与 kubelet 的值一致,否则 kube-proxy 启动后会找不到该 Node,从而不会创建任何 ipvs 规则;

- mode: 使用 ipvs 模式。

1.6 分发配置文件

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for (( i=0; i < 6; i++ )) 4 do 5 echo ">>> ${ALL_NAMES[i]}" 6 sed -e "s/##ALL_NAME##/${ALL_NAMES[i]}/" -e "s/##ALL_IP##/${ALL_IPS[i]}/" kube-proxy-config.yaml.template > kube-proxy-config-${ALL_NAMES[i]}.yaml.template 7 scp kube-proxy-config-${ALL_NAMES[i]}.yaml.template root@${ALL_NAMES[i]}:/etc/kubernetes/kube-proxy-config.yaml 8 done

提示:本步骤操作仅需要在master01节点操作。

1.7 创建kube-proxy的systemd

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# cat > kube-proxy.service <<EOF 4 [Unit] 5 Description=Kubernetes Kube-Proxy Server 6 Documentation=https://github.com/GoogleCloudPlatform/kubernetes 7 After=network.target 8 9 [Service] 10 WorkingDirectory=${K8S_DIR}/kube-proxy 11 ExecStart=/opt/k8s/bin/kube-proxy \\ 12 --config=/etc/kubernetes/kube-proxy-config.yaml \\ 13 --logtostderr=true \\ 14 --v=2 15 Restart=on-failure 16 RestartSec=5 17 LimitNOFILE=65536 18 19 [Install] 20 WantedBy=multi-user.target 21 EOF

提示:本步骤操作仅需要在master01节点操作。

1.8 分发kube-proxy systemd

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_name in ${ALL_NAMES[@]} 4 do 5 echo ">>> ${all_name}" 6 scp kube-proxy.service root@${all_name}:/etc/systemd/system/ 7 done #分发system

提示:本步骤操作仅需要在master01节点操作。

二 启动并验证

2.1 启动kube-proxy 服务

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 4 do 5 echo ">>> ${all_ip}" 6 ssh root@${all_ip} "mkdir -p ${K8S_DIR}/kube-proxy" 7 ssh root@${all_ip} "modprobe ip_vs_rr" 8 ssh root@${all_ip} "systemctl daemon-reload && systemctl enable kube-proxy && systemctl restart kube-proxy" 9 done #启动服务前必须先创建工作目录

提示:本步骤操作仅需要在master01节点操作。

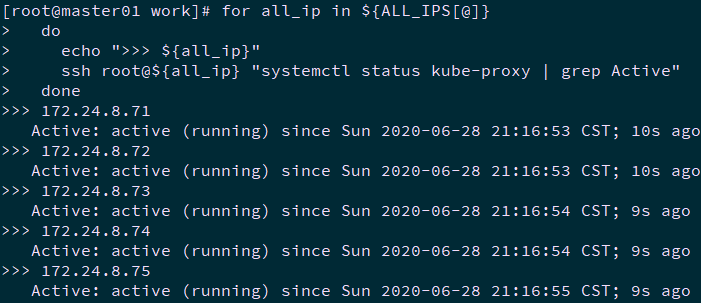

2.2 检查kube-proxy 服务

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 4 do 5 echo ">>> ${all_ip}" 6 ssh root@${all_ip} "systemctl status kube-proxy | grep Active" 7 done

提示:本步骤操作仅需要在master01节点操作。

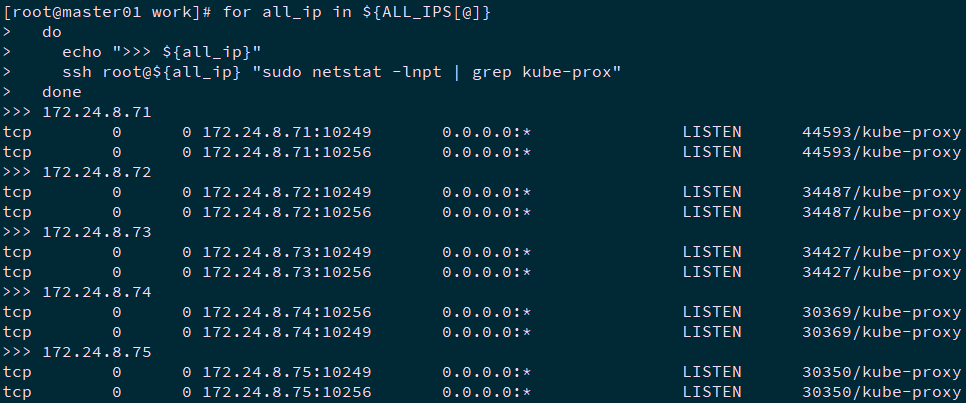

2.3 查看监听端口

kube-proxy 监听 10249 和 10256 端口:

- 10249:对外提供 /metrics;

- 10256:对外提供 /healthz 的访问。

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 4 do 5 echo ">>> ${all_ip}" 6 ssh root@${all_ip} "sudo netstat -lnpt | grep kube-prox" 7 done

提示:本步骤操作仅需要在master01节点操作。

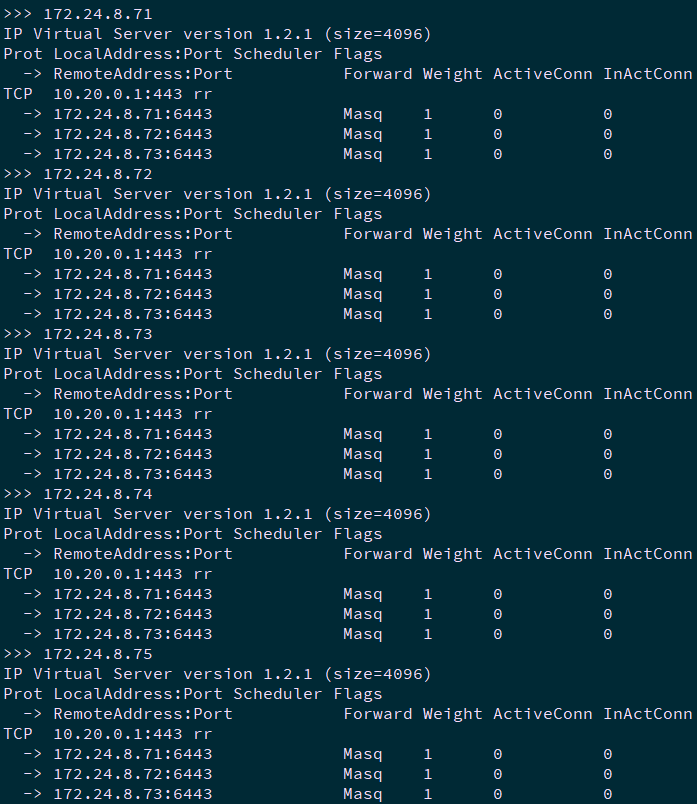

2.4 查看ipvs 路由规则

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# for all_ip in ${ALL_IPS[@]} 4 do 5 echo ">>> ${all_ip}" 6 ssh root@${all_ip} "/usr/sbin/ipvsadm -ln" 7 done

提示:本步骤操作仅需要在master01节点操作。

可见所有通过 https 访问 K8S SVC kubernetes 的请求都转发到 kube-apiserver 节点的 6443 端口。

三 故障解决

3.1 iptables问题

若出现如下报错:

1 kube-proxy Not using `--random-fully` in the MASQUERADE rule for iptables because the local version of iptables does not support it

表示当前iptables版本并不支持--random-fully,至少要在1.6.2版本才能支持,可通过编译升级iptables。

3.2 编译iptables

1 [root@master01 ~]# cd /opt/k8s/work 2 [root@master01 work]# source /root/environment.sh 3 [root@master01 work]# wget https://www.netfilter.org/projects/iptables/files/iptables-1.6.2.tar.bz2 4 [root@master01 work]# for all_name in ${ALL_NAMES[@]} 5 do 6 echo ">>> ${all_name}" 7 scp iptables-1.6.2.tar.bz2 root@${all_name}:/root/ 8 ssh root@${all_name} "yum -y install gcc make libnftnl-devel libmnl-devel autoconf automake libtool bison flex libnetfilter_conntrack-devel libnetfilter_queue-devel libpcap-devel bzip2" 9 ssh root@${all_name} "export LC_ALL=C && tar -xvf iptables-1.6.2.tar.bz2 && cd iptables-1.6.2 && ./autogen.sh && ./configure && make -j4 && make install && ls 10 -l /usr/local/sbin" 11 ssh root@${all_name} "systemctl daemon-reload && systemctl restart kubelet && systemctl restart kube-proxy" 12 done #编译安装iptables及重启相关服务

提示:本步骤操作仅需要在master01节点操作。

作者:木二

出处:http://www.cnblogs.com/itzgr/

关于作者:云计算、虚拟化,Linux,多多交流!

本文版权归作者所有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接!如有其他问题,可邮件(xhy@itzgr.com)咨询。

浙公网安备 33010602011771号

浙公网安备 33010602011771号