JUC 并发编程 Part 3

😉 本文共8790字,阅读时间约15min

修饰关键字原理

volatile原理

- volatile 的底层实现原理是内存屏障,Memory Barrier(Memory Fence)

- 对 volatile 变量的写指令后会加入写屏障

- 对 volatile 变量的读指令前会加入读屏障

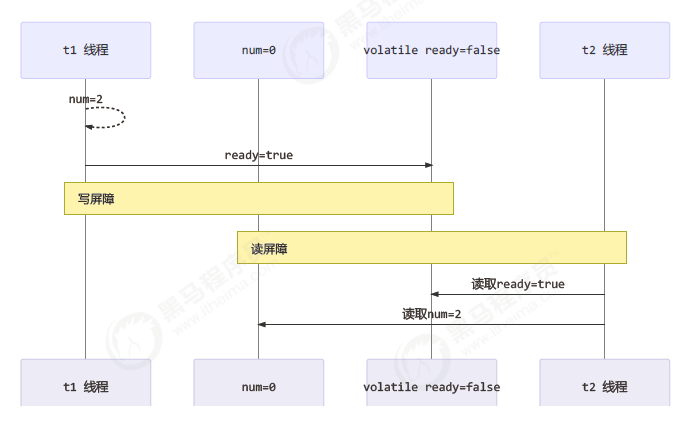

可见性

写屏障(sfence)保证在该屏障之前的,对共享变量的改动,都同步到主存当中

public void actor2(I_Result r) {

num = 2;

ready = true; // ready 是 volatile 赋值带写屏障

// 写屏障

}

而读屏障(lfence)保证在该屏障之后,对共享变量的读取,加载的是主存中最新数据

public void actor1(I_Result r) {

// 读屏障

// ready 是 volatile 读取值带读屏障

if(ready) {

r.r1 = num + num;

} else {

r.r1 = 1;

}

}

有序性 DCL

写屏障会确保指令重排序时,不会将写屏障之前的代码排在写屏障之后

读屏障会确保指令重排序时,不会将读屏障之后的代码排在读屏障之前

还是那句话,不能解决指令交错:写屏障仅仅是保证之后的读能够读到最新的结果,但不能保证读跑到它前面去。而有序性的保证也只是保证了本线程内相关代码不被重排序。

public final class Singleton {

private Singleton() { }

private static volatile Singleton INSTANCE = null;

public static Singleton getInstance() {

// 实例没创建,才会进入内部的 synchronized代码块

if (INSTANCE == null) {

synchronized (Singleton.class) { // t2

// 也许有其它线程已经创建实例,所以再判断一次

if (INSTANCE == null) { // t1

INSTANCE = new Singleton();

}

}

}

return INSTANCE;

}

}

-

这里使用volatile是为了防止编译器优化导致的指令重排序,在进行new一个对象不是原子性操作,可以分为三步骤:

1.分配内存空间

2.实例化对象

3.给变量INSTANCE赋值

对于上面的执行,如果1和3先执行了(假设2还没有完成),在第一层if外的线程这时候判断不为null,这时候就会直接返回该对象,但是这个对象可能还不完整。

注意 synchronized 语句块既可以保证代码块的原子性,也同时保证代码块内变量的可见性。但缺点是synchronized 是属于重量级操作,性能相对更低

final原理

// 理解了 volatile 原理,再对比 final 的实现就比较简单了

public class TestFinal {

final int a = 20;

}

final 变量的赋值也会通过 putfield 指令来完成,同样在这条指令之后也会加入写屏障,保证在其它线程读到它的值时不会出现为 0 的情况

synchronized原理 - 锁升级机制

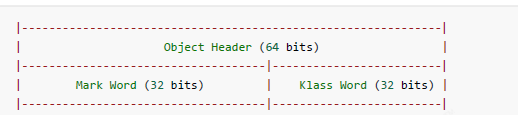

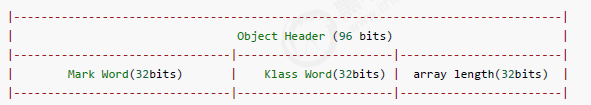

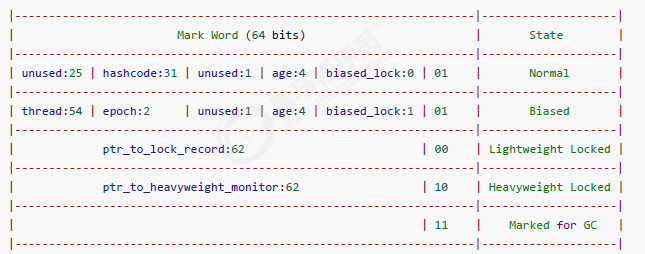

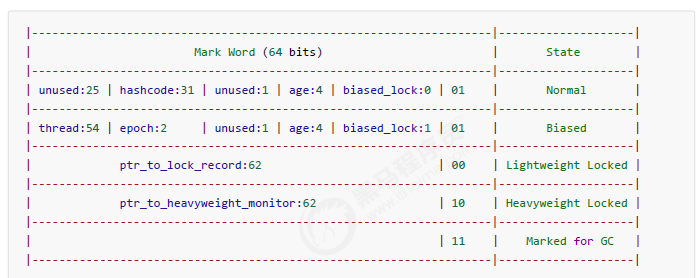

对象头格式

- 普通对象

- 数组对象

- 其中Mark Word结构

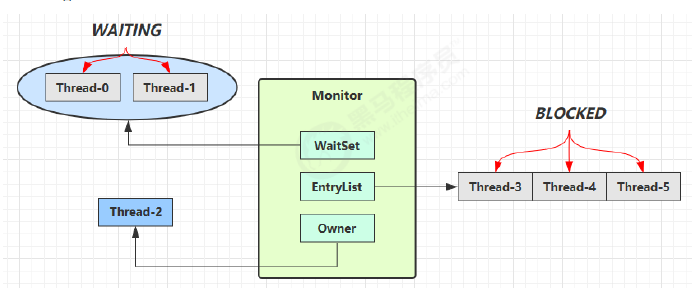

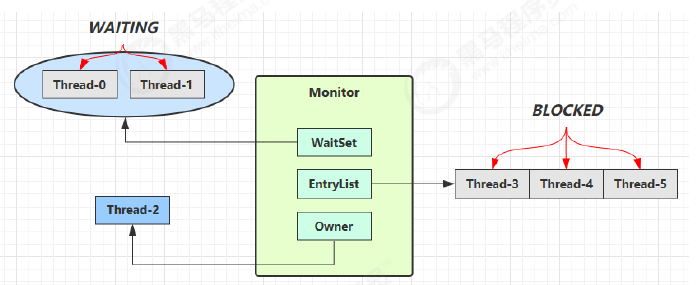

Monitor原理(重量级锁原理)

- Monitor 被翻译为监视器或管程

- 每个 Java 对象都可以关联一个 Monitor 对象,如果使用 synchronized 给对象上锁(重量级)之后,该对象头的Mark Word 中就被设置指向 Monitor 对象的指针。

- 刚开始 Monitor 中 Owner 为 null

- 当 Thread-2 执行 synchronized(obj) 就会将 Monitor 的所有者 Owner 置为 Thread-2,Monitor中只能有一个 Owner

- 在 Thread-2 上锁的过程中,如果 Thread-3,Thread-4,Thread-5 也来执行 synchronized(obj),就会进入EntryList BLOCKED

- Thread-2 执行完同步代码块的内容,然后唤醒 EntryList 中等待的线程来竞争锁,竞争的时是非公平的

- 图中 WaitSet 中的 Thread-0,Thread-1 是之前获得过锁,但条件不满足进入 WAITING 状态的线程,跟wait-notify有关

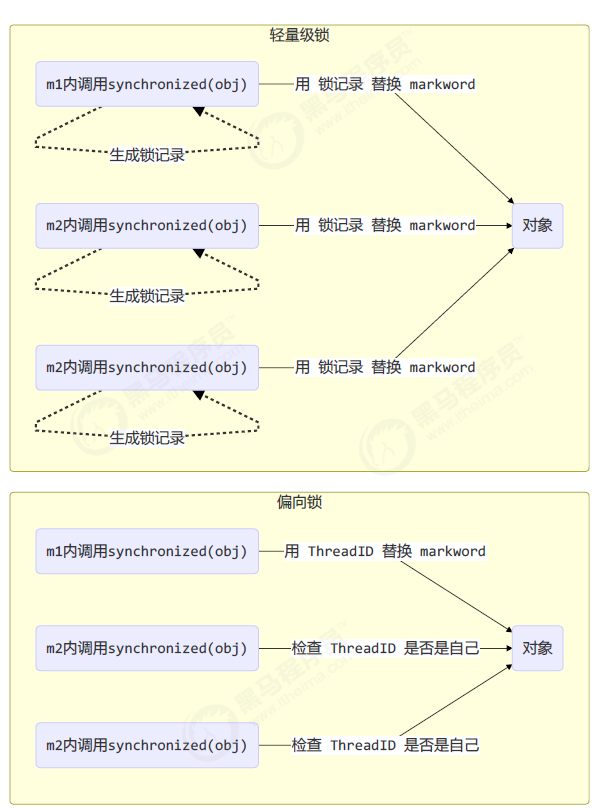

轻量级锁原理

- 轻量级锁的使用场景:如果一个对象虽然有多线程要加锁,但加锁的时间是错开的(也就是没有竞争),那么可以使用轻量级锁来优化。轻量级锁对使用者是透明的,语法不变。

轻量级锁加锁过程

假设有两个方法同步块,利用同一个对象加锁

static final Object obj = new Object();

public static void method1() {

synchronized( obj ) {

// 同步块 A

method2();

}

}

public static void method2() {

synchronized( obj ) {

// 同步块 B

}

}

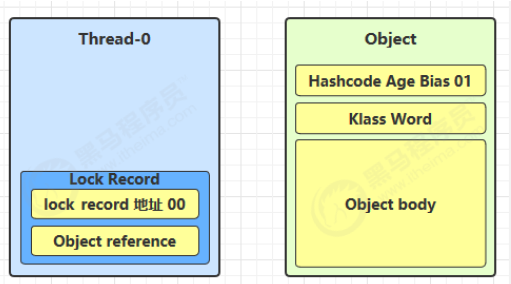

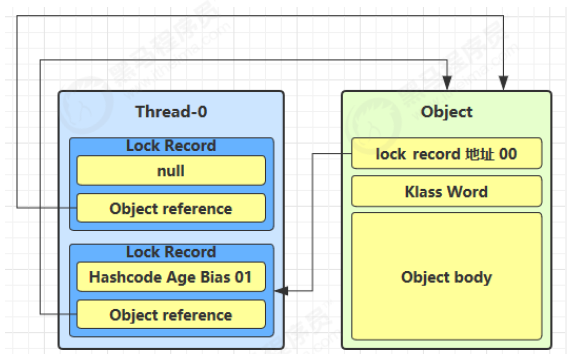

- 创建锁记录(Lock Record)对象,每个线程都的栈帧都会包含一个锁记录的结构,内部可以存储锁定对象的Mark Word。

- 让锁记录中 Object reference 指向锁对象,并尝试用 cas 替换 Object 的 Mark Word,将 Mark Word 的值存入锁记录

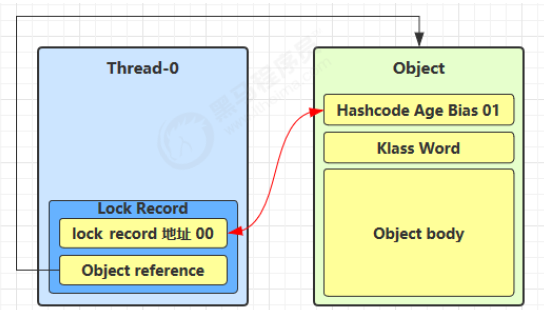

- 如果 cas 替换成功,对象头中存储了锁记录地址和状态 00 ,表示由该线程给对象加锁,这时图示如下

- 如果 cas 失败,有两种情况

- 如果是其它线程已经持有了该 Object 的轻量级锁,这时表明有竞争,进入锁膨胀过程

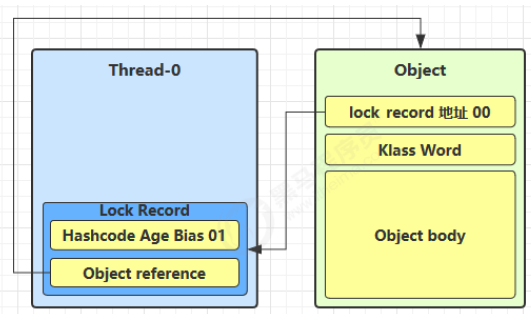

- 如果是自己执行了 synchronized 锁重入,那么再添加一条 Lock Record 作为重入的计数

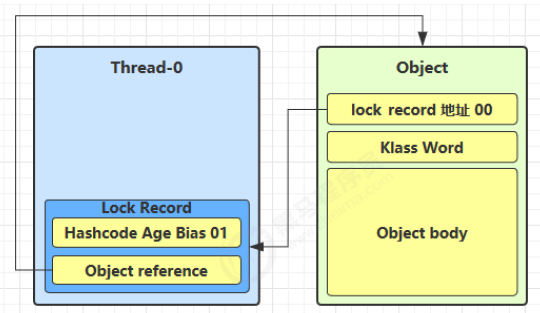

- 当退出 synchronized 代码块(解锁时)如果有取值为 null 的锁记录,表示有重入,这时重置锁记录,表示重入计数减一

- 当退出 synchronized 代码块(解锁时)锁记录的值不为 null,这时使用 cas 将 Mark Word 的值恢复给对象头

- 成功,则解锁成功

- 失败,说明轻量级锁进行了锁膨胀或已经升级为重量级锁,进入重量级锁解锁流程

锁膨胀

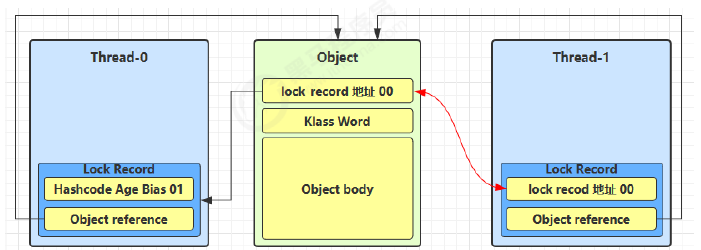

如果在尝试加轻量级锁的过程中,CAS 操作无法成功,这时一种情况就是有其它线程为此对象加上了轻量级锁(有竞争),这时需要进行锁膨胀,将轻量级锁变为重量级锁。

static Object obj = new Object();

public static void method1() {

synchronized( obj ) {

// 同步块

}

}

- 当 Thread-1 进行轻量级加锁时,Thread-0 已经对该对象加了轻量级锁

- 当 Thread-0 退出同步块解锁时,使用 cas 将 Mark Word 的值恢复给对象头,失败。这时会进入重量级解锁流程,即按照 Monitor 地址找到 Monitor 对象,设置 Owner 为 null,唤醒 EntryList 中 BLOCKED 线程

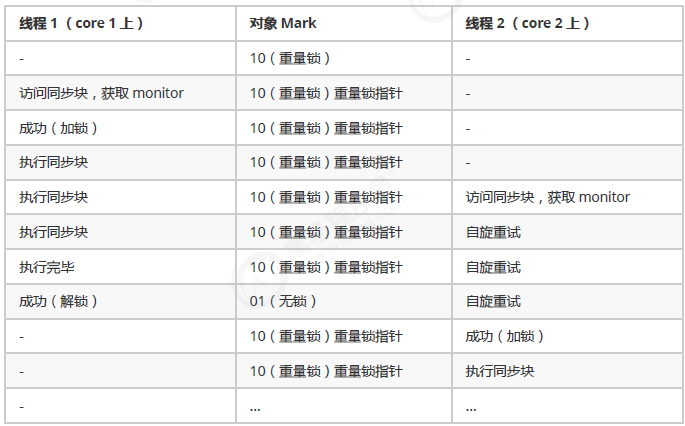

自旋优化

重量级锁竞争的时候,还可以使用自旋来进行优化,如果当前线程自旋成功(即这时候持锁线程已经退出了同步块,释放了锁),这时当前线程就可以避免阻塞。

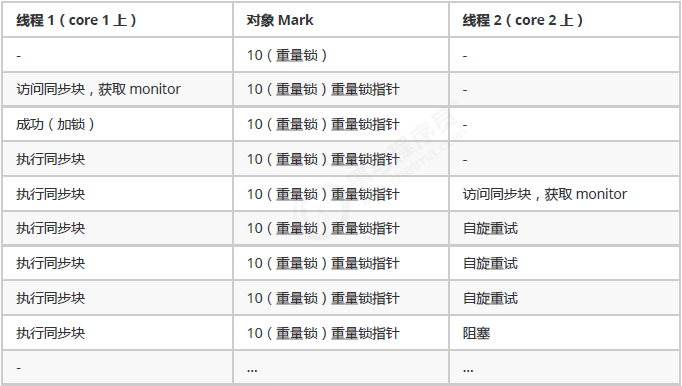

自旋重试成功的情况

自旋重试失败的情况

- 自旋会占用 CPU 时间,单核 CPU 自旋就是浪费,多核 CPU 自旋才能发挥优势。

- 在 Java 6 之后自旋锁是自适应的,比如对象刚刚的一次自旋操作成功过,那么认为这次自旋成功的可能性会高,就多自旋几次;反之,就少自旋甚至不自旋,总之,比较智能。

- Java 7 之后不能控制是否开启自旋功能

偏向锁原理

- 轻量级锁在没有竞争时(就自己这个线程),每次重入仍然需要执行 CAS 操作。

- Java 6 中引入了偏向锁来做进一步优化:只有第一次使用 CAS 将线程 ID 设置到对象的Mark Word 头,之后发现这个线程 ID 是自己的就表示没有竞争,不用重新 CAS。以后只要不发生竞争,这个对象就归该线程所有

- Java 15偏向锁被废弃:

- 过去看到的性能提升,在现在看来已经不那么明显了。受益于偏向锁的应用程序,往往是使用了早期 Java 集合 API(Hashtable 和 Vector) 每次访问时都进行同步。JDK 1.2 引入了针对单线程场景的非同步集合(HashMap 和 ArrayList),JDK 1.5 针对多线程场景推出了性能更高的并发数据结构。这意味着如果代码更新为使用较新的类,由于不必要同步而受益于偏向锁的应用程序,可能会看到很大的性能提高。

- 偏向锁为同步系统引入了许多

复杂的代码,并且对 HotSpot 的其他组件产生了影响。这种复杂性已经成为理解代码的障碍,也阻碍了对同步系统进行重构。因此,我们希望禁用、废弃并最终删除偏向锁。。

static final Object obj = new Object();

public static void m1() {

synchronized( obj ) {

// 同步块 A

m2();

}

}

public static void m2() {

synchronized( obj ) {

// 同步块 B

m3();

}

}

public static void m3() {

synchronized( obj ) {

// 同步块 C

}

}

偏向状态

回忆一下对象头格式

- 一个对象创建时:

- 如果开启了偏向锁(默认开启),那么对象创建后,markword 值为 0x05 即最后 3 位为 101,这时它的thread、epoch、age 都为 0

- 偏向锁是默认是延迟的,不会在程序启动时立即生效,如果想避免延迟,可以加 VM 参数 -

XX:BiasedLockingStartupDelay=0 来禁用延迟 - 如果没有开启偏向锁,那么对象创建后,markword 值为 0x01 即最后 3 位为 001,这时它的 hashcode、age 都为 0,第一次用到 hashcode 时才会赋值

注意:处于偏向锁的对象解锁后,线程 id 仍存储于对象头中

偏向锁撤销

调用对象 hashCode

调用了对象的 hashCode,但偏向锁的对象 MarkWord 中存储的是线程 id,如果调用 hashCode 会导致偏向锁被撤销。

- 轻量级锁会在锁记录中记录 hashCode

- 重量级锁会在 Monitor 中记录 hashCode

输出

11:22:10.386 c.TestBiased [main] - 调用 hashCode:1778535015

11:22:10.391 c.TestBiased [t1] - synchronized 前

00000000 00000000 00000000 01101010 00000010 01001010 01100111 00000001 normal

11:22:10.393 c.TestBiased [t1] - synchronized 中

00000000 00000000 00000000 00000000 00100000 11000011 11110011 01101000轻量级锁

11:22:10.393 c.TestBiased [t1] - synchronized 后

00000000 00000000 00000000 01101010 00000010 01001010 01100111 00000001 normal

其它线程使用对象

当有其它线程使用偏向锁对象时,会将偏向锁升级为轻量级锁

调用 wait/notify

也是违反使用场景,最后升级为重量级锁

批量重偏向

如果对象虽然被多个线程访问,但没有竞争,这时偏向了线程 T1 的对象仍有机会重新偏向 T2,重偏向会重置对象的 Thread ID。

当撤销偏向锁阈值超过 20 次后,jvm 会这样觉得,我是不是偏向错了呢,于是会在给这些对象加锁时重新偏向至加锁线程。

批量撤销

当撤销偏向锁阈值超过 40 次后,jvm 会这样觉得,自己确实偏向错了,根本就不该偏向。于是整个类的所有对象都会变为不可偏向的,新建的对象也是不可偏向的。

同步关键字原理

wait notify 原理

- Owner 线程发现条件不满足,调用 wait 方法,即可进入 WaitSet 变为 WAITING 状态

- BLOCKED 和 WAITING 的线程都处于阻塞状态,不占用 CPU 时间片

- BLOCKED 线程会在 Owner 线程释放锁时唤醒

- WAITING 线程会在 Owner 线程调用 notify 或 notifyAll 时唤醒,但唤醒后并不意味者立刻获得锁,仍需进入EntryList 重新竞争

// 让进入 object 监视器的线程到 waitSet 等待。从而让其他线程就机会获取对象的锁。无限制等待,直到notify为止

obj.wait()

// 有时限的等待, 到 n 毫秒后结束等待,或是被 notify

obj.wait(long n)

// 在 object 上正在 waitSet 等待的线程中挑一个唤醒

obj.notify()

// 让 object 上正在 waitSet 等待的线程全部唤醒

obj.notifyAll()

// 这些都是线程之间进行协作的手段,都属于 Object 对象的方法。必须获得此对象的锁,才能调用

join 原理

调用者轮询检查线程 alive 状态,注意join 体现的是【保护性暂停】模式

t1.join();

// 等价于下面的代码

synchronized (t1) {

// 调用者线程进入 t1 的 waitSet 等待, 直到 t1 运行结束

while (t1.isAlive()) {

t1.wait(0);

}

}

park unpark 原理

- 每个线程都有自己的一个 Parker 对象,由三部分组成 _counter , _cond 和 _mutex 打个比喻

- 线程就像一个旅人,Parker 就像他随身携带的背包,条件变量就好比背包中的帐篷。_counter 就好比背包中的备用干粮(0 为耗尽,1 为充足)

- 调用 park 就是要看需不需要停下来歇息

- 如果备用干粮耗尽,那么钻进帐篷歇息

- 如果备用干粮充足,那么不需停留,继续前进

- 调用 unpark,就好比令干粮充足

- 如果这时线程还在帐篷,就唤醒让他继续前进

- 如果这时线程还在运行,下次他调用 park 时,仅是消耗掉备用干粮,不需停留继续前进。

- 因为背包空间有限,多次调用 unpark 仅会补充一份备用干粮

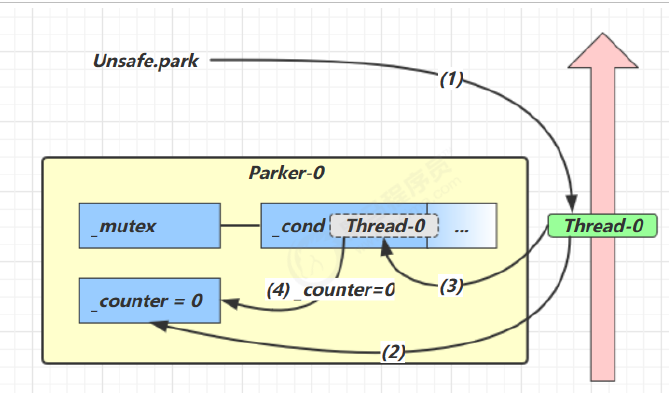

- 当前线程调用 Unsafe.park() 方法

- 检查 _counter ,本情况为 0,这时,获得 _mutex 互斥锁

- 线程进入 _cond 条件变量阻塞

- 设置 _counter = 0

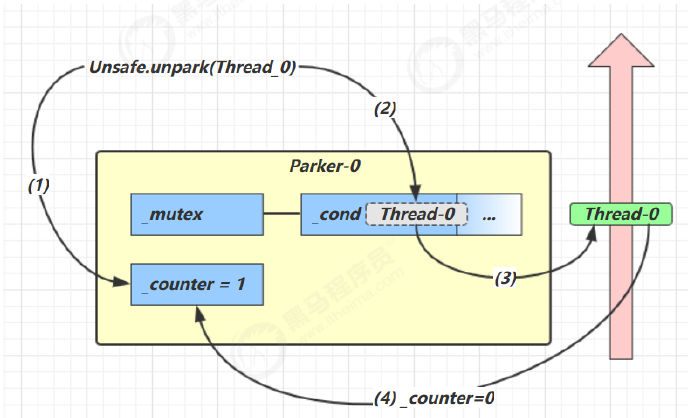

- 调用 Unsafe.unpark(Thread_0) 方法,设置 _counter 为 1

- 唤醒 _cond 条件变量中的 Thread_0

- Thread_0 恢复运行

- 设置 _counter 为 0

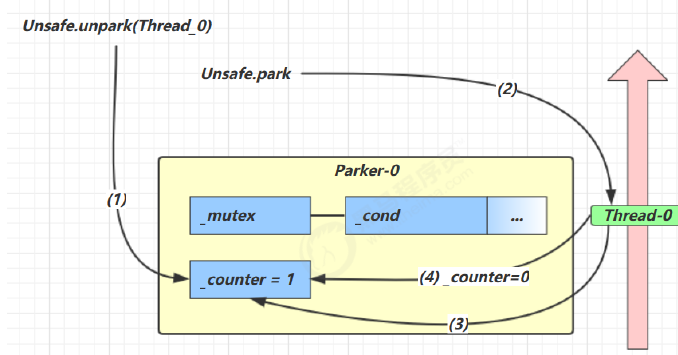

- 调用 Unsafe.unpark(Thread_0) 方法,设置 _counter 为 1

- 当前线程调用 Unsafe.park() 方法

- 检查 _counter ,本情况为 1,这时线程无需阻塞,继续运行

- 设置 _counter 为 0

// 它们是 LockSupport 类中的方法

// 暂停当前线程

LockSupport.park();

// 恢复某个线程的运行

LockSupport.unpark(暂停线程对象)

- 特点:

- wait,notify 和 notifyAll 必须配合 Object Monitor 一起使用,而 park,unpark 不必

- park & unpark 是以线程为单位来【阻塞】和【唤醒】线程,而 notify 只能随机唤醒一个等待线程,notifyAll是唤醒所有等待线程,就不那么【精确】

- park & unpark 可以先 unpark,而 wait & notify 不能先 notify

无锁并发

有如下需求,保证 account.withdraw 取款方法的线程安全。

- 可能需要synchronized(Account.class),锁的粒度很大

- 可以使用原子类解决,无锁效率高

CAS 与 volatile

CAS如何实现

AtomicInteger内部并没有用锁来保护共享变量的线程安全。那么它是如何实现的呢?

public void withdraw(Integer amount) {

while(true) {

// 需要不断尝试,直到成功为止

while (true) {

// 比如拿到了旧值 1000

int prev = balance.get();

// 在这个基础上 1000-10 = 990

int next = prev - amount;

/*

compareAndSet 正是做这个检查,在 set 前,先比较 prev 与当前值

- 不一致了,next 作废,返回 false 表示失败

比如,别的线程已经做了减法,当前值已经被减成了 990

那么本线程的这次 990 就作废了,进入 while 下次循环重试

- 一致,以 next 设置为新值,返回 true 表示成功

*/

if (balance.compareAndSet(prev, next)) {

break;

}

}

}

}

-

其中的关键是CAS ( Compare And Swap),它必须是原子操作。

其实 CAS 的底层是 lock cmpxchg 指令(X86 架构),在单核 CPU 和多核 CPU 下都能够保证【比较-交

换】的原子性。 -

volatile仅仅保证了共享变量的可见性,让其它线程能够看到最新值,但不能解决指令交错问题(不能保证原子性)。CAS 必须借助 volatile 才能读取到共享变量的最新值来实现【比较并交换】的效果。

为什么无锁并发效率高

-

无锁情况下,即使重试失败,线程始终在高速运行,没有停歇,而 synchronized 会让线程在没有获得锁的时

候,发生上下文切换,进入阻塞。打个比喻- 线程就好像高速跑道上的赛车,高速运行时,速度超快,一旦发生上下文切换,就好比赛车要减速、熄火,等被唤醒又得重新打火、启动、加速... 恢复到高速运行,代价比较大

-

但无锁情况下,因为线程要保持运行,需要额外 CPU 的支持,CPU 在这里就好比高速跑道,没有额外的跑

道,线程想高速运行也无从谈起,虽然不会进入阻塞,但由于没有分到时间片,仍然会进入可运行状态,还

是会导致上下文切换。

CAS的特点

- 结合 CAS 和 volatile 可以实现无锁并发,适用于线程数少、多核 CPU 的场景下。

- CAS 是基于乐观锁的思想:最乐观的估计,不怕别的线程来修改共享变量,就算改了也没关系,我吃亏点再重试呗。

- synchronized 是基于悲观锁的思想:最悲观的估计,得防着其它线程来修改共享变量,我上了锁你们都别想改,我改完了解开锁,你们才有机会。

- CAS 体现的是无锁并发、无阻塞并发,请仔细体会这两句话的意思

- 因为没有使用 synchronized,所以线程不会陷入阻塞,这是效率提升的因素之一

- 但如果竞争激烈,可以想到重试必然频繁发生,反而效率会受影响

原子类

原子整数

JUC 并发包提供了:AtomicBoolean、AtomicInteger、AtomicLong

原子引用

- AtomicReference

// 安全实现 - 使用CAS

class DecimalAccountSafeCas implements DecimalAccount {

AtomicReference<BigDecimal> ref;

public DecimalAccountSafeCas(BigDecimal balance) {

ref = new AtomicReference<>(balance);

}

@Override

public BigDecimal getBalance() {

return ref.get();

}

@Override

public void withdraw(BigDecimal amount) {

while (true) {

BigDecimal prev = ref.get();

BigDecimal next = prev.subtract(amount);

if (ref.compareAndSet(prev, next)) {

break;

}

}

}

}

- ABA问题及其解决

- 主线程仅能判断出共享变量的值与最初值 A 是否相同,不能感知到这种从 A 改为 B 又 改回 A 的情况,如果主线程希望:只要有其它线程【动过了】共享变量,那么自己的 cas 就算失败,这时,仅比较值是不够的,需要再加一个版本号

- AtomicStampedReference

- AtomicStampedReference 可以给原子引用加上版本号,追踪原子引用整个的变化过程,如: A -> B -> A ->C ,通过AtomicStampedReference,我们可以知道,引用变量中途被更改了几次。

- AtomicMarkableReference

- 但是有时候,并不关心引用变量更改了几次,只是单纯的关心是否更改过,所以就有了

AtomicMarkableReference

- 但是有时候,并不关心引用变量更改了几次,只是单纯的关心是否更改过,所以就有了

原子数组

- AtomicIntegerArray

- AtomicLongArray

- AtomicReferenceArray

安全的数组

demo(

()-> new AtomicIntegerArray(10),

(array) -> array.length(),

(array, index) -> array.getAndIncrement(index),

array -> System.out.println(array)

);

字段更新器

- AtomicReferenceFieldUpdater // 域 字段

- AtomicIntegerFieldUpdater

- AtomicLongFieldUpdater

利用字段更新器,可以针对对象的某个域(Field)进行原子操作,只能配合 volatile 修饰的字段使用,否则会出现异常

Exception in thread "main" java.lang.IllegalArgumentException: Must be volatile type

原子累加器

为什么原子累加器能提升性能?

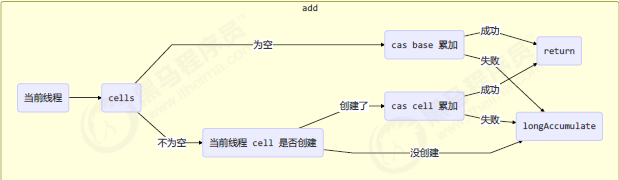

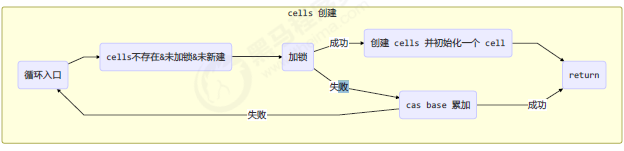

在有竞争时,设置多个累加单元,Therad-0 累加 Cell[0],而 Thread-1 累加Cell[1]... 最后将结果汇总。这样它们在累加时操作的不同的 Cell 变量,因此减少了 CAS 重试失败,从而提高性能。

源码之LongAdder

// 累加单元数组, 懒惰初始化

transient volatile Cell[] cells;

// 基础值, 如果没有竞争, 则用 cas 累加这个域

transient volatile long base;

// 在 cells 创建或扩容时, 置为 1, 表示加锁

transient volatile int cellsBusy;

原理之伪共享

其中 Cell 即为累加单元

// 防止缓存行伪共享

@sun.misc.Contended

static final class Cell {

volatile long value;

Cell(long x) {

value = x;

}

// 最重要的方法, 用来 cas 方式进行累加, prev 表示旧值, next 表示新值

final boolean cas(long prev, long next) {

return UNSAFE.compareAndSwapLong(this, valueOffset, prev, next);

}

// 省略不重要代码

}

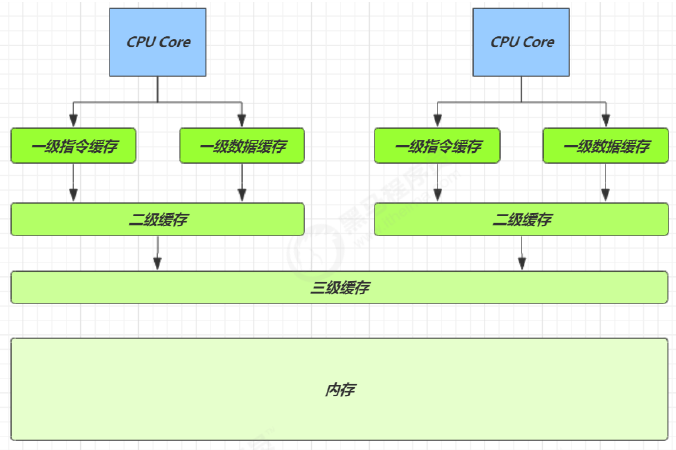

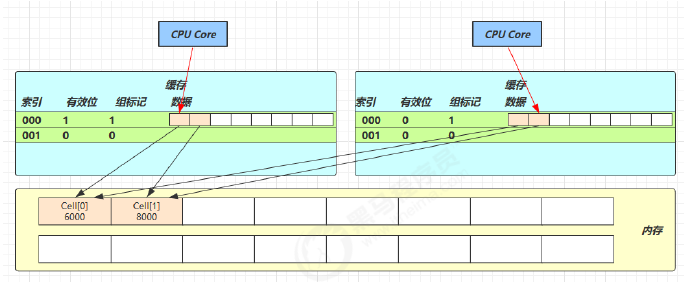

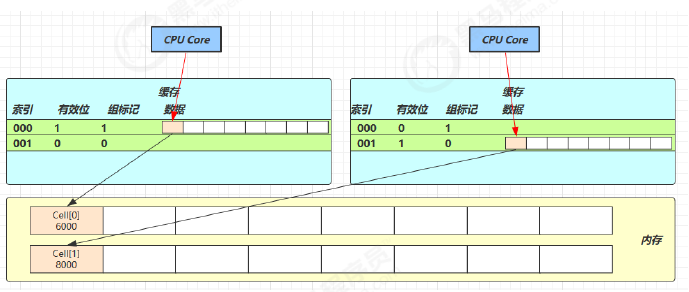

得从缓存说起,缓存与内存的速度比较

- 因为 CPU 与 内存的速度差异很大,需要靠预读数据至缓存来提升效率。

- 而缓存以缓存行为单位,每个缓存行对应着一块内存,一般是 64 byte(8 个 long)

- 缓存的加入会造成数据副本的产生,即同一份数据会缓存在不同核心的缓存行中

- CPU 要保证数据的一致性,如果某个 CPU 核心更改了数据,其它 CPU 核心对应的整个缓存行必须失效

- 因为 Cell 是数组形式,在内存中是连续存储的,一个 Cell 为 24 字节(16 字节的对象头和 8 字节的 value),因此缓存行可以存下 2 个的 Cell 对象。这样问题来了:

- Core-0 要修改 Cell[0]

- Core-1 要修改 Cell[1]

- 无论谁修改成功,都会导致对方 Core 的缓存行失效,比如 Core-0 中 Cell[0]=6000, Cell[1]=8000 要累加

Cell[0]=6001, Cell[1]=8000 ,这时会让 Core-1 的缓存行失效,@sun.misc.Contended用来解决这个问题,它的原理是在使用此注解的对象或字段的前后各增加 128 字节大小的padding,从而让 CPU 将对象预读至缓存时占用不同的缓存行,这样,不会造成对方缓存行的失效

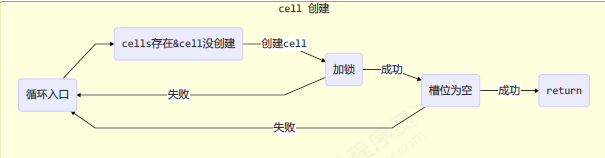

add流程图

add流程图

longAccumulate流程图

获得最终结果通过sum方法

public long sum() {

Cell[] as = cells; Cell a;

long sum = base;

if (as != null) {

for (int i = 0; i < as.length; ++i) {

if ((a = as[i]) != null)

sum += a.value;

}

}

return sum;

}

Unsafe

概述

Unsafe 对象提供了非常底层的,操作内存、线程的方法,Unsafe 对象不能直接调用,只能通过反射获得

public class UnsafeAccessor {

static Unsafe unsafe;

static {

try {

Field theUnsafe = Unsafe.class.getDeclaredField("theUnsafe");

theUnsafe.setAccessible(true);

unsafe = (Unsafe) theUnsafe.get(null);

} catch (NoSuchFieldException | IllegalAccessException e) {

throw new Error(e);

}

}

static Unsafe getUnsafe() {

return unsafe;

}

}

Unsafe CAS 操作

@Data

class Student {

volatile int id;

volatile String name;

}

Unsafe unsafe = UnsafeAccessor.getUnsafe();

Field id = Student.class.getDeclaredField("id");

Field name = Student.class.getDeclaredField("name");

// 获得成员变量的偏移量

long idOffset = UnsafeAccessor.unsafe.objectFieldOffset(id);

long nameOffset = UnsafeAccessor.unsafe.objectFieldOffset(name);

Student student = new Student();

// 使用 cas 方法替换成员变量的值

UnsafeAccessor.unsafe.compareAndSwapInt(student, idOffset, 0, 20); // 返回 true

UnsafeAccessor.unsafe.compareAndSwapObject(student, nameOffset, null, "张三"); // 返回 true

System.out.println(student);

不可变类 / 无状态类

不可变对象,实际是另一种避免竞争的方式,从而实现线程安全。

比如String类

final的使用

发现该类、类中所有属性都是 final 的

- 属性用 final 修饰保证了该属性是只读的,不能修改

- 类用 final 修饰保证了该类中的方法不能被覆盖,防止子类无意间破坏不可变性

保护性拷贝

比如substring(),发现其内部是调用 String 的构造方法创建了一个新字符串。这种通过创建副本对象来避

免共享的手段称之为【保护性拷贝(defensive copy)】。

public String substring(int beginIndex) {

if (beginIndex < 0) {

throw new StringIndexOutOfBoundsException(beginIndex);

}

int subLen = value.length - beginIndex;

if (subLen < 0) {

throw new StringIndexOutOfBoundsException(subLen);

}

return (beginIndex == 0) ? this : new String(value, beginIndex, subLen);

}

无状态

在 web 阶段学习时,设计 Servlet 时为了保证其线程安全,都会有这样的建议,不要为 Servlet 设置成员变量,这

种没有任何成员变量的类是线程安全的

因为成员变量保存的数据也可以称为状态信息,因此没有成员变量就称之为【无状态】

线程池

线程池状态

ThreadPoolExecutor 使用 int 的高 3 位来表示线程池状态,低 29 位表示线程数量

| 状态名 | 高3位 | 说明 |

|---|---|---|

| RUNNING | 111 | |

| SHUTDOWN | 000 | 不会接收新任务,但会处理阻塞队列剩余任务 |

| STOP | 001 | 会中断正在执行的任务,并抛弃阻塞队列任务 |

| TIDYING | 010 | 任务全执行完毕,活动线程为 0 即将进入终结 |

| TERMINATED | 011 | 终结状态 |

这些信息存储在一个原子变量 ctl 中,目的是将线程池状态与线程个数合二为一,这样就可以用一次 cas 原子操作

进行赋值。

构造方法

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler)

- corePoolSize 核心线程数目 (最多保留的线程数)

- maximumPoolSize 最大线程数目

- keepAliveTime 生存时间 - 针对救急线程

- unit 时间单位 - 针对救急线程

- workQueue 阻塞队列

- threadFactory 线程工厂 - 可以为线程创建时起个好名字

- handler 拒绝策略

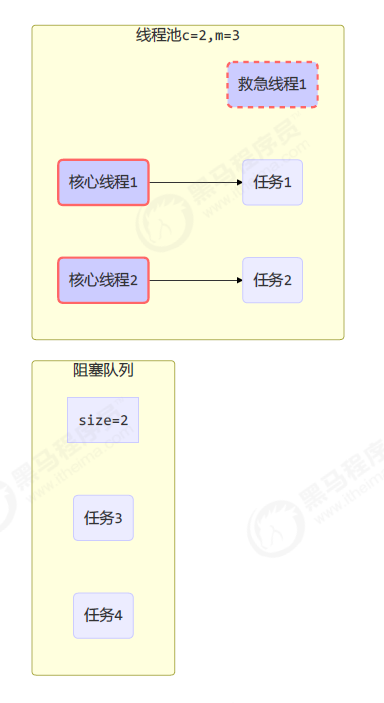

工作方式

- 线程池中刚开始没有线程,当一个任务提交给线程池后,线程池会创建一个新线程来执行任务。

- 当线程数达到 corePoolSize 并没有线程空闲,这时再加入任务,新加的任务会被加入workQueue 队列排

队,直到有空闲的线程。 - 如果队列选择了有界队列,那么任务超过了队列大小时,会创建 maximumPoolSize - corePoolSize 数目的线

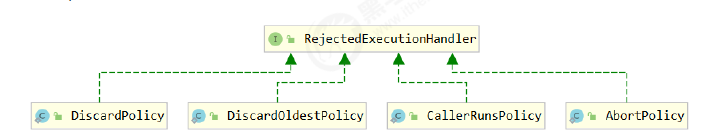

程来救急。 - 如果线程到达 maximumPoolSize 仍然有新任务这时会执行拒绝策略。拒绝策略 jdk 提供了 4 种实现,其它

著名框架也提供了实现- AbortPolicy 让调用者抛出 RejectedExecutionException 异常,这是默认策略

- CallerRunsPolicy 让调用者运行任务

- DiscardPolicy 放弃本次任务

- DiscardOldestPolicy 放弃队列中最早的任务,本任务取而代之

- 当高峰过去后,超过corePoolSize 的救急线程如果一段时间没有任务做,需要结束节省资源,这个时间由

keepAliveTime 和 unit 来控制。

线程池工作方法

根据这个构造方法,JDK Executors 类中提供了众多工厂方法来创建各种用途的线程池

newFixedThreadPool

public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

}

特点

- 核心线程数 == 最大线程数(没有救急线程被创建),因此也无需超时时间

- 阻塞队列是无界的,可以放任意数量的任务

评价 适用于任务量已知,相对耗时的任务

newCachedThreadPool

public static ExecutorService newCachedThreadPool() {

return new ThreadPoolExecutor(0, Integer.MAX_VALUE,

60L, TimeUnit.SECONDS,

new SynchronousQueue<Runnable>());

}

特点

- 核心线程数是 0, 最大线程数是 Integer.MAX_VALUE,救急线程的空闲生存时间是 60s,意味着

- 全部都是救急线程(60s 后可以回收)

- 救急线程可以无限创建

- 队列采用了 SynchronousQueue 实现特点是,它没有容量,没有线程来取是放不进去的

评价 整个线程池表现为线程数会根据任务量不断增长,没有上限,当任务执行完毕,空闲 1分钟后释放线

程。 适合任务数比较密集,但每个任务执行时间较短的情况

newSingleThreadExecutor

public static ExecutorService newSingleThreadExecutor() {

return new FinalizableDelegatedExecutorService

(new ThreadPoolExecutor(1, 1,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>()));

}

使用场景:

希望多个任务排队执行。线程数固定为 1,任务数多于 1 时,会放入无界队列排队。任务执行完毕,这唯一的线程也不会被释放。

区别:

- 自己创建一个单线程串行执行任务,如果任务执行失败而终止那么没有任何补救措施,而线程池还会新建一个线程,保证池的正常工作

- Executors.newSingleThreadExecutor() 线程个数始终为1,不能修改

- FinalizableDelegatedExecutorService 应用的是装饰器模式,只对外暴露了 ExecutorService 接口,因

此不能调用 ThreadPoolExecutor 中特有的方法

- FinalizableDelegatedExecutorService 应用的是装饰器模式,只对外暴露了 ExecutorService 接口,因

- Executors.newFixedThreadPool(1) 初始时为1,以后还可以修改

- 对外暴露的是 ThreadPoolExecutor 对象,可以强转后调用 setCorePoolSize 等方法进行修改

提交任务

// 执行任务

void execute(Runnable command);

// 提交任务 task,用返回值 Future 获得任务执行结果

<T> Future<T> submit(Callable<T> task);

// 提交 tasks 中所有任务

<T> List<Future<T>> invokeAll(Collection<? extends Callable<T>> tasks)

throws InterruptedException;

// 提交 tasks 中所有任务,带超时时间

<T> List<Future<T>> invokeAll(Collection<? extends Callable<T>> tasks,long timeout, TimeUnit unit);

// 提交 tasks 中所有任务,哪个任务先成功执行完毕,返回此任务执行结果,其它任务取消

<T> T invokeAny(Collection<? extends Callable<T>> tasks);

// 提交 tasks 中所有任务,哪个任务先成功执行完毕,返回此任务执行结果,其它任务取消,带超时时间

<T> T invokeAny(Collection<? extends Callable<T>> tasks,long timeout, TimeUnit unit);

关闭线程池

shutdown

/*

线程池状态变为 SHUTDOWN

- 不会接收新任务

- 但已提交任务会执行完

- 此方法不会阻塞调用线程的执行

*/

void shutdown();

public void shutdown() {

final ReentrantLock mainLock = this.mainLock;

mainLock.lock();

try {

checkShutdownAccess();

// 修改线程池状态

advanceRunState(SHUTDOWN);

// 仅会打断空闲线程

interruptIdleWorkers();

onShutdown(); // 扩展点 ScheduledThreadPoolExecutor

} finally {

mainLock.unlock();

}

// 尝试终结(没有运行的线程可以立刻终结,如果还有运行的线程也不会等)

tryTerminate();

}

shutdownNow

/*

线程池状态变为 STOP

- 不会接收新任务

- 会将队列中的任务返回

- 并用 interrupt 的方式中断正在执行的任务

*/

List<Runnable> shutdownNow();

public List<Runnable> shutdownNow() {

List<Runnable> tasks;

final ReentrantLock mainLock = this.mainLock;

mainLock.lock();

try {

checkShutdownAccess();

// 修改线程池状态

advanceRunState(STOP);

// 打断所有线程

interruptWorkers();

// 获取队列中剩余任务

tasks = drainQueue();

} finally {

mainLock.unlock();

}

// 尝试终结

tryTerminate();

return tasks;

}

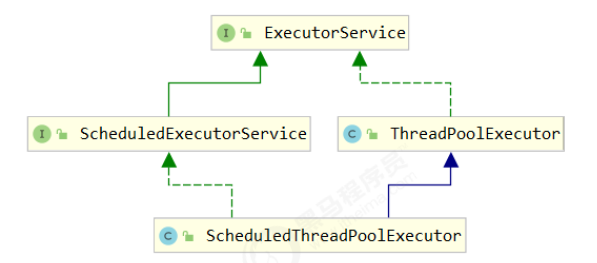

任务调度线程池

在『任务调度线程池』功能加入之前,可以使用 java.util.Timer 来实现定时功能,Timer 的优点在于简单易用,但由于所有任务都是由同一个线程来调度,因此所有任务都是串行执行的,同一时间只能有一个任务在执行,前一个任务的延迟或异常都将会影响到之后的任务。

使用 ScheduledExecutorService 改写:

ScheduledExecutorService executor = Executors.newScheduledThreadPool(2);

// 添加两个任务,希望它们都在 1s 后执行

executor.schedule(() -> {

System.out.println("任务1,执行时间:" + new Date());

try { Thread.sleep(2000); } catch (InterruptedException e) { }

}, 1000, TimeUnit.MILLISECONDS);

executor.schedule(() -> {

System.out.println("任务2,执行时间:" + new Date());

}, 1000, TimeUnit.MILLISECONDS);

scheduleAtFixedRate

ScheduledExecutorService pool = Executors.newScheduledThreadPool(1);

log.debug("start...");

pool.scheduleAtFixedRate(() -> {

log.debug("running...");

}, 1, 1, TimeUnit.SECONDS);

输出:

21:45:43.167 c.TestTimer [main] - start...

21:45:44.215 c.TestTimer [pool-1-thread-1] - running...

21:45:45.215 c.TestTimer [pool-1-thread-1] - running...

21:45:46.215 c.TestTimer [pool-1-thread-1] - running...

21:45:47.215 c.TestTimer [pool-1-thread-1] - running...

// if 任务执行时间超过了间隔时间

// 输出分析:一开始,延时 1s,接下来,由于任务执行时间 > 间隔时间,间隔被『撑』到了 2s

输出:

21:44:30.311 c.TestTimer [main] - start...

21:44:31.360 c.TestTimer [pool-1-thread-1] - running...

21:44:33.361 c.TestTimer [pool-1-thread-1] - running...

21:44:35.362 c.TestTimer [pool-1-thread-1] - running...

21:44:37.362 c.TestTimer [pool-1-thread-1] - running...

scheduleWithFixedDelay

ScheduledExecutorService pool = Executors.newScheduledThreadPool(1);

log.debug("start...");

pool.scheduleWithFixedDelay(()-> {

log.debug("running...");

sleep(2);

}, 1, 1, TimeUnit.SECONDS);

// 输出分析:一开始,延时 1s,scheduleWithFixedDelay 的间隔是 上一个任务结束 <-> 延时 <-> 下一个任务开始 所以间隔都是 3s

21:40:55.078 c.TestTimer [main] - start...

21:40:56.140 c.TestTimer [pool-1-thread-1] - running...

21:40:59.143 c.TestTimer [pool-1-thread-1] - running...

21:41:02.145 c.TestTimer [pool-1-thread-1] - running...

21:41:05.147 c.TestTimer [pool-1-thread-1] - running...

评价 整个线程池表现为:线程数固定,任务数多于线程数时,会放入无界队列排队。任务执行完毕,这些线

程也不会被释放。用来执行延迟或反复执行的任务

正确处理任务异常

主动catch异常

ExecutorService pool = Executors.newFixedThreadPool(1);

pool.submit(() -> {

try {

log.debug("task1");

int i = 1 / 0;

} catch (Exception e) {

log.error("error:", e);

}

});

使用Future

ExecutorService pool = Executors.newFixedThreadPool(1);

Future<Boolean> f = pool.submit(() -> {

log.debug("task1");

int i = 1 / 0;

return true;

});

log.debug("result:{}", f.get());

输出:

21:54:58.208 c.TestTimer [pool-1-thread-1] - task1

Exception in thread "main" java.util.concurrent.ExecutionException:

java.lang.ArithmeticException: / by zero

at java.util.concurrent.FutureTask.report(FutureTask.java:122)

at java.util.concurrent.FutureTask.get(FutureTask.java:192)

at cn.itcast.n8.TestTimer.main(TestTimer.java:31)

Caused by: java.lang.ArithmeticException: / by zero

at cn.itcast.n8.TestTimer.lambda$main$0(TestTimer.java:28)

at java.util.concurrent.FutureTask.run(FutureTask.java:266)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1149)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at java.lang.Thread.run(Thread.java:748)

Tomcat线程池

- LimitLatch 用来限流,可以控制最大连接个数,类似 J.U.C 中的 Semaphore 后面再讲

- Acceptor 只负责【接收新的 socket 连接】

- Poller 只负责监听 socket channel 是否有【可读的 I/O 事件】

- 一旦可读,封装一个任务对象(socketProcessor),提交给 Executor 线程池处理

- Executor 线程池中的工作线程最终负责【处理请求】

Tomcat 线程池扩展了 ThreadPoolExecutor,行为稍有不同

- 如果总线程数达到 maximumPoolSize

- 这时不会立刻抛 RejectedExecutionException 异常。

- 而是再次尝试将任务放入队列,如果还失败,才抛出 RejectedExecutionException 异常

Connector线程配置

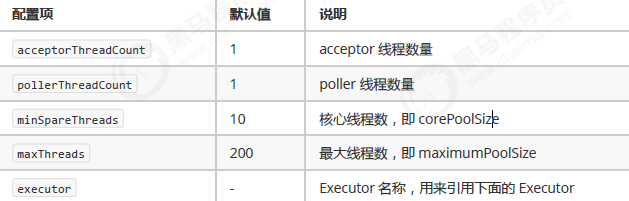

Executor线程配置

Fork/Join

Fork/Join 是 JDK 1.7 加入的新的线程池实现,它体现的是一种分治思想,适用于能够进行任务拆分的 cpu 密集型

运算。所谓的任务拆分,是将一个大任务拆分为算法上相同的小任务,直至不能拆分可以直接求解。跟递归相关的一些计算,如归并排序、斐波那契数列、都可以用分治思想进行求解。

Fork/Join 在分治的基础上加入了多线程,可以把每个任务的分解和合并交给不同的线程来完成,进一步提升了运

算效率。Fork/Join 默认会创建与 cpu 核心数大小相同的线程池。

浙公网安备 33010602011771号

浙公网安备 33010602011771号