s通过案例彻底详解spark中DAG的逻辑视图的产生机制和过程 -- (视频笔记)(重点)

hadoop RDD 把hdfs的block转换为split 的逻辑映射

mapPartitioned RDD 从split中转换,与hadoop RDD 一一映射

textFile

flatMap 也是mapPartitioned RDD

map

reduceByKey

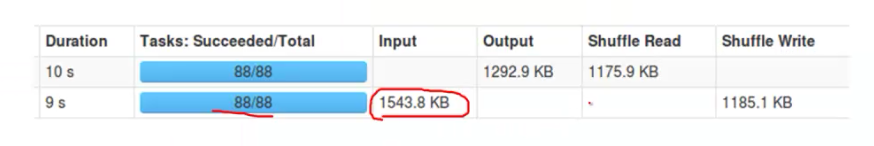

会将前期的窄依赖部分合并作为一个stage

第一个stage 会将结果写入到local file system(shuffle write)中

groupbykey及其以后因为存在shuffle,因此会生成一个新的stage

从上一个stage的local file system中获取数据(shuffer read)

driver 中的map output tracker的master负责跟踪第一个stage的输出。

参看spark shell的任务图形。