深度学习-1x1大小的卷积核、Inception网络

两个作用:

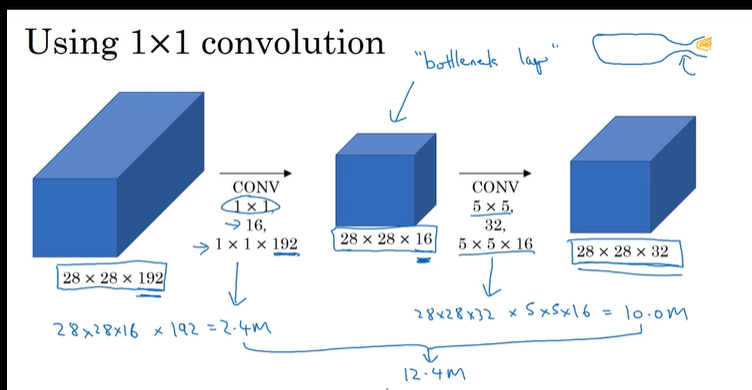

1、改变通道数,在inception网络中作为瓶颈,明显降低参数数量以及计算成本。 并且经过证明,合理的使用1x1的卷积并不会影响之后的影响。(具体的合理怎么规定?这里以后再说)

2、可以单纯的RELU的非线性,可以学习到更为复杂的函数。

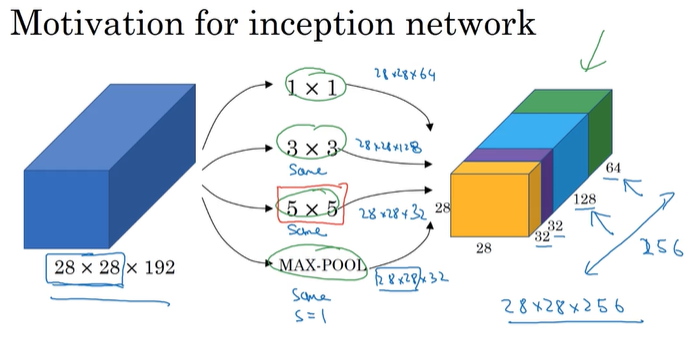

inception提出的动机:不用人工选择卷积核的大小,而是由网络自行决定选什么。

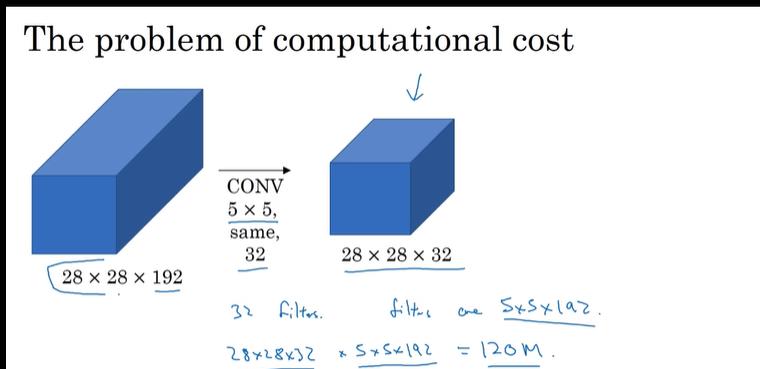

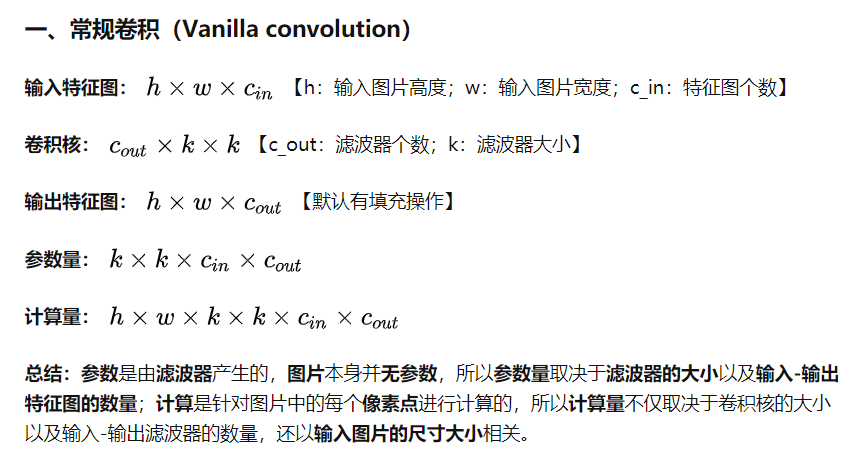

主要思想:运用1x1大小的卷积核 明显降低了 之后使用其他卷积核的参数,从120M降低到12M,文末附带计算量和参数量的计算

浙公网安备 33010602011771号

浙公网安备 33010602011771号