深度学习-batch norm

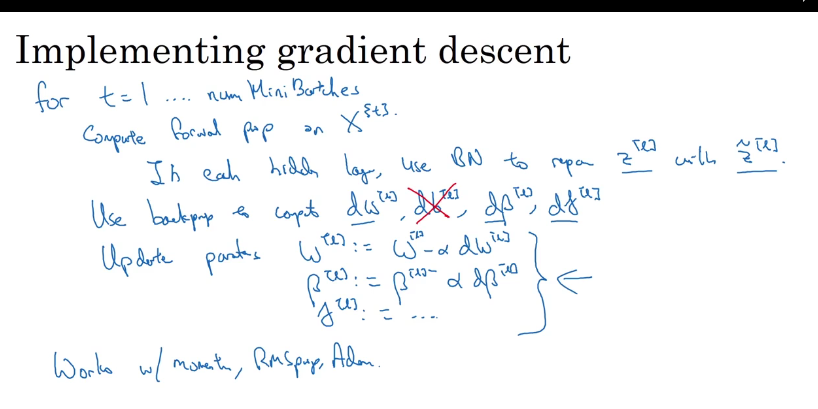

批归一化,不仅可以用在输入层能够加速梯度下降,而且可以用在隐藏层Z(i),另外可以改变其均值方差。

批量归一化为什么会奏效?

1、正规化,让每个维度有类似的大小范围,加快梯度下降,这只是浅层的原因

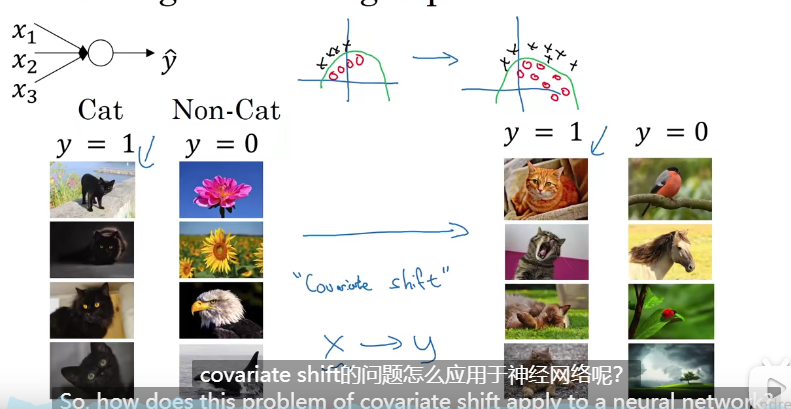

2、更进一步,由于批的分布变化可能会极不稳定,对后面的网络参数训练也不稳定,所有统一做成一个稳定的N(0,1)分布,使得每一层训练更加独立,这是更底层的东西。

例如,本来黑猫的图片来训练,后面优势彩色猫的图片,这时两者的分布不同,对后面的参数影响更大。所以限制在一定范围内N(0,1),更容易训练。

因为要归一化,所以不用b