深度学习-RMSprop、Adam、AdaGrad

RMSprop:通过指数加权均,使得大不能不能过大,小的不能太小。

动量法,通过指数加权平均求对应平均值,使其下降的更为平稳。

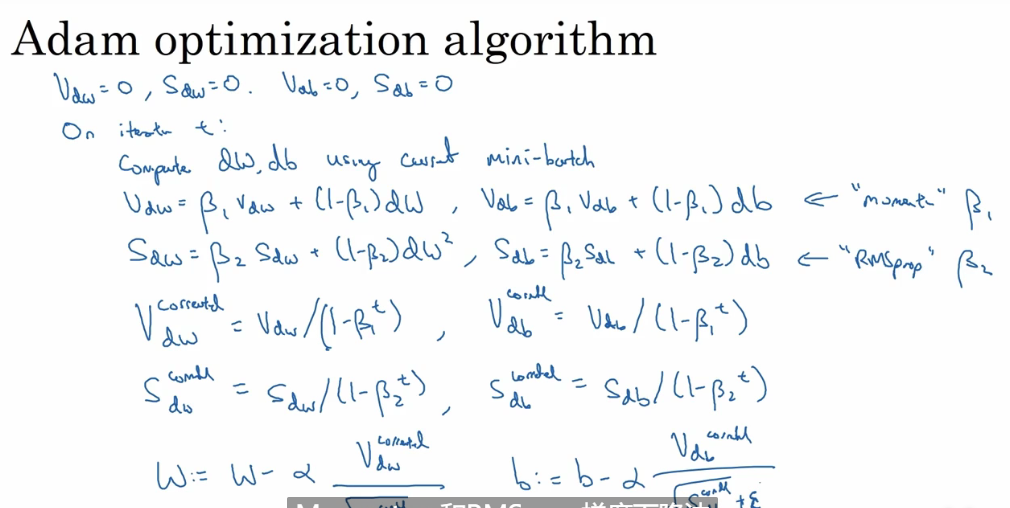

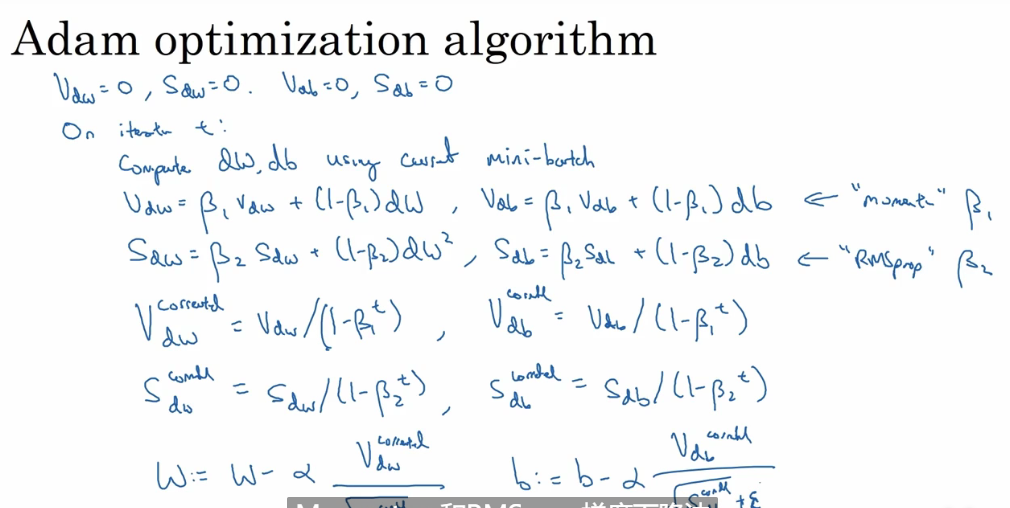

Adam就是结合了RMSprop 和动量法

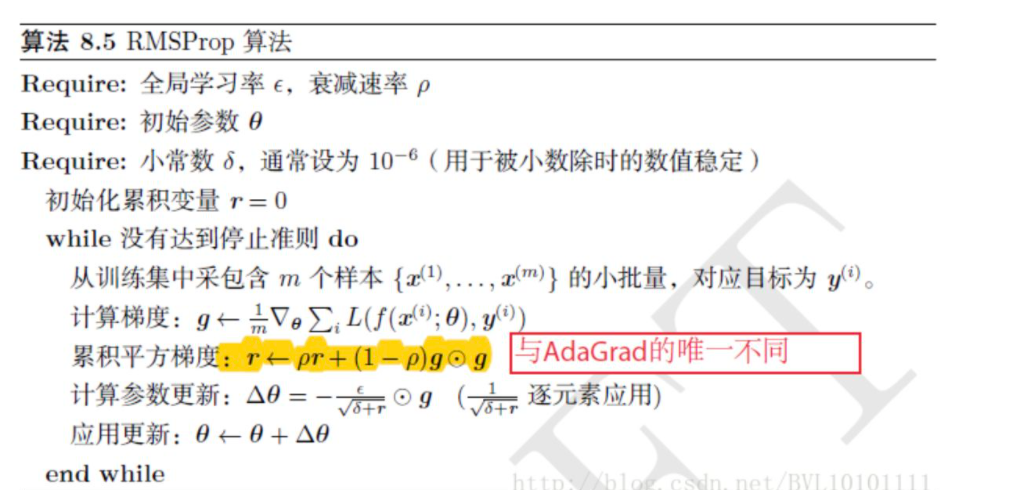

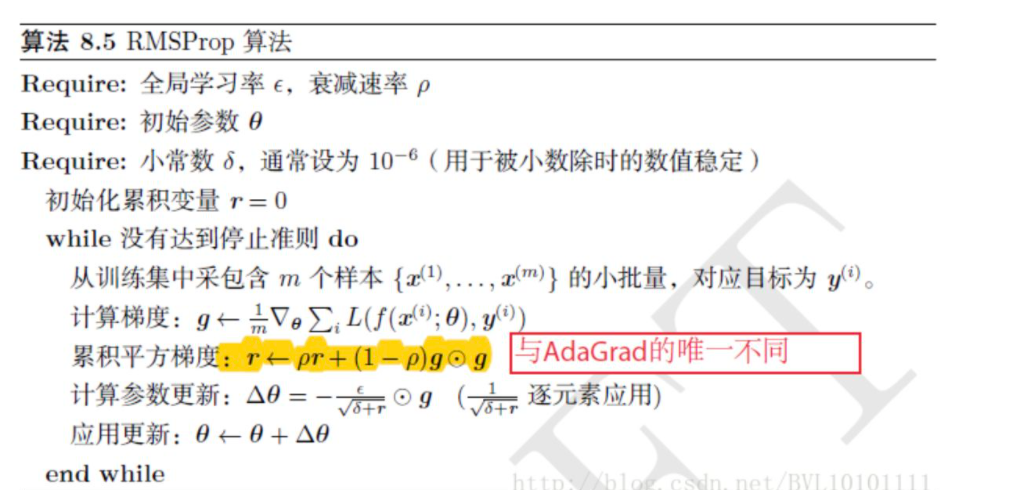

RMSProp算法不是像AdaGrad算法那样暴力直接的累加平方梯度,而是加了一个衰减系数来控制历史信息的获取多少。

RMSprop:通过指数加权均,使得大不能不能过大,小的不能太小。

动量法,通过指数加权平均求对应平均值,使其下降的更为平稳。

Adam就是结合了RMSprop 和动量法

RMSProp算法不是像AdaGrad算法那样暴力直接的累加平方梯度,而是加了一个衰减系数来控制历史信息的获取多少。