Survey on Large Language Model-Enhanced Reinforcement Learning: Concept, Taxonomy, and Methods

发表时间:2024

文章要点:文章对LLM增强强化学习(LLM-enhanced RL)的现有文献进行了总结。在agent-environment交互的范式下,讨论LLM对RL算法的帮助。

文章先给出LLM-enhanced RL的概念:the methods that utilize the multi-modal information processing, generating, reasoning, etc. capabilities of pre-trained, knowledge-inherent AI models to assist the RL paradigm。指的是利用预训练好的大模型的各种能力来帮助提升强化学习范式的一类方法。LLM-enhanced RL和model-based RL的主要区别在于LLM的model是更general的,包含各种知识的模型,而不是task specific的。

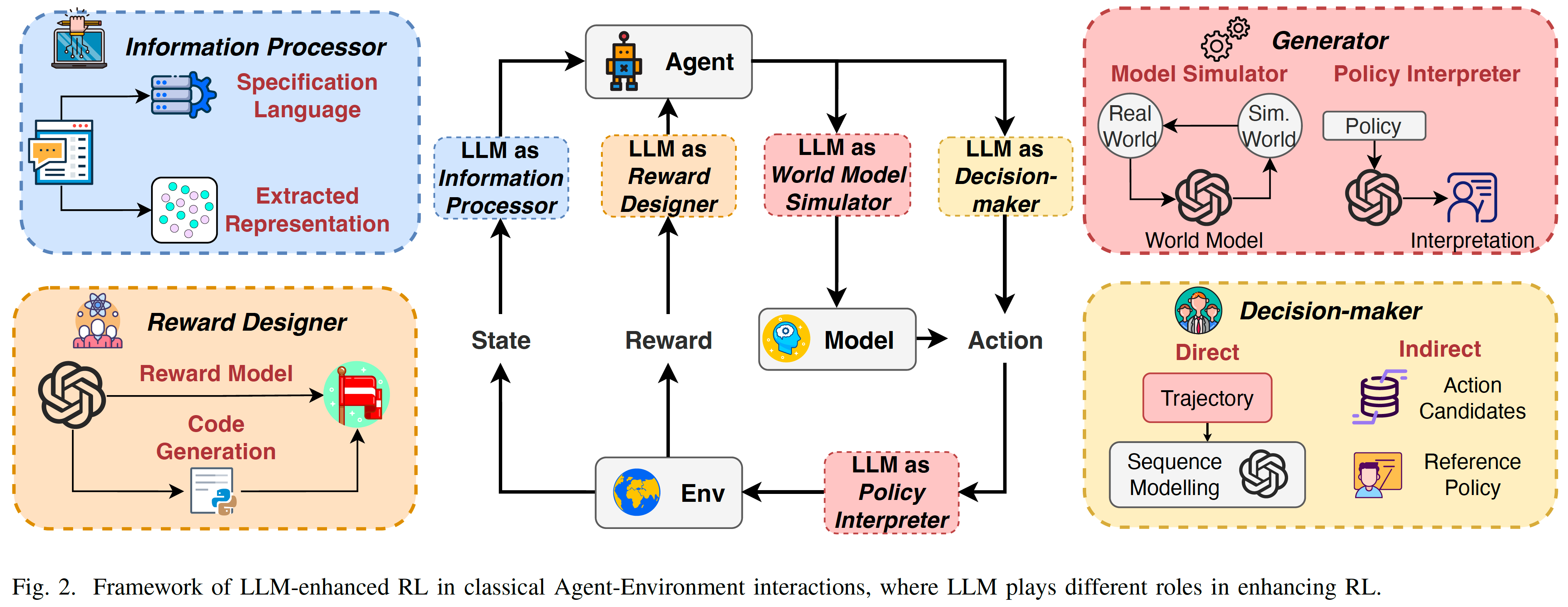

文章将LLM的功能分为信息处理器(information processor)、奖励设计者(reward designer)、决策者(decision-maker)和生成器(generator),并依次讨论每一部分。

LLM AS INFORMATION PROCESSOR

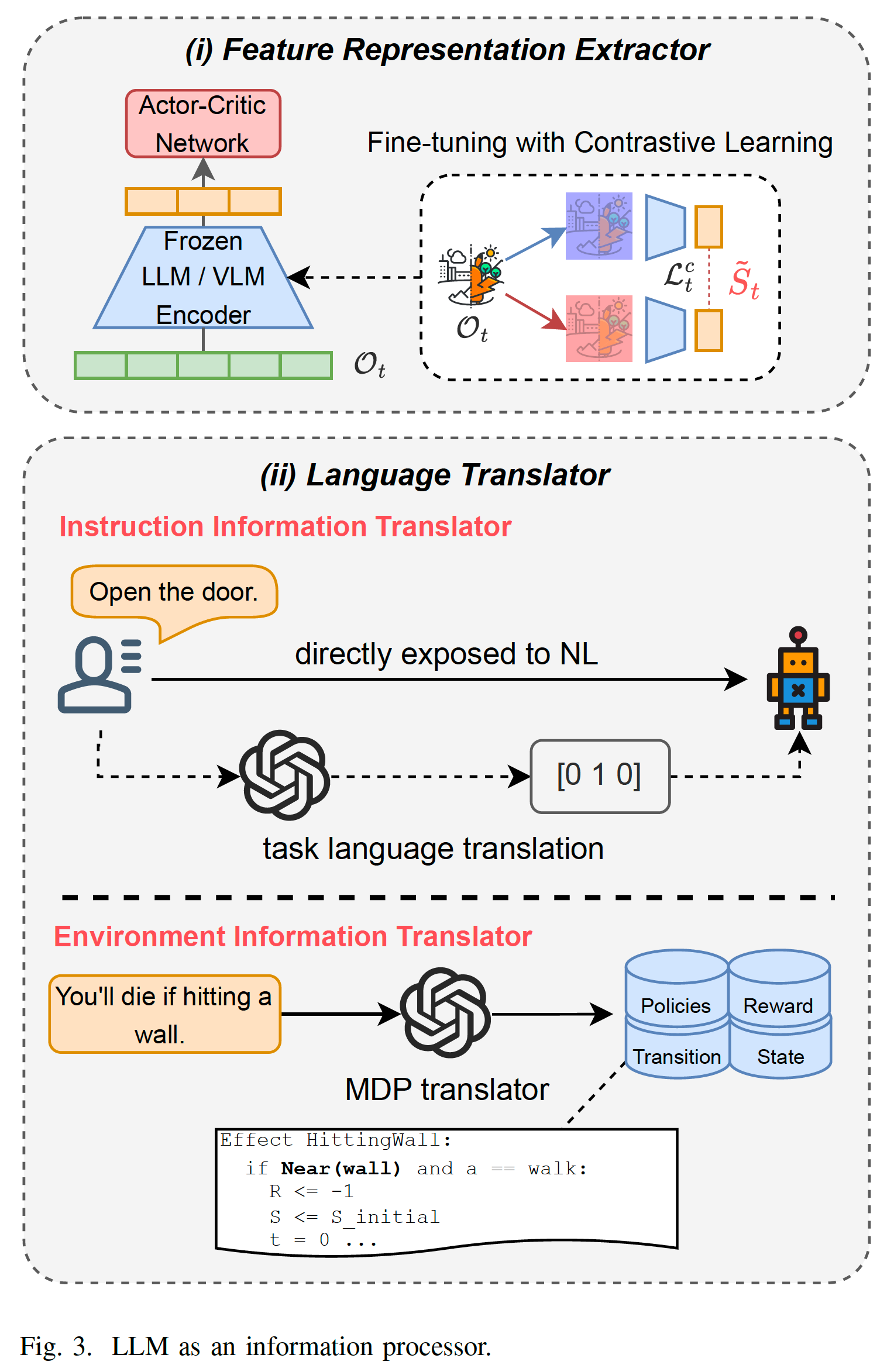

由于RL是端到端的学习范式,需要联合信息处理和策略学习两个方面,加大了RL学习的难度。LLM作为信息处理器(information processor)可以帮助RL提取信息,其中一个作用是相当于一个特征提取器(Feature Representation Extractor),将原始输入转换成特征向量再给到RL。图Fig.3(i)所示,LLM作为encoder要么是参数固定不变的(frozen),要么是通过某个损失进一步微调的,例如图中的contrastive learning。

LLM作为信息处理器的另一个用处是作为翻译器(Language Translator),LLM处理各种语义信息并总结成结构化的任务相关的信息(LLM transforms the diverse and informal natural language information into formal task-specific information)。Instruction Information Translation针对instruction-following applications,将任务说明规范化。Environment Information Translation针对环境相关的信息,将其规范化。如图Fig.3(ii)所示,将instruction变成one hot编码,将环境dynamic信息集成到reward中。

LLM AS INFORMATION PROCESSOR

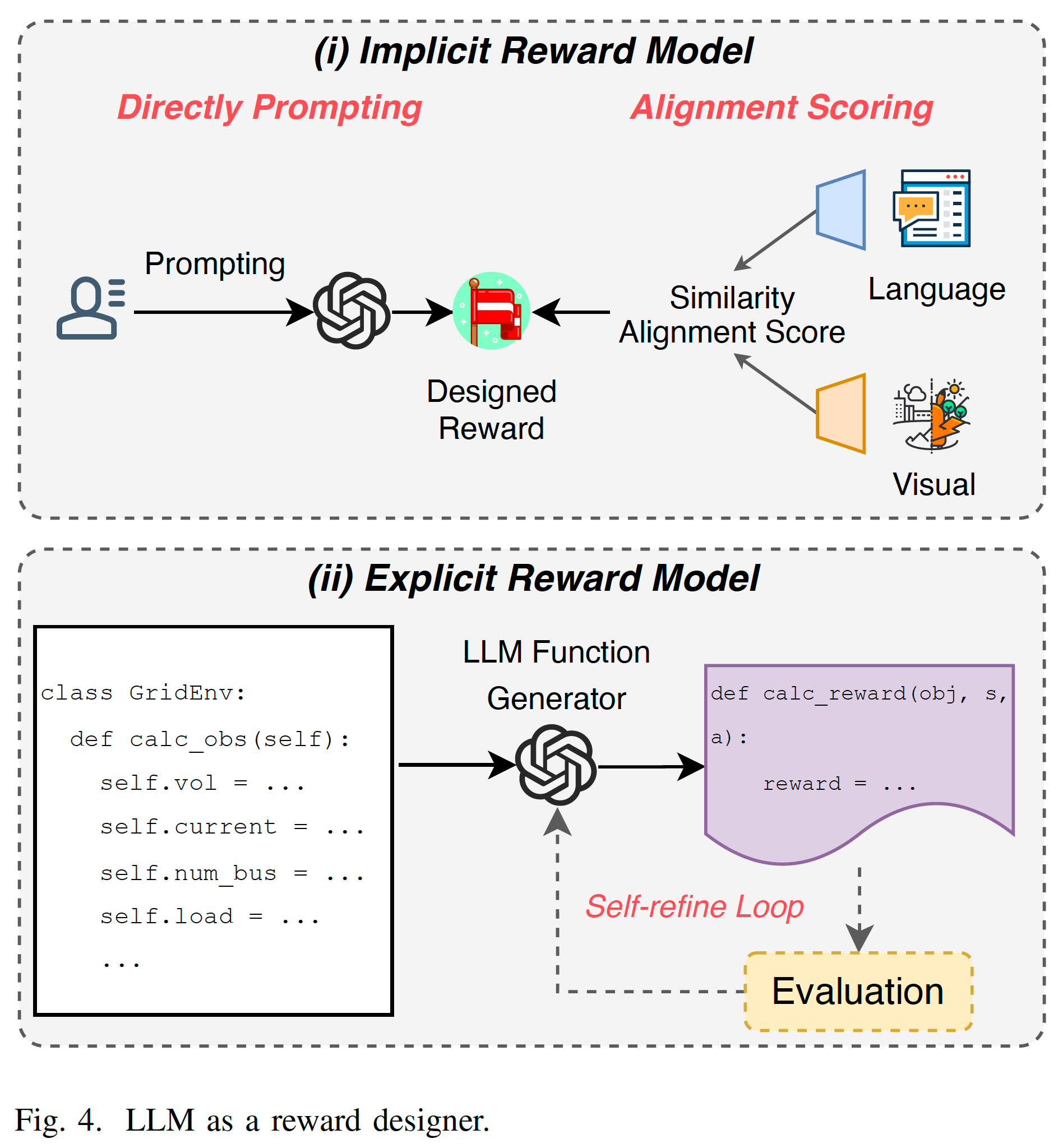

Reward 是RL学习的唯一信号,其重要性不言而喻。但是要想设计一个好的reward function是很困难的。LLM可以帮助设计或者reshape reward,包括隐式和显式。Implicit Reward Model指通过prompt LLM给出reward,或者通过LLM设计相似度指标来打分。Explicit Reward Model比较好理解,就是让LLM写个reward的函数出来。两种方式如Fig.4.所示。

LLM AS DECISION-MAKER

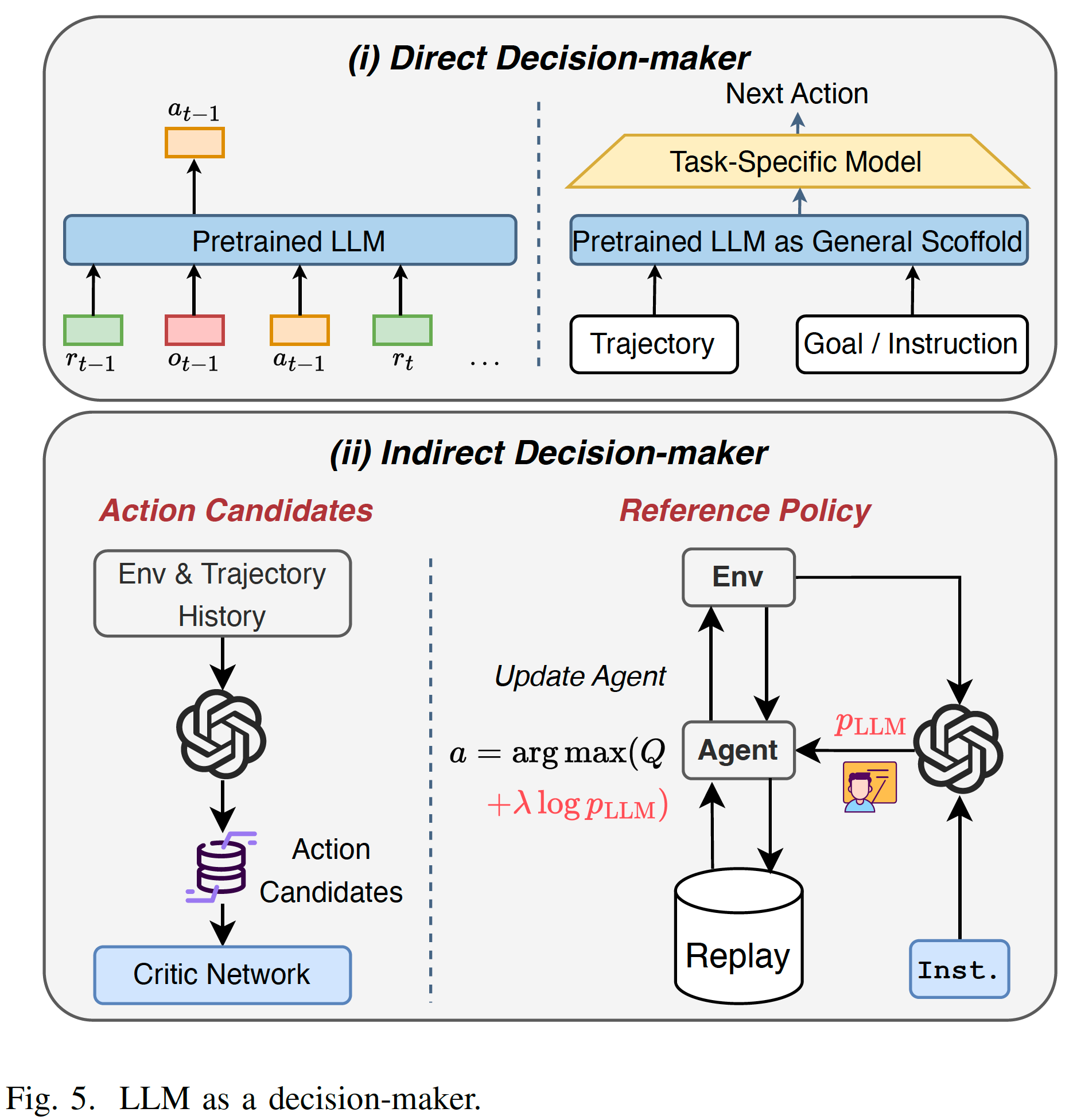

因为RL是decision making的任务,而LLM是基于大量数据训练的通用模型,本身具有一定的决策能力,所以可以帮助RL决策。分为直接和间接两种形式。Direct Decision-Maker直接利用模型本身,主要指transformer结构训练决策模型,这类任务通常不涉及RL,或者说只涉及offline RL。Indirect Decision-Maker中,LLM不是作为最终决策的policy,而是辅助RL的policy做决策。比如帮助筛选出候选动作,或者提供一个参考策略(Reference Policy)或者指导或者正则项。如Fig.5所示。

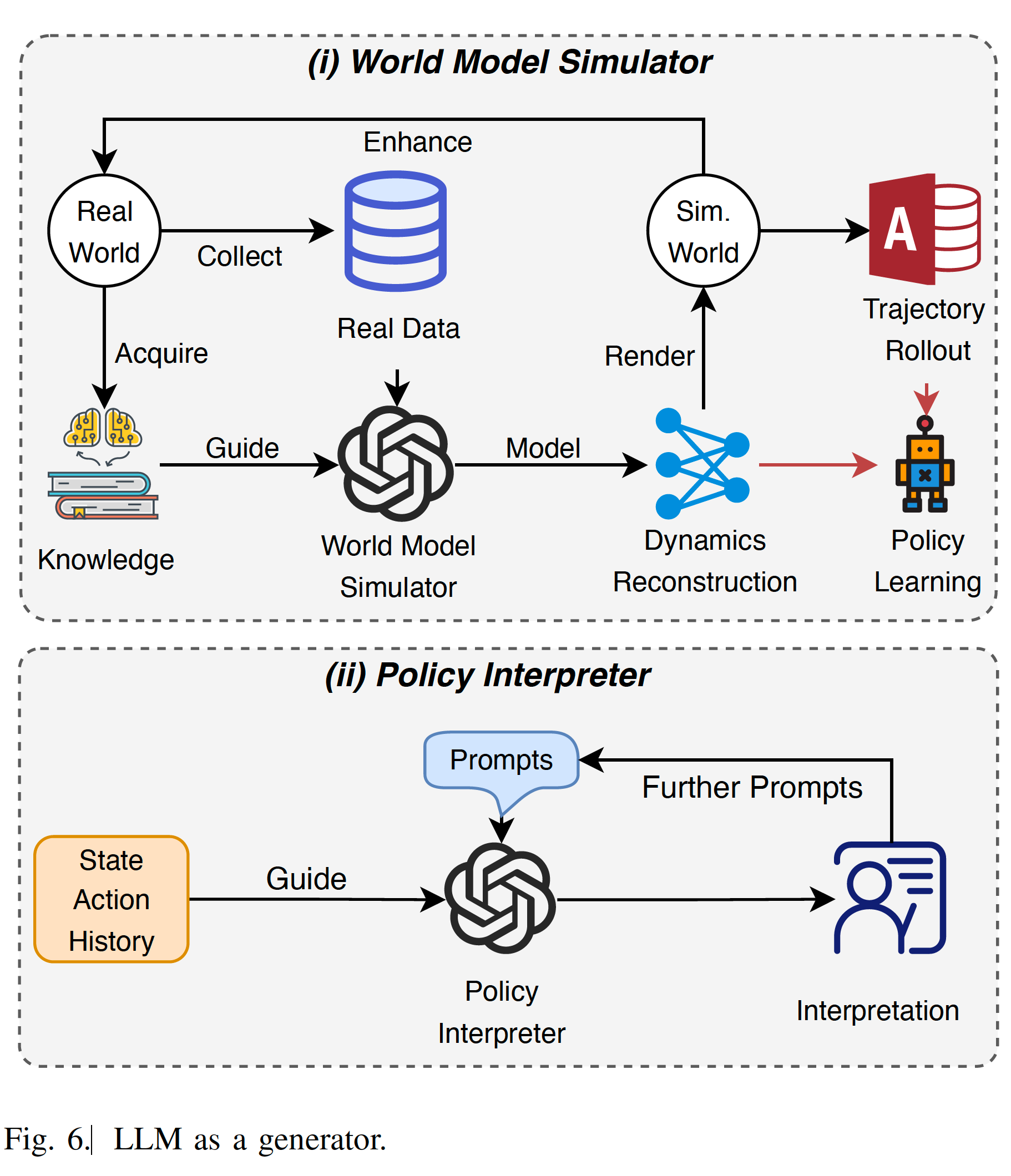

LLM AS GENERATOR

这一部分的作用比较像model-based里的model,不过功能要更丰富一些。文中分为World Model Simulator和Policy Interpreter两个作用。其中World Model Simulator和model-based RL里的model类似,这里主要指用transformer的结构学一个world model。这个model可以用来做trajectory rollout生成更多的样本,或者学习dynamic的表征。Policy Interpreter是说LLM可以分析或者解释一下当前策略行为的意义,方向往可解释性强化学习靠近(LLMs can be prompts to generate readable interpretations of current policies or situations for humans)。如Fig.6所示。

最后文章总结了应用,机会和挑战,还是一些比较常见的话题。应用总结了机器人,自动驾驶,能源管理,健康。机会总结了LLM-Enhanced RL下的子问题,比如RL方面的multi-agent RL, safe RL, transfer RL, explainable RL,LLM方面的retrieval-augmented generation (RAG)等工具。这个基本上就是水A+B文章的套路了。挑战提出了一些潜在的问题,比如LLM-Enhanced RL依赖LLM的能力,以及加入LLM的交互在计算开销上会大大增加等等。

总结:总结了多个方面的作用,挺全面的。不过他这个分类的方式其实有点奇怪,逻辑不太清晰,可能一种解释就是RL里面涉及到state,reward,model,action,对应起来就是LLM的四个功能了。

疑问:无。

浙公网安备 33010602011771号

浙公网安备 33010602011771号