RETROFORMER: RETROSPECTIVE LARGE LANGUAGE AGENTS WITH POLICY GRADIENT OPTIMIZATION

发表时间:2024(ICLR 2024)

文章要点:文章提出Retroformer,用策略梯度的方式调优prompt,更好的利用环境的reward。大体思路是学习一个retrospective LLM,将之前的轨迹和得分作为输入,得到一个新的prompt,这个prompt综合分析了之前的经验,从而提供一个更好的prompt。然后不断和环境交互,用PPO训练retrospective LLM。

具体的,整个架构包括Actor Model,Retrospective Model和Memory Module。

Actor Model是一个固定参数的LLM,用来输入prompt生成动作。

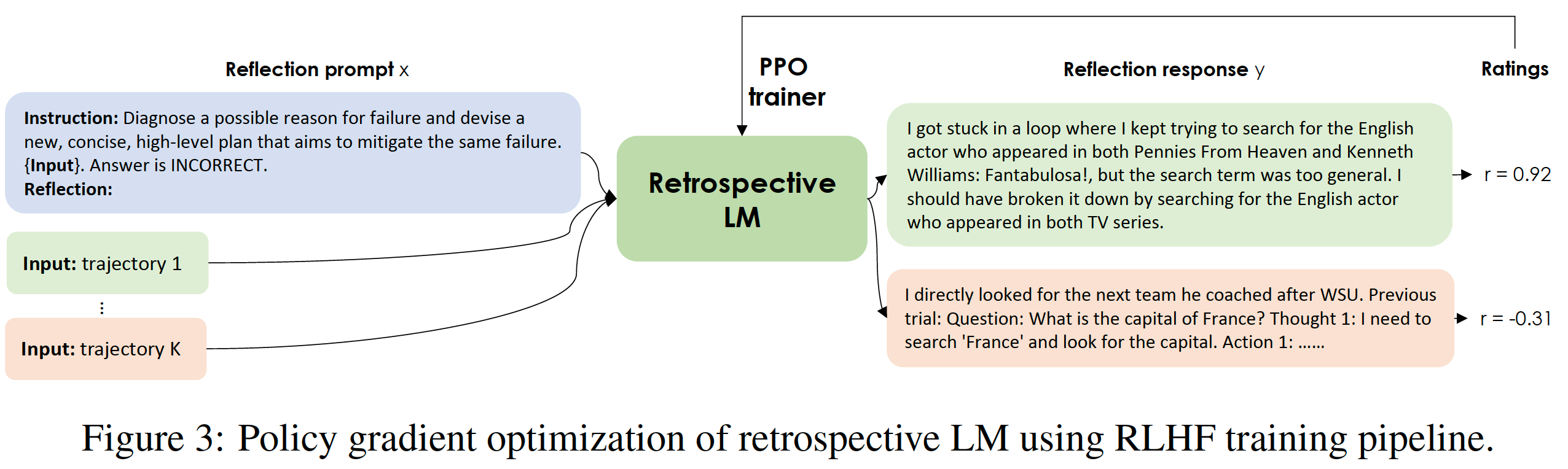

Retrospective Model用来根据之前的经验生成新的prompt(Its primary function is to produce self-reflections, offering valuable feedback for diagnosing a possible reason for prior failure and devising a new, concise, high-level plan that aims to mitigate same failure.)。

Memory Module存储长短时记忆。其中Short-term memory指当前episode,Long-term memory指Retrospective Model输出的总结了之前的失败经验的prompt。

Retrospective Model的训练如下图所示,每次生成多条轨迹并打分,再用PPO训练更新参数。

总结:还是有道理的,虽然还是在做prompt,不过总算看到一篇真正用了RL的了。

疑问:无。

浙公网安备 33010602011771号

浙公网安备 33010602011771号