Prioritized Experience Replay

发表时间:2016(ICLR 2016)

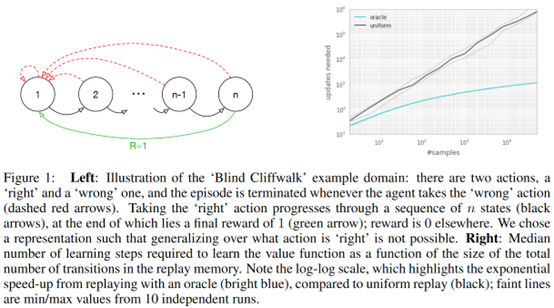

文章要点:这篇文章提出了很经典的experience replay的方法PER,通过temporal-difference (TD) error来给采样赋权重(Sequences associated with rewards appear to be replayed more frequently, Experiences with high magnitude TD error also appear to be replayed more often)。TD error可以看做是surprising或者unexpected的度量。

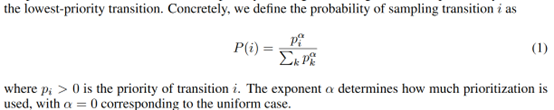

根据TD error定义的priority p计算采样的概率

有了这个之后,作者提出了两个变种,一个是proportional prioritization

直接根据概率采样得到,其中有

\(\epsilon\)是一个很小的正值来保证概率不为0.

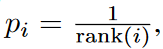

另一个变种是rank-based prioritization,其中

这里rank(i)是根据TD error的绝对值的排序。实现的时候为了加快采样速度,用了sum-tree作为buffer的数据结构。

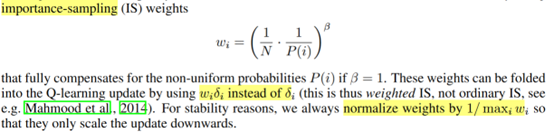

另外,作者用了importance sampling来修正权重

然后这个权重会逐渐衰减,通过控制\(\beta\)从初始值增加到1实现。

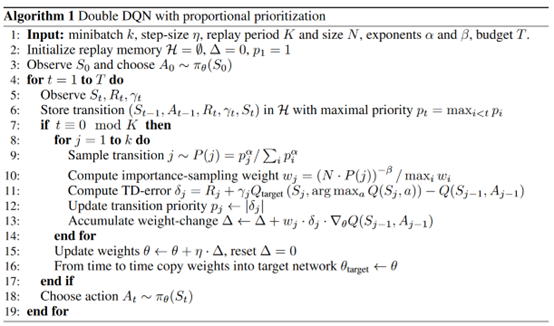

整个算法伪代码如下

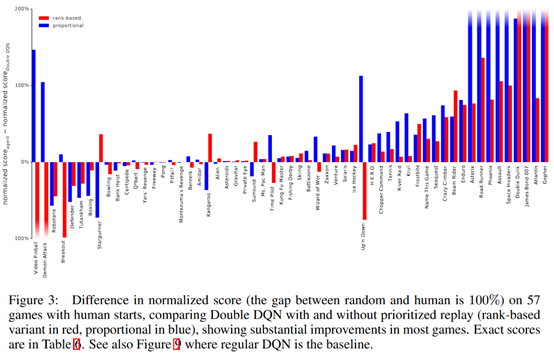

在Atari上表现如下

总结:无。

疑问:无。

浙公网安备 33010602011771号

浙公网安备 33010602011771号