A Study on Overfitting in Deep Reinforcement Learning

发表时间:2018

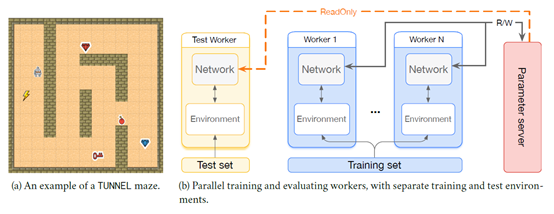

文章要点:这篇文章搞了一个maze的环境来研究RL里面的overfitting问题。把环境也分成train和test,然后来看效果。Train和test就根据初始状态来分的,其实就是agent在迷宫里面的起始位置。先是比较了训练时间,训练集的大小,任务难度这三个因素,结论就是训练太久会overfitting,训练集越大泛化性会更好,任务难度越大泛化性越差。然后通过改变reward的正负号注入随机性,来检测网络的记忆能力,他就是想说就算reward是乱的,RL还是能学到,这就说明RL在训练集上严重overfitting。这个我觉得有点牵强,你把随机性看成是stochastic dynamic transition呢,那RL学到了不是理所当然吗?然后后面还加入一些其他随机性看看作用,如下图

这些随机性有两种用法,第一种就是训练的时候加上,避免overfitting。另一种就是测试的时候加上,看看模型泛化性如何,有没有overfitting。得出的结论就是啥也说明不了,训练的时候加还是不能避免overfitting,测试的时候加也检测不出来在训练集上有没有overfitting(能在测试集上检测出来)。最后还说了一点Inductive Bias的东西,作者想说如果问题和priori很匹配,那效果就好。实验就是分别用MLP和CNN来训,然后说CNN有空间不变性,所以在maze上的泛化性更好。

总结:感觉这些东西不做也能猜到啊,结论也没啥用啊,这个文章的意义在哪?环境也是自己弄了一个很简单的maze,真的能说明什么问题吗?180+的引用,说实在我是不太理解的。

疑问:无。

浙公网安备 33010602011771号

浙公网安备 33010602011771号