LLaMA Factory在window11上运行deepseek进行训练微调准备环境

使用大模型deepseek有两个方式,一般都是两个一起用

第一步使用自有数据进行训练微调,第二步可以使用知识库RAG方式进行部署

目前电脑: 8G显卡4060, 内存32G window11系统

1.准备python环境

使用anaconda软件准备python环境: python10

2.重装nvidia,以防cuda安装后出现问题(可以忽略这一步,如果出现问题再安装)

https://www.nvidia.com/en-us/software/nvidia-app/

3.需要安装cuda

选择cuda版本

安装的cuda版本不能大于系统信息: 这里是12.8 所以需要小于12.8

还需要考虑LLaMA Factory 支持的cuda及pytorch支持的cuda版本, 这里通过这些综合选择了 cuda12.1.1

cuda版本列表: https://developer.nvidia.com/cuda-toolkit-archive

4.准备pytorch环境,下载地址: https://pytorch.org/get-started/locally/

全版本命令地址: https://pytorch.org/get-started/previous-versions/

找到CUDA12.1 可以根据下面命令行试验,我这里测试

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

安装后通过代码

import torch print(torch.cuda.current_device()) print(torch.cuda.get_device_name(0)) print(torch.__version__) print(torch.cuda.is_available()) # 应输出 True,如果是false需要检查环境

5.安装LLaMA Factory,文档地址: https://llamafactory.readthedocs.io/zh-cn/latest/getting_started/installation.html

根据步骤安装即可

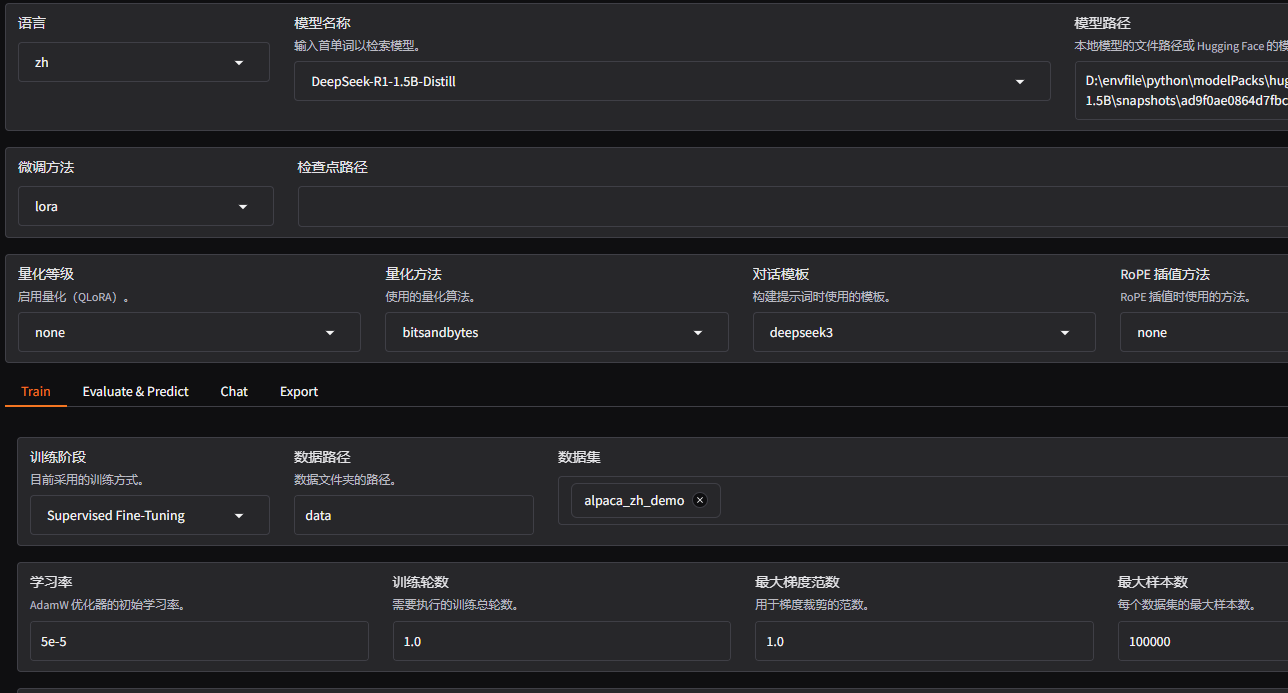

6.准备DeepSeek模型 这里下载的是 deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

这里使用的是huggingface的镜像地址 https://hf-mirror.com/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B 进行下载

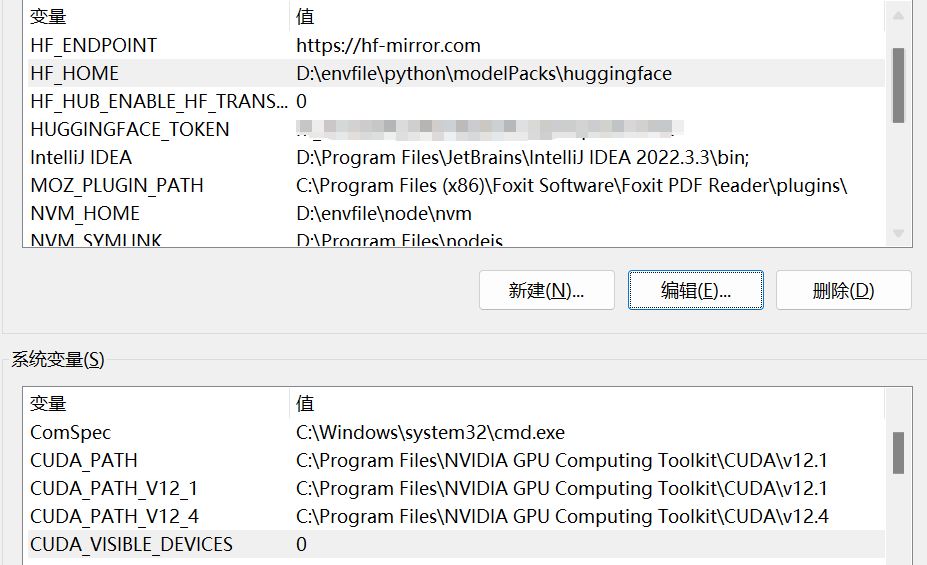

下载前需要设置全局变量: 模型下载地址: HF_HOME 这里根据自己需要修改

方法地址: https://hf-mirror.com/

7.命令行运行llama-factory命令: https://llamafactory.readthedocs.io/zh-cn/latest/getting_started/webui.html

llamafactory-cli webui

剩下训练微调参数自己搜索查找

浙公网安备 33010602011771号

浙公网安备 33010602011771号