扒站工具推荐

背景

网络爬行(也称为网络抓取)在当今的许多领域得到广泛应用。它的目标是从任何网站获取新的或更新的数据并存储数据以便于访问。Web爬虫工具越来越为人所知,因为Web爬虫简化并自动化了整个爬网过程,使每个人都可以轻松访问Web数据资源。使用网络爬虫工具可以让人们免于重复打字或复制粘贴,我们可以期待一个结构良好且包罗万象的数据收集。此外,这些网络爬虫工具使用户能够以有条不紊和快速的方式抓取万维网,而无需编码并将数据转换为符合其需求的各种格式。

在这篇文章中,我将在推荐 3 个网页抓取工具供您参考。您可能会找到最适合您需求的网络爬虫。

推荐程序

- Octoparse–八爪鱼

这个不仅操作简单、功能齐全,还能短时间内获取大量数据。尤其重点推荐Octoparse的云采集功能,给予了高度的赞许。

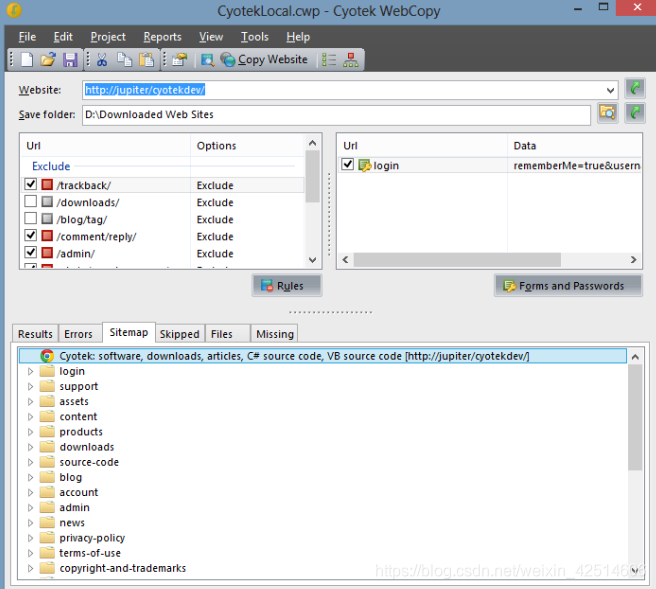

- Cyotek WebCopy

WebCopy是一个免费的网站爬虫,允许您将本地部分或完整的网站复制到您的硬盘上以供离线阅读。

它将扫描指定的网站,然后将网站内容下载到您的硬盘上,并自动重新映射到网站中图像和其他网页等资源的链接,以匹配其本地路径,不包括网站的某个部分。还可以使用其他选项,例如下载要包含在副本中的URL,但不能对其进行爬网。

您可以使用许多设置来配置网站的抓取方式,除了上面提到的规则和表单之外,您还可以配置域别名,用户代理字符串,默认文档等。

但是,WebCopy不包含虚拟DOM或任何形式的JavaScript解析。如果一个网站大量使用JavaScript进行操作,如果由于JavaScript用于动态生成链接而无法发现所有网站,则WebCopy不太可能制作真正的副本。

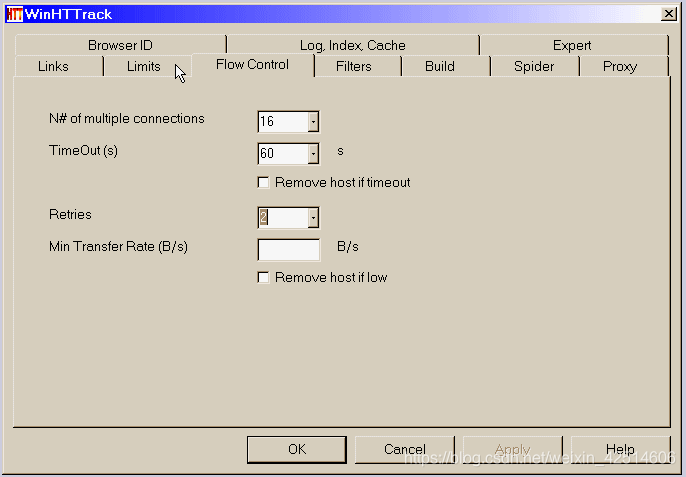

3. Httrack

作为网站爬虫免费软件,HTTrack提供的功能非常适合从互联网下载整个网站到您的PC。它提供了适用于Windows,Linux,Sun Solaris和其他Unix系统的版本。它可以将一个站点或多个站点镜像在一起(使用共享链接)。您可以在“设置选项”下下载网页时决定要同时打开的连接数。您可以从整个目录中获取照片,文件,HTML代码,更新当前镜像的网站并恢复中断的下载。

此外,HTTTrack还提供代理支持,以最大限度地提高速度,并提供可选的身份验证。

HTTrack用作命令行程序,或通过shell用于私有(捕获)或专业(在线Web镜像)使用。 有了这样的说法,HTTrack应该是首选,并且具有高级编程技能的人更多地使用它

小结

总之,我上面提到的爬虫可以满足大多数用户的基本爬行需求,而这些工具中各自的功能仍然存在许多差异,因为这些爬虫工具中的许多都为用户提供了更高级的内置配置工具。因此,请确保在使用之前已完全了解爬虫提供的帮助信息。

作者:叉叉敌

博客:https://chasays.github.io/

微信公众号:Chasays, 欢迎关注一起吹牛逼,也可以加个人微信号「xxd_0225」互吹。

本博客大多为学习笔记或读书笔记,本文如对您有帮助,还请多推荐下此文,如有错误欢迎指正,相互学习,共同进步。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 25岁的心里话

· 按钮权限的设计及实现