一个例子讲明爬虫解析库xpath

对爬取的网页进行数据解析有4中方式:

re正则

bs4

xpath

pyquery

这里着重介绍xpath

一。安装

pip install lxml

二。优点

解析效率比较高

通用性最强的

三。实例

from lxml import etree from random import choice import requests user_agents = [ "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11", "User-Agent:Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; en) Presto/2.8.131 Version/11.11", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36"] headers = { "User-Agent":choice(user_agents) } url="https://www.qidian.com/mm/rank/yuepiao?chn=0" response=requests.get(url,headers=headers) e=etree.HTML(response.text) names=e.xpath('//p[@class="author"]/a[1]/text()') titles=e.xpath('//h4/a/text()') for name,title in zip(names,titles): print(name,':',title)

结果是控制台输出显示解析到的作者和标题

四。说明

response.text 为获取的页面源文件编码

e.xpath() 按xpath语法编写过滤内容

xpath语法,可看了解,很简单的https://www.w3school.com.cn/xpath/xpath_syntax.asp

五。xpath调试工具

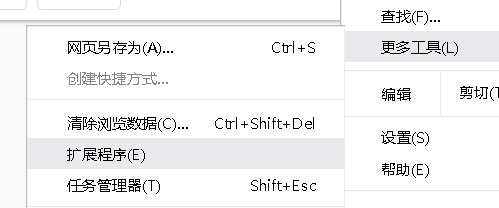

下载

xpath helper插件

将其拖入拓展程序

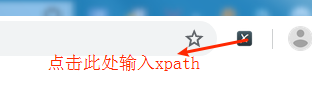

安装完成后

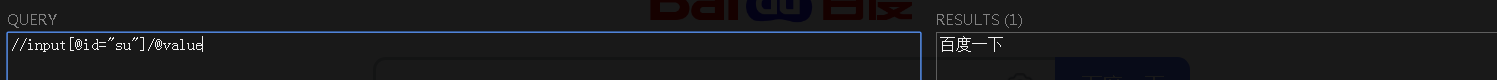

调整窗口如下

bs4