机器学习第四章

思维导图

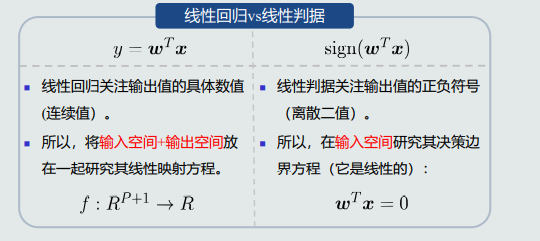

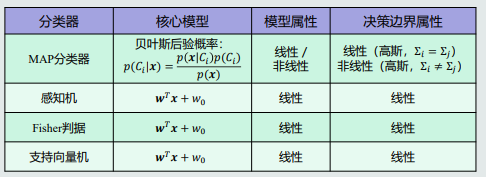

4.1线性判据基本概念

生成模型:直接在输入空间中学习其概率密度p(x)

判别模型:直接在输入空间输出后验概率p(Ci|x)

- 线性判据:如果判别模型f(x)是线性函数,那f(x)为线性判据

- 对于二分类,决策边界是线性;对于多分类,相邻两类的决策边界也是线性

- 计算量少,适用于样本少的情况

- 线性判据模型:f(x) = wTx + w0

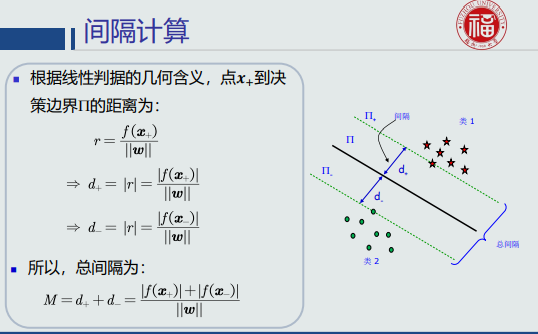

- 任意样本x到决策边界的垂直距离:r = f(x) / ||w||。

4.2线性判据学习概述

监督式学习(训练)过程(学习w和w0)

识别过程

- 解不唯一;

- 参数空间&解域(从解域中找到最优解);

- 设计目标函数 + 约束条件(提高泛化能力)

- 最大/最小化目标函数

- 约束条件

- 使得解域范围收缩

4.3并行感知机算法

-

预处理:参数合一,负类样本取反

-

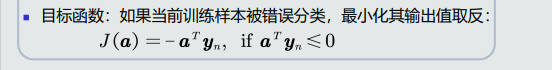

目标函数是被错误分类的所有训练样本的输出取反求和。

-

目标函数求偏导后不含参数w和w0,故使用梯度下降迭代求解最优,需要设置步长、阈值,和初始化w和w0,当目标函数小于阈值或者大于等于0后,停止。

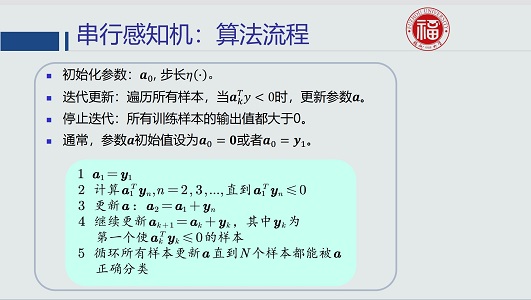

4.4串行感知机算法

-

并行感知机算法一次全部给出训练样本

串行感知机算法一个一个串行给出训练样本

-

思想:当前样本被错误分类的程度最小。

-

目标函数

-

收敛性、全局最优&局部最优

-

感知机变体 b的作用:避免出现a=0的解

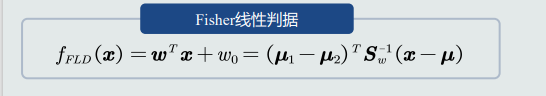

4.5Fisher线性判据

-

原理:找到一个合适的投影轴,使得两类样本在轴上重叠部分最少

类间差异程度尽可能大、类内离散程度尽可能小

-

类间样本用均值差度量、类内样本用协方差矩阵度量

-

存在问题:两类部分样本在决策边界附近犬牙交错

4.6支持向量机基本概念

-

基本思想:给定一组训练样本,两个类与决策边界最近的训练样本到决策边界的间隔最大。

-

间隔

-

支持向量机(SVM):最大化总间隔。

4.7拉格朗日乘数法

- 用于解决条件优化问题

- 等式约束中g(x) = 0的条件,使得λ可正可负,f(x)和g(x)的梯度方向一定平行,但方向可能同向或者反向,且梯度幅值不同。

- 不等式约束分为两种情况:

- 一种是极值点在可行域内,即g(x) < 0,则必有λ=0;

- 一种是极值点落在可行域边界,即λ大于0,故f(x)的梯度方向将和g(x)平行且相反

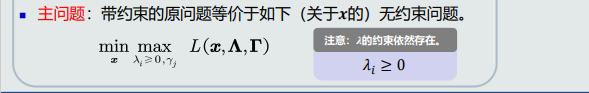

4.8拉格朗日对偶问题

-

不等式约束仍然带有约束条件,如何优化求解?

-

引入主问题,仍然难以求解

-

引入对偶函数,主问题最优值的下界

4.9支持向量机学习算法

- 带不等式约束的优化问题使用拉格朗日对偶法求解

- 构造拉格朗日函数、构建对偶函数、对偶问题的求解(二次规划问题、参数最优解w、w0)

- 支持向量机分类器

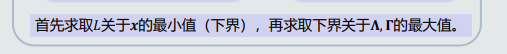

4.10软间隔支持向量机

-

软间隔:克服过拟合

-

允许在一定程度上,让训练样本出现在间隔区域内

-

引入松弛变量

松弛变量的大小决定了错误分类的程度

-

引入正则系数

-

构建拉格朗日函数、对偶函数(在极值点得到)、求解参数w和w0最优解

4.11线性判据多类分类

-

多类分类的本质:非线性

多个模型(线性/非线性)组合成非线性决策边界

-

策略

- One-to-all: 假设每个类与剩余类可分

- K个类、K-1个分类器

- 正负样本个数不均衡?存在混淆区域问题?

- 线性机: 假设每个类与剩余类线性可分。

- 使用输出值投票法(max函数)给定测试样本𝒙,其属于所有分类器中输出值最大的那个类。

- 可能出现测试样本出现在拒绝区域?

- One-to-one:每个类与剩余类可能线性不可分

- K(K-1)/2个分类器

- 标签识别法:利用每一类的权重𝒘向量决定该类与剩余类之间的决策边界

- 会出现拒绝选项?

- One-to-all: 假设每个类与剩余类可分

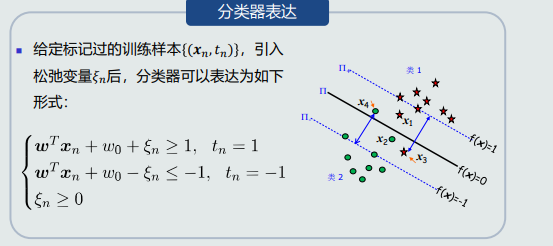

4.12线性回归

-

输入&输出

-

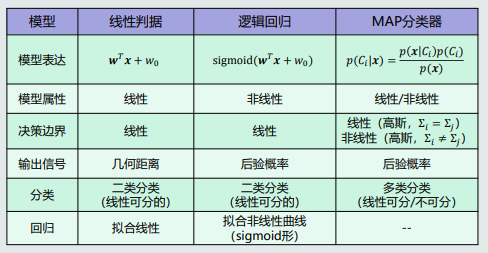

线性回归VS线性判据

-

线性回归模型如何学习:学习参数w、目标函数(最小化均方差)、优化目标(对参数求偏导)(梯度下降更新迭代or最小二乘法得封闭解)

-

概率解释

4.13逻辑回归的概念

-

线性模型如何改进为非线性模型?

-

回顾:MAP分类器

-

Logit变换:𝐶1类的后验概率与𝐶2类的后验概率之间的对数比率

Sigmoid函数:连接线性模型和后验概率的桥梁

线性模型𝑓(𝒙) + Sigmoid函数 = 后验概率

-

逻辑回归:线性模型𝑓(𝒙) + sigmoid函数。

-

适用范围:

- 分类(狭义/广义)(前提:两类线性可分)

- 回归(可拟合Sigmoid形式的非线性曲线)

4.14逻辑回归的学习

-

学习参数w和w0

-

训练样本(真值取值方式和SVM不一样)

正类(𝐶1类)样本的输出真值𝑡𝑛 = 1

负类(𝐶2类)样本的输出真值𝑡𝑛 = 0

-

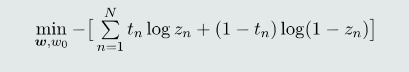

目标函数—最大似然估计法( 给定单个输入样本𝒙,模型输出的类别标签𝑙可以看做一个随机变量 )—交叉熵

-

优化目标函数

- 梯度下降法(有需要注意的问题:梯度消失问题(可通过选择较小初始化参数w来避免))

- 达到一定训练精度,提前停止迭代,可以避免过拟合

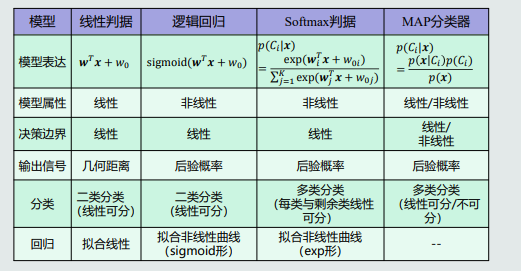

4.15Softmax判据的概念

-

逻辑回归输出:属于正类的后验概率

那么多类?每类的后验概率如何表达?

-

后验概率的多类情况:一个类与剩余类的后验概率比率

-

逻辑回归是由Logit变换反推出来的;由Logit变换可知:正负类后验概率比率的对数是一个线性函数

-

分类𝐾个类,可以构建𝐾个线性判据。第𝑖个线性判据表示𝐶𝑖类与剩余类的分类边界,剩余类用一个参考负类(reference class) 𝐶𝐾来表达。

-

对于多类分类,K个线性模型也跟每个类对应的后验概率建立起了联系

-

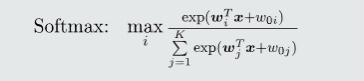

Softmax判据:𝐾个线性判据 + softmax函数

4.16Softmax判据的学习

- Softmax判据需要学习K组参数{wi,w0}

4.17核支持向量机(Kernel SVM)

- 以SVM为基础是否可实现非线性分类边界?

- 思想: 如果样本在原始特征空间(𝑋空间)线性不可分,可以将这些样本通过一个函数𝜑映射到一个高维的特征空间(Φ空间),使得在这个高维空间,这些样本拥有一个线性分类边界。

- 核函数:在低维空间的一个非线性函数,包含向量映射和点积计算

-

核函数条件:Mercer条件

-

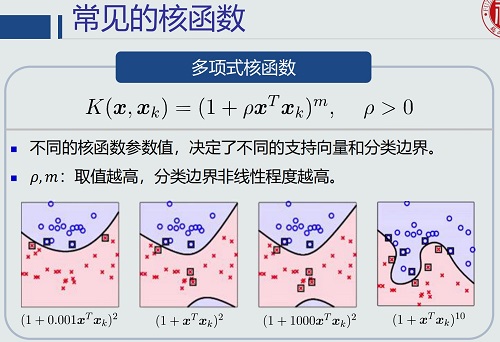

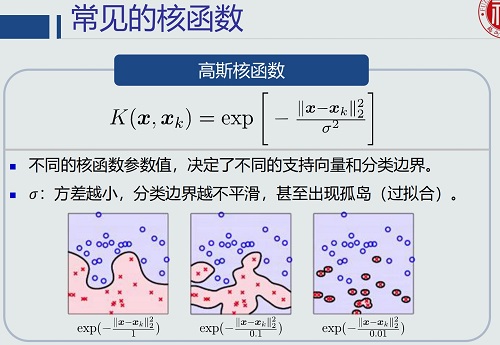

常见核函数

-

多项式核函数

-

高斯核函数

-

-

核函数的优缺点

-