hadoop集群搭建(hadoop-2.10.0)

2020双十 阿里云服务器ECS团购特惠链接

一、系统配置

3台虚拟机

hadoop1: 4g内存 2核 80g硬盘 作为master节点

hadoop2 1g内存 1核 8g硬盘 作为slave节点

hadoop3: 1g内存 1核 8g硬盘 作为slave节点

二、基础概念

hadoop主要包含了3个组件:存储组件hdfs、资源调度引擎yarn、计算引擎MapReduce.

1、hdfs集群

NameNode: 资源存储目录,负责维护整个HDFS文件系统的目录树以及每一个路径(文件)对应的block块信息

DataNode: 资源实际存储位置

2、yarn集群

ResourceManage: 负责资源的分配与调度

NodeManager: 负责接收 ResourceManager的资源分配请求,分配具体的资源给应用

三、hadoop集群搭建

1、下载安装包到hadoop1节点的/usr/local/softwareinstall目录

curl -O https://mirrors.ocf.berkeley.edu/apache/hadoop/common/hadoop-2.10.0/hadoop-2.10.0.tar.gz

2、远程传输到hadoop2、hadoop3节点同目录下

scp hadoop-2.10.0.tar.gz root@hadoop2:`pwd`

scp hadoop-2.10.0.tar.gz root@hadoop3:`pwd`

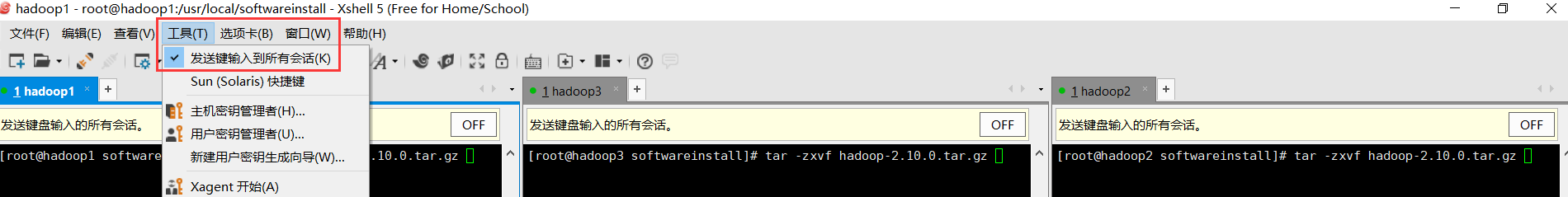

3、解压安装包(3台节点同时操作)

tar -zxvf hadoop-2.10.0.tar.gz

4、添加hadoop环境变量

vim /etc/profile

添加如下配置

export HADOOP_HOME=/usr/local/softwareinstall/hadoop-2.10.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile #使修改生效

5、修改配置文件(/usr/local/softwareinstall/hadoop-2.10.0/etc/hadoop/目录下的文件)

(1)core-site.xml

添加如下配置

<configuration>

<!--The name of the default file system-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop1:9003</value>

</property>

<!--修改用于hadoop存储数据的默认位置-->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop</value>

</property>

</configuration>

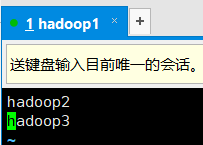

(2)slaves文件

避免节点过多时,需要手工重复进行dataNode/NodeManager的启动,

编辑该文件后,只需要在master节点上操作即可启动集群。

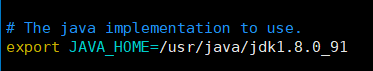

(3)hadoop-env.sh

告知hadoop jdk安装目录所在

(4)mapred-site.xml (map-reduce相关配置)

拷贝mapred-site.xml.template文件,命名为mapred-site.xml,添加如下配置

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

(5)yarn-site.xml

<configuration>

<!-- 设置ResourceManager 域名 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

6、启动集群(hdfs集群和yarn集群)

只需在master节点(hadoop1)上操作即可(前提:需配置ssh免密登录,使hadoop1能够免密登录到hadoop2、hadoop3),

6.1 启动hdfs集群

hdfs namenode -format #格式化hdfs文件系统

start-dfs.sh #启动hdfs集群

stop-dfs.sh #停止hdfs集群

(start-dfs.s为安装目录sbin文件下的可执行文件,因为已配置环境变量,故可不带就对路径)

6.2 启动yarn集群

start-yarn.sh #启动yarn集群

stop-yarn.sh #停止yarnjiqun

6.3 进程验证

可用start-all.sh一次性启动hdfs、yarn集群

7、ui界面登陆

7.1 hdfs集群管理 ui界面

7.2 yarn集群管理ui界面

参考:

(1)hadoop单节点安装官方教程

(4)hadoop集群安装官方教程

(2)core-site.xml配置项含义

(3)hdfs-site.xml配置项含义

(4)mapred-site.xml配置项含义

(5)yarn-site.xml配置项含义