kafka集群安装与配置

1、下载kafka安装包kafka_2.11-0.11.0.2.tgz到集群的某台节点上(hadoop1)

curl -O https://archive.apache.org/dist/kafka/0.11.0.2/kafka_2.11-0.11.0.2.tgz

2、将安装包远程传输到节点hadoop2、hadoop3上

scp -r kafka_2.11-0.11.0.2.tgz root@hadoop2:`pwd`

scp -r kafka_2.11-0.11.0.2.tgz root@hadoop3:`pwd`

3、解压安装包

tar -zxvf kafka_2.11-0.11.0.2.tgz

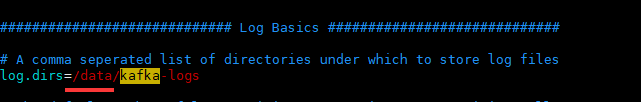

4、修改“xxx安装目录/kafka_2.11-0.11.0.2/config/”目录下的server.properties文件

主要修改broker.id、log.dirs、zookeeper.connect 3项

broker.id:集群中broker节点编号,需有1台设置的值为0;

log.dirs:日志消息存储目录,3个节点设置的值相同

zookeeper.connect:zookeeper集群地址

5、启动kafka(需先启动zk集群)

(1)启动kafka

> /bin/kafka-server-start.sh /config/server.properties

(2)停止kafka

> bin/kafka-server-stop.sh

(3)创建topic

>bin/kafka-topics.sh --create --zookeeper hadoop1:2181,hadoop2:2181,hadoop3:2181 --replication-factor 1 --partitions 1 --topic test

更多操作,参考官方文档

附录

一、kafka开机自启动配置

1、cd /etc/init.d

2、vim kfk,编辑如下内容

#!/bin/bash

#chkconfig:2345 60 20

#description:kafka

export JAVA_HOME=/usr/java/jdk1.8.0_172

KAFKA_HOME=/usr/local/softwareinstall/kafka_2.11-0.11.0.2

case $1 in

start) su root ${KAFKA_HOME}/bin/kafka-server-start.sh ${KAFKA_HOME}/config/server.properties;;

stop) su root ${KAFKA_HOME}/bin/kafka-server-stop.sh;;

*) echo "require start|stop" ;;

esac

注:

3、chmod +x kfk

给所有用户,赋予kfk文件的权限,便于系统启动时,具有权限执行kfk脚本

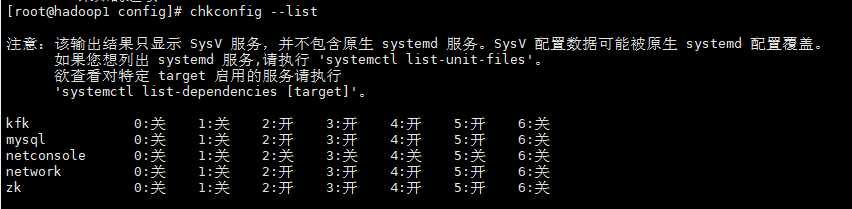

4、chkconfig --add kfk

添加kafka启动脚本kfk到开机自启动的脚本列表

chkconfig --list,可查看开机自启动脚本

5、启动/停止kafka

service kfk start 启动kafka

service kfk stop 停止kafka