安装centOS后要解决的问题

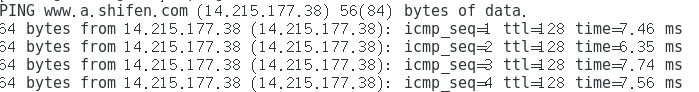

1,检查是否联网

ping www.baidu.com

未显示:

则表示网络未连接

首先关闭防火墙

sudo systemctl stop firewalld.service #停止firewall

sudo systemctl disable firewalld.service #禁止firewall开机启动

其次

cd /etc/sysconfig/network-scripts/

ls

sudo vi ifcfg-ens33

修改

noboot=no 为 noboot=yes

:wq! 退出

再检查网络

ping www.baidu.com

已解决

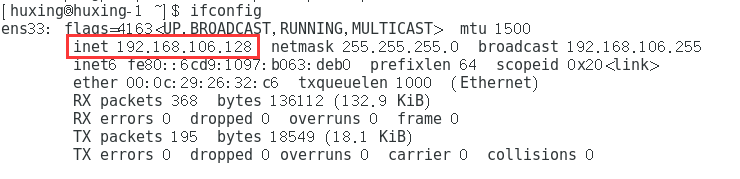

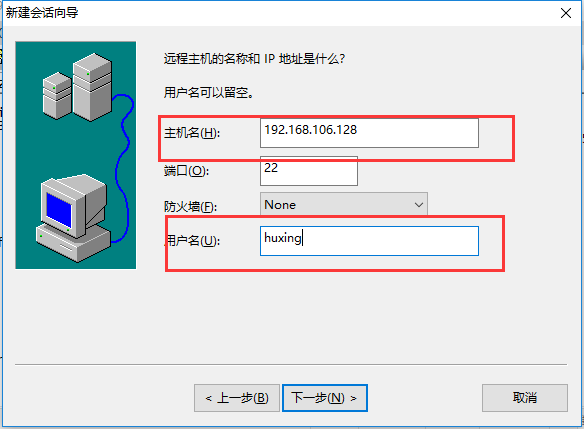

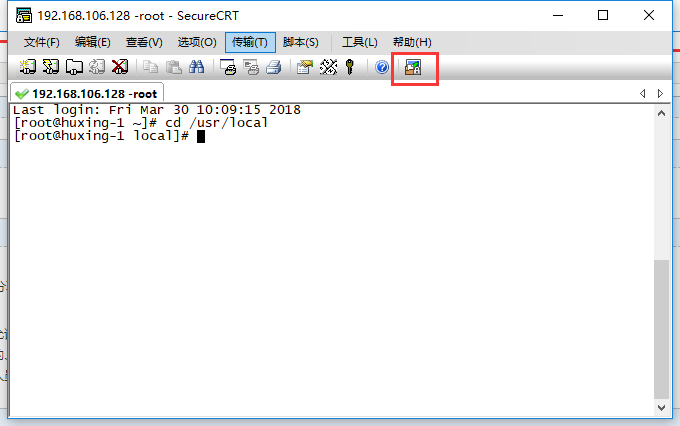

2,下载secureCRT(百度云中有),链接xshell

ifconfig

ip为:192.168.106.128

完成

如果要新建一个root用户远程链接,则用户名使用 root,密码使用root用户的密码。

关于xshell中文乱码的问题:

可以在选项中设置

3,搭建伪分布式 hadoop (集群环境在另一篇中)

3.1

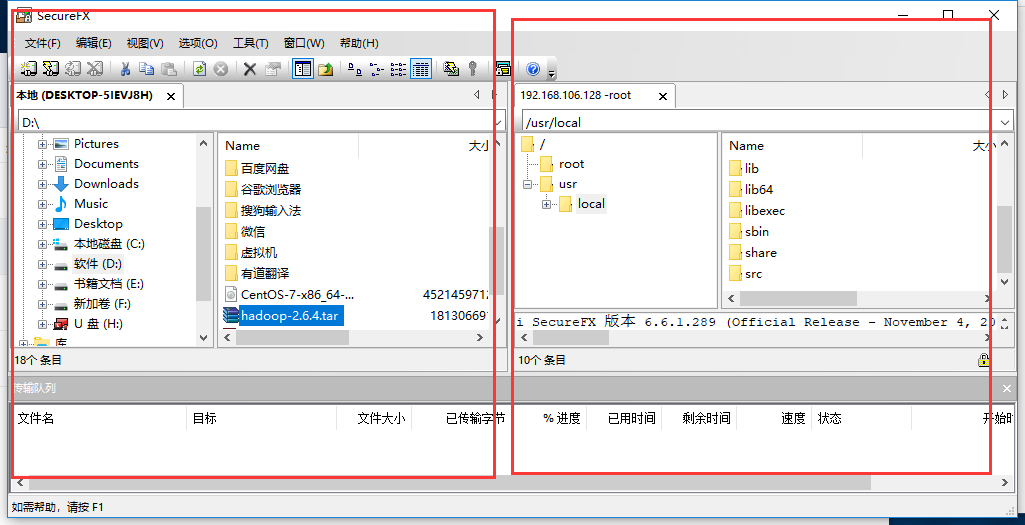

将下载的hadoop tar包通过ftp上传到linux中的 /usr/local 目录下

解压:

cd /usr/local 目录下解压

tar zxvf hadoop-2.6.4.tar.gz

3.2

设置主机名和IP之间的映射:

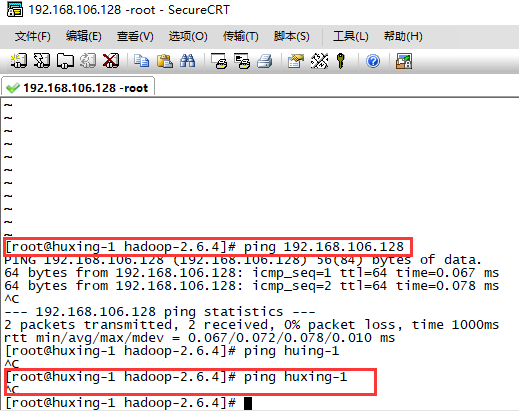

如图可以看出 ping ip 可以ping 通,但是ping 主机名没有反应

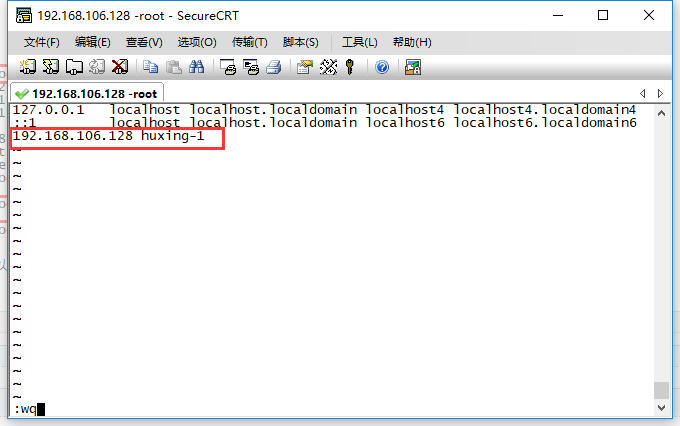

vi /etc/hosts

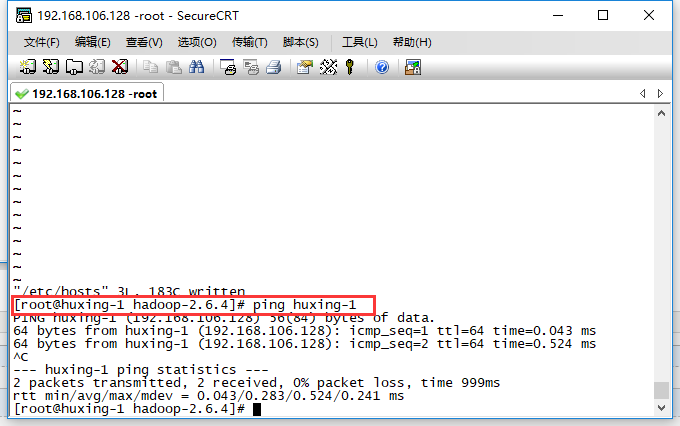

如下图 此时再ping 主机名可以ping通

3.3

配置java环境

下载jdk的tar包 (百度云中有)

和上面一样传到/usr/local目录中

解压

tar zxvf jdk-8u91-linux-x64.tar.gz

cd jdk1.7.0_79/ pwd

复制产生的目录

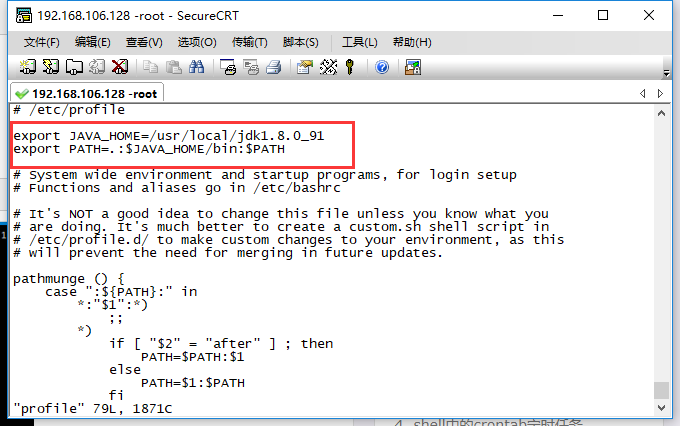

vi /etc/profile

文件中插入:

重启source文件

source /etc/profile

然后

java -version

出现如下信息则正常安装

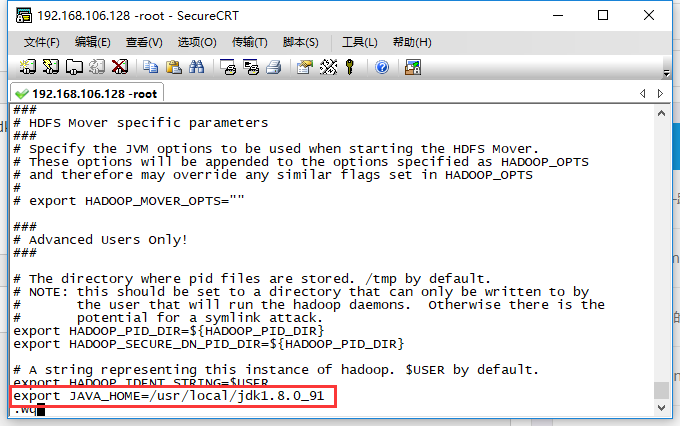

切到如下图目录中,可能会因为你下载的Hadoop版本不同而导致目录中的版本号不同,改一下就好

cd /usr/local/hadoop-2.6.4/etc/hadoop

编辑

vi hadoop-env.sh

加入一行 export JAVA_HOME=/usr/local/jdk1.8.0_91

3.4

编辑

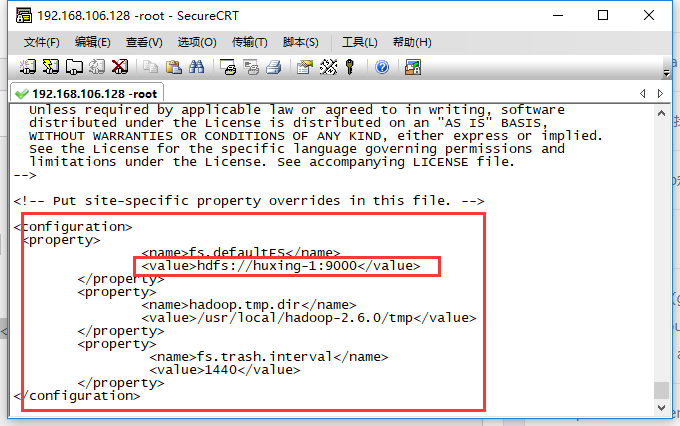

vi core-site.xml

向其中插入下列代码 (不包括configuration)

(记得将文中的*****改成你的主机名)

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://xxxxxx:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.6.0/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

</configuration>

复制代码

3.4

编辑

vi yarn-site.xml

插入 同上不包括configuration

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

</configuration>

3.5

编辑

vi hdfs-site.xml

在其中插入:(同上不包括configuration)

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

3.6

文件重命名

mv mapred-site.xml.template mapred-site.xml

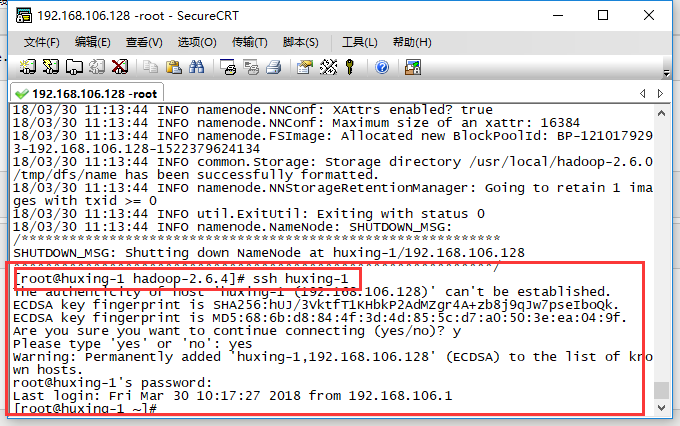

3.7

启动格式化

cd /usr/local/hadoop-2.6.4

bin/hdfs namenode -format

3.8

ssh免密登录

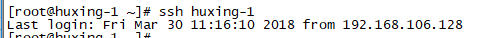

检查是否可以免密

ssh 主机名

不可以,则需要设置

sudo yum -y install openssh-server

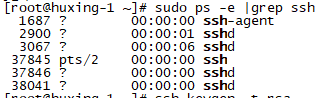

打开"终端窗口",输入"sudo ps -e |grep ssh"-->回车-->有sshd,说明ssh服务已经启动,如果没有启动,输入"sudo service ssh start"-->回车-->ssh服务就会启动

ssh-keygen -t rsa

按三次回车就行

ssh-copy-id -i ***主机名

再检查是否可以免密

解决

4,登录

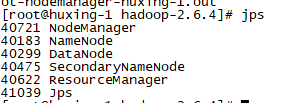

sbin/start-all.sh // 要在/usr/local/hadoop-2.6.4/ 目录下启动

jps

成功

关闭的命令是

sbin/stop-all.sh

--------------------------------------

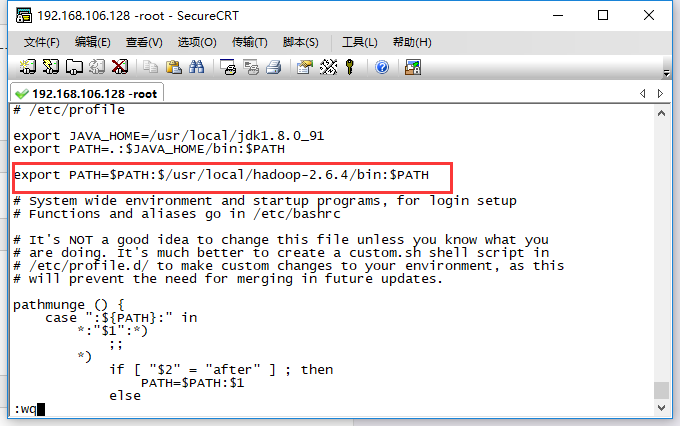

最后将hadoop的path加到系统配置文件中,否则执行命令时会报错

vi /etc/profile

export PATH=$PATH:$/usr/local/hadoop-2.6.4/bin:$PATH

重启source文件

source /etc/profile

另外 ,这是hadoop 伪分布式安装的过程,意思就是说只有一个Hadoop服务器的时候,而Hadoop的集群模式的安装,如果是三个节点的话,就只需要再搭建另外俩个节点,然后将这三个节点联系起来,建立一个集群就行,也很容易,可以在我的博客中找Hadoop集群的那篇文章就行。