Ubuntu下hadoop集群搭建

--修改IP地址(克隆镜像后可修改可不修改)

http://jingyan.baidu.com/article/e5c39bf5bbe0e739d7603396.html

-----------------------------

--修改主机名:

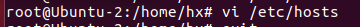

--修改主机名和IP的映射关系:

--检查是否ping得通主机名:

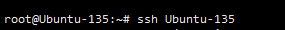

--检查ssh是否可以免密登录:

如果不可以免密登录,则:

sudo apt-get update sudo apt-get install openssh-server sudo ps -e |grep ssh ssh-keygen -t rsa ssh-copy-id -i ***主机名

可以免密登录,就不用再输入密码

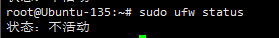

--检查防火墙: 该命令仅限于Ubuntu使用

该命令仅限于Ubuntu使用

--查看java情况:

java -version

--将主节点的profile文件拷贝到另外两个从节点上(这样可以节约许多配置的时间):

scp /etc/profile/ 192.168.22.132:/etc/profile scp /etc/profile/ 192.168.22.135:/etc/profile

--将主节点上的jdk拷贝到另外两个从节点上:

/usr/local# scp -r jdk1.7.0_79/ 192.168.22.132:/usr/local /usr/local# scp -r jdk1.7.0_79/ 192.168.22.135:/usr/local

--在两个从节点中source一下配置文件才能生效:

source /etc/profile

--在主节点上修改/etc/hosts文件

在内容中有如下

192.168.2.xxx node1

192.168.2.xxx node2

192.168.2.xxx node3

在主节点上执行ping node2或者ping node3不报错

--在主节点上执行,将主节点的秘钥拷贝到另外两个从节点上:

ssh-copy-id -i Ubuntu-2 ssh-copy-id -i Ubuntu-135

在另外两个节点上也要执行,这样集群之间就能互相免密登录了

--在主节点上执行:

scp /etc/hosts Ubuntu-2:/etc scp /etc/hosts Ubuntu-135:/etc

--这里需要在主节点上把单节点的伪分布安装成功,详细步骤之前的博客中有,如果在之前部署单节点的伪分布安装时,进行了格式化,则需要将tmp文件删除

root@Ubuntu-1:/usr/local/hadoop-2.6.0# ls bin etc include lib libexec LICENSE.txt logs NOTICE.txt README.txt sbin share tmp root@Ubuntu-1:/usr/local/hadoop-2.6.0# rm -r tmp/ root@Ubuntu-1:/usr/local/hadoop-2.6.0# ls bin etc include lib libexec LICENSE.txt logs NOTICE.txt README.txt sbin share

--在主节点上执行:

root@Ubuntu-1:/usr/local/hadoop-2.6.0/etc/hadoop# vi slaves

把文件中的所有信息都删了,在slaves文件中加入如下信息:Ubuntu-1

Ubuntu-2

Ubuntu-135

--将主节点中的Hadoop文件拷到另外两个从节点中:

root@Ubuntu-1:/usr/local# scp -r hadoop-2.6.0 Ubuntu-2:/usr/local root@Ubuntu-1:/usr/local# scp -r hadoop-2.6.0 Ubuntu135:/usr/local

--在node1中执行格式化命令 bin/hdfs namenode -format

--在node1中执行启动命令 sbin/start-all.sh

浙公网安备 33010602011771号

浙公网安备 33010602011771号