根据之前的操作,我们已经可以正常的启动Hadoop了,关于真正的集群我会在之后进行说明。现在我们来看一下第一个程序吧

1. 在eclipse上建立一个java项目

2. 将 /usr/hadoop/share/hadoop/common/hadoop-common-2.2.0.jar 文件导入到项目中

3. 将 /usr/hadoop/share/hadoop/common/lib/commons-logging-1.1.1.jar 文件导入到项目中

4. 编写代码如下

import java.io.IOException; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FSDataOutputStream; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class DFSOperator { /** * @param args */ public static void main(String[] args) { Configuration conf = new Configuration(); try { FileSystem fs = FileSystem.get(conf); Path f = new Path("hdfs:///dfs_operator.txt"); FSDataOutputStream s = fs.create(f, true); int i = 0; for (i = 0; i < 100000; ++i) s.writeChars("test"); s.close(); } catch (IOException e) { e.printStackTrace(); } } }

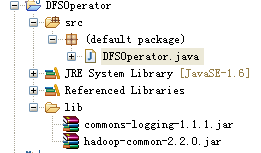

5. 项目抓图

6. 将项目导出成为Jar包 dfsOperator.jar ,可以在如下地址下载

http://pan.baidu.com/share/link?shareid=3076182544&uk=2517512140

7. 将Jar包传输到Linux系统中,然后使用如下方法执行

7.1 查看是否存在dfs_operator.txt文件,如果存在需要先删除掉

hadoop fs -ls /

注明:如果要删除文件可以用如下命令 hadoop fs -rm /dfs_operator.txt

7.2 运行命令生成dfs_operator.txt文件

hadoop jar dfsOperator.jar DFSOperator

7.3 运行7.1的命令查看运行效果,如果增加了dfs_operator.txt文件,证明运行成功