最小二乘法模型的推导原理

一、线性回归

在统计学中,线性回归(Linear Regression)是利用称为线性回归方程的最小平方函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合。

回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。

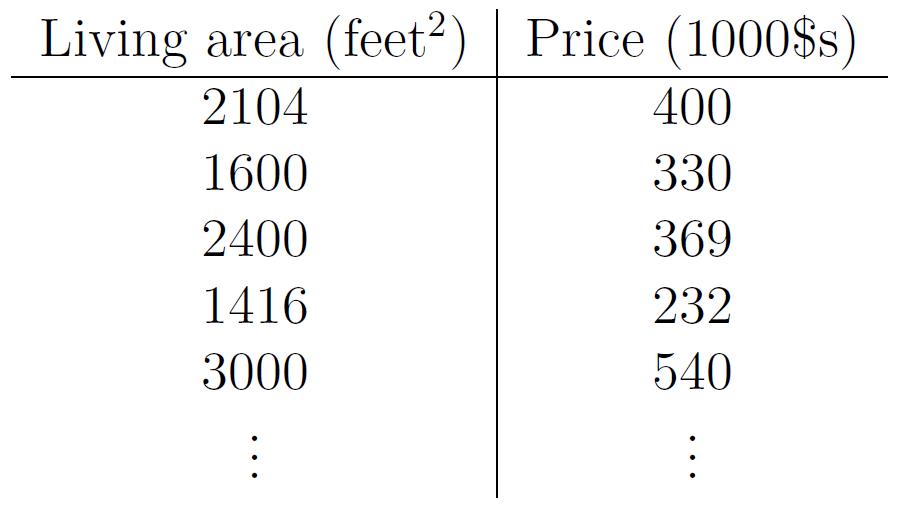

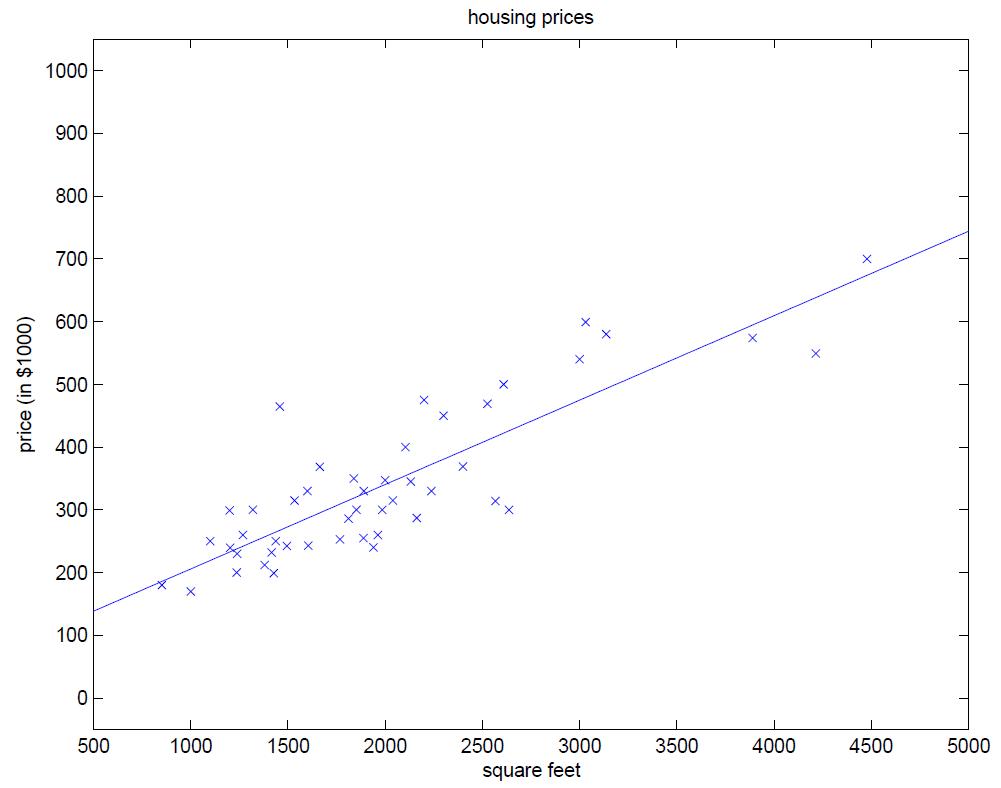

下面我们来举例何为一元线性回归分析,图1为某地区的房屋面积(feet)与价格($)的一个数据集,在该数据集中,只有一个自变量面积(feet),和一个因变量价格($),所以我们可以将数据集呈现在二维空间上,如图2所示。利用该数据集,我们的目的是训练一个线性方程,无限逼近所有数据点,然后利用该方程与给定的某一自变量(本例中为面积),可以预测因变量(本例中为房价)。本例中,训练所得的线性方程如图3所示。

图1、房价与面积对应数据集

图2、二维空间上的房价与面积对应图

图3、线性逼近

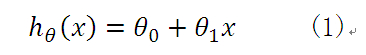

同时,分析得到的线性方程为:

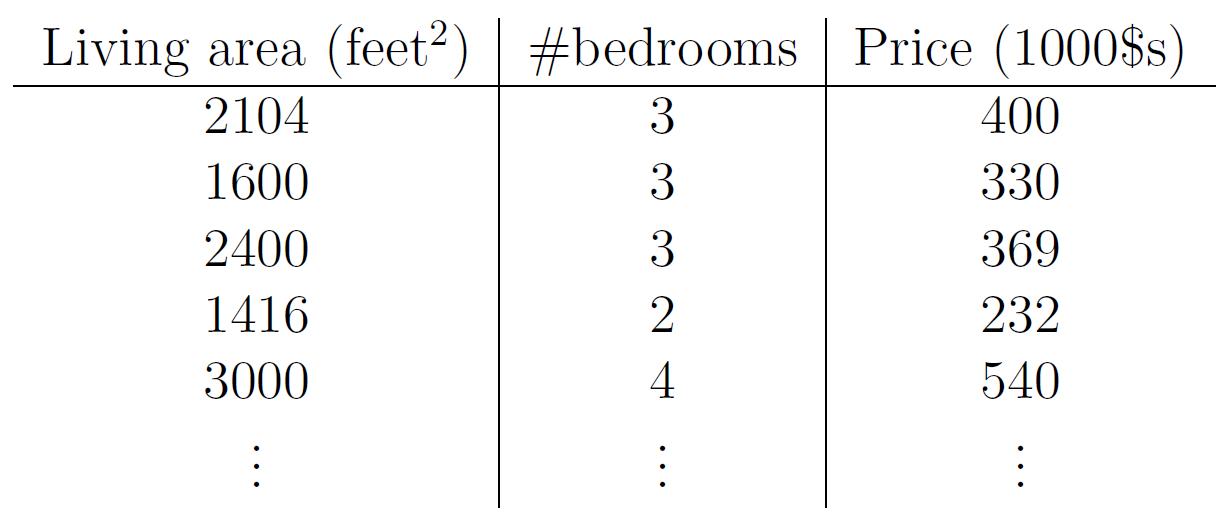

接下来还是该案例,举一个多元线性回归的例子。如果增添了一个自变量:房间数,那么数据集可以如下所示:

图4、房价与面积、房间数对应数据集

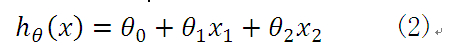

那么,分析得到的线性方程应如下所示:

因此,无论是一元线性方程还是多元线性方程,可统一写成如下的格式:

上式中x0=1,而求线性方程则演变成了求方程的参数ΘT。

线性回归假设特征和结果满足线性关系。其实线性关系的表达能力非常强大,每个特征对结果的影响强弱可以有前面的参数体现,而且每个特征变量可以首先映射到一个函数,然后再参与线性计算,这样就可以表达特征与结果之间的非线性关系。

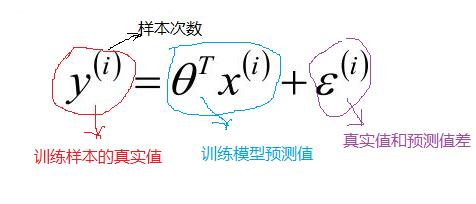

二、真实值、预测值、误差:

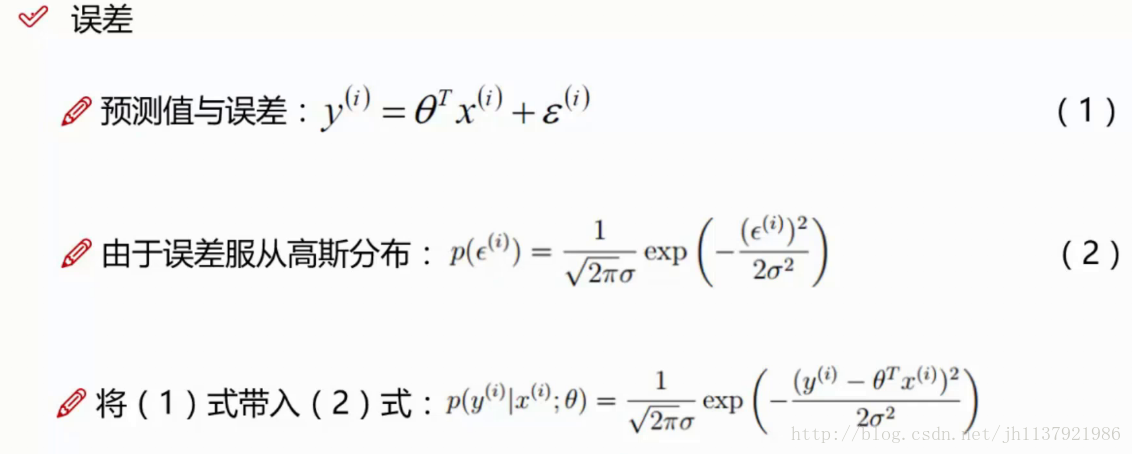

对误差的深入理解:

[假设]:误差 ε 是独立同分布的,并且服从均值为0方差为θ^2的高斯分布,

误差特点:

1.误差指的是实际值与预测值之间的差值

2.独立:张三和李四一起来贷款,他俩没关系。

3.同分布:张三和李四都是我们张三和李四都来的是我们假定的这家银行来贷款

4.高斯分布:银行可能会多贷款,也可能少贷款,但是绝大多数情况下,这个贷款的差额的浮动不会太大(这里所说的的多贷款,少贷款是银行实际贷款和预测贷款之间的差别)

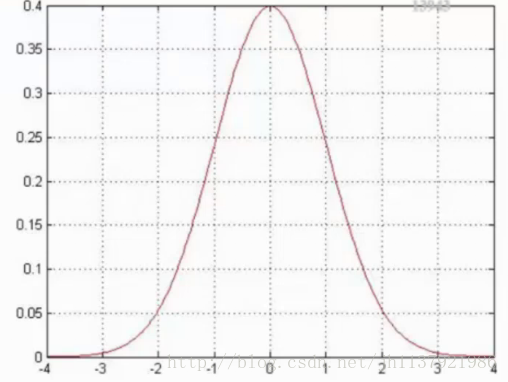

下面展示高斯分布(正态分布)的图像:

根据图型对误差的深入理解: 高斯分布的积分为1,所以可以把闭区间的面积看作概率,中间区域的面积最大,说明值落在中间的概率大,由图可知,有大概率的点是落在x=0附近的,高斯分布的纵坐标无实际意义,纵坐标的值与方差θ的平方有关,θ越大,表示样本的震荡幅度越大(不会密集的分布在0附近),那么图像就越矮,纵坐标越小。

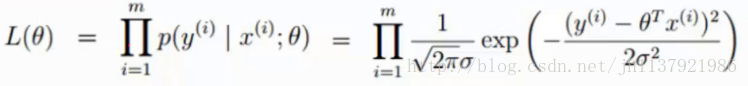

三、似然函数

目的:计算出什么样的参数θ和我们的数据(x,y)组合之后,能满足我们的真实值(根据数据来猜测结果)

形象理解:比如说我们掷硬币,掷了十次,结果是九次正面朝上,一次反面朝上,那么认为下一次正面朝上的概率θ就是90%;

似然函数就是用结果(或样本)(9正,1负的数据)来推算参数(weight权重、概率),也就是说通过参数θ得到的预测的算法,能够尽可能地拟合样本数据(已知结果),从而最大化的使得预测结果更偏向于真实数据。

似然函数说白了就是结果导向,由已知结果来推算出预测参数θ,因为结果已经发生了,那么概率p(y|x;θ)肯定是取最大的!

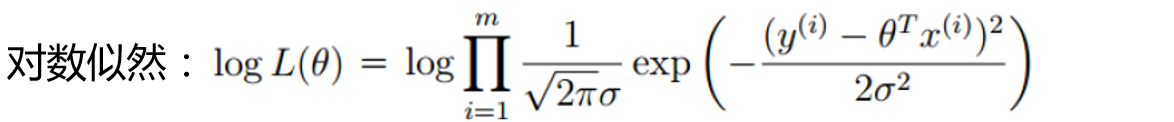

这里的似然函数是怎么来的:

(1)式是已知的,(2)式我们假设的,那么将(1)代入(2),就可以得到一个新的关于参数θ的函数,这就是一个似然函数。

注:前面的括号里面的参数,经查阅资料,分号前面的表示已知量、确定值,分号后面的是自变量,所以似然函数就是一个关于θ的函数,所以可以简写成L(θ)

但是似然函数的累乘的,乘法比较难算,我们可以引入对数,进行累加:

四、最小二乘法

根据上面的对数似然函数,我们可以进行化简从而得到最小二乘法:

五、计算最小二乘法(得到参数取何值时候,真实值和预测值越接近)

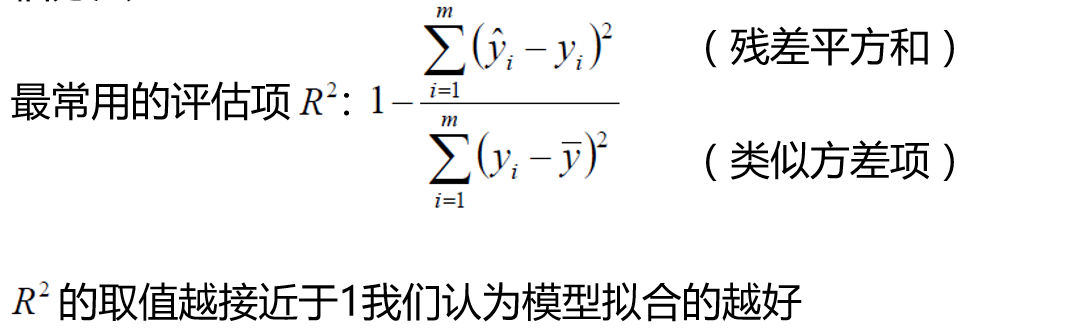

六:评估方法(对我们模拟的模型进行评估)

总结:以上就是通过线性回归思想建立最小二乘法模型

浙公网安备 33010602011771号

浙公网安备 33010602011771号