Hugging News #0703: 在浏览器中运行 Whisper 模型、WAIC 分论坛活动邀请报名

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」,本期 Hugging News 有哪些有趣的消息,快来看看吧!

重要更新

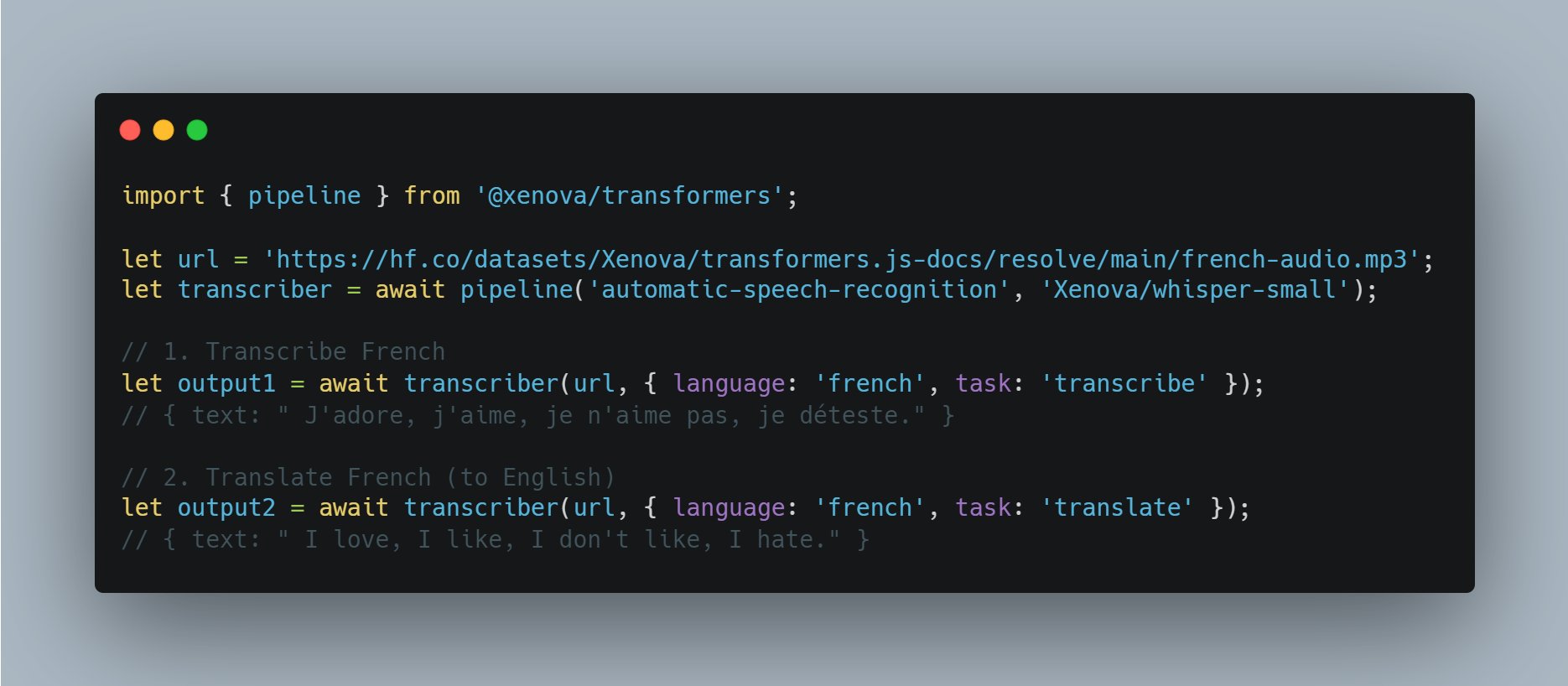

Whisper Web:在你的浏览器中运行语音识别

作为 Transformers.js v2.2.0 的示例应用,我们发布了一个名为 Whisper Web 的网页应用,它支持了 100 多种不同语言的转录和翻译,并支持切换模型、语言和任务。其代码是开源的,只需要几行代码即可运行。

在线体验:

开源更新

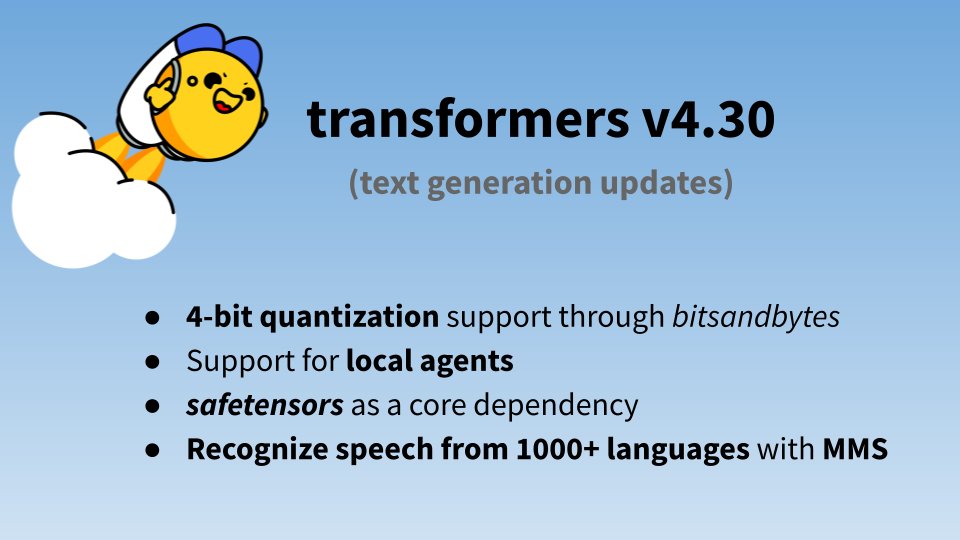

Transformers v4.30 发布: 在更小的设备上运行大语言模型

Transformers 的 4.30 版本已经发布了,其中的 4-bit 量化是这次更新的亮点。4-bit 量化是一种降低深度学习模型大小和运算复杂度的技术。一般来说,深度学习模型中的参数是以 32-bit 浮点数(也就是我们常说的float)来表示的。每个这样的浮点数都需要 32 个 bit 的存储空间。然而,对于大多数的应用场景来说,我们并不需要这么高的精度。因此,我们可以通过量化技术将 32-bit 的浮点数转换为更低 bit 的表示,比如 4-bit,从而极大地降低模型的大小,加快模型运算速度,降低能耗。通过将模型转换为 4-bit 格式,使得模型的大小减小,从而可以在更小的设备上运行,比如只有 24GB 的 GPU 上就能运行一个 30B 的模型。而这在之前是不可能做到的。使用这个功能非常简单,只需要在 .from_pretrained() 加载函数中添加 load_in_4bit=True 即可,这将使你的模型在推理和训练时更加节省资源。

除此之外,这个版本还加入了在本地运行的 transformers agents、为了使 transformers 模型更加安全,将 safetensors 作为默认的序列化解决方案以及将 Meta 的 MMS 工作加入到 transformers 库中等。查阅详细的更新内容,请参与如下链接在 GitHub 上阅读:

Transformers 正式使用 Accelerate 作为其 PyTorch 后端

在长期的使用中,我们发现 transformers 在不同设备上以及做分布式的训练时,其中有大量重复的代码,这并不是很 🦫,而 accelerate 库正好就是做这些的,所以我们决定将 Trainer 转换为使用这个库。我们尽量保持向后兼容,以确保用户不会有太大感知,如果你一直在只用 Trainer 写分布式训练的代码则不需要做任何改动,但有一点需要注意,为了得到更好的性能,建议未来你可以选择使用最新版本的 accelerate 库。

与你在 WAIC 活动中相遇

世界人工智能大会(WAIC)是国家发展和改革委员会、工业和信息化部、科学技术部、国家互联网信息办公室、中国科学院、中国工程院、中国科学技术协会和上海市人民政府共同主办的一个人工智能盛会,自 18 年开始至今已经成功举办五届。今年的 WAIC 将于 2023 年 7 月 6 日 — 8 日在上海举办。

WAIC - AIGC 时代下的青年开发者人才培养论坛

欢迎来参加由 Hugging Face 中国负责人 Tiezhen 出席的 WAIC - AIGC 时代下的青年开发者人才培养论坛,2023 年 7 月 8 日 9:00-12:00,在上海世博展览馆 - X 号会议室,请查看活动海报和报名链接。

报名链接:

WAIC - 启明创投论坛:生成式 AI 与大模型

我们也将出席和参与 2023 年 7 月 7 日 9:00-12:00 在世博展览馆 B2F-1 号会议室的「启明创投论坛:生成式 AI 与大模型」的圆桌讨论环节。

欢迎扫码参与活动,期待与你在现场见面!

以上就是上周的 Hugging News,新的一周开始了,我们一起加油!

浙公网安备 33010602011771号

浙公网安备 33010602011771号