08.HDFS读写流程

一、HDFS写数据流程

1.1 剖析文件写入

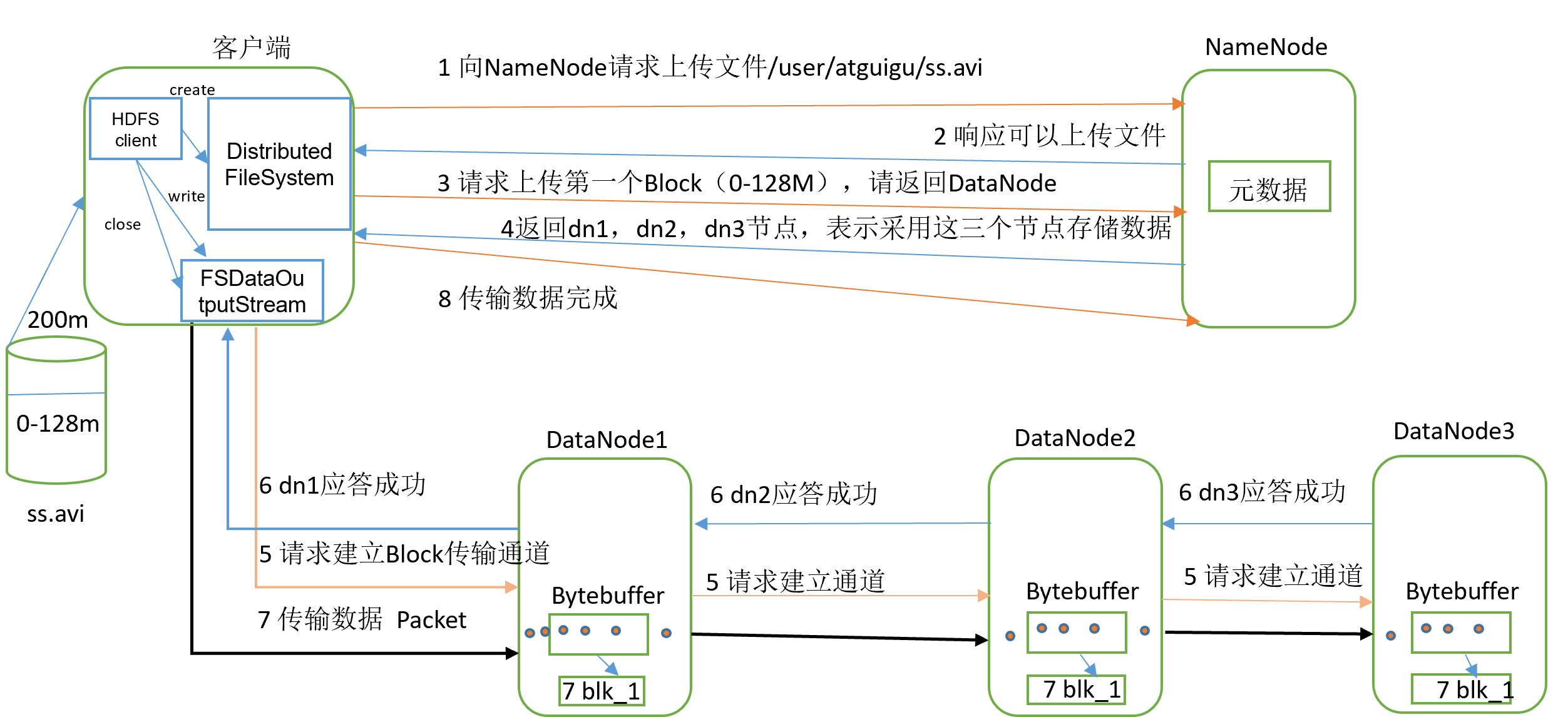

HDFS写数据流程,如图所示:

- 客户端通过

DIstributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否存在,父目录是否存在 NameNode返回是否可以上传- 客户端对上传文件进行拆分为块,客户端请求第一个

Block上传到哪几个DataNode服务器上 NameNode返回DataNode节点名,分别是dn1、dn2、dn3- 客户端通过

FSDataoutputStream模块请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成 dn1、dn2、dn3逐级应答客户端- 客户端开始往

dn1上传第一个Block(先从磁盘读取数据放到一个本地内存缓存),以Packet为单位,dn1收到一个Packet就会传给dn2,dn2传给dn3;dn1每传一个Packet会放入一个应答队列等待应答 - 当第一个

Block传输完成之后,客户端再次请求NameNode上传第二个Block的服务器(重复执行3-7步)

1.2 副本存储节点选择

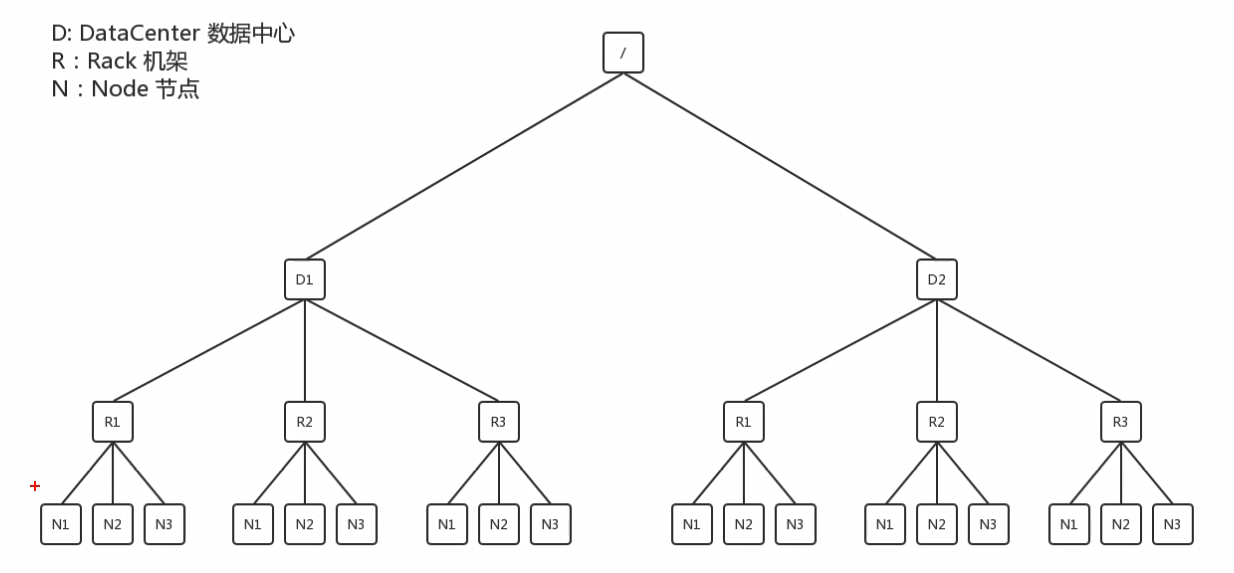

在HDFS写数据的过程中,NameNode会选择距离待上传数据最近距离的DataNode接收数据。那么这个最近距离怎么计算呢?

节点距离:两个节点到达最近的共同祖先的距离总和。

同一节点的进程距离/D1/R1/N1->/D1/R1/N1:0

同一机架上的不同节点/D1/R1/N1->/D1/R1/N2:2

同一数据中心不同机架上的不同节点/D1/R1/N1->/D1/R2/N1:4

不同数据中心的节点:/D1/R1/N1->/D2/R1/N1:6

所以说我们在客户端上传副本时,比如在Hadoop100上传文件,并限制副本数为1,那么选择的DataNode一定是Hadoop100机器。

Hadoop官网:For the common case, when the replication factor is three, HDFS’s placement policy is to put one replica on one node in the local rack, another on a different node in the local rack, and the last on a different node in a different rack

官网对存储节点的选择给出的方案:如果需要上传3个副本,第一个副本在Client所处的节点上,如果客户端在集群外,则随机选择一个;第二个副本和第一个副本位于相同机架不同节点;第三个节点位于不同机架随机节点。

这样能够保证性能和安全性的平衡性。

二、HDFS读数据流程

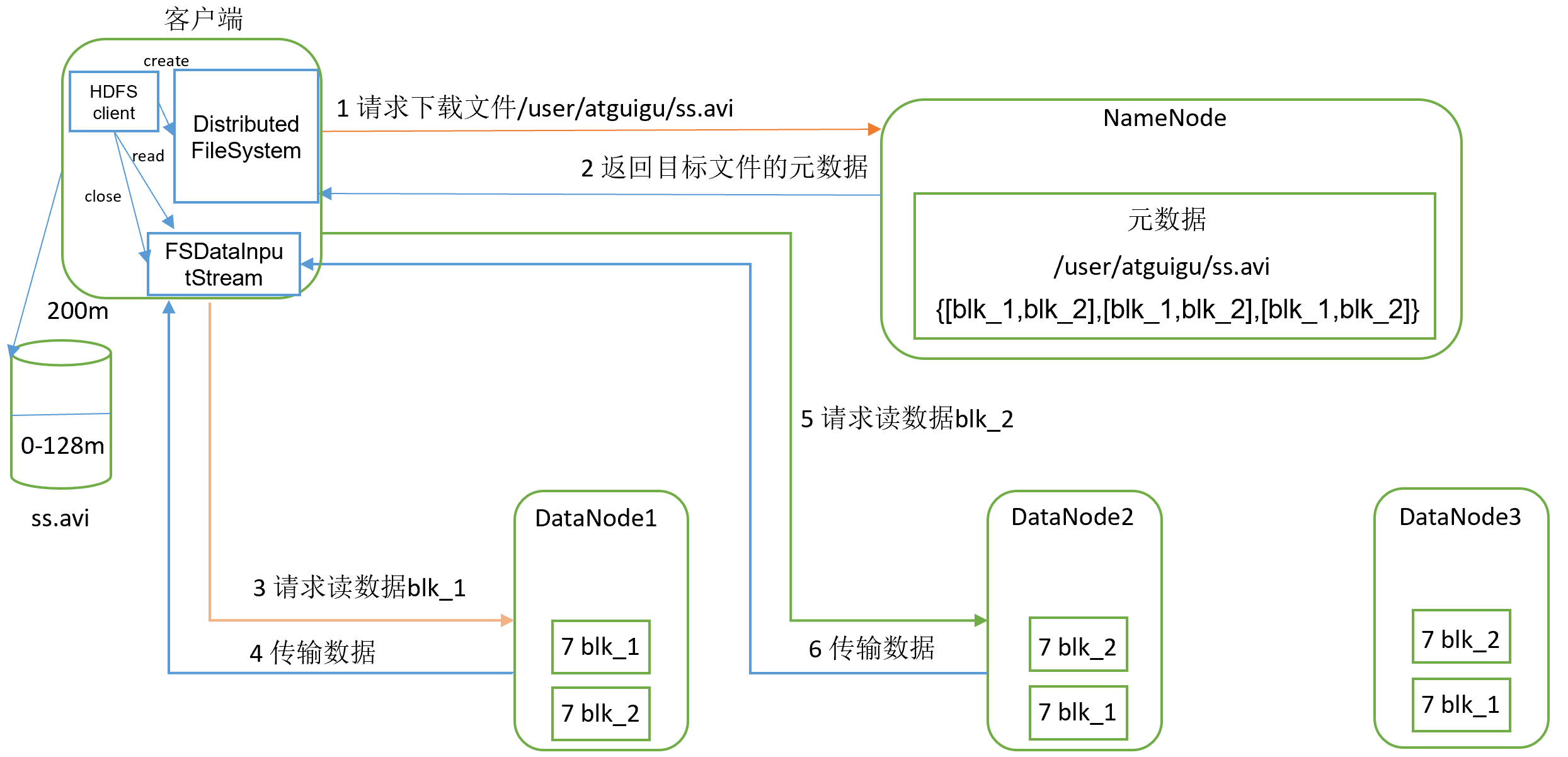

HDFS读数据流程,如图所示:

- 客户端通过

Distributed FileSystem向NameNode请求下载文件,NameNode通过查询元数据,找到文件块所在的DataNode地址 - 挑选一台

DataNode(接近原则,然后随机)服务器,请求读取数据 DataNode开始传输数据给客户端(从磁盘里面读取数据输入流,以Packet为单位来做校验)- 客户端以

Packet为单位接收,先在本地缓存,然后写入目标文件