Tensorflow Serving Docker compose 部署服务细节(Ubuntu)

【摘要】 Tensorflow Serving 是tf模型持久化的重要工具,本篇介绍如何通过Docker compose搭建并调试TensorFlow Serving

TensorFlow Serving GitHub地址:

https://github.com/tensorflow/serving

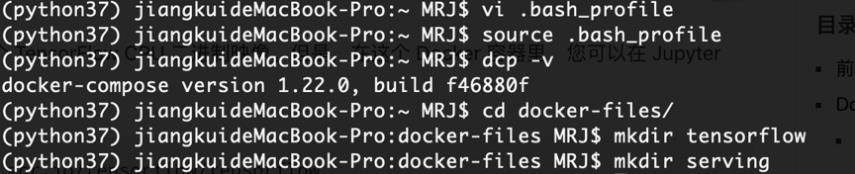

建立docker-compose 文件目录

在serving下建立docker-compose.yml文件。

一、下载安装测试TensorFlow Serving正常运行

拉取最近版本的docker

二、用tensorflow训练模型并导出model文件

(https://www.tensorflow.org/guide/saved_model#prepare_serving_inputs)

首先将训练好的模型导出为*.pd的model文件。

导出model文件后,记录model的存放地址<export path>

模型查看

saved_model_cli show --dir <export path> --all

三、使用serving

(https://github.com/tensorflow/serving/blob/master/tensorflow_serving/g3doc/serving_config.md)

单模型测试及演示POST请求。介绍JSON设计

docker-compose.yml文件示例:

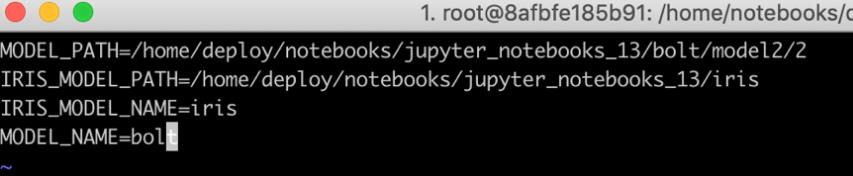

.env 文件配置

单模型部署和多模型部署:

models.config文件示例:

https://www.tensorflow.org/tfx/tutorials/serving/rest_simple

成功部署多模型多版本tensorflow serving

请求模板:

{

"signature_name": "predict",

"instances": [

{

"SepalLength":

5.1,

"PetalLength":

1.7,

"PetalWidth":

0.5,

"SepalWidth":

3.3

}

]

}返回模板:

{

"predictions": [

{

"classes": [(分类名)

"0"

],

"logits": [

-3.47067

],

"logistic": [

0.0301584

],

"class_ids": [(分类ID)

0

],

"probabilities": [(分类概率)

0.969842,

0.0301584

]

}

]

}来源:华为云社区 作者:Edison

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· 探究高空视频全景AR技术的实现原理

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· SQL Server 2025 AI相关能力初探

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南