selenium3.7+ python3 添加cookie模拟登陆

一、背景介绍

最近做一个爬虫项目,用selenium调用浏览器去获取渲染后的源码,但是每次登陆都需要手机验证,这真的是头痛啊,这种验证方式不要想着去破解,还是老老实实用手机收验证码去吧!反正我是不知道这种验证方式还能破解!难道就没有其他办法了吗?

有,那就是模拟登陆!这样最起码不用没测试一次就登陆验证一次。

这里要说一下的就是,网上很多关于webdriver 添加cookie的教程,基本百分之80都是有问题的。反正我是找了N多的帖子都没有一个是正确的。

二、 添加cookie方法:driver.add_cookie()

1.add_cookie(cookie_dict)方法里面参数是cookie_dict,说明里面参数是字典类型。

2.add_cookie源码。

从源码中我们可以看出,add_cookie方法接受一个字典,字典中包含name,value,path,domain,secure,expiry,但是这个源码容易误导人,那就是cookie参数没有给全。

网上很多教程给的代码cookie参数是没给够的,根本就跑不起来。

3. add_cookie接收的字典格式。

正确的格式:

cookie = {

# "domain": ".58.com", #Firefox浏览器不能写domain,如果写了会报错,谷歌需要写否则也是报错,这里就是一个坑。其他浏览器没测试不知道情况。

'name': name,

'value': value,

"expires": "",

'path': '/',

'httpOnly': False,

'HostOnly': False,

'Secure': False,

}

name:cookie的名称

value:cookie对应的值,动态生成的

domain:服务器域名

expiry:Cookie有效终止日期

path:Path属性定义了Web服务器上哪些路径下的页面可获取服务器设置的Cookie

httpOnly:防脚本攻击

secure:在Cookie中标记该变量,表明只有当浏览器和Web Server之间的通信协议为加密认证协议时

为什么要构造成这样子,其实我们看下浏览器保存的cookie格式就明白了。下图就是谷歌浏览器的cookie 的截图。

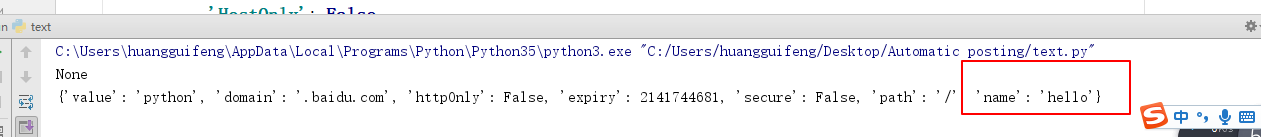

三 ,我们举个例子看下是否真的写成功了:

第一次访问的的时候去获取名字叫hello的cookie 是没有的,add_cookie后再去访问,第二次访问就拿到了hello。说明已经写进去了。

四、项目实战。

能不能用?好不好用?怎么用?,用项目来说话,模拟登陆百度。!

目标:

1.手动登录一次后,只要在cookie 有效期内无需重复登录。

2.访问浏览记录。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 | #!coding=utf-8import timefrom selenium import webdriverimport pickleclass BaiduSpider(object): def __init__(self,username,password): self.username = username self.password = password self.driver = webdriver.Chrome() self.driver.get(url='http://www.baidu.com') self.set_cookie() self.is_login() def is_login(self): '''判断当前是否登陆''' self.driver.refresh() html = self.driver.page_source if html.find(self.username) == -1: #利用用户名判断是否登陆 # 没登录 ,则手动登录 self.login() else: #已经登录 尝试访问搜索记录,可以正常访问 self.driver.get(url='http://i.baidu.com/my/history') time.sleep(30) # 延时看效果 def login(self): '''登陆''' time.sleep(60) #等待手动登录 self.driver.refresh() self.save_cookie() def save_cookie(self): '''保存cookie''' # 将cookie序列化保存下来 pickle.dump(self.driver.get_cookies(), open("cookies.pkl", "wb")) def set_cookie(self): '''往浏览器添加cookie''' '''利用pickle序列化后的cookie''' try: cookies = pickle.load(open("cookies.pkl", "rb")) for cookie in cookies: cookie_dict = { "domain": ".baidu.com", # 火狐浏览器不用填写,谷歌要需要 'name': cookie.get('name'), 'value': cookie.get('value'), "expires": "", 'path': '/', 'httpOnly': False, 'HostOnly': False, 'Secure': False} self.driver.add_cookie(cookie_dict) except Exception as e: print(e)if __name__ == '__main__': BaiduSpider('usename','!!!!') # 你的百度账号,密码 |

如果你支持我,就扫扫我的红包,你领我几毛,我领几毛,也算是对我的支持。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构