Deep Residual Learning for Image Recognition

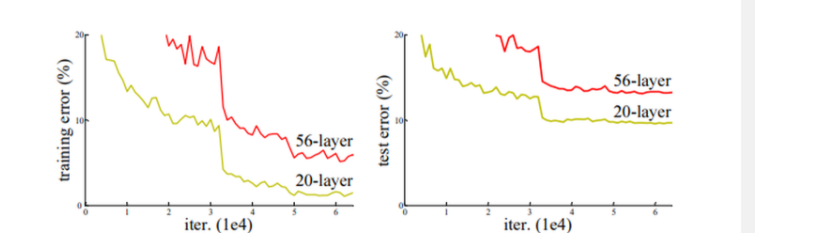

讲述了用平常的训练方法,深度比惨大的网络表现应该优于浅层的网络,因为CNN能够提取low/mid/high-level的特征,网络的层数越多,意味着能够提取到不同level的特征越丰富。并且,越深的网络提取的特征越抽象,越具有语义信息。

但是本文的实验下来表明并不是这样,由此引出了‘退化问题’,训练出现饱和,但是却不是过拟合,因为在训练集上的表现也不是很理想。

由此提出假设,更改学习的目标,假设它们可以渐近地近似残差函数,即,因此,我们明确让这些层近似残差函数

。因此原始函数变为

(移动X)。尽管两种形式应该都能渐近地近似要求的函数(如假设),但学习的难易程度可能是不同的。

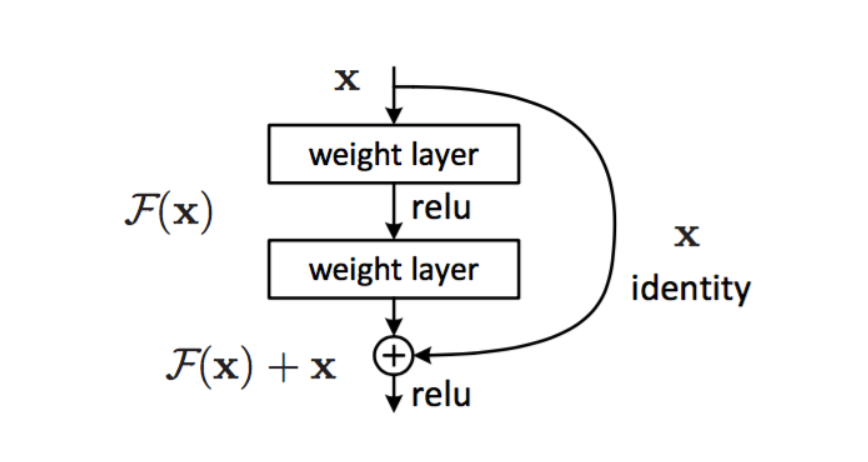

考虑H(x)作为几个堆叠层(不必是整个网络)要拟合的基础映射,也就是说这个结构是没过一定层数就会使用一次残差,并不是在整个网络上只有一头一尾

这里就是一个例子,,这里的激活函数使用的是relu

此处相加的2个维度必须保证,如果不符合,需要使用Ws来确保可加。

在训练时还使用了一种过拟合的方法,没有采用dropout,叫做权重衰减,也叫做L2正则化.就是在代价函数后面加上一个正则化项。

同时还使用了动量梯度下降。