元数据治理-Atlas血缘

参考:

官网:

https://atlas.apache.org

简单介绍:

https://cloud.tencent.com/developer/article/1544396 GG

https://blog.csdn.net/wangpei1949/article/details/87555794 #web

和CDH集成:

https://blog.csdn.net/xueyao0201/article/details/94310583

部署:

官网:

https://atlas.apache.org/#/Installation

https://blog.csdn.net/MuQianHuanHuoZhe/article/details/82048755 GG

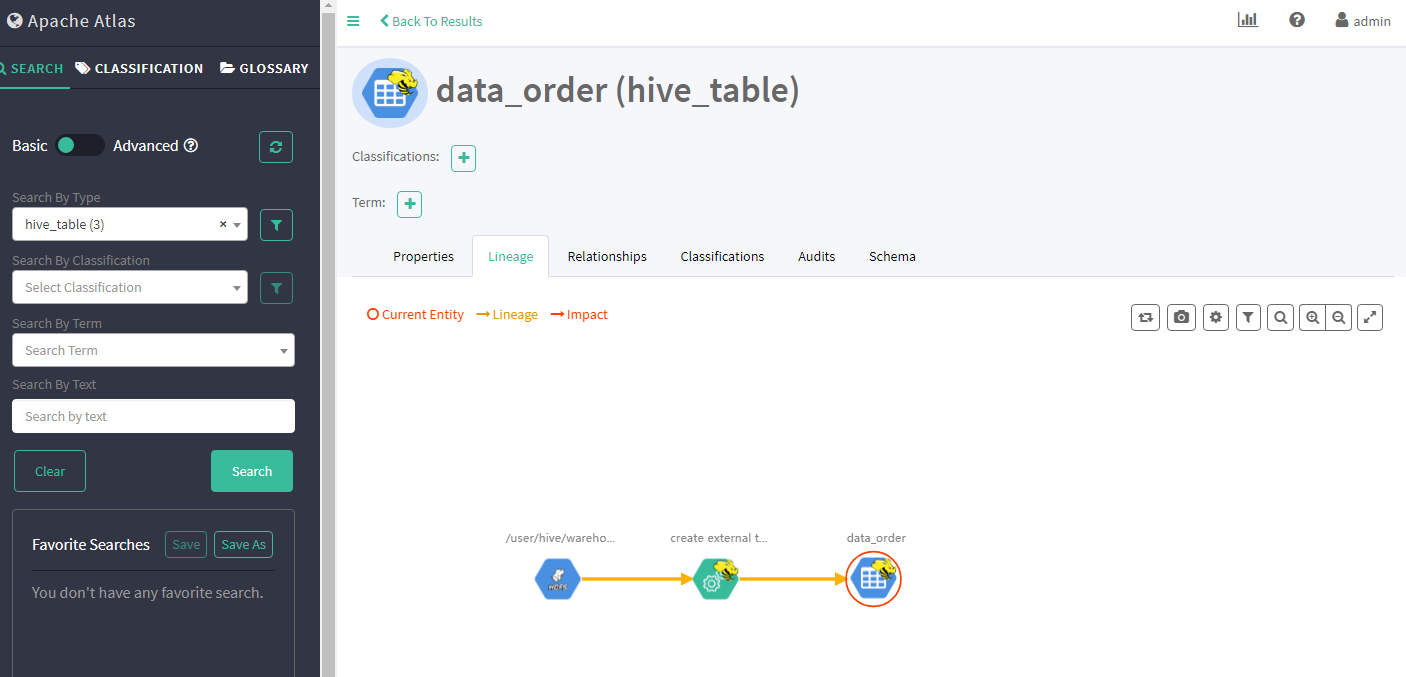

一、Atlas是什么?

在当今大数据的应用越来越广泛的情况下,数据治理一直是企业面临的巨大问题。

大部分公司只是单纯的对数据进行了处理,而数据的血缘,分类等等却很难实现,市场上也急需要一个专注于数据治理的技术框架,这时Atlas应运而生。

Atlas是Hadoop的数据治理和元数据框架。

Atlas是一组可扩展和可扩展的核心基础治理服务,使企业能够有效,高效地满足Hadoop中的合规性要求,并允许与整个企业数据生态系统集成。

Apache Atlas为组织提供了开放的元数据管理和治理功能,以建立其数据资产的目录,对这些资产进行分类和治理,并为数据科学家,分析师和数据治理团队提供围绕这些数据资产的协作功能。

Atlas支持各种Hadoop和非Hadoop元数据类型

提供了丰富的REST API进行集成

对数据血缘的追溯达到了字段级别,这种技术还没有其实类似框架可以实现

对权限也有很好的控制

架构原理:

Atlas包括以下组件:

采用Hbase存储元数据

采用Solr实现索引

Ingest/Export 采集导出组件 Type System类型系统 Graph Engine图形引擎 共同构成Atlas的核心机制

所有功能通过API向用户提供,也可以通过Kafka消息系统进行集成

Atlas支持各种源获取元数据:Hive,Sqoop,Storm。。。

还有优秀的UI支持

压力大时需要单独一台机器部署Apache Atlas

Atlas Hive hook向Hive注册侦听以创建/更新/删除操作,并通过Kafka通知更新Atlas中的元数据以获取Hive中的更改

采集的动作存到hbase,然后再展示出来.

接下来需求是给hive安装扩展插件采集血缘关系。

1、每台机器都要新建一个/etc/hive/auxlib文件夹,然后往里面上传22个atlas特有的jar包;emr配置hive_aux_jars_path

/etc/hive/auxlib/atlas-hive-plugin-impl每台都拷上

2、接着,往hive配置文件夹/etc/ecm/hive-conf加2个atlas特有配置文件(除了java_home和内嵌程序hbase开关的manage为前缀,配置项都以atlas为前缀)。重启hive

/etc/ecm/hive-conf/atlas-application.properties

/etc/ecm/hive-conf/atlas-env.sh

3、运行import_hive.sh的脚本

/etc/hive/auxlib/hook-bin/import_hive.sh

官网:

https://atlas.apache.org/#/HookHive

Atlas Hive钩子向Hive注册以侦听创建/更新/删除操作,并通过Kafka通知更新Atlas中的元数据以获取Hive中的更改。请按照以下说明在Hive中设置Atlas挂钩:

通过添加以下内容,在hive-site.xml中设置Atlas挂钩:

<property>

<name>hive.exec.post.hooks</name>

<value>org.apache.atlas.hive.hook.HiveHook</value>

</property>

解压缩apache-atlas-$ {project.version} -hive-hook.tar.gz

cd apache-atlas-hive-hook-$ {project.version}

将文件夹apache-atlas-hive-hook-$ {project.version} / hook / hive的全部内容复制到<atlas package>/ hook / hive

<atlas package>在您的配置单元配置的hive-env.sh中添加“ export HIVE_AUX_JARS_PATH = / hook / hive”

将<atlas-conf>/atlas-application.properties 复制到hive conf目录。

采集到的数据展示到worker1上:

http://8.xx.xx.xxx:21060

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步