d2l-ResNet

残差网络 ResNet

核心思想

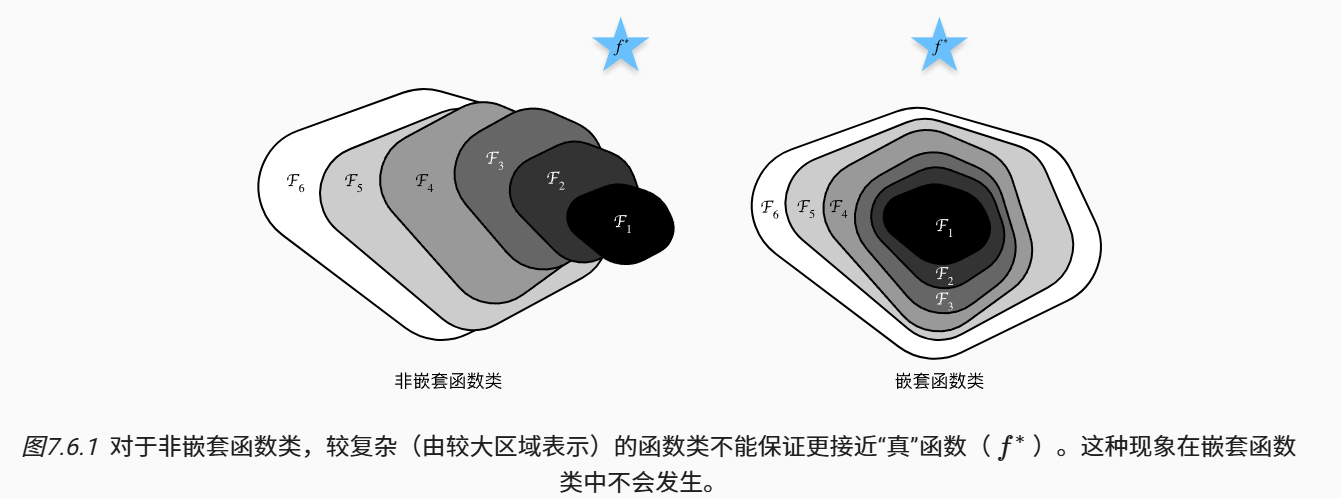

神经网络的加深并不一定会带来好处。

如果复杂函数能够覆盖简单函数的区域(嵌套函数),能够确保模型的精度逐步提高。

核心思想:每个附加层应该更容易地包含原始函数

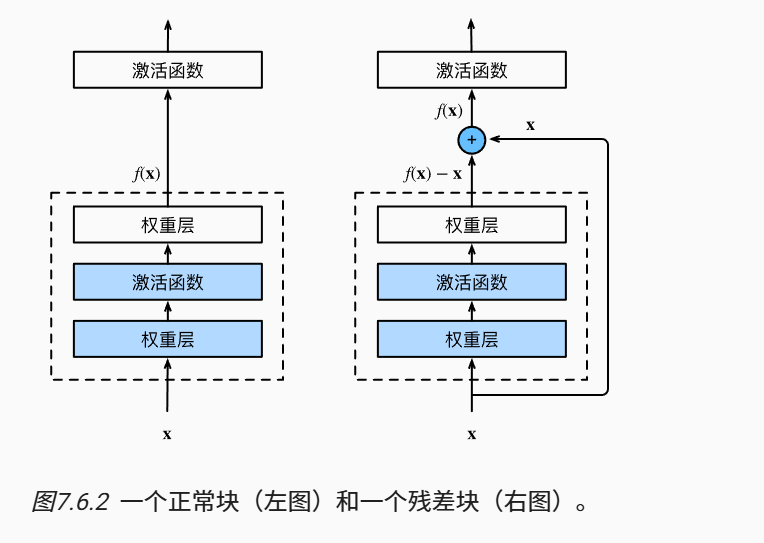

残差块(residual block):

- 原先需要拟合

- 在残差块中,输入可以通过跨层数据线路更快地向前传播

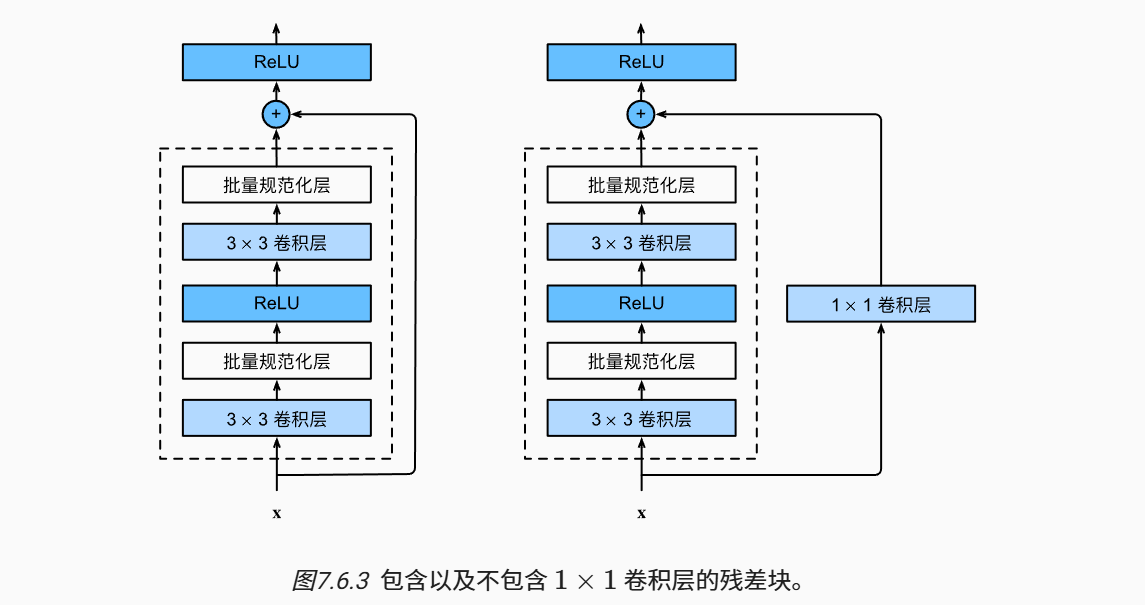

1个残差块Residual中有:

- 2个相同输出通道的

3*3 Conv层。 - 每个卷积层后接

1个BN层,1个ReLU激活函数 - 跨层数据通道将

输入x直接加到第2个ReLU函数之前 - 如果

input_channel != output_channel,则加1*1 Conv层变换通道数

class Residual(nn.Module):

def __init__(self, input_channels, num_channels,

use_1x1conv=False, strides=1):

super().__init__()

self.conv1 = nn.Conv2d(input_channels, num_channels,

kernel_size=3, padding=1, stride=strides)

self.conv2 = nn.Conv2d(num_channels, num_channels,

kernel_size=3, padding=1)

if use_1x1conv:

self.conv3 = nn.Conv2d(input_channels, num_channels,

kernel_size=1, stride=strides)

else:

self.conv3 = None

self.bn1 = nn.BatchNorm2d(num_channels)

self.bn2 = nn.BatchNorm2d(num_channels)

def forward(self, X):

Y = F.relu(self.bn1(self.conv1(X)))

Y = self.bn2(self.conv2(Y))

if self.conv3:

X = self.conv3(X)

Y += X

return F.relu(Y)

常见的ResNet架构有:

- ResNet-18

- ResNet-34

- ResNet-50

- ResNet-101

- ResNet-152

ResNet 18

ResNet 和 GoogleNet 类似,首先是1个步幅为2的7*7 Conv层,接步幅为2的 3*3 MaxPooling层

b1 = nn.Sequential(nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64), nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

然后是4个resnet_blk,每个resnet_blk由2个残差块构成。

- 第1个 resnet_blk 因为之前使用步长为2的MaxPooling,因此无需进行高宽减半

- 第2,3,4个 resnet_blk 在第一个残差块Residual中通道翻倍、高宽减半。

def resnet_block(input_channels, num_channels, num_residuals,

first_block=False):

blk = []

for i in range(num_residuals):

if i == 0 and not first_block:

blk.append(Residual(input_channels, num_channels,

use_1x1conv=True, strides=2))

else:

blk.append(Residual(num_channels, num_channels))

return blk

b2 = nn.Sequential(*resnet_block(64, 64, 2, first_block=True))

b3 = nn.Sequential(*resnet_block(64, 128, 2))

b4 = nn.Sequential(*resnet_block(128, 256, 2))

b5 = nn.Sequential(*resnet_block(256, 512, 2))

最后,ResNet加入全局平均池化层,以及全连接层输出。

net = nn.Sequential(b1, b2, b3, b4, b5,

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten(), nn.Linear(512, 10))

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)