论文阅读-Causality Inspired Framework for Model Interpretation

标题:A Causality Inspired Framework for Model Interpretation

关键词:自然语言处理,因果推理,可解释机器学习

论文链接:https://dl.acm.org/doi/pdf/10.1145/3580305.3599240

会议:KDD

1. 简介

解释(explanation) 能否揭示 模型表现的根本原因(root cause)是XAI的重要问题。

文章提出了Causality Inspired Model Interpreter (CIMI),一种基于因果推理的解释器。

- 在XAI中 变量集合(a set of variables)可以作为模型预测的可能原因(possible causes),如果其满足因果充分性假设(causal sufficiency assumption)。

- 核心问题:如何有效地 发现突出的共同原因(prominent common causes),并能从大量特征和数据点推广到不同实例(泛化性generalizability)。

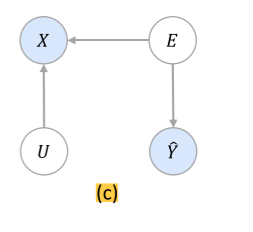

2. 因果图

- X:输入实例

- E:模型预测的泛化因果解释(generalized causal explanation for predeiction)

- U:非解释部分(non-explanation)

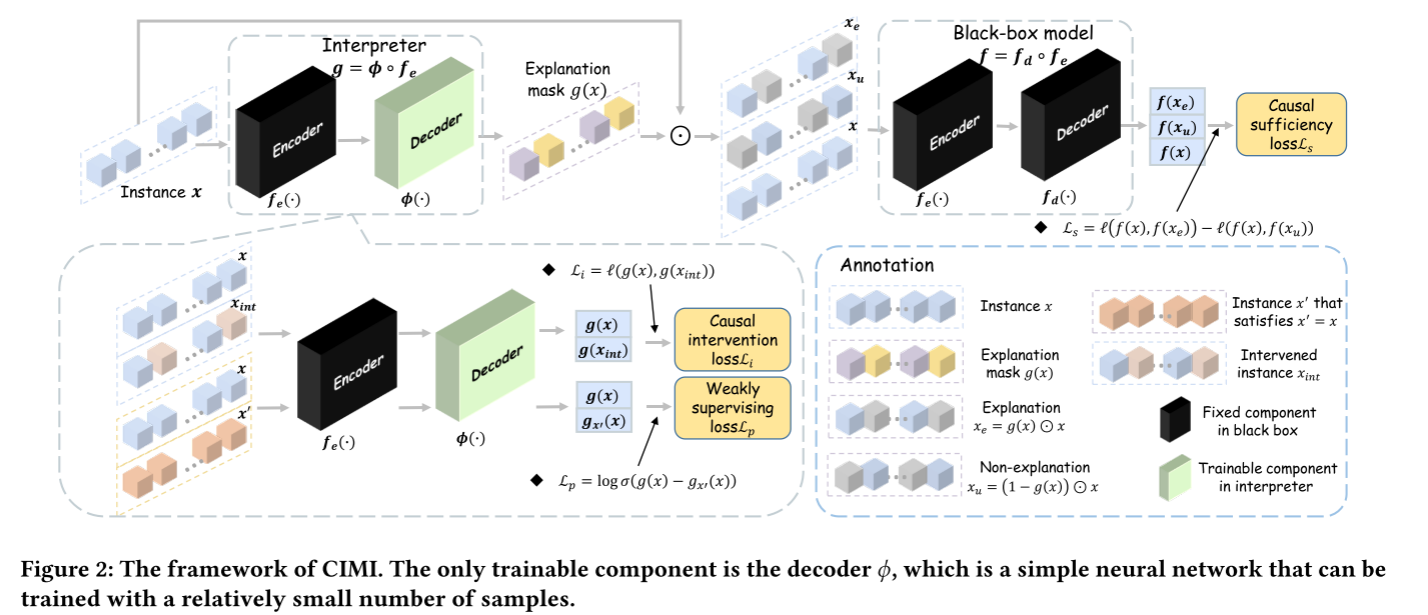

3. 框架结构

解释器 Interpreter

- 1-layer LSTM: hidden size is 64

- 2-layers MLP: 64 × 16, 16 × 2

- 输出第i维度的值:token i 被选中作为解释的概率

信息瓶颈理论:infomation bottleneck theory 在前向传播过程中,神经网络会逐渐专注于输入中最重要的部分,过滤掉不重要的部分。(信息量是逐渐衰减的)

黑盒模型的编码器

4. 损失函数

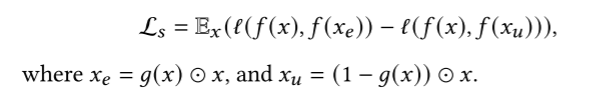

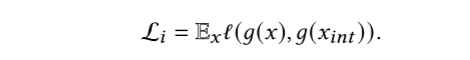

1. causal sufficiency loss

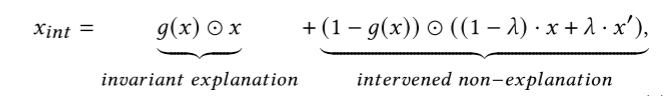

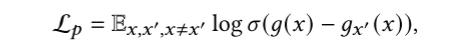

2. causal intervention loss

对非解释部分进行线性插值,不会影响解释的生成。

3. weakly supervised loss

为了防止生成平凡解(包含所有token的解),设置了此弱监督损失。

- 最大化实例x中的 token 被包括在解释

- 最小化不在x中的token(噪音)被预测为解释的概率(minimizing the probability that a token not in 𝑥 (noise) is predicted to be the explanation)

5. 实验

5.1 评价指标

1. causul sufficiency(3个)

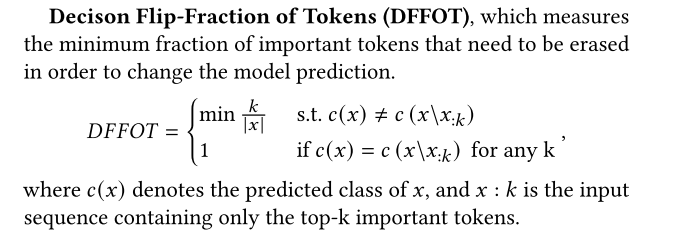

- Decison Flip-Fraction of Tokens (DFFOT):改变模型预测所需要修改重要token的最小部分(minimum fraction)(越小越好)

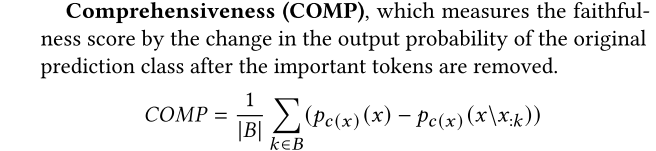

- Comprehensiveness (COMP):移除important token,原预测类的概率变化量(越大越好)

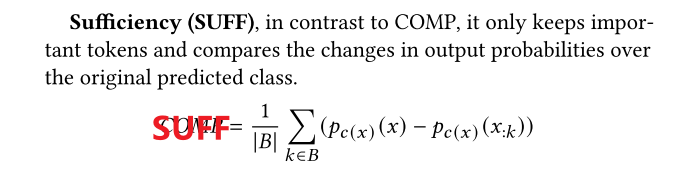

- Sufficiency (SUFF):只保留import token,原预测类的概率变化量(越小越好)

2. explanation generalizability(1个)

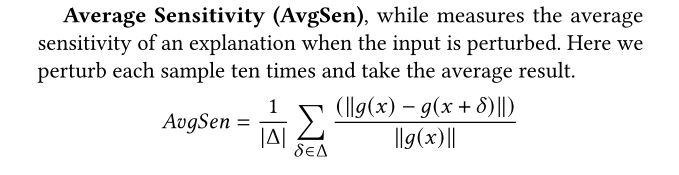

- Average Sensitivity (AvgSen):当输入被扰动时,一个解释的平均敏感度。(在实验中对每个实例替换5个token,并计算top-10 important token的敏感度)。

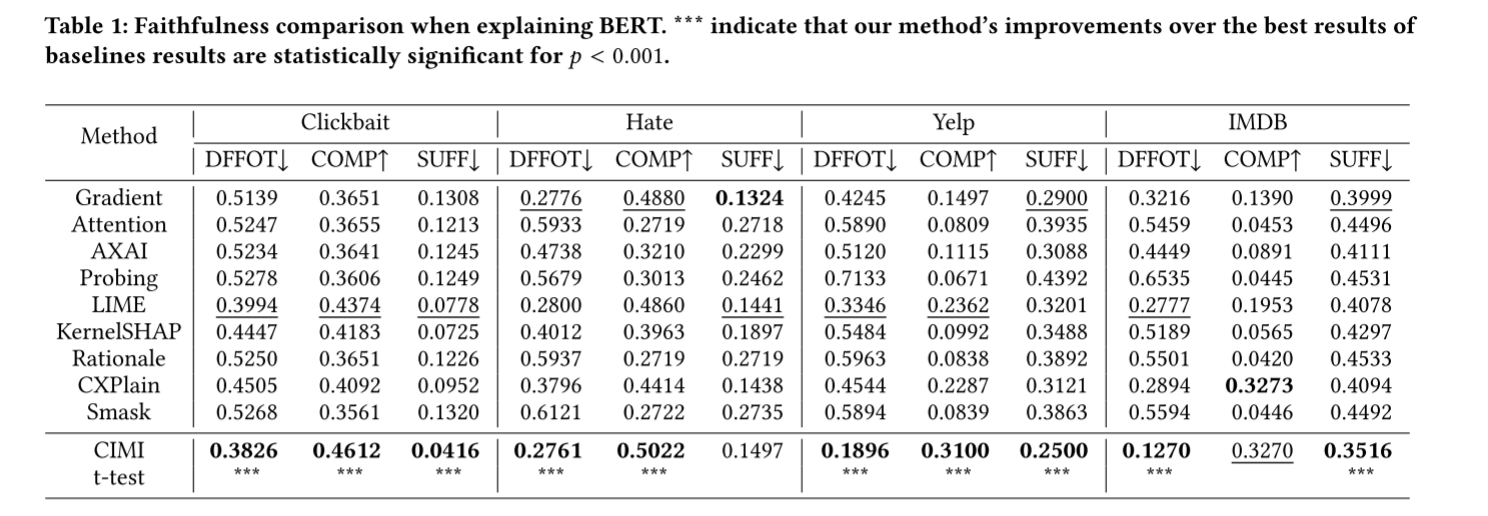

5.2 Faithfulness Comparison

- 测量不同方法的3个指标

- 计算CIMI方法是否有显著提升

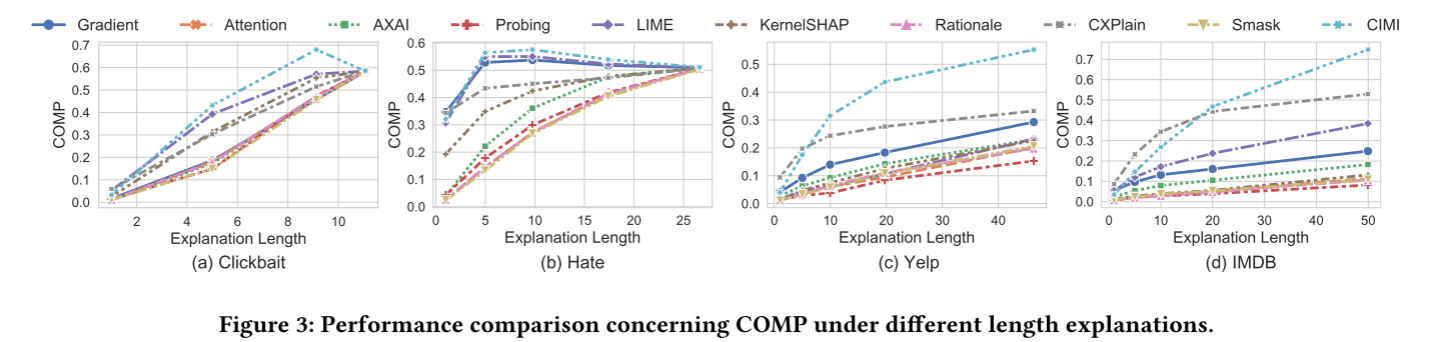

不同解释长度下的COMP指标的比较

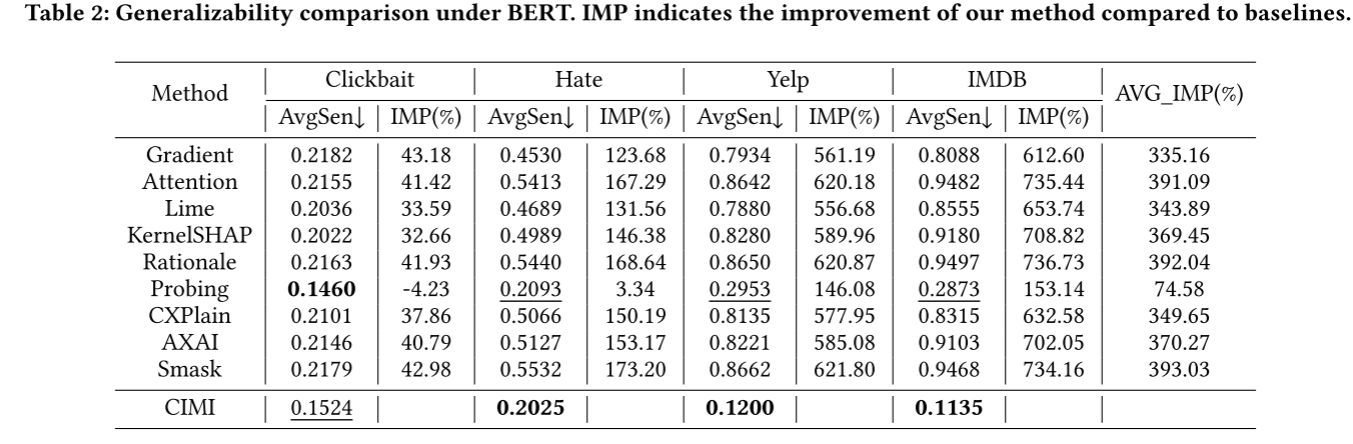

5.3 Generalizability Comparison

用AvgSen作为衡量泛化能力的指标

在4个数据集上CIMI的top-10 token中有8个能保持一致,说明该方法能够抓住具有不变的泛化特征(invariant generalizable features)。

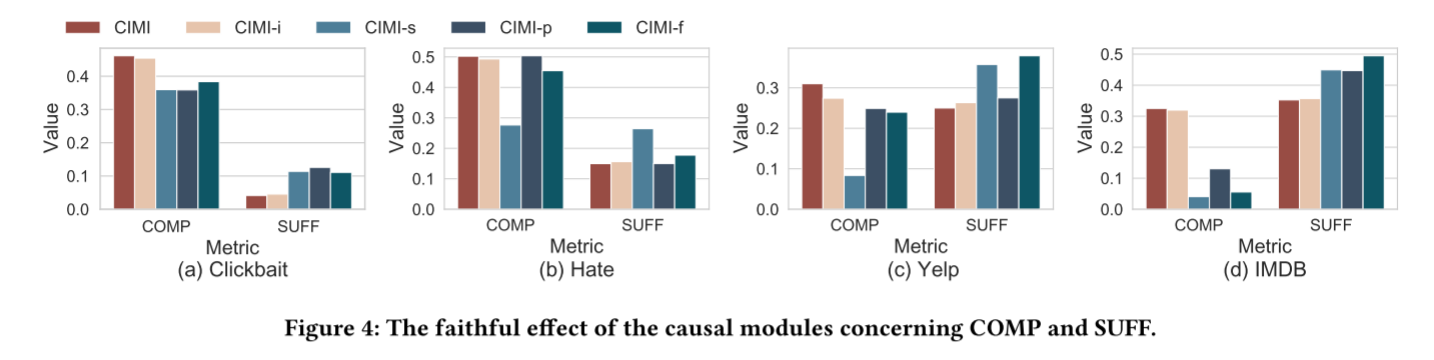

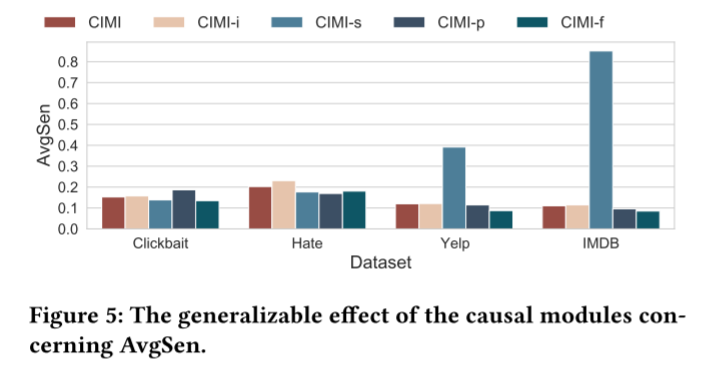

5.4 消融实验

尝试移除不同的模块,观察模型表现的变化,进而证明模型设计理念的正确性。

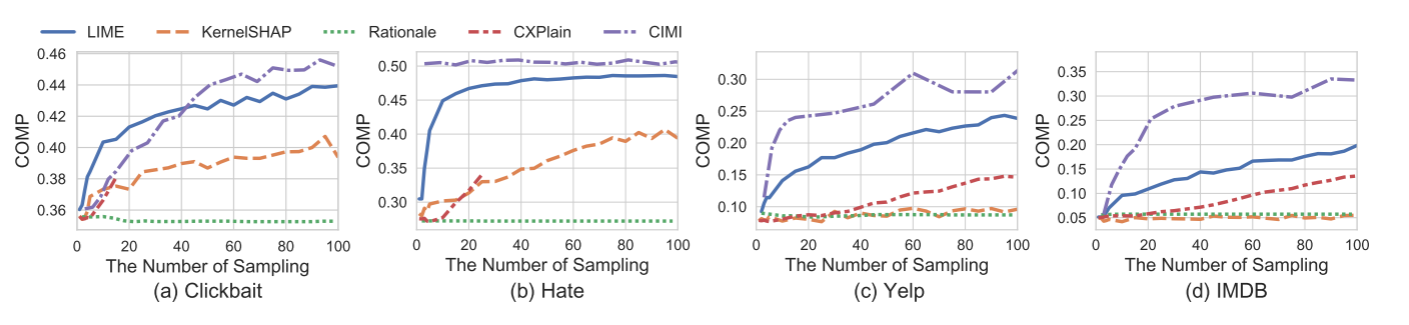

5.5 采样效率(Sampling Efficiency)

用 各种基于扰动的方法 在 相同前向传播次数下 的表现来衡量 采样效率。

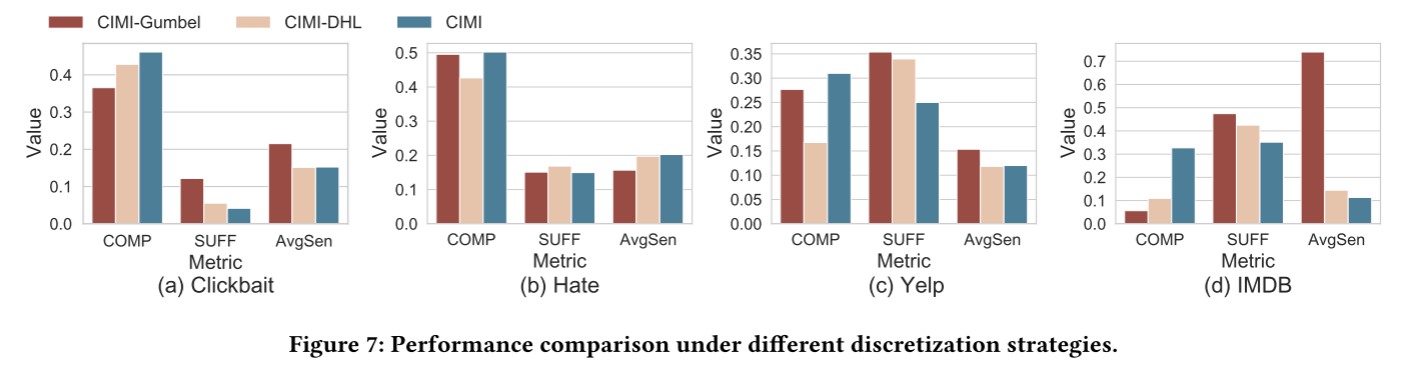

5.6 不同离散化策略的表现

原来的方法采用的是可微的Softmax,本实验尝试将其替换为 Gumbel-Softmax 和 Deep Hash Learning 两个离散函数。

离散化的掩码能够提高解释的泛化能力,但是以模型表现下降为代价。

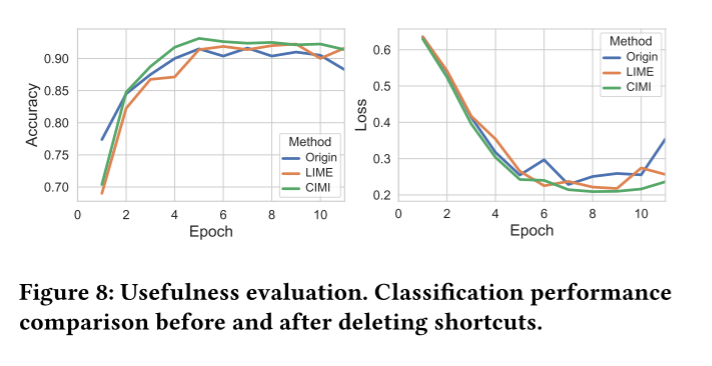

5.7 Usefulness Evaluation 模型排错

利用模型生成的解释剔除shortcut features。在CIMI debugging 之后模型表现是最好的。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 单元测试从入门到精通

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律