吴恩达《深度学习》第一门课(1)深度学习引言

本阶段的博客内容是关于深度学习知识,总结吴恩达老师的课程的内容,笔记大部分转载自https://www.cnblogs.com/ys99/ 这个博主。

1.1欢迎

主要讲了五门课的内容:

第一门课:神经网络基础,构建网络等;

第二门课:神经网络的训练技巧;

第三门课:构建机器学习系统的一些策略,下一步该怎么走(吴恩达老师新书《Machine Learning Yearning》就是针对这个以及上一课);

第四门课:卷积神经网络相关;

第五门课:循环神经网络相关。

1.2什么是神经网络

(1)常说的深度学习指的就是训练神经网络,或者也指特别大规模的神经网络。

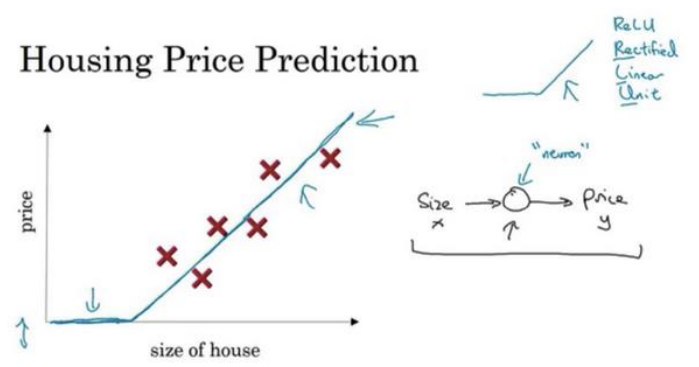

(2)每一个神经元都代表着从输入到输出的函数映射,如下的房价预测:

(3)激活函数Relu(Rectified Linear Unit)其实就是max(0,x)。

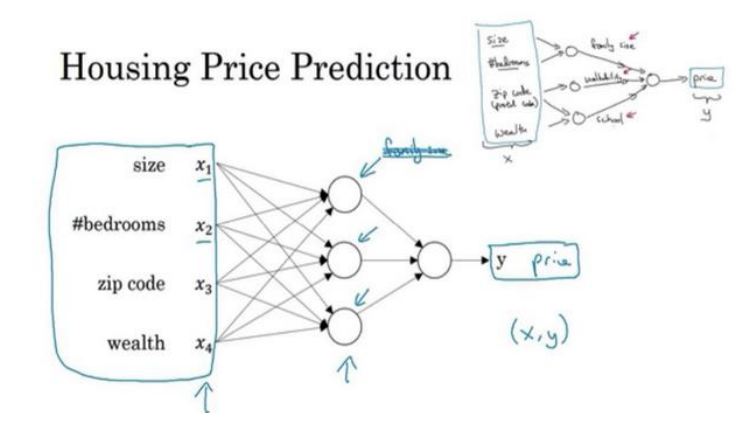

(4)神经网络非常擅长计算从x到y的精确映射函数(个人理解:神经网络实质就是非线性的多项式拟合),神经网络的输入单元个数一般是特征个数,中间称为隐藏层,然后输出单元个数依据实际情况而定,如下输出是房价的预测值,故是一个神经元。

1.3神经网络的监督学习

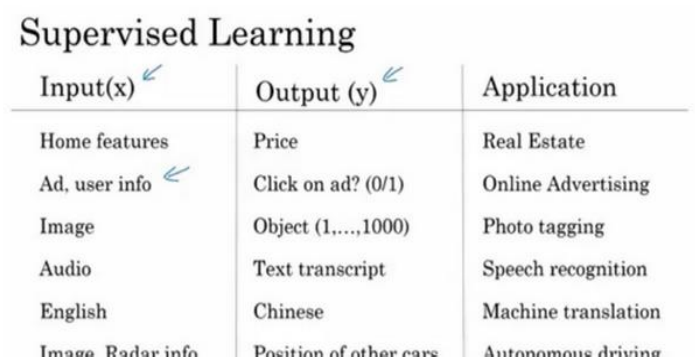

(1)神经网络在监督学习上的应用:

(2)数据包括结构化数据和非结构化数据,图像语言语音都是非结构化数据,是神经网络要研究解决的重点。

1.4为什么深度学习会兴起

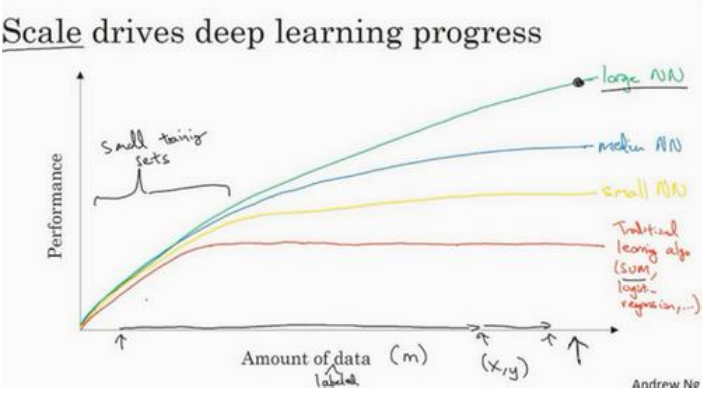

(1)三点原因:数据规模大、计算速度提高、算法的创新。事实上如今提高性能最可靠的方法就是运用更大的神经网络和投入更多的数据。下图展示了数据量、模型大小与性能之间的关系:

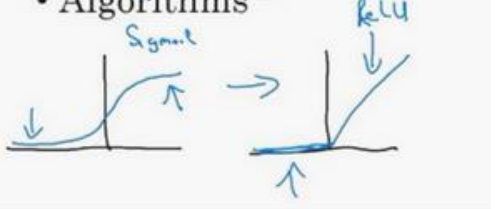

(2)算法创新的一个小案例:激活函数从sigmoid(存在梯度消失)变成ReLU,训练的速度变得更快了,sigmod函数在右上方收敛速度会变慢,效率低,relu函数可以快速收敛。

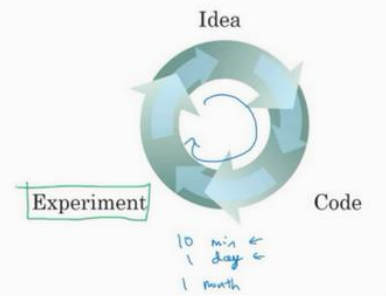

(3)在实践应该按照下图方式进行快速迭代:

1.5关于这么课

总共四周,分别是前言,预备知识,浅层神经网络和深层神经网络。

作者:你的雷哥

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须在文章页面给出原文连接,否则保留追究法律责任的权利。

浙公网安备 33010602011771号

浙公网安备 33010602011771号