[Triton课程笔记] 1.1.1 框架介绍

一、推理框架介绍

- triton和推理框架不能画上等号,推理框架一般包括客户端端和服务端,triton是服务端部分。

- 使用triton的场景,一般使用k8s来管理triton应用,解决负载均衡,动态扩容等问题。

- 模型仓库,用来管理模型文件。

- metrics service:监控整个推理服务,驾驶舱。

- 推理服务一般开启多个部署,用以分担推理请求压力。triton实际上就是绿色部分。

- triton支持多种深度学习框架导出的模型,Tensorrt只是triton里的一个推理库而已。

二、推理框架组件介绍

进一步介绍了推理框架中的组件。

- k8s——集群。

- Triton——单模式推理服务(Pod),单卡/多卡

- Tensorrt——模型加速库。

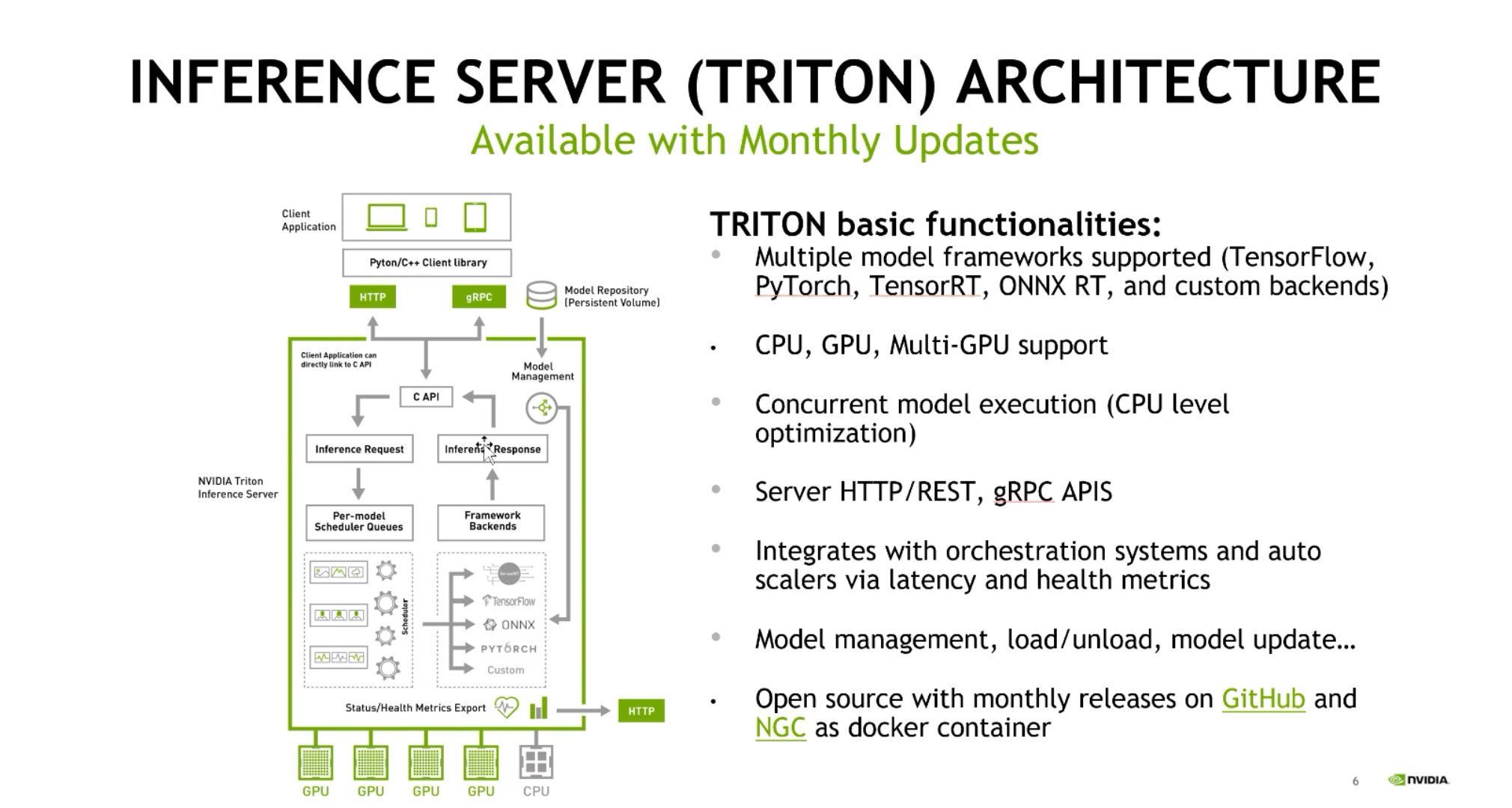

三、Triton基本功能

- 多框架支持;

- CPU、GPU,多GPU异构支持;

- 并行执行能力,CPU级别优化;

- 支持HTTP/REST,gRPC APIS;

- 监控:通过延迟和运行状况指标与编排系统和自动缩放进程集成;

- 模型管理,加载、卸载、更新;

- 开源,NGC docker仓库支持,每月发布;

其他:Scheduler主要是指对推理请求队列进行调度的过程。

本文版权归作者(https://www.cnblogs.com/harrymore/)和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接,如有问题, 可邮件(harrymore@126.com)咨询.

浙公网安备 33010602011771号

浙公网安备 33010602011771号