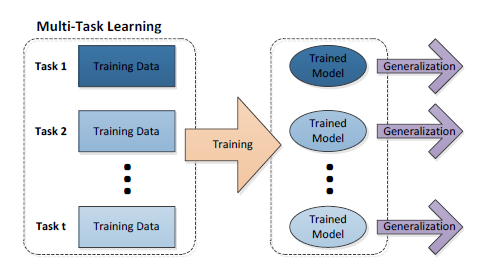

摘要:  一. 多任务学习理论 1.1 多任务学习的定义 如果有$n$个任务(传统的深度学习方法旨在使用一种特定模型仅解决一项任务),而这$n$个任务或它们的一个子集彼此相关但不完全相同,则称为多任务学习(以下简称为MTL) 。通过使用所有$n$个任务中包含的知识,将有助于改善特定模型的学习 多任务学习本质上 阅读全文

一. 多任务学习理论 1.1 多任务学习的定义 如果有$n$个任务(传统的深度学习方法旨在使用一种特定模型仅解决一项任务),而这$n$个任务或它们的一个子集彼此相关但不完全相同,则称为多任务学习(以下简称为MTL) 。通过使用所有$n$个任务中包含的知识,将有助于改善特定模型的学习 多任务学习本质上 阅读全文

一. 多任务学习理论 1.1 多任务学习的定义 如果有$n$个任务(传统的深度学习方法旨在使用一种特定模型仅解决一项任务),而这$n$个任务或它们的一个子集彼此相关但不完全相同,则称为多任务学习(以下简称为MTL) 。通过使用所有$n$个任务中包含的知识,将有助于改善特定模型的学习 多任务学习本质上 阅读全文

一. 多任务学习理论 1.1 多任务学习的定义 如果有$n$个任务(传统的深度学习方法旨在使用一种特定模型仅解决一项任务),而这$n$个任务或它们的一个子集彼此相关但不完全相同,则称为多任务学习(以下简称为MTL) 。通过使用所有$n$个任务中包含的知识,将有助于改善特定模型的学习 多任务学习本质上 阅读全文

posted @ 2022-11-11 15:46

晓柒NLP

阅读(14012)

评论(0)

推荐(2)

摘要:

深度学习网络模型中初始的权值参数通常都是初始化成随机数,而使用梯度下降法最终得到的局部最优解对于初始位置点的选择很敏感,下面介绍Pytorch中随机种子的设置及其原理。 1. Pytorch随机种子设置 在同一开发环境中,随机数种子seed确定时,模型的训练结果将始终保持一致。 def setup_ 阅读全文

posted @ 2022-11-11 15:43

晓柒NLP

阅读(5207)

评论(0)

推荐(1)

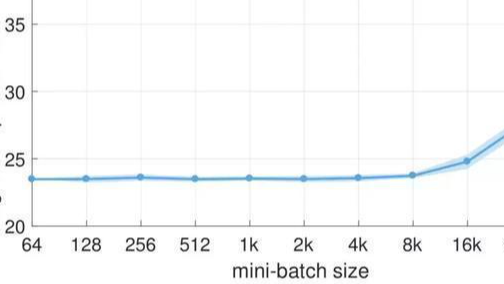

摘要:  Batch_Size(批尺寸)是机器学习中一个重要参数,下文详细讲解Batch的意义以及相关概念的区别 1. 定义 Iteration:表示1次迭代(也叫training step),每次迭代更新1次网络结构的参数 Batch_size:1次迭代所使用的样本量,每跑完一个batch都要更新参数,这个 阅读全文

Batch_Size(批尺寸)是机器学习中一个重要参数,下文详细讲解Batch的意义以及相关概念的区别 1. 定义 Iteration:表示1次迭代(也叫training step),每次迭代更新1次网络结构的参数 Batch_size:1次迭代所使用的样本量,每跑完一个batch都要更新参数,这个 阅读全文

Batch_Size(批尺寸)是机器学习中一个重要参数,下文详细讲解Batch的意义以及相关概念的区别 1. 定义 Iteration:表示1次迭代(也叫training step),每次迭代更新1次网络结构的参数 Batch_size:1次迭代所使用的样本量,每跑完一个batch都要更新参数,这个 阅读全文

Batch_Size(批尺寸)是机器学习中一个重要参数,下文详细讲解Batch的意义以及相关概念的区别 1. 定义 Iteration:表示1次迭代(也叫training step),每次迭代更新1次网络结构的参数 Batch_size:1次迭代所使用的样本量,每跑完一个batch都要更新参数,这个 阅读全文

posted @ 2022-11-11 15:38

晓柒NLP

阅读(773)

评论(0)

推荐(0)

浙公网安备 33010602011771号

浙公网安备 33010602011771号