hadoop环境搭建

hadoop环境搭建

本环境基于操作系统为centos 7.4 1708,官方镜像已经不提供下载,只有readme,查看readme找到镜像地址。hadoop采用的版本为2.7.4,下载地址。以下为环境部署步骤:

一、安装JDK

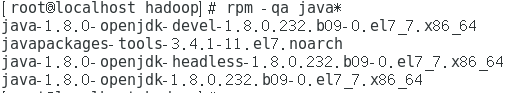

1.安装之前先检测

安装之前先检测是否自带的有java sdk,如果存在需要先进行卸载,否则会出现hadoop启动异常问题,查看命令如下:

rpm -qa java*

2.安装jdk,执行如下命令:

yum install java-1.8.0-openjdk java-1.8.0-openjdk-devel -y

3.配置环境变量

执行如下命令修改配置文件:

vim /etc/profile

添加如下内容

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.232.b09-0.el7_7.x86_64 export JRE_HOME=$JAVA_HOME/jre export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

应用修改后的配置文件

source /etc/profile

测试环境变量是否设置成功,执行如下命令:

javac

查看现在运行的java的进程

jps

二、安装hadoop

1.获取hadoop安装包

执行如下命令获取hadoop获取hadoop文件:

wget http://archive.apache.org/dist/hadoop/common/hadoop-2.7.4/hadoop-2.7.4.tar.gz

2.解压文件

tar -zxfv hadoop-2.7.4.tar.gz

3.移动解压文件到运行目录,这边暂时存放位置为/usr/local

4.配置配置文件

主要有四个,配置文件在解压后的文件夹下etc/hadoop/文件夹下,分别为:hadoop-env.sh,core-site.xml,hdfs-site.xml,mapred-env.sh

(1)hadoop-env.sh

将java环境变量替换为真实位置

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.232.b09-0.el7_7.x86_64

(2)core-site.xml

在configuration节点中添加如下属性:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/hadoop</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>dfs.name.dir</name>

<value>/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

(3).hdfs-site.xml

在configuration节点中添加如下属性:

<configuration>

<property>

<name>dfs.data.dir</name>

<value>/hadoop/data</value>

</property>

</configuration>

(4)mapred-env.sh

在configuration节点中添加如下属性:

<configuration>

<property>

<name>mapred.jb.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

5.添加hadoop环境变量

执行如下命令修改配置文件:

vim /etc/profile

添加第一行,并修改第二行,结果如下如下内容

export HADOOP_HOME=/usr/local/hadoop-2.7.4/

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$HADOOP_HOME/bin:$PATH

应用修改后的配置文件

source /etc/profile

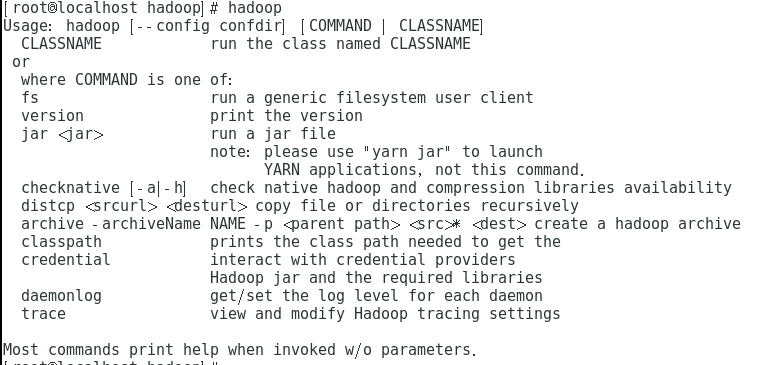

测试环境变量是否设置成功,执行如下命令:

hadoop

出现该结果表示环境变量设置成功。

6.启动hadoop

在hadoop目录sbin目录下执行start-all.sh启动hadoop,期间需要输入root用户密码,命令如下:

./start-all.sh

7.查看web界面

启动成功可以通过两个地址可以进行查看:

至此hadoop基础平台搭建完成,下一步会将Hive,HBase,ZooKeeper,Spark等环境的部署。