黑盒对抗攻击论文《DaST: Data-free Substitute Training for Adversarial Attacks》阅读感想

先介绍对抗攻击的初级内容:

目前的图像对抗攻击分类:1、一般化攻击,这类攻击根本不需要知道要被攻击的神经网络是啥样的,产生的对抗样本具有通用的对抗性,多采用滤波的方式实现攻击,如:

《Noise is Inside Me! Generating Adversarial Perturbations with Noise Derived from Natural Filters》

2、特定网络的攻击,又可分为白盒攻击和黑盒攻击

(1)白盒攻击需要知道要攻击的网络的全部信息,如网络架构、参数等;白盒攻击又可分为基于梯度的方法和基于牛顿法等寻优算法的方法。如经典的FGSM,B-LFGS,Deep-Fool等

(2)黑盒攻击可以大致分为两类:基于访问网络输出的方法和基于攻击替代模型的方法;

基于访问的方法又可分为两种,第一种是只知道网络的输出标签(比如网络输出是不是cat等),如ZOO等好多方法,第二种是可以知道网络输出的类概率向量的,如One-Pixel等好多方法。

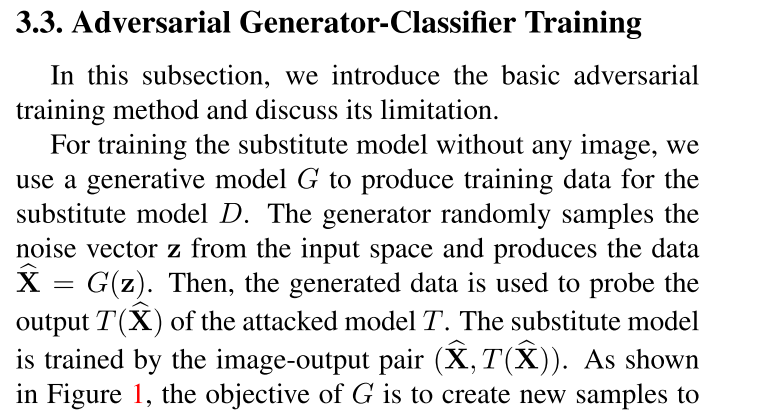

基于攻击替代模型的方法:比如我们要攻击分类网络A,可以先用分类网络的训练数据集自己训练一个本地网络B,将能够成功攻击B的对抗样本用来攻击网络A

那么巧了,本次要讲的这篇文章属于攻击替代模型的,但是我们一般说的攻击替代模型的方法都是需要知道数据集的,也就是需要拿相同的train数据集或者相近的数据集去训练替代网络,然后将成功攻击替代网络的对抗样本去攻击远程的网络。然而,本文作者竟然夸张到不需要任何数据!有图为证:

然而,马上就出现了转弯:

对抗样本X是需要从输入空间采样得到的,如何采样?那么输入空间哪来的,还不是要攻击的网络用的数据集,果然马上在实验细节上:

呵呵,我只想说 本文的作者你是在哄三岁小孩子嘛?而且全文对于噪声z是怎么来的只字未提,如何采样啊大哥?那么我想问一下了,这篇文章是怎么过审的,CVPR2020上面!

现在做对抗攻击的论文就这么好过审嘛?评委都不懂这么个玩意儿?当然那个审论文的人就更不懂了!

posted on 2020-09-23 23:15 Attack-DrHao 阅读(1675) 评论(8) 编辑 收藏 举报