微服务架构技术栈

微服务架构技术栈

场景:

如果我们打开支付宝首页,去看我们的余额,它会展示你的总资产,昨日收益、累计收益等信息。假如这个页面所展示的信息,都来自各个不同的系统/应用,我们通过各个接口把这些数据展示出来。如果我们现在要在前端页面展示这几项数据的话,我们应该怎么去展示呢?

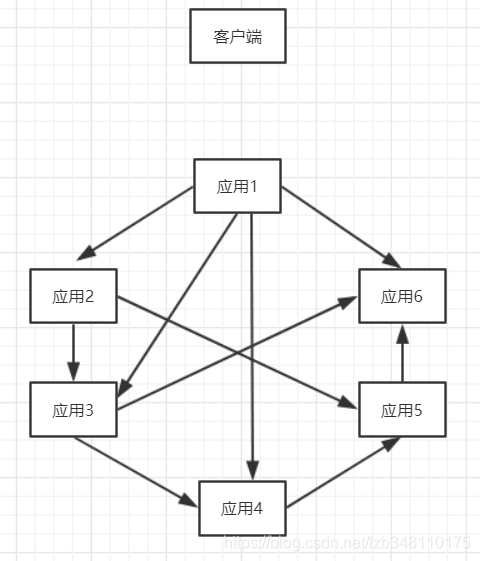

在这种情况下,我们不可能让客户端与6个不同的应用/系统都一一去通信来去完成数据的展示。而是6个应用/系统之间进行彼此通信来完成调用,最后客户端只需要调用一个接口来获取数据即可,而不是与每一个应用/系统进行通信。我们的架构可能是如下的样子:

一个电商系统,比如淘宝,我们在首页会展示很多数据信息,例如:首页信息、商品信息、个人信息、推送信息等等很多。如果首页展示的数据来自100个不同的应用/系统,那么通过如上架构,我们在后端便会出现几百个乃至上千个通信的交互,那么后端的结构就会变得非常的庞大和复杂。所以在这样的架构下,我们需要对上面结构作出一些调整 ,所以我们就引入了SOA架构

0.图示区别

1.什么是SOA架构

SOA(全称:Service Oriented Architecture),中文意思为 “面向服务的架构”,你可以将它理解为一个架构模型或者一种设计方法,而并不是服务解决方案。其中包含多个服务, 服务之间通过相互依赖或者通过通信机制,来完成相互通信的,最终提供一系列的功能。一个服务通常以独立的形式存在与操作系统进程中。各个服务之间通过网络调用 。

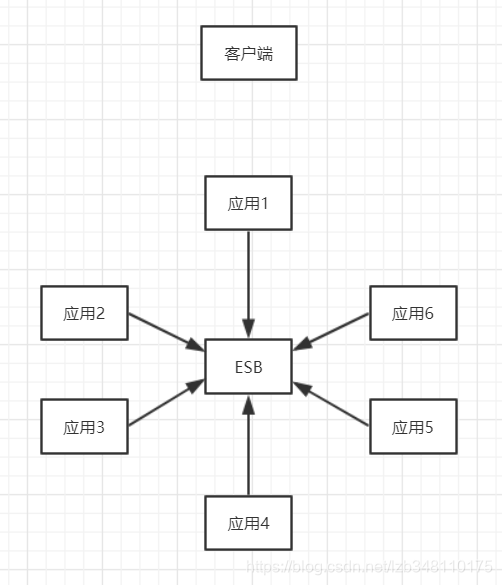

跟 SOA 相提并论的还有一个 ESB(企业服务总线),简单来说ESB就是一根管道,用来连接各个服务节点。为了集成不同系统,不同协议的服务,ESB 可以简单理解为:它做了消息的转化解释和路由工作,让不同的服务互联互通;

我们将各个应用之间彼此的通信全部去掉,在中间引入一个ESB企业总线,各个服务之间,只需要和ESB进行通信,这个时候,各个应用之间的交互就会变得更加的清晰,业务架构/逻辑等,也会变得很清楚。原本杂乱没有规划的系统,梳理成了一个有规划可治理的系统,在这个过程中,最大的变化,就是引入了ESB企业总线。

SOA 所解决的核心问题

-

系统集成:站在系统的角度,解决企业系统间的通信问 题,把原先散乱、无规划的系统间的网状结构,梳理成规整、可治理的系统间星形结构,这一步往往需要引入 一些产品,比如 ESB、以及技术规范、服务管理规范;这一步解决的核心问题是【有序】

-

系统的服务化:站在功能的角度,把业务逻辑抽象成可复用、可组装的服务,通过服务的编排实现业务的快速再生。目的:把原先固有的业务功能转变为通用的业务服务,实现业务逻辑的快速复用;这一步解决的核心问题是【复用】

-

业务的服务化:站在企业的角度,把企业职能抽象成可复用、可组装的服务;把原先职能化的企业架构转变为服务化的企业架构,进一步提升企业的对外服务能力;前面两步都是从技术层面来解决系统调用、系统功能复用的问题。第三步,则是以业务驱动把一个 业务单元封装成一项服务。这一步解决的核心问题是 【高效】

2.微服务架构

微服务架构其实和SOA架构类似,微服务是在SOA上做的升华。微服务架构重点强调的一个是"业务需要彻底的组件化和服务化",原有的单个业务系统会拆分为多个可以独立开发、设计、运行的小应用。这样的小应用和其他各个应用之间,相互去协作通信,来完成一个交互和集成,这就是微服务架构。

组件化:组件表示一个可以独立更换和升级的单元,就以PC机为例,PC中的 CPU、内存、显卡、硬盘一样,独立更换升级而不影响其他单元。如果我们把PC作为组件以服务的方式构建,那么这台PC只需要维护主板和一些必要的外部设备。CPU、内存、硬盘都是以组件方式提供服务,PC需要调用CPU做计算处理,只需要知道CPU这个组件的地址即可。

微服务的特征

1. 通过服务实现组件化

2. 按业务能力来划分服务和开发团队

3. 去中心化

4. 基础设施自动化(devops、自动化部署)

3.SOA 和微服务架构的差别

1. 微服务去中心化,去掉ESB企业总线。微服务不再强调传统SOA架构里面比较重的ESB企业服务总线,同时SOA的思想进入到单个业务系统内部实现真正的组件化

-

Docker容器技术的出现,为微服务提供了更便利的条件,比如更小的部署单元,每个服务可以通过类似Node或者Spring Boot等技术跑在自己的进程中。

-

SOA注重的是系统集成方面,而微服务关注的是完全分离

一、互联网高可用架构,为什么要服务化?

服务化之前高可用架构

在服务化之前,互联网的高可用架构大致是这样一个架构

- 1)用户端是浏览器browser,APP客户端

- 2)后端入口是高可用的nginx集群,用于做反向代理

- 3)中间核心是高可用的web-server集群,研发工程师主要编码工作就是在这一层

- 4)后端存储是高可用的db集群,数据存储在这一层

更典型的,web-server层是通过DAO/ORM等技术来访问数据库的。

可以看到,最初都是没有服务层的,此时架构会碰到一些什么痛点呢?

架构痛点一:代码到处拷贝

举一个最常见的业务的例子->用户数据的访问,绝大部分公司都有一个数据库存储用户数据,各个业务都有访问用户数据的需求:

在有用户服务之前,各个业务线都是自己通过DAO写SQL访问user库来存取用户数据,这无形中就导致了代码的拷贝。

架构痛点二:复杂性扩散

随着并发量的越来越高,用户数据的访问数据库成了瓶颈,需要加入缓存来降低数据库的读压力,于是架构中引入了缓存,由于没有统一的服务层,各个业务线都需要关注缓存的引入导致的复杂性:

对于用户数据的写请求,所有业务线都要升级代码:

- 1)先淘汰cache

- 2)再写数据

对于用户数据的读请求,所有业务线也都要升级代码:

- 1)先读cache,命中则返回

- 2)没命中则读数据库

- 3)再把数据放入cache

这个复杂性是典型的“业务无关”的复杂性,业务方需要被迫升级。

随着数据量的越来越大,数据库需要进行水平拆分,于是架构中又引入了分库分表,由于没有统一的服务层,各个业务线都需要关注分库分表的引入导致的复杂性:

这个复杂性也是典型的“业务无关”的复杂性,业务方需要被迫升级。 包括bug的修改,发现一个bug,多个地方都需要修改。

架构痛点三:库的复用与耦合

服务化并不是唯一的解决上述两痛点的方法,抽象出统一的“库”是最先容易想到的解决:

- 1)代码拷贝

- 2)复杂性扩散

的方法。抽象出一个user.so,负责整个用户数据的存取,从而避免代码的拷贝。至于复杂性,也只有user.so这一个地方需要关注了。

解决了旧的问题,会引入新的问题,库的版本维护与业务线之间代码的耦合:

- 业务线A将user.so由版本1升级至版本2,如果不兼容业务线B的代码,会导致B业务出现问题;

- 业务线A如果通知了业务线B升级,则是的业务线B会无故做一些“自身业务无关”的升级,非常郁闷。当然,如果各个业务线都是拷贝了一份代码则不存在这个问题。

架构痛点四:SQL质量得不到保障,业务相互影响

业务线通过DAO访问数据库:

本质上SQL语句还是各个业务线拼装的,资深的工程师写出高质量的SQL没啥问题,经验没有这么丰富的工程师可能会写出一些低效的SQL,假如业务线A写了一个全表扫描的SQL,导致数据库的CPU100%,影响的不只是一个业务线,而是所有的业务线都会受影响

架构痛点五:疯狂的DB耦合

业务线不至访问user数据,还会结合自己的业务访问自己的数据

- 典型的,通过join数据表来实现各自业务线的一些业务逻辑。

- 这样的话,业务线A的table-user与table-A耦合在了一起,业务线B的table-user与table-B耦合在了一起,业务线C的table-user与table-C耦合在了一起,结果就是:table-user,table-A,table-B,table-C都耦合在了一起。

- 随着数据量的越来越大,业务线ABC的数据库是无法垂直拆分开的,必须使用一个大库(疯了,一个大库300多个业务表)。

二、服务化解决什么问题?

为了解决上面的诸多问题,互联网高可用分层架构演进的过程中,引入了“服务层”。

以上文中的用户业务为例,引入了user-service,对业务线响应所用用户数据的存取。引入服务层有什么好处,解决什么问题呢?

好处一:调用方爽

- 有服务层之前:业务方访问用户数据,需要通过DAO拼装SQL访问

- 有服务层之后:业务方通过RPC访问用户数据,就像调用一个本地函数一样,非常之爽

User = UserService::GetUserById(uid);

传入一个uid,得到一个User实体,就像调用本地函数一样,不需要关心序列化,网络传输,后端执行,网络传输,范序列化等复杂性。

好处二:复用性,防止代码拷贝

- 这个不展开叙述,所有user数据的存取,都通过user-service来进行,代码只此一份,不存在拷贝。

- 升级一处升级,bug修改一处修改。

好处三:专注性,屏蔽底层复杂度

在没有服务层之前,所有业务线都需要关注缓存、分库分表这些细节

在有了服务层之后,只有服务层需要专注关注底层的复杂性了,向上游屏蔽了细节。

好处四:SQL质量得到保障

原来是业务向上游直接拼接SQL访问数据库。

有了服务层之后,所有的SQL都是服务层提供的,业务线不能再为所欲为了。底层服务对于稳定性的要求更好的话,可以由更资深的工程师维护,而不是像原来SQL难以收口,难以控制。

好处五:数据库解耦

原来各个业务的数据库都混在一个大库里,相互join,难以拆分。

服务化之后,底层的数据库被隔离开了,可以很方便的拆分出来,进行扩容。

好处六:提供有限接口,无限性能

在服务化之前,各业务线上游想怎么操纵数据库都行,遇到了性能瓶颈,各业务线容易扯皮,相互推诿。

服务化之后,服务只提供有限的通用接口,理论上服务集群能够提供无限性能,性能出现瓶颈,服务层一处集中优化。

一、概述

近年,Spring Cloud 俨然已经成为微服务开发的主流技术栈,在国内开发者社区非常火爆。我近年一直在一线互联网公司(携程,拍拍贷等)开展微服务架构实践,根据我个人的一线实践经验和我平时对 Spring Cloud 的调研,我认为 Spring Cloud 技术栈中的有些组件离生产级开发尚有一定距离。比方说 Spring Cloud Config 和 Spring Cloud Sleuth 都是 Pivotal 自研产品,尚未得到大规模企业级生产应用,很多企业级特性缺失(具体见我后文描述)。

另外 Spring Cloud 体系还缺失一些关键的微服务基础组件,比如 Metrics 监控,健康检查和告警等。所以我在参考 Spring Cloud 微服务技术栈的基础上,结合自身的实战落地经验,也结合国内外一线互联网公司(例如 Netflix,点评,携程,Zalando 等)的开源实践,综合提出更贴近国内技术文化特色的轻量级的微服务参考技术栈。希望这个参考技术栈对一线的架构师(或者是初创公司)有一个好的指导,能够少走弯路,快速落地微服务架构。

这个参考技术栈和总体架构如下图所示:

主要包含 11 大核心组件,分别是:

二、核心支撑组件

- 服务网关 Zuul

- 服务注册发现 Eureka+Ribbon

- 服务配置中心 Apollo

- 认证授权中心 Spring Security OAuth2

- 服务框架 Spring MVC/Boot

三、监控反馈组件

- 数据总线 Kafka

- 日志监控 ELK

- 调用链监控 CAT

- Metrics 监控 KairosDB

- 健康检查和告警 ZMon

- 限流熔断和流聚合 Hystrix/Turbine

四、核心支撑组件

1、服务网关 Zuul

2013 年左右,InfoQ 曾经对前 Netflix 架构总监 Adrian Cockcroft 有过一次专访 [附录 1],其中有问 Adrian:“Netflix 开源这么多项目,你认为哪一个是最不可或缺的 (MOST Indispensable)”,Adrian 回答说:“在 NetflixOSS 开源项目中,有一个容易被忽略,但是 Netflix 最强大的基础服务之一,它就是 Zuul 网关服务。Zuul 网关主要用于智能路由,同时也支持认证,区域和内容感知路由,将多个底层服务聚合成统一的对外 API。Zuul 网关的一大亮点是动态可编程,配置可以秒级生效”。从 Adrian 的回答中,我们可以感受到 Zuul 网关对微服务基础架构的重要性

Zuul 在英文中是一种怪兽,星际争霸中虫族里头也有 Zuul,Netflix 为网关起名 Zuul,寓意看门神兽。

Zuul 网关在 Netflix 经过生产级验证,在纳入 Spring Cloud 体系之后,在社区中也有众多成功的应用。Zuul 网关在携程(日流量超 50 亿),拍拍贷等公司也有成功的落地实践,是微服务基础架构中网关一块的首选。其它开源产品像 Kong 或者 Nginx 等也可以改造支持网关功能,但是较复杂门槛高一点。

Zuul 网关虽然不完全支持异步,但是同步模型反而使它简单轻量,易于编程和扩展,当然同步模型需要做好限流熔断(和限流熔断组件 Hystrix 配合),否则可能造成资源耗尽甚至雪崩效应(cascading failure)。

2、服务注册发现 Eureka + Ribbon

针对微服务注册发现场景,社区里头的开源产品当中,经过生产级大流量验证的,目前只有 Netflix Eureka 一个,它也已经纳入 Spring Cloud 体系,在社区中有众多成功应用,例如携程 Apollo 配置中心也是使用 Eureka 做软负载。其它产品如 Zookeeper/Etcd/Consul 等,都是比较通用的产品,还需要进一步封装定制才可生产级使用。Eureka 支持跨数据中心高可用,但它是 AP 最终一致系统,不是强一致性系统。

Ribbon 是可以和 Eureka 配套对接的客户端软负载库,在 Eureka 的配合下能够支持多种灵活的动态路由和负载均衡策略。内部微服务直连可以直接走 Ribbon 客户端软负载,网关上也可以部署 Ribbon,这时网关相当于一个具有路由和软负载能力的超级客户端。

Ribbon 是蝴蝶结的意思。

3、服务配置中心 Apollo

Spring Cloud 体系里头有个 Spring Cloud Config 产品,但是功能远远达不到生产级,只能小规模场景下用,中大规模企业级场景不建议采用。携程框架研发部开源的 Apollo 是一款在携程和其它众多互联网公司生产落地下来的产品,开源两年多,目前在 github 上有超过 4k 星,非常成功,文档齐全也是它的一大亮点,推荐作为企业级的配置中心产品。

Apollo 支持完善的管理界面,支持多环境,配置变更实时生效,权限和配置审计等多种生产级功能。Apollo 既可以用于连接字符串等常规配置场景,也可用于发布开关(Feature Flag)和业务配置等高级场景。在《2018 波波的微服务基础架构和实践》课程中,第二个模块就配置中心相关主题,会深度剖析携程 Apollo 的架构和实践,预计 6 月份推出,欢迎大家关注学习。

阿波罗是希腊神话中太阳神的意思

4、认证授权中心 Spring Security OAuth2

目前开源社区还没有特别成熟的微服务安全认证中心产品,之前我工作过的一些中大型互联网公司,比如携程,唯品会等,在这一块基本都是定制自研的,但是对一般企业来说,定制自研还是有门槛的。OAuth2 是一种基于令牌 Token 的授权框架,已经得到众多大厂(Google, Facebook, Twitter, Microsoft 等)的支持,可以认为是事实上的微服务安全协议标准,适用于开放平台联合登录,现代微服务安全(包括单页浏览器 App/ 无线原生 App/ 服务器端 WebApp 接入微服务,以及微服务之间调用等场景),和企业内部应用认证授权 (IAM/SSO) 等多种场景。

Spring Security OAuth2 是 Spring Security 基础上的一个扩展,支持四种主要的 OAuth2 Flows,基本可以作为微服务认证授权中心的推荐产品。但是 Spring Security OAuth2 还只是一个框架,不是一个端到端的开箱即用的产品,企业级应用仍需在其上进行定制,例如提供 Web 端管理界面,对接企业内部的用户认证登录系统,使用 Cache 缓存令牌,和微服务网关对接等,才能作为生产级使用。在《2018 波波的微服务基础架构和实践》课程中,第一个模块就是微服务安全架构和实践相关主题,会深度剖析 OAuth2 原理和 Spring Security OAuth2 实践,欢迎大家关注学习。

Spring Security OAuth2 是 Spring Security 框架的一个扩展。

5、服务框架 Spring/Boot

Spring 可以说是史上最成功的 Web App/API 开发框架之一,它融入了 Java 社区中多年来沉淀下来的最佳实践,虽然有将近 15 年历史,但目前的社区活跃度仍呈上升趋势。Spring Boot 在 Spring 的基础上进一步打包封装,提供更贴心的 Starter 工程,自启动能力,自动依赖管理,基于代码的配置等特性进一步降低接入门槛。另外 Spring Boot 也提供 actuator 这样的生产级监控特性,支持 DevOps 研发模式,它是微服务开发框架的推荐首选。

REST 契约规范 Swagger 和 Spring 有比较好的集成,使得 Spring 也支持契约驱动开发 (Contract Driven Development) 模型。对于一些中大规模的企业,如果业务复杂团队较多,考虑到互操作性和集成成本,建议采用契约驱动开发模型,也就是开发时先定义 Swagger 契约,然后再通过契约生成服务端接口和客户端,再实现服务端业务逻辑,这种开发模型能够标准化接口,降低系统间集成成本,对于多团队协同并行开发非常重要。

六、监控反馈组件

1、数据总线 Kafka

最初由 Linkedin 研发并在其内部大规模成功应用,然后在 Apache 上开源的 Kafka,是业内数据总线 (Databus) 一块的标配,几乎每一家互联网公司都可以看到 Kafka 的身影。Kafka 堪称开源项目的一个经典成功案例,其创始人团队从 Linkedin 离职后还专门成立了一家叫 confluent 的企业软件服务公司,围绕 Kafka 周边提供配套和增值服务。在监控一块,日志和 Metrics 等数据可以通过 Kafka 做收集、存储和转发,相当于中间增加了一个大容量缓冲,能够应对海量日志数据的场景。除了日志监控数据收集,Kafka 在业务大数据分析,IoT 等场景都有广泛应用。如果对 Kafka 进行适当定制增强,还可以用于传统消息中间件场景。

Kafka 的特性是大容量,高吞吐,高可用,数据可重复消费,可水平扩展,支持消费者组等。Kafka 尤其适用于不严格要求实时和不丢数据的大数据日志场景。

Kafka 创始人三人组,离开 Linkedin 后,创立了基于 Kafka 的创业公司 Confluent。

2、日志监控 ELK

ELK(ElasticSearch/Logstash/Kibana)是日志监控一块的标配技术栈,几乎每一家互联网公司都可以看到 ELK 的身影,据称携程是国内 ELK 的最大用户,每日增量日志数据量达到 80~90TB。ELK 已经非常成熟,基本上是开箱即用,后续主要的工作在运维、治理和调优。

ELK 一般和 Kafka 配套使用,因为日志分词操作还是比较耗时的,Kafka 主要作为前置缓冲,起到流量消峰作用,抵消日志流量高峰和消费(分词建索引)的不匹配问题。一旦反向索引建立,日志检索是非常快的,所以日志检索快和灵活是 ElasticSearch 的最大亮点。另外 ELK 还有大容量,高吞吐,高可用,可水平扩容等企业级特性。

创业公司起步期,考虑到资源时间限制,调用链监控和 Metrics 监控可以不是第一优先级,但是 ELK 是必须搭一套的,应用日志数据一定要收集并建立索引,基本能够覆盖大部分 Trouble Shooting 场景(业务,性能,程序 bug 等)。

另外用好 ELK 的关键是治理,需要制定一些规则(比如只收集 Warn 级别以上日志),对应用的日志数据量做好监控,否则开发人员会滥用,什么垃圾数据都往 ELK 里头丢,造成大量空间被浪费,严重的还可能造成性能可用性问题。

3、调用链监控 CAT

Spring Cloud 支持基于 Zipkin 的调用链监控,我个人基于实践经验认为 Zipkin 还不能算一款企业级调用链监控产品,充其量只能算是一个半成品,很多重要的企业级特性缺失。Zipkin 最早是由 Twitter 在消化 Google Dapper 论文的基础上研发,在 Twitter 内部有较成功应用,但是在开源出来的时候把不少重要的统计报表功能给阉割了(因为依赖于一些比较重的大数据分析平台),只是开源了一个半成品,能简单查询和呈现可视化调用链,但是细粒度的调用性能数据报表没有开源。

Google 大致在 2007 年左右开始研发称为 Dapper 的调用链监控系统,但在远远早于这个时间(大致在 2002 左右),eBay 就已经有了自己的调用链监控系统 CAL(Centralized Application Logging),Google 和 eBay 的设计思路大致相同,但是也有一些差别。CAL 在 eBay 有大规模成功应用,被称为是 eBay 的四大神器之一(另外三个是 DAL,Messaging 和 SOA)。

开源调用链监控系统 CAT 的作者吴其敏(我曾经和他同事,习惯叫他老吴),曾经在 eBay 工作近十年,期间深入消化吸收了 CAL 的设计。2011 年后老吴离开 eBay 去了点评,用三年时间在点评再造了一款调用链监控产品 CAT(Centralized Application Tracking),CAT 具有 CAL 的基因和影子,同时也融入了老吴在点评的探索实践和创新。

CAT 是一款更完整的企业级调用链监控产品,甚至已经接近一个 APM(Application Performance Management)产品的范畴,它不仅支持调用链的查询和可视化,还支持细粒度的调用性能数据统计报表,这块是 CAT 和市面上其它开源调用链监控产品最本质的差异点,实际上开发人员大部分时间用 CAT 是看性能统计报表(主要是 CAT 的 Transaction 和 Problem 报表),这些报表相当于给了开发人员一把尺子,可以自助测量并持续改进应用性能。另外 CAT 还支持应用报错大盘,自助告警等功能,也是企业级监控非常实用的功能。

CAT 在点评,携程,陆金所,拍拍贷等公司有成功落地案例,因为是国产调用链监控产品,界面展示和功能等更契合国内文化,更易于在国内公司落地。个人推荐 CAT 作为微服务调用链监控的首选。

至于社区里头有人提到 CAT 的侵入性问题,我觉得是要一分为二看,有利有弊,有耦合性但是性能更好,一般企业中基础架构团队会使用 CAT 统一为基础组件埋点,开发人员一般不用自己埋点;另外企业用了一款调用链监控产品以后,一般是不会换的,开发人员用习惯就好了,侵入不是大问题

CAT 的 Transaction 报表

4、Metrics 监控 KariosDB

除了日志和调用链,Metrics 也是应用监控的重要关注点。互联网应用提倡度量驱动开发(Metrics Driven Development),也就是说开发人员不仅要关注功能实现,做好单元测试(TDD),还要做好业务层(例如注册,登录和下单数等)和应用层(例如调用数,调用延迟等)的监控埋点,这个也是 DevOps(开发即运维)理念的体现,DevOps 要求开发人员必须关注运维需求,监控埋点是一种生产级运维需求。

Metrics 监控产品底层依赖于时间序列数据库(TSDB),最近比较热的开源产品有 Prometheus 和 InfluxDB,社区用户数量和反馈都不错,可以采纳。但是这些产品分布式能力比较弱,定制扩展门槛比较高,一般建议刚起步量不大的公司采用。

如果企业业务和团队规模发展到一定阶段,建议考虑支持分布式能力的时间序列监控产品,例如 KairosDB 或者 OpenTSDB,我本人对这两款产品都有一些实践经验,KariosDB 基于 Cassandra,相对更轻量一点,建议中大规模公司采用,如果你们公司已经采用 Hadoop/HBase,则 OpenTSDB 也是不错选择。

KairosDB 一般也和 Kafka 配套使用,Kafka 作为前置缓冲。另外注意使用 KariosDB 打点的话 tag 的值不能太离散,否则会有查询性能问题,这个和 KariosDB 底层存储结构有关系。Grafana 是 Metrics 展示标配,可以和 KariosDB 无缝集成。

Grafana 是 Metrics 展示标配,和主流时间序列数据库都可以集成

5、健康检查和告警 ZMon

除了上述监控手段,我们仍需要健康检查和告警系统作为配套的监控手段。ZMon 是德国电商公司 Zalando 开源的一款健康检查和告警平台,具备强大灵活的监控告警能力。ZMon 本质上可以认为是一套分布式监控任务调度平台,它提供众多的 Check 脚本(也可以自己再定制扩展),能够对各种硬件资源或者目标服务(例如 HTTP 端口,Spring 的 Actuator 端点,KariosDB 中的 Metrics,ELK 中的错误日志等等)进行定期的健康检查和告警,它的告警逻辑和策略采用 Python 脚本实现,开发人员可以实现自助式告警。ZMon 同时适用于系统,应用,业务,甚至端用户体验层的监控和告警。

6、限流熔断和流聚合 Hystrix+Turbine

2010 年左右,Netflix 也饱受分布式微服务系统中雪崩效应(Cascading Failure)的困扰,于是专门启动了一个叫做弹性工程的项目来解决这个问题,Hystrix 就是弹性工程最终落地下来的一个产品。Hystrix 在 Netflix 微服务系统中大规模推广应用后,雪崩效应问题基本得到解决,整个体统更具弹性。

之后 Netflix 把 Hystrix 开源贡献给了社区,短期获得社区的大量正面反馈,目前 Hystrix 在 github 上有超过 1.3 万颗星,据说支持奥巴马总统选举的系统也曾使用 Hystrix 进行限流熔断保护 ,可见限流熔断是分布式系统稳定性的强需求,Netflix 很好的抓住了这个需求并给出了经过生产级验证的解决方案。Hystrix 已经被纳入 Spring Cloud 体系,它是 Java 社区中限流熔断组件的首选(目前还看不到第二个更好的产品)。

Turbine 是和 Hystrix 配套的一个流聚合服务,能够对 Hystrix 监控数据流进行聚合,聚合以后可以在 Hystrix Dashboard 上看到集群的流量和性能情况。

Hystrix 在英文中是豪猪兽的意思,豪猪兽通过身上的刺保护自己,Netflix 为限流熔断组件起名 Hystrix,寓意 Hystrix 能够保护微服务调用

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 没有源码,如何修改代码逻辑?

· 一个奇形怪状的面试题:Bean中的CHM要不要加volatile?

· [.NET]调用本地 Deepseek 模型

· 一个费力不讨好的项目,让我损失了近一半的绩效!

· .NET Core 托管堆内存泄露/CPU异常的常见思路

· DeepSeek “源神”启动!「GitHub 热点速览」

· 微软正式发布.NET 10 Preview 1:开启下一代开发框架新篇章

· C# 集成 DeepSeek 模型实现 AI 私有化(本地部署与 API 调用教程)

· DeepSeek R1 简明指南:架构、训练、本地部署及硬件要求

· NetPad:一个.NET开源、跨平台的C#编辑器