hadoop中常见问题

=================================================================111

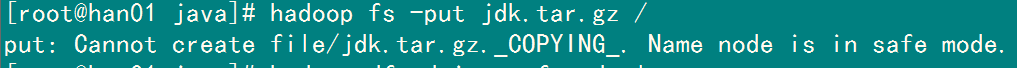

//启动服务器时不能拷贝文件,退出安全模式,

//hdfs在启动开始时会进入安全模式,这时文件系统中的内容不允许修改也不允许删除,直到安全模式结束。

//安全模式主要是为了系统启动的时候检查各个DataNode上数据块的有效性,同时根据策略必要的复制或者删除部分数据块。

//运行期通过命令也可以进入安全模式。在实践过程中,系统启动的时候去修改和删除文件也会有安全模式不允许修改的出错提示,只需要等待一会儿即可。

//put: Cannot create file/jdk.tar.gz._COPYING_. Name node is in safe mode.

//也可以通过命令强制退出

hadoop dfsadmin -safemode leave

=================================================================222

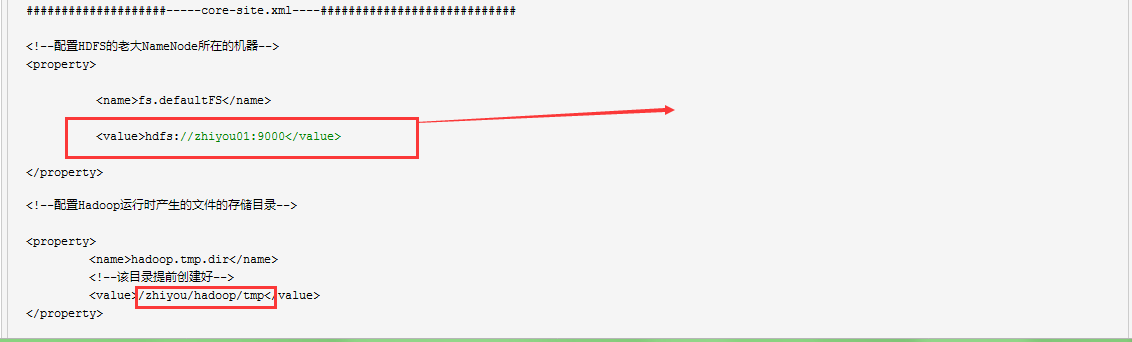

datanode 没有启动 再每次预格式化之前将 将 core-site.xml中配置的路径和文件目录下清空

=================================================================333

第一个不能使用 localhost:9000

否则的话java代码中访问不到的

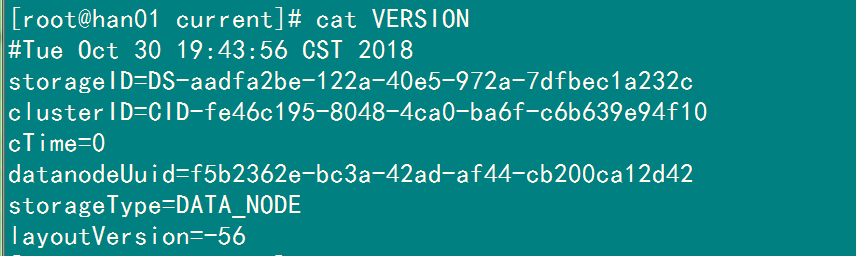

第二个在每次预格式化之前必须将里面的内容清空,因为里面的

/zhiyou/hadoop/tmp/dfs/data/current/ 下的 VERSION 如果不删除,这个文件中存在着datanode每次都是第一次预格式化生成的id,下次启动datanode就不会启动

=================================================================444

每次liunx重启之后 hadoop的namenode都启动不了,前提是core-site.xml等有关namenode的配置文件是没有问题,也就是之前是可以启动的,然后重启虚拟机或是其他原因导致不可启动

>===终极解决方案:重新预格式化一下,之前现将tmp下的文件删除

hadoop namenode -format

>--但是之前的上传的数据可能会丢失

>===如果不想与格式化,可以修复一下tmp中的数据,也可能是这里面的元数据遭到破坏;

hadoop namenode -recover 选C

>--执行该命令进行修复,不确定是否会有效果

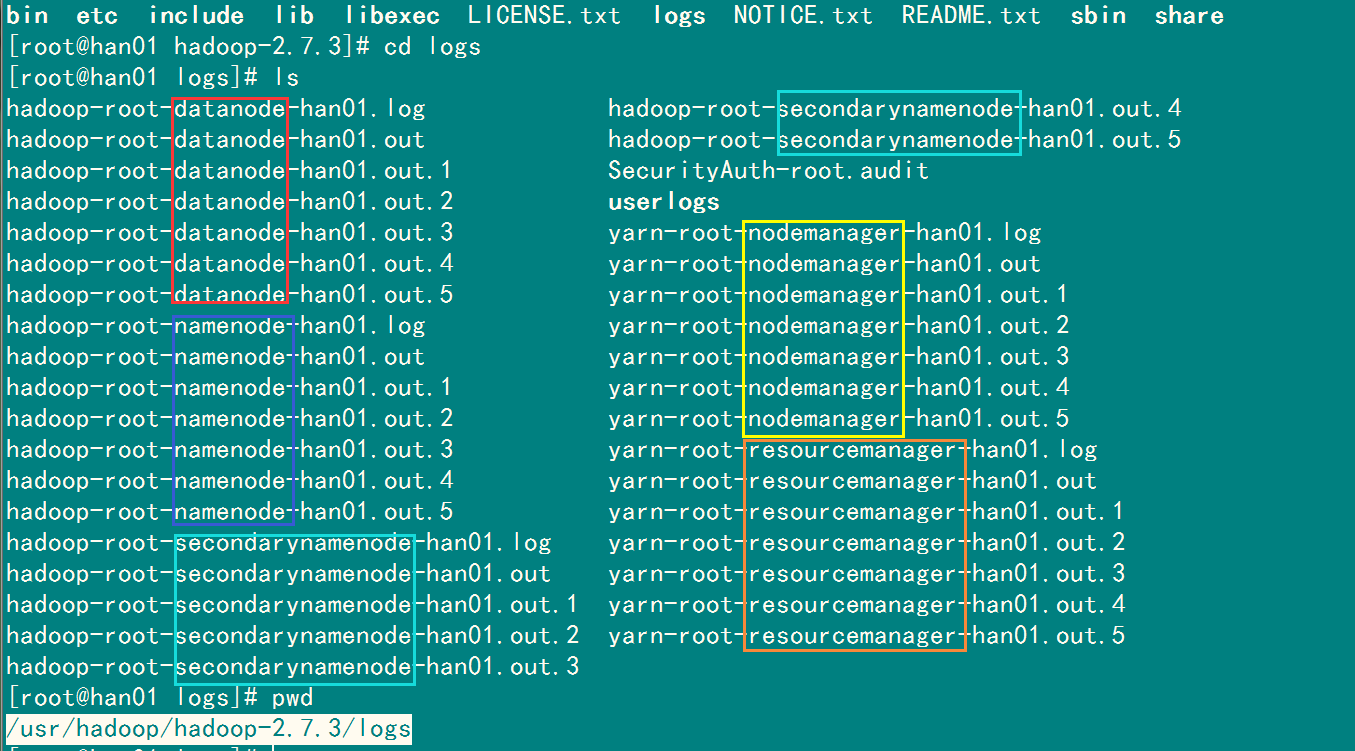

>===如果有个节点不能启动,或是其中namenode等不能启动又找不见原因,可以采取以下方案

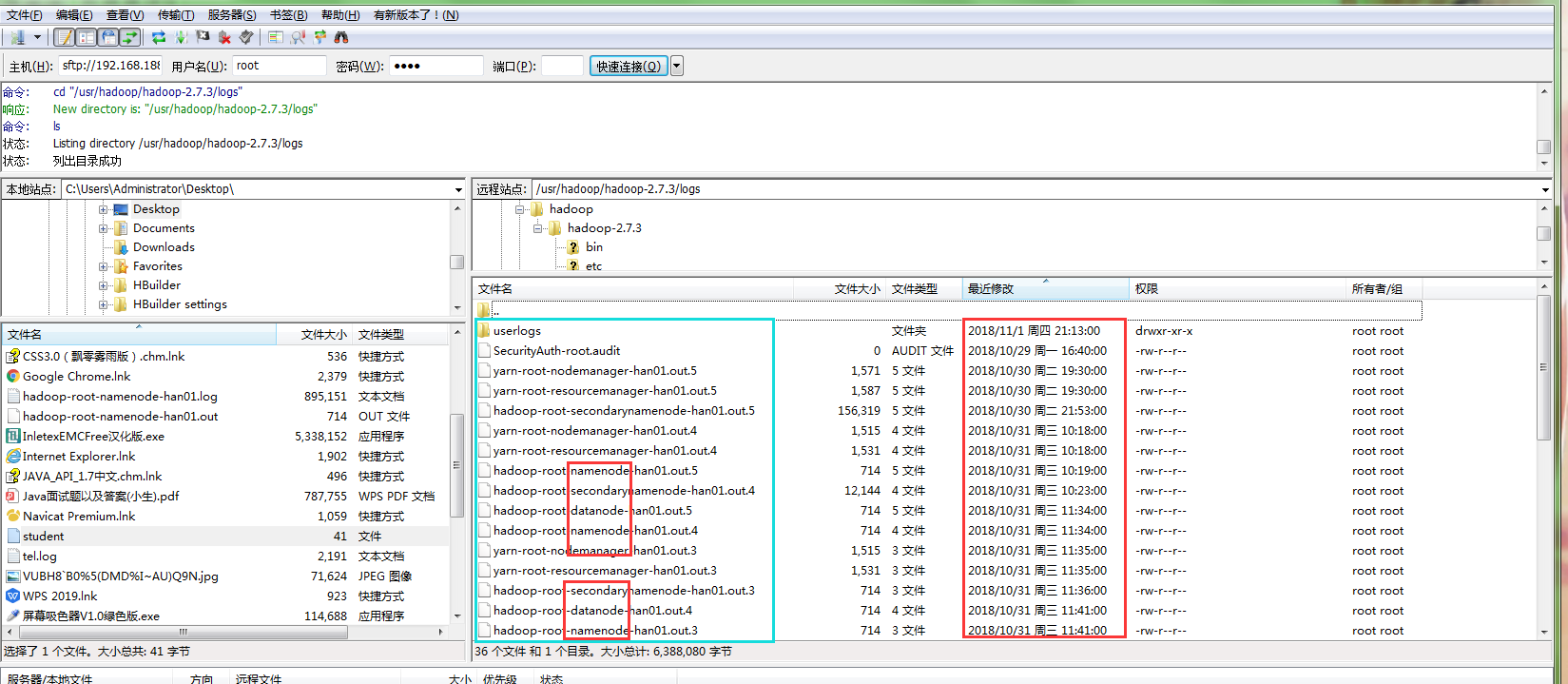

查看相关的日志文件:在hadoop的安装目录下进入logs目录,查看最近的日志文件

目录文件 /usr/hadoop/hadoop-2.7.3/logs

输入ls可查看相关的日志信息:

>===这里查看比较麻烦,可通过FileZilla等辅助文件查看,然后将最近的一次日志拷贝到桌面使用记事本打开,可看到相关的错误,然后就可以发现导致一些相关节点无法启动的最终原因,然后百度解决

本文来自博客园踩坑狭,作者:韩若明瞳,转载请注明原文链接:https://www.cnblogs.com/han-guang-xue/p/9879323.html