spark集群配置

1.jdk环境

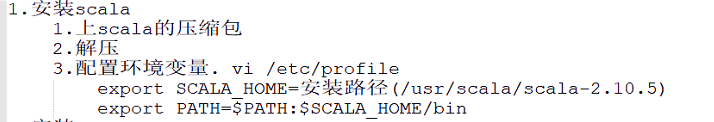

2.scala安装和环境配置

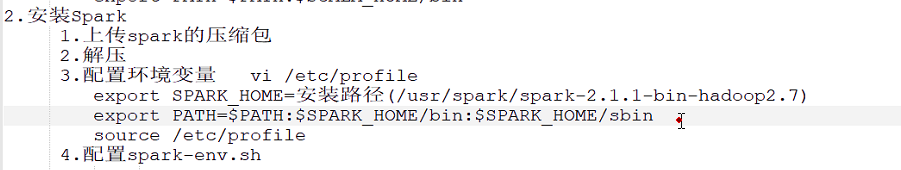

3.spark

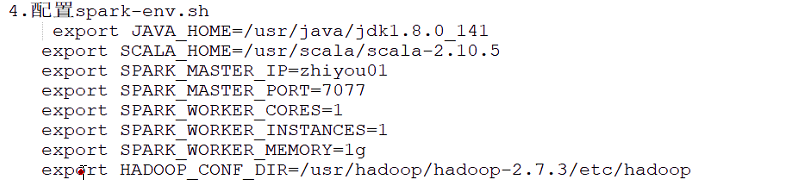

配置spark-env.sh

export JAVA_HOME=/usr/java/jdk1.8.0_141 export SCALA_HOME=/usr/scala export SPARK_MASTER_IP=han01 export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=1 #每个Worker进程所需要的CPU核的数目; export SPARK_WORKER_INSTANCES=1 #每个Worker节点上运行Worker进程的数目 export SPARK_WORKER_CORES=1 #每个WORK再节点运行时占用的cpu个数 export SPARK_WORKER_MEMORY=1g export HADOOP_CONF_DIR=/usr/hadoop/hadoop-2.7.3/etc/hadoop

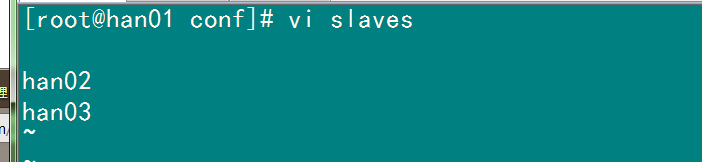

4.配置slaves(worker坐在的机器)

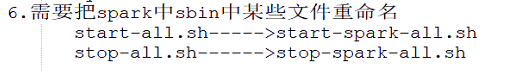

5.避免与hadoop启动命令冲突

修改.sh

6.jdk

将配置 拷贝到其他两个机器

刷新环境变量: source /etc/profile

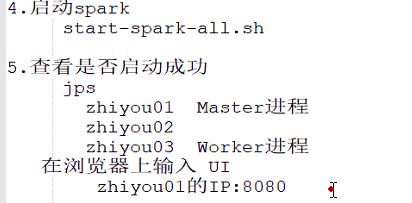

7.启动spark

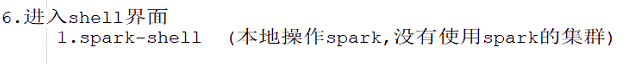

8.进入shell界面

9.(出现问题)拒绝连接:

10.在集群中启动命令:

spark-shell --master spark://han01:7077 --total-executor-cores 1 --executor-memory 512m

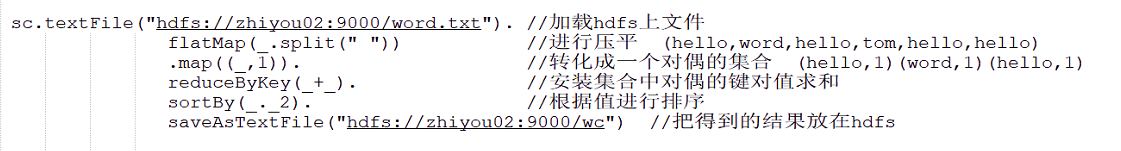

11.hadoop中做单词统计

12.hadoop中RDD的理解和使用

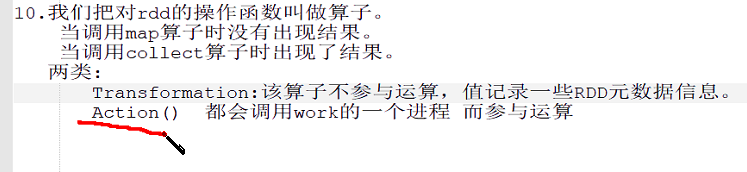

13.hadoop中RDD操作的函数叫做算子

本文来自博客园踩坑狭,作者:韩若明瞳,转载请注明原文链接:https://www.cnblogs.com/han-guang-xue/p/10026942.html